In der heutigen digitalen Welt steht die Wahl der richtigen Datenbanktechnologie im Mittelpunkt des Erfolgs vieler Unternehmen. Besonders bei wachsendem Datenvolumen und steigenden Ansprüchen an Skalierbarkeit und Performance wird die Entscheidung, welches Datenbanksystem eingesetzt wird, immer komplexer. In diesem Kontext gewinnt die Migration von verteilten Datenbanklösungen wie CockroachDB hin zu Postgres zunehmend an Bedeutung. Was viele zunächst nicht erwarten, zeigt sich bei näherer Betrachtung als wegweisende Option – und das aus guten Gründen. Der technologische Kontext vieler Start-ups und wachsender digitaler Unternehmen ist geprägt von Cloud-nativen, skalierbaren Architekturen.

CockroachDB wurde dabei oft als der Goldstandard für hochverfügbare, horizontal skalierbare und geo-redundante Datenbanken verstanden. Gerade durch die überzeugende Unterstützung für Multiregion-Szenarien, die mittlerweile durch regulatorische Anforderungen wie die Datenschutz-Grundverordnung (DSGVO) an Relevanz gewinnen, wurde CockroachDB als zukunftssicherer Ansatz favorisiert. Doch dieses Bild wandelte sich mit der Zeit. Mit dem Wachstum der Nutzerdaten und der konkreten Arbeitslast stiegen nämlich auch die Herausforderungen. Die Kosten explodierten teilweise bis zum Fünffachen im Vergleich zu vorherigen Jahren.

Besonders da viele Unternehmen zunächst keine Multi-Region-Anforderungen erfüllen mussten und innerhalb einer einzigen Region arbeiteten, stellte sich die Frage nach dem tatsächlichen Mehrwert einer verteilten Datenbank. Zudem sorgten wiederkehrende technische Probleme wie ablaufende Migrationsprozesse für Zusatzaufwände, die Entwickler und Betriebsteams zunehmend belasteten. Ein besonderes Ärgernis lag in der Handhabung von Datenbank-Migrationen. Mit Prisma, einem beliebten objekt-relationalen Mapper (ORM), wurden Migrationen oft durch Timeouts gestoppt, was zu langen Ausfallzeiten während der Deployments führte. Entwickler waren gezwungen, manuelle Migrationen durchzuführen, was nicht nur zeitintensiv war, sondern auch zur Quelle von Fehlern und Unsicherheit im Produktionsbetrieb wurde.

Im starken Gegensatz dazu wurden ähnliche Migrationen in Postgres in Sekundenbruchteilen ausgeführt, was den Wechsel zusätzlich attraktiv machte. Doch nicht nur die Migrationen waren ein bedeutender Faktor. Auch die ETL-Prozesse (Extrahieren, Transformieren, Laden) litten unter den Performance-Einschränkungen bei CockroachDB. Es mangelte an stabilen, voll ausgereiften Tools zur Datenreplikation und Synchronisation. Die einzige verfügbare Lösung war lange Zeit ein Alpha-Status Connector für Airbyte, dessen Einsatz mit unerwarteten Speicherlecks einherging – ein Risiko, das sich auf den Produktionsbetrieb auswirkte und die tägliche Arbeit unnötig erschwerte.

Ein weiterer Aspekt war die Query-Performance. Obwohl CockroachDB an einigen Stellen mit optimierten Abfrageplänen punktete und bei speziellen Queries sogar schneller war als Postgres, dominierten in der Praxis ineffiziente und komplexe SQL-Abfragen, vor allem durch den von Prisma generierten Code. Die Cockroach-Optimierungen machten aus diesen teilweise sogar Nachteil durch ungewollte Volltabellenscans, während Postgres mit soliden Index-Strategien und ausgefeiltem Query Planner deutlich schneller reagierte. Gerade bei komplexen Datenmodellen zeigt sich oft, dass die reine Verteilungsstrategie nicht automatisch besseren Zugriff bedeutet. Auch aus Sicht der Entwickler ergaben sich signifikante Unterschiede.

CockroachDB stellte hohe Barrieren beim Umgang mit laufenden Abfragen. Einfache Nutzeraktionen wie das Abbrechen einer lang laufenden komplexen Query waren kompliziert, da dies über eine verteilte Infrastruktur manuell im Cluster gemacht werden musste. Postgres hingegen bot ein deutlich intuitiveres und effektiveres Handling mit etablierten Tools, die ein schnelles Intervenieren ermöglichte. Problematisch war ebenfalls die Cockroach-spezifische Unterstützung und Infrastruktur. Häufige Verbindungsprobleme, insbesondere über VPN-Lösungen wie Tailscale, führten zu unerklärlichen Kurzzeit-Ausfällen in verschiedenen Umgebungen.

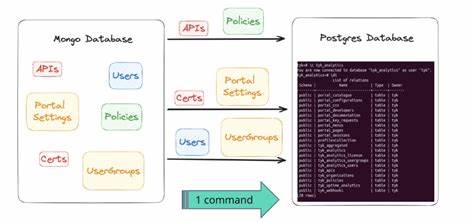

Das Hin- und Her zwischen unterschiedlichen Supportportalen mit langen Wartezeiten erhöhte den Frust zusätzlich. Im direkten Vergleich verbesserte sich in der Postgres-Welt sowohl die Stabilität als auch die direkte Verfügbarkeit von technischen Ansprechpersonen. Der eigentliche Migrationsprozess stellte dennoch eine große Herausforderung dar. Besonders bei umfangreichen Datenbanken mit Hunderten von Millionen Datensätzen ist ein Umzug ohne längere Ausfallzeiten oder Dateninkonsistenzen selten trivial. Hier zeigte sich ein kreativer Ansatz mit einer maßgeschneiderten ETL-Lösung, die auf modernen Technologien wie Bun basierte.

Durch das Auslesen der Schema-Struktur, das sequenzielle Dumpen der Daten und das parallele Einspielen in Postgres konnte ein effizientes und skalierbares Verfahren realisiert werden. Eine besondere Hürde war hierbei die unterschiedliche Kodierung von JSON- und Array-Datentypen zwischen den Systemen, welche mit custom CSV-Parsing-Strategien erfolgreich überwunden wurde. Das Ergebnis der Migration war beeindruckend. Innerhalb eines Zeitraums von nicht einmal einer Stunde wurde die gesamte Produktivdatenbank umgezogen – ohne Datenverlust und mit kontrollierter Heraufsetzung des Live-Traffics. Die unmittelbaren Auswirkungen auf die Performance zeigten sich durch einen signifikanten Rückgang der Anfragenlatenzen um rund ein Drittel.

Über die nächsten Tage hinweg konnten durch Analyse-Tools wie PGAnalyze diverse weitere Optimierungen im Datenbankschema und bei Abfragen vorgenommen werden, was die Vorteile von Postgres weiter ausbaute. Finanziell bedeutete die Migration für das Unternehmen ebenfalls einen entscheidenden Gewinn. Trotz bewusst konservativer Ressourcenplanung im neuen Postgres-Cluster ergab sich eine Kosteneinsparung von über 110.000 US-Dollar pro Jahr – Tendenz steigend aufgrund erwartetem Wachstum. Dies zeigt eindrucksvoll, dass Investitionen in eine systematische Neuausrichtung der Dateninfrastruktur neben technischen Vorteilen auch unmittelbar wirtschaftliche Effekte erzielen können.

Die Erfahrung aus dem Wechsel von CockroachDB zu Postgres spricht für die zunehmende Relevanz gut etablierter relationaler Datenbanksysteme, selbst in Kontexten, in denen verteilte Systeme ursprünglich als notwendig oder überlegen galten. Die reiche Ecosystem-Landschaft, die breite Support-Basis sowie die stabilen Werkzeuge für Entwicklung und Betrieb von Postgres schaffen ein Umfeld, das langfristig sowohl Skalierbarkeit als auch Zuverlässigkeit sichert. Unternehmen, die heute in komplexe Datenarchitekturen investieren, sollten daher eine kritische Bewertung der eigenen Anforderungen vornehmen. Die vermeintlichen Vorteile von Multi-Region Verteilung oder hochverteilten Systemen müssen gegen die tatsächlichen Kosten, den operativen Aufwand und die Performance-Realität abgewogen werden. Migrationen wie die geschilderte zeigen, dass eine sorgfältige Planung und der Einsatz passender Tools zu einem erstaunlich effizienten Umzug führen kann – auch bei großen Datenmengen.

Für Entwickler, Datenbankadministratoren und Architekten bietet die Erfahrung wertvolle Einsichten in die Bedeutung von ORM-Kompatibilität, bei der Wahl passender ETL-Strategien sowie im Umgang mit Query-Optimierung. Gerade im Zusammenspiel mit Systemen wie Prisma lohnt sich ein tieferer Blick auf das generierte SQL und die Query-Ausführungspläne, um unerwünschte Performancefallen frühzeitig zu erkennen und zu vermeiden. Nicht zuletzt illustriert die Migration einen zentralen Trend in der Softwarewelt: Technologische Entscheidungen müssen sich immer öfter nicht nur an innovativen Features orientieren, sondern vor allem an pragmatischen, stabilen und kosteneffizienten Lösungen. Postgres erweist sich dabei als bewährter Partner, der sich dank ständiger Weiterentwicklung den Anforderungen moderner Anwendungen problemlos anpasst. Der Weg von verteilten Datenbanken zurück zu stabilen, relationalen Lösungen ist somit kein Rückschritt, sondern eine strategische Weiterentwicklung.

Unternehmen, die diesen Schritt wagen, verbessern ihre Betriebsabläufe, reduzieren Risiken und profitieren von einem reichen Ökosystem, das Innovationen und Effizienz gleichermaßen fördert. Die Migration zu Postgres wird daher nicht nur technisch sinnvoll, sondern zu einer entscheidenden Weichenstellung für zukunftsfähige Dateninfrastrukturen.