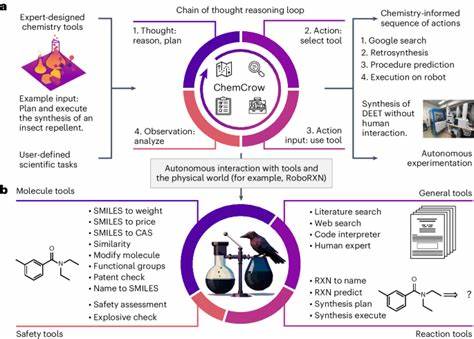

Die Chemie als Fachgebiet ist seit jeher stark auf fundiertes Wissen und komplexe Problemlösungskompetenz angewiesen. Die jüngsten Fortschritte im Bereich der künstlichen Intelligenz, insbesondere großer Sprachmodelle wie GPT-4 und vergleichbarer Systeme, eröffnen nun neue Wege zur Verarbeitung und Anwendung chemischen Wissens. Doch wie steht es um die tatsächlichen Fähigkeiten dieser Modelle im Vergleich zu menschlichen Chemikern? Können sie das Expertenwissen übertreffen, oder stoßen sie an fundamentale Grenzen? Dieser Frage widmet sich das Forschungsprojekt ChemBench, ein neuartiges Evaluationsframework, das die chemischen Kenntnisse und die Denkfähigkeiten großer Sprachmodelle systematisch untersucht und mit denen von Experten vergleicht.Große Sprachmodelle (Large Language Models, LLMs) sind maschinell lernende Systeme, die auf der Verarbeitung riesiger Textmengen basieren. Ursprünglich entwickelt, um natürliche Sprache zu verstehen und zu generieren, haben viele dieser Modelle in letzter Zeit gezeigt, dass sie in verschiedensten Fachgebieten erstaunliche Leistungen erbringen können – so auch in der Chemie und den Materialwissenschaften.

Ein Schema, das über 2700 Fragen sowohl mit Multiple-Choice- als auch offenen Antworten enthält, bildet die Basis von ChemBench. Diese Fragen decken ein breites Spektrum an Themen ab, die in der Chemieausbildung relevant sind, und verlangen unterschiedlichste Kompetenzen wie Faktenwissen, Rechenfähigkeiten, logisches Denken und chemische Intuition.Die Ergebnisse im Vergleich zwischen LLMs und menschlichen Experten sind beeindruckend. führende Sprachmodelle wie das sogenannte o1-preview haben es geschafft, menschliche Chemiker in diesem Benchmark deutlich zu übertreffen. Dies zeigt, dass LLMs mittlerweile mehr als bloße Faktenwiedergeber sind – sie können komplexe Fragen erfassen und fundierte Antworten liefern.

Gleichzeitig offenbaren die Studien aber auch Schwächen, gerade bei Aufgaben, die intensives Faktenwissen verlangen oder bei denen fehlerfreie Unsicherheitseinschätzungen notwendig sind. So fällt es den Modellen beispielsweise schwer, ihre eigene Sicherheit bei Antworten realistisch einzuschätzen, was in sensiblen Bereichen wie chemischer Sicherheit riskant sein kann.Ein besonderes Augenmerk liegt auf der Fähigkeit der Modelle, chemische Strukturinformationen verbal zu verstehen und anzuwenden. Während Chemiker oft Zeichnungen oder dreidimensionale Modelle zur Veranschaulichung nutzen, müssen die Sprachmodelle meist mit SMILES-Strings arbeiten, einer textbasierten Form der Molekülbeschreibung. Diese Umstellung erschwert das genaue Verständnis struktureller Feinheiten, was sich in niedrigen Erfolgsraten bei Aufgaben wie der Interpretation von NMR-Spektren oder Isomerenzahlen widerspiegelt.

An der Schnittstelle zwischen Sprachverarbeitung und chemischem Fachwissen besteht somit noch deutlicher Verbesserungsbedarf. Vielleicht können multimodale Modelle, die Bild- und Textinformationen gemeinsam auswerten, hier künftig eine bedeutende Rolle spielen.Während die LLMs in Bereichen wie allgemeiner Chemie oder technischer Chemie vergleichsweise gute Ergebnisse erzielen, zeigen sie gerade bei Themen wie Toxizität, Sicherheitsaspekten oder analytischer Chemie Schwächen. Das leitet wichtige Diskussionen ein, wie gut Lehrmittel und Prüfungsformate künftig auf die Fähigkeiten von KI-Systemen abgestimmt sein müssen. Wenn Maschinen Faktenwissen und Berechnungen schneller und präziser liefern können, muss die menschliche Chemieausbildung zwangsläufig auf kritisches Denken, komplexe Analyse und kreative Lösungsansätze fokussieren.

Das erneuert traditionelle Bildungsparadigmen und fordert eine Anpassung an das kollaborative Arbeiten zwischen Mensch und Maschine.Ein weiterer interessanter Befund betrifft die vermutete „chemische Intuition“ der KI. In der Arzneimittelforschung werden häufig Entscheidungen auf Basis von Präferenzen oder Erfahrungen getroffen, beispielsweise wenn ein Chemiker zwischen zwei Molekülen wählen muss. Im Rahmen der ChemBench-Studie konnten die Modelle jedoch kaum mit den Präferenzen erfahrener Chemiker Schritt halten, was zeigt, dass der Transfer von menschlich geprägtem Urteilsvermögen auf Maschinen noch in den Anfängen steckt. Hier bieten sich vielversprechende Forschungsansätze, insbesondere durch Methoden der sogenannten Präferenzoptimierung oder stärker integrierte Lernansätze, die menschliches Feedback einbeziehen.

Neben der Leistungsfähigkeit spielt auch die Transparenz und Sicherheit der KI-Modelle eine zentrale Rolle. Insbesondere wenn Nutzer aus der Allgemeinheit LLMs nutzen, um Fragen zur chemischen Sicherheit zu stellen, müssen die Modelle verlässliche und verantwortungsbewusste Antworten liefern. Die Studie zeigt, dass Fehlinformationen oder übermäßig sicher erscheinende aber falsche Antworten weiterhin ein Risiko darstellen. Für die Zukunft der Chemie bedeutet dies, dass menschliche Expertise trotz fortgeschrittener KI unersetzlich bleibt und dass verlässliche menschlich-kontrollierte Systeme oder kombinierte „Copilot“-Anwendungen weiterentwickelt werden müssen.Das ChemBench-Projekt steht exemplarisch für die Notwendigkeit, spezialisierte und umfassende Benchmarking-Frameworks für wissenschaftliche KI-Anwendungen zu entwickeln.

Im Gegensatz zu bisherigen Benchmarks, die sich oft auf eng definierte Vorhersageaufgaben konzentrieren oder keine offene Vergleichsbasis bieten, ermöglicht ChemBench eine differenzierte und transparente Bewertung der vielfältigen Fähigkeiten von Sprachmodellen, angepasst an die Komplexität chemischer Fragestellungen. Gleichzeitig schafft es eine Brücke zwischen der Forschungsgemeinschaft und Anwendern, indem es leicht erweiterbare und reproduzierbare Testumgebungen bereitstellt.Insgesamt zeigt die Gegenüberstellung von großen Sprachmodellen und menschlichen Chemikern, dass wir uns in einem spannenden Wandel befinden. KI-Systeme erweitern die Möglichkeiten der chemischen Forschung, können große Datenmengen analysieren und schneller einzelne Probleme lösen. Doch sie sind keine vollwertigen Ersatz für Experten, sondern Werkzeuge, die die menschliche Kompetenz ergänzen und verstärken.

Die Herausforderung liegt darin, diese Synergie optimal zu nutzen, während gleiche Zeit die Grenzen der Modelle transparent gemacht werden. Gerade im Hinblick auf Sicherheit, kritische Fragestellungen und ethische Aspekte ist ein reflektierter Umgang mit KI in der Chemie unabdingbar.Die Zukunft der Chemie wird daher durch eine enge Verzahnung von menschlichem Expertenwissen und künstlicher Intelligenz geprägt sein. Die Bereitschaft von Bildungseinrichtungen, Forschungsinstitutionen und der Industrie, sich auf diese Veränderungen einzustellen, entscheidet über die Innovationskraft des Faches. Das Beispiel ChemBench zeigt eindrucksvoll, wie systematische Evaluationen und interdisziplinäre Zusammenarbeit diese Entwicklung fördern können.

Spannende Entwicklungen sind zu erwarten – vom intelligenten experimentellen Design über automatisierte Interpretation bis hin zur Gestaltung neuer Moleküle werden KI-gestützte Ansätze zur Norm im modernen chemischen Forschungsprozess avancieren. Die Balance zwischen maschineller Leistungsfähigkeit und menschlicher Urteilskraft bleibt dabei eine der größten Herausforderungen und zugleich eine Chance für eine neue Ära der Chemie.