Die Zeitreihenprognose hat sich zu einer der zentralen Herausforderungen und zugleich einer der wichtigsten Disziplinen im Bereich der datengetriebenen Analysen entwickelt. Egal, ob es darum geht, Markttrends zu antizipieren, das Verhalten von Nutzern vorherzusagen, Ressourcen optimal einzusetzen oder wirtschaftliches Wachstum zu planen – präzise Forecasts sind entscheidend für den Geschäftserfolg. Die wachsende Datenmenge sowie deren Komplexität verlangen jedoch modernere Methoden, die weit über klassische statistische Modelle hinausgehen und insbesondere die Vernetzung von Datenquellen berücksichtigen. Genau hier setzen Graph-Transformer an und erweitern die Möglichkeiten der klassischen Zeitreihenanalyse entscheidend. Zeitreihenprognosen basieren traditionell auf der Analyse einzelner Datenreihen, bei der saisonale Schwankungen, Trends und weitere zeitliche Muster herausgearbeitet werden.

Dieser isolierte Blick auf einzelne Zeitreihen stößt jedoch schnell an Grenzen, sobald externe, miteinander verbundene Einflussgrößen ins Spiel kommen – beispielsweise Marketingkampagnen, Wettbewerber-Preise, saisonale Ereignisse oder regionale wirtschaftliche Indikatoren. Solche Zusammenhänge lassen sich nur durch eine Berücksichtigung von relationaler Information zuverlässig modellieren. Graphen als Datenmodell bieten hier eine natürliche Struktur, denn sie verbinden unterschiedlichste Entitäten und deren Merkmale in einem vernetzten Netzwerk. Entscheidend ist, dass in realen Geschäftsanwendungen fast sämtliche Daten in relationalen Datenbanken vorliegen. Diese enthalten diverse Tabellen mit jeweils eigenen Entitäten – wie Kunden, Produkte, Transaktionen oder Marketingaktionen – zwischen denen komplexe Beziehungen bestehen.

Relationale Deep Learning (RDL) ist eine Methode, die automatisch jene Beziehungen in Graphstrukturen überführt. Durch diese automatisierte Transformation werden Zeitreihenprognosen auf einem Teilgraphen realisiert, wobei die prädiktive Kraft nicht nur von den einzelnen Zeitverläufen, sondern von der gesamten Netzwerkstruktur profitiert. Ein anschauliches Beispiel liefert die Vorhersage von Produktverkäufen, die traditionell auf den historischen Verkaufszahlen basieren. Durch RDL und Graph-Transformer können zusätzlich Signale aus angrenzenden Knoten wie Kundenverhalten, Transaktionen und Marketingmaßnahmen integriert werden. Dadurch entsteht ein holistisches Modell, welches die Dynamiken im Produktnetzwerk besser erfasst und Vorhersagen deutlich präziser ermöglicht.

Im Kern basiert das Prognosemodell auf der mathematischen Darstellung eines Graphen mit Knoten und Kanten, wobei nur eine Teilmenge der Knoten zeitabhängige Signale (Zeitreihen) trägt, für die Vorhersagen getroffen werden sollen. Die Knoten zeichnen sich durch aussagekräftige Merkmale aus, die beispielsweise als kodierte Datenzeilen aus einer relationalen Datenbank vorliegen. Die Herausforderung besteht darin, eine Funktion zu erlernen, die zukünftige Werte einer Zeitreihe anhand mehrerer Datenquellen, zeitlicher Muster und graphbasierter Kontextinformationen zuverlässig vorhersagt. Das Herzstück der Architektur besteht aus mehreren Komponenten: Zum einen werden Datums- und Uhrzeitinformationen wie Wochentag, Monat oder Feiertage kodiert, um saisonale Effekte und zeitliche Besonderheiten im Modell abzubilden. Solche Kalenderkodierungen helfen insbesondere dabei, seltene Ereignisse wie Feiertage gesondert zu berücksichtigen, die starke Einflussfaktoren auf Zeitreihen haben können.

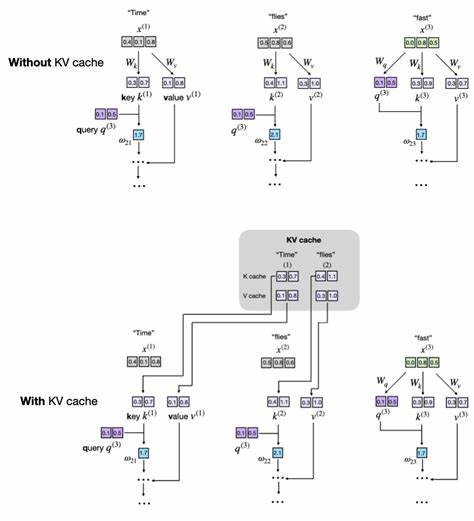

Weiterhin wird die Graphstruktur selbst genutzt, um Einbettungen für die einzelnen Entitäten zu generieren. Hierfür werden mithilfe eines Graph-Transformers Teilgraphen rund um die Zielknoten extrahiert, wobei ausschließlich vorherige Zeitpunkte berücksichtigt werden, um Datenlecks durch zukunftsgerichtete Informationen zu vermeiden. Die Verarbeitung der Teilgraphen erlaubt dem Modell, Beziehungen und komplexe Signalwirkungen unter den Knoten zu erkennen und für die Vorhersage zu nutzen. Neben der graphbasierten Kontextinformation ist die korrekte Einbettung der historischen Zeitreihe selbst für jeden Knoten entscheidend. Diese wird meist mittels Sequenzencoder realisiert, die unterschiedliche Architekturen aufweisen können – von einfachen mehrschichtigen Perzeptrons über Convolutional Neural Networks (CNNs) bis hin zu Transformer-Modellen.

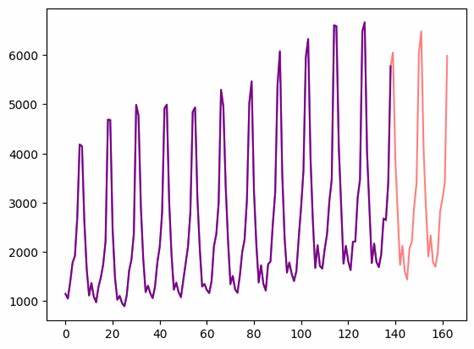

Besonders CNNs haben sich hier als effiziente und leistungsfähige Lösung erwiesen, da sie Zeitschritte kontinuierlich über den zeitlichen Verlauf erfassen können. Die Kombination all dieser Komponenten – Kalender- und Zeitkodierungen, Graph-Embeddings und sequenzielle Vergangenheitseinbettungen – wird in einer zentralen Vorhersagefunktion zusammengeführt. Klassischerweise erfolgt die Prognose über eine einfache Regression durch ein Multi-Layer-Perzeptron, das den nächsten Zeitpunkt vorhersagt. Diese Methode hat Vorteile in Hinblick auf Einfachheit und Effizienz, weist jedoch Beschränkungen auf, da sie von einer gaußförmigen Verteilung der Werte ausgeht und häufig zur sogenannten Mittelwert-Glättung neigt, wodurch präzise, hochfrequente Muster verloren gehen können. Um diesen Einschränkungen zu begegnen, kommen moderne generative Ansätze zum Einsatz, wobei Diffusionsmodelle eine zunehmend wichtige Rolle spielen.

Anstatt nur einen einzelnen Punktwert vorherzusagen, wird hier die gesamte Wahrscheinlichkeitsverteilung zukünftiger Werte modelliert. Durch iterative Denoising-Prozesse lässt sich aus der initialen Rauschprobe eine realistische, bedingt auf Inputmerkmalen generierte Zeitreihe erzeugen. Diese probabilistische Herangehensweise eröffnet vielfältige Möglichkeiten, beispielsweise mehrere Szenarien zu simulieren oder Unsicherheiten direkt in Form von Quantilen und Wahrscheinlichkeitsbereichen abzuleiten. In empirischen Vergleichen zeigen generative Modelle, dass sie in der Lage sind, feinere Details und plötzliche Änderungen besser abzubilden als klassische Regressionsmodelle. Im direkten Vergleich mit etablierten Tools wie Facebook Prophet erbringen graphbasierte Vorhersagemodelle nicht nur eine präzisere Einhaltung von Trends und Saisonalitäten, sondern reduzieren auch systematische Verzerrungen und Mittelwertverschiebungen.

Die Integration relationaler Datenquellen in Form von Graphinformationen führt nachweislich zu niedrigeren Fehlerwerten wie dem Mean Absolute Error (MAE) und dem Mean Absolute Percentage Error (MAPE). Die industrielle Bedeutung dieser Methodik erstreckt sich über vielfältige Bereiche. So können Einzelhandelsunternehmen mithilfe von Graph-Transformern und relationalen Deep-Learning-Techniken Verkaufszahlen genauer prognostizieren, was wiederum zu besserer Lagerhaltung und zielgerichteteren Werbekampagnen führt. Ebenso profitieren Versorgungsunternehmen von präziseren Vorhersagen in Verbrauchsprofilen und können dadurch ihre Ressourcen effizienter planen. Auch im Finanz- und Gesundheitswesen bieten sich durch die Kombination von Graphstrukturen und zeitlichen Daten neue Möglichkeiten zur Risikoabschätzung und Entscheidungsunterstützung.

Die Nutzung von Frameworks wie PyTorch Geometric ermöglicht eine schnelle Entwicklung und Umsetzung dieser Modelle. PyTorch Geometric unterstützt gängige Graph-Neural-Networks inklusive Graph-Transformer-Module und bietet umfangreiche Dokumentationen, sodass Anwender sowohl in Forschung als auch Praxis fundiert einsteigen können. Zudem erleichtert die Verfügbarkeit von Evaluierungsbenchmarks wie RelBench die systematische Bewertung und Verbesserung von Modellen auf relationalen Datensätzen. Zusammenfassend stellt die Kombination von Zeitreihenanalyse mit Graph-Transformern einen zukunftsweisenden Ansatz dar, der die Grenzen klassischer Einzelzeitreihenprognosen sprengt. Die Nutzung relationaler Daten, modernen Encoder-Techniken und probabilistischer Forecast-Modelle schafft eine flexible und leistungsfähige Grundlage für vielfältige Anwendungen in vernetzten, datenreichen Umgebungen.

Die weiteren Fortschritte in generativen Modellen, Sampling-Techniken und effizienten Graph-Encodings versprechen noch präzisere und robustere Vorhersagen in der nahen Zukunft – eine Bereicherung für Unternehmen und Organisationen, die auf datenbasierte Entscheidungen angewiesen sind.