Die rasante Entwicklung großer Sprachmodelle, auch bekannt als Large Language Models (LLMs), hat die Art und Weise, wie Entwickler mit Code und komplexen Aufgaben umgehen, grundlegend verändert. Besonders in sensiblen Branchen wie dem Finanzsektor, wo höchste Sicherheitsvorgaben und Korrektheitsanforderungen gelten, stellt sich die Frage: Wie können LLMs die Entwicklererfahrung tatsächlich aufwerten, ohne Kompromisse bei Sicherheit und Qualität einzugehen? Auch wenn der unmittelbare Einsatz von webbasierten AI-Diensten nicht möglich ist, eröffnen sich durch lokal betriebene Modelle und spezialisierte Use Cases spannende Potenziale, die weit über das einfache Abrufen von Code-Snippets hinausgehen. In den kommenden Abschnitten beleuchten wir, wie LLMs gezielt und pragmatisch eingebunden werden können, um Entwickler im Finanzumfeld produktiver und zufriedener zu machen. Zunächst einmal sei festgehalten, dass die Rolle von LLMs keineswegs darauf reduziert werden sollte, verlässlich sauberen Code automatisch zu generieren. Gerade in Bereichen mit kritischen Geschäftslogiken und strengen Compliance-Anforderungen, wie der Finanzbranche, muss jede Code-Änderung präzise geprüft werden.

Hier kann eine direkte, unreflektierte Übernahme KI-generierter Codevorschläge mehr Schaden anrichten als nützen. Doch die wahre Stärke von LLMs liegt in den unterstützenden Tätigkeiten rund um das Coding – was einzeln betrachtet unspektakulär erscheinen mag, im Gesamtbild jedoch zu erheblichen Effizienzgewinnen führt. Ein praxiserprobter Ansatz ist der Einsatz von lokal laufenden, datenschutzkonformen Modellen. Solche LLMs können auf firmeninterner Hardware betrieben werden und gewährleisten so, dass kein sensibler Quellcode die eigenen sicheren Infrastrukturen verlässt. Diese Modelle können speziell auf firmenspezifische Dokumentation und Coding-Guidelines trainiert oder angepasst werden, um kontextbezogene und passgenaue Hilfestellungen zu bieten.

So werden Entwickler beispielsweise beim Verfassen von Kommentaren oder der Erstellung von Dokumentationen unterstützt. In einem Bereich, der oft zeitintensiv und wenig inspirierend ist, kann diese automatisierte Textassistenz viel Entlastung bieten. Neben der Dokumentation ist auch Codeformatierung und Refactoring ein Feld, in dem LLMs signifikante Mehrwerte erzeugen können. Die Modelle helfen, Code konsistent nach den hauseigenen Styleguides zu gestalten und optimieren dabei die Lesbarkeit, ohne die zugrunde liegende Logik zu verändern. Besonders in großen Teams mit unterschiedlichem Hintergrund und Coding-Stil sorgt dieses automatisierte Aufräumen für eine verbesserte Codequalität und erleichtert die Wartbarkeit erheblich.

Darüber hinaus sind LLMs ausgezeichnete Partner für Design- und Architekturfragen. Obwohl sie keinen Ersatz für erfahrene Software-Architekten darstellen, können sie dennoch als beratende Instanz fungieren und bei der Strukturierung neuer Module oder der Evaluierung alternativer Lösungsansätze helfen. Durch das Stellen gezielter Fragen und das Erhalten gut formulierten Feedbacks können Entwickler frühzeitig potenzielle Probleme identifizieren und schneller zu tragfähigen Konzepten gelangen. Viele Entwickler berichten, dass sie LLMs vor allem als intelligente Suchhilfe einsetzen – eine Art stark erweitertes StackOverflow oder Google, das in Sekundenschnelle passende Codebeispiele, API-Beschreibungen oder Tool-Kombinationen vorschlägt. Dieser Nutzen ist zwar auf den ersten Blick nicht revolutionär, aber in der Praxis im Tagesgeschäft enorm wertvoll und spart viel Zeit bei der Recherche.

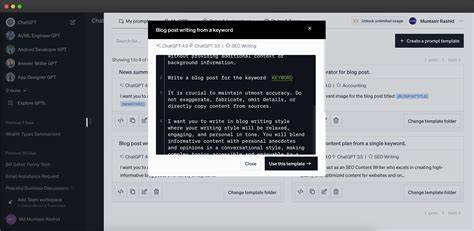

Der Unterschied zu herkömmlichen Suchmaschinen liegt darin, dass die Antworten oft im Kontext des Projektes oder der eingesetzten Technologien generiert werden und zielgerichteter sind. Trotz aller Vorteile darf man nicht verschweigen, dass der Einsatz von LLMs nicht ohne Herausforderungen bleibt. Gerade in der Finanzindustrie sind Fehler in der Software oft mit hohen Risiken verbunden – von finanziellen Einbußen bis hin zu regulatorischen Sanktionen. Deshalb ist es wichtig, dass bei der Nutzung von LLMs immer eine gründliche Überprüfung und Tests der Ergebnisse erfolgen. Das sogenannte „Prompt Engineering“ nimmt dabei eine zentrale Rolle ein: Entwickler müssen lernen, wie sie mit den Modellen interagieren, um präzise und nützliche Ausgaben zu erhalten und unnötige Iterationen zu minimieren.

Neben der technischen Seite spielt das Mindset eine große Rolle. Da KI-basierte Tools nicht allwissend sind und gelegentlich Fehlinformationen liefern, ist es entscheidend, sie als Partner zu verstehen, die repetitive oder mühsame Aufgaben erleichtern, nicht aber als vollständigen Ersatz menschlicher Expertise. Diese realistische Erwartungshaltung vermeidet Enttäuschungen und fördert einen besseren Umgang mit den Werkzeugen. Innovative Unternehmen experimentieren bereits heute mit internen Chatbots, die auf firmeneigenen Daten, Quellcodes und weiteren Dokumenten basieren. Diese Bots können Entwicklern schnellen Zugang zu Wissensbeständen bieten, ohne dass Informationen das geschützte Firmennetzwerk verlassen.

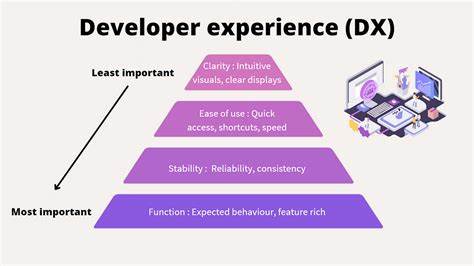

Solche Lösungen sind nicht nur datenschutzkonform, sondern auch speziell darauf ausgelegt, den spezifischen Herausforderungen kompletter Softwareprojekte Rechnung zu tragen – etwa durch das Verständnis von regulatorischen Anforderungen oder finanziellen Fachtermini. Ein weiterer interessanter Trend ist die Integration von LLMs in IDEs (Integrated Development Environments) auf dem lokalen Rechner. Dabei werden KI-gestützte Funktionen wie intelligente Autovervollständigung, Fehlerdiagnose oder sogar automatische Testfallgenerierung ohne Cloud-Anbindung angeboten. Das muss nicht unbedingt die aktuell größten Modelle sein, sondern kann auch auf kleineren, spezifischeren Modellen basieren, die ressourcenschonend arbeiten und trotzdem einen spürbaren Productivity-Boost ermöglichen. Final betrachtet eröffnen LLMs für Entwickler im Finanzsektor vor allem im Bereich der kognitiven Unterstützung großes Potenzial.

Sie helfen, Routineaufgaben zu erleichtern, das Auffinden relevanter Informationen zu beschleunigen und die Codequalität durch Strukturierung und Dokumentation zu verbessern. Trotz der notwendigen Vorsicht und des erhöhten Prüfungsaufwands können sie den komplexen Arbeitsalltag deutlich angenehmer und effizienter gestalten. Letztlich ist es eine Frage der Herangehensweise: Wer LLMs als Ergänzung und intelligentes Hilfsmittel begreift, nicht als Allheilmittel, wird von deren Vorzügen bestmöglich profitieren. Die Investition in robuste lokale AI-Infrastrukturen, gezieltes Prompt-Training sowie die Weiterentwicklung einer kritischen, aber konstruktiven Nutzerhaltung ist der Schlüssel, um die nächste Entwicklungsstufe in einem sensiblen Umfeld wie dem Finanzsektor zu erreichen.