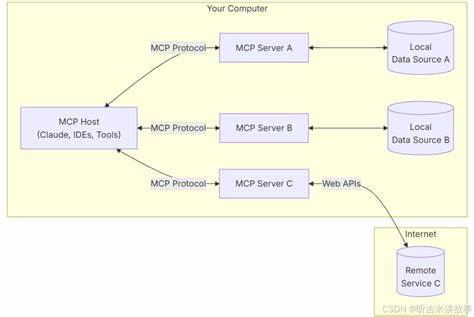

Die Technologiewelt entwickelt sich in rasantem Tempo weiter, insbesondere im Bereich der Künstlichen Intelligenz (KI) und deren Integration in verschiedenste Systeme. Ein wichtiger Aspekt dabei ist die Verbindung sogenannter Model Context Protocol (MCP) Server, die zunehmend an Bedeutung gewinnen. Die neue Bibliothek MCP Integrator und Aggregator bringt frischen Wind und bietet Entwicklern leistungsstarke Werkzeuge, um MCP-Server effizient miteinander zu verbinden und zusammenzuführen. Diese innovative Lösung erleichtert die Handhabung von MCP-Servern und bietet vielfältige Möglichkeiten im Zusammenspiel mit großen Sprachmodellen (LLMs). MCP-Server sind spezialisierte Systeme, die einen standardisierten Austausch von Modellkontexten und passenden Tools ermöglichen.

Sie sind essenziell, um KI-Anwendungen flexibel und modular zu gestalten. Die Herausforderung in der Praxis liegt jedoch oft darin, mehrere MCP-Server miteinander zu verbinden oder sie direkt in KI-Workflows zu integrieren. Genau hier setzt die neue Bibliothek an. Sie bietet zwei Hauptkomponenten: Einen Integrator und einen Aggregator. Beide machen die Zusammenarbeit verschiedener MCP-Systeme anwenderfreundlicher und leistungsfähiger.

Der MCP Integrator dient als Brücke zwischen MCP-Servern und großen Sprachmodellen. Er ist darauf ausgelegt, eine nahtlose Verbindung herzustellen, Tools für die LLM-Anbieter zu formatieren und Nutzereingaben oder Antworten des Sprachmodells automatisch auf notwendige Werkzeugaufrufe zu prüfen. So können Entwickler komplexe Abläufe in KI-Anwendungen deutlich vereinfachen. Mit einem gut konfigurierten Integrator lässt sich beispielsweise sicherstellen, dass Sprachmodelle nur die passenden Werkzeuge ansteuern, und die Ergebnisse automatisch weiterverarbeiten. Die Bibliothek unterstützt verschiedene Verbindungstypen wie HTTP, CLI oder Streaming-Verbindungen (SSE), was die Integration sehr flexibel macht.

Der Aggregator hingegen ist ein MCP-Server, der mehrere MCP-Server unter einer einheitlichen Schnittstelle zusammenfasst. Dies ist besonders hilfreich, wenn man verschiedene spezialisierte Systeme in einem Gesamt-Ökosystem bündelt, wobei jedes System seine spezifischen Werkzeuge beisteuert. Der Nutzen liegt darin, dass KI-Anwendungen auf ein einziges MCP-System zugreifen können, das im Hintergrund die Verbindung an die einzelnen MCPs steuert. Ein Einsatzszenario könnte sein, unterschiedliche Speicher- oder Analyse-Server zusammenzuführen, um eine optimierte Ressourcennutzung zu gewährleisten. Auch die Protokollübersetzung spielt eine bedeutende Rolle – wenn ein MCP über ein bestimmtes Protokoll nicht erreichbar ist, kann der Aggregator einen Vermittler mit anderem Protokoll verwenden und so Kompatibilität sicherstellen.

Neben Integrator und Aggregator stellt die Bibliothek auch einen sogenannten SimpleServer bereit. Dieser ist ein konfigurierbarer MCP-Server, der leicht an unterschiedliche Protokolle angepasst werden kann – dazu gehören HTTP-Schnittstellen, Server-Sent Events (SSE) oder Kommandozeileninterfaces (CLI). Entwickler definieren lediglich die Tools und deren Eingabeschemata, der SimpleServer kümmert sich um die eigentliche Kommunikation und Protokolllogiken. Das ist äußerst praktisch, wenn man MCP-Server variabel in verschiedenen Umgebungen oder Deployments einsetzen möchte, ohne den Kerncode anpassen zu müssen. Installation und erster Einsatz der MCP-Bibliothek sind sehr unkompliziert.

Die Bibliothek ist über npm verfügbar und lässt sich mit wenigen Zeilen Code in eigene Projekte einbinden. Für den Integrator wird eine Konfiguration benötigt, die Angaben zur Verbindungsart, die URL oder CLI-Pfade und entsprechende Header enthält. Ebenso ist die Auswahl des LLM-Anbieters und des verwendeten Modells erforderlich. Anschließend kann der Integrator starten, die verfügbaren Tools abrufen, diese für das LLM formatieren und Toolaufrufe aus LLM-Antworten extrahieren und ausführen. Der gesamte Prozess kann programmatisch kontrolliert und gesteuert werden, was vor allem für Automatisierung und komplexe Anwendungen ein großer Vorteil ist.

Die einfache Bedienbarkeit und Modularität machen die Bibliothek nicht nur für Entwickler interessant, sondern auch für Unternehmen und Forschungseinrichtungen, die KI-Anwendungen skalierbar und erweiterbar gestalten möchten. Durch die Unterstützung mehrerer Verbindungsarten und die Fähigkeit, diverse MCP-Server flexibel zu bündeln, kann die MCP Integrator und Aggregator Bibliothek in unterschiedlichsten Architekturen eingesetzt werden. Besonders bei Docker- und Container-basierten Deployments zeigt sich ihr Vorteil, da dadurch ganze MCP-Landschaften in einem einzelnen Docker-Image oder einer docker-compose-Konfiguration gebündelt und transportiert werden können. Darüber hinaus bietet die Bibliothek umfassende Konfigurationsmöglichkeiten. So lässt sich beispielsweise die Anzahl der parallelen Calls begrenzen, was entscheidend für das Handling von Lastspitzen oder Verbindungsengpässen ist.

Auch die Möglichkeit, Zeitüberschreitungen, Wiederholversuche und Umgebungsvariablen anzupassen, erlaubt eine maßgeschneiderte Steuerung des Betriebs. Für Entwickler sind außerdem Beispielkonfigurationen für CLI-, HTTP- und SSE-Server beiliegend, die als Ausgangspunkt für eigene Anpassungen dienen können. Die Bibliothek ist in TypeScript geschrieben, was für moderne Entwicklungsumgebungen große Vorteile bringt. Die statische Typisierung sorgt für zuverlässigen Code und erleichtert das Debugging. Zudem ist der Quellcode quelloffen und unter GPLv3 lizenziert, wodurch eine aktive Beteiligung aus der Community gefördert wird.

Die Unterstützungen für große LLM-Provider wie OpenAI, Anthropic, AWS Bedrock oder Claude stellen sicher, dass ein breites Spektrum an KI-Systemen bedient wird. Nicht zuletzt erleichtert die Bibliothek auch das Testen und die kontinuierliche Integration. Standardisierte Umgebungsvariablen für API-Schlüssel und Modelle können flexibel gesetzt werden. Auch die Option, den Aggregator direkt via CLI zu starten, macht das lokale Testen und Hosting zügig möglich. Für den produktiven Einsatz in Cloud- oder Container-Umgebungen sind diese Eigenschaften besonders wertvoll.

Zusammenfassend lässt sich sagen, dass die MCP Integrator und Aggregator Bibliothek eine bedeutende Neuerung darstellt, die viele Herausforderungen der MCP-Integration und -Aggregation adressiert. Sie ermöglicht eine zentrale, flexible und performante Verwaltung von MCP-Servern, die als Rückgrat moderner KI-Applikationen dienen. Mit ihr werden Entwickler in die Lage versetzt, komplexe MCP-Architekturen einfach zu realisieren, unterschiedliche Protokolle zu überbrücken und KI-Workflows effizienter zu gestalten. Die vielseitigen Konfigurationsoptionen und die Unterstützung gängiger KI-Provider machen sie zu einem unverzichtbaren Werkzeug in der aktuellen KI-Infrastruktur. Unternehmen und Entwickler, die auf der Suche nach einer Lösung sind, um MCP-Systeme nicht nur separat, sondern zusammenhängend zu betreiben, finden mit der MCP Integrator und Aggregator Bibliothek ein mächtiges Werkzeug.

Es lohnt sich, die Möglichkeiten und Vorteile dieser neuen Bibliothek zu erforschen und in eigenen Projekten anzuwenden, um so die nächste Generation intelligenter Anwendungen zu gestalten.