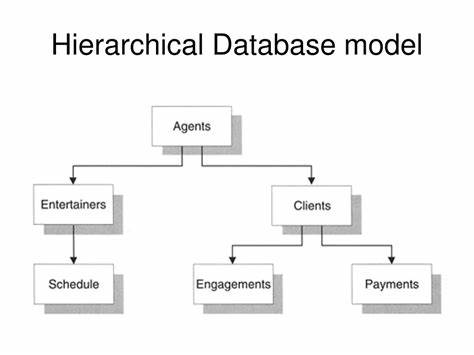

Hierarchische Modelle haben in der Statistik und Datenanalyse an Bedeutung gewonnen, insbesondere wenn es darum geht, komplexe Strukturen und Abhängigkeiten in Daten abzubilden. Die Frage, ob man sich bei der Modellierung für einfache oder komplexe hierarchische Modelle entscheiden sollte, beschäftigt sowohl Praktiker als auch Forschende seit langem. Dabei geht es nicht nur um technische Aspekte, sondern vor allem um das Abwägen von Modelltreue, Interpretierbarkeit und Rechenaufwand. In diesem Kontext stellt sich die zentrale Herausforderung: Wie gelingt es, den Balanceakt zwischen vereinfachten hierarchischen Strukturen und elaborierten Modellen mit zahlreichen Interaktionen und Parametern zu meistern? Ein unkompliziertes Modell ist häufig leichter zu interpretieren und schneller zu schätzen, kann jedoch wichtige Zusammenhänge übersehen oder zu stark vereinfachen. Ein komplexes Modell verspricht, die Datenstruktur detaillierter abzubilden, ist aber oft schwieriger zu verstehen, anspruchsvoll in der Schätzung und anfällig für Überanpassung, besonders wenn die Datenmenge limitiert ist.

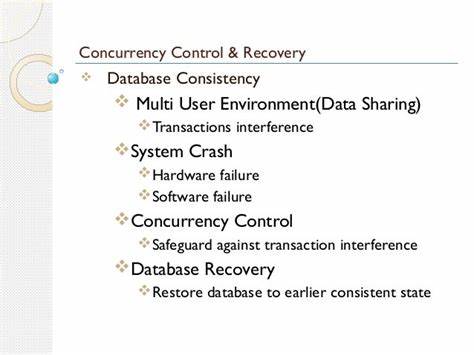

Der Schlüssel liegt darin, die Komplexität der Modelle an die tatsächlichen Anforderungen der Daten und der Forschungsfrage anzupassen. Bayesianische Methoden haben hier einen besonderen Stellenwert, da sie von Natur aus flexibel mit Unsicherheit umgehen. In der bayesianischen Hierarchie kann eine komplexe Modellstruktur aufgebaut werden, die dennoch in Situationen mit wenigen Daten oder hohem Rauschen auf einfachere Formen zurückfällt. Dies geschieht durch den Einfluss der Priorverteilungen, die, wenn die Daten keine klare Information liefern, die Posteriorverteilung in Richtung der Prior schieben. Ein weiterer Vorteil der bayesianischen Modelle liegt in der Möglichkeit, eine iterative Modellierung und -prüfung zu betreiben.

Das bedeutet, zunächst beginnt man mit einem einfachen hierarchischen Modell und evaluiert dessen Passgenauigkeit. Stellt sich heraus, dass wichtige Abhängigkeiten oder Interaktionen nicht erfasst werden, kann das Modell schrittweise erweitert werden. Dieser Prozess ist nicht nur wissenschaftlich sinnvoll, sondern auch praktisch zielführend, da man auf diese Weise Probleme wie Überanpassung und schlechte Schätzbarkeit besser kontrolliert. Ein zentrales Konzept in der Praxis ist das sogenannte "aufbauende Modellieren". Hierbei wird nicht sofort ein hochkomplexes Modell formuliert, sondern man arbeitet sich von einfachen Strukturen zu komplexeren vor.

Dies reduziert das Risiko, in unübersichtliche Parameterräume abzutauchen oder mit problematischer Posteriorgeometrie konfrontiert zu werden. Gleichzeitig lassen sich durch den Vergleich verschiedener Modellstufen die Effekte einzelner Modellbestandteile besser verstehen. Moderne probabilistische Programmiersprachen und schnelle bayesianische Inferenzalgorithmen erleichtern den Umgang mit komplexeren hierarchischen Modellen erheblich. Dennoch sollte man sich vor der Versuchung hüten, Komplexität nur um der Komplexität willen einzuführen. Eine Erweiterung der hierarchischen Struktur ist dann sinnvoll, wenn sie theoretisch oder empirisch begründet ist und den Modellfit sowie die Vorhersage verbessert.

Empirisch hat sich gezeigt, dass der Einsatz komplexer Modelle in Situationen, in denen das Problem auch nur ansatzweise komplex ist, oftmals bessere Ergebnisse liefert. Wie mehrfach betont wurde, ist die Antwort auf den Balanceakt nicht: Komplexität vermeiden, sondern: Komplexität sinnvoll steuern und gezielt einführen. Die Praxis zeigt auch, dass einfache Modelle manchmal besser abschneiden können als hochkomplexe, insbesondere wenn letztere schlecht spezifiziert oder überparametrisiert sind. Dennoch sollte die Antwort kein Festhalten an einfachen Modellen sein, sondern das stete Bemühen, komplexere Modelle zu entwickeln, die genau die Aspekte erfassen, die zum Erfolg des einfachen Modells führen. Es gibt verschiedene Techniken, um komplexe hierarchische Modelle handhabbar zu machen.

Dazu zählen die Nutzung von Näherungsverfahren wie Laplace-Approximationen, variationalen Methoden und Markov-Chain-Monte-Carlo-Samplern mit Verbesserungen wie Hamiltonian Monte Carlo. Weiterhin sind Regularisierungspriors, sogenannte schwach informierende oder penalized complexity Priors, ein effektives Mittel, Modelle so zu steuern, dass sie bei wenig Daten auf einfachere Strukturen reduzieren. Empirische Bayes-Verfahren können ebenfalls einen Kompromiss bieten, indem sie zunächst per Optimierung gewisse Modellkomponenten schätzen und anschließend die Unsicherheit anderer Parameter berücksichtigen, auch wenn diese Methoden nicht der vollständigen Bayesschen Integration entsprechen. Die Anwendung von sogenannten "Canary Variablen" oder anderen Modelldiagnostik-Werkzeugen unterstützt dabei, Modellfehlanpassungen frühzeitig zu erkennen und den Modellaufbau zu verbessern. Neben den technischen und analytischen Überlegungen spielt auch die Frage der Interpretierbarkeit eine wichtige Rolle.

Ein einfacheres hierarchisches Modell ermöglicht oft eine bessere Kommunikation der Ergebnisse und ein tieferes Verständnis der zugrunde liegenden Prozesse. Gerade in multidisziplinären Teams oder bei der Kommunikation von statistischen Ergebnissen an nicht-statistische Stakeholder kann das ausschlaggebend sein. Insgesamt ist es ratsam, nicht nur ein einzelnes Modell auszuloten, sondern eine Modellpalette von einfach bis komplex zu entwickeln. Die sogenannte „Entfaltung“ des Modells als Blume, die mit zunehmender Datenverfügbarkeit und Erkenntnis mehr „Blütenblätter“ zeigt, illustriert diesen fortschreitenden Prozess bildhaft. Bei immer mehr Daten können dann auch komplexere Modelle solide geschätzt werden, ohne Gefahr zu laufen, durch fehlende Datenqualität oder -quantität in die Irre geführt zu werden.

![3D Printed TPU Bellows [video]](/images/4675A5AA-E9D1-42A5-8444-C7A0113F4D36)