Die rasante Entwicklung künstlicher Intelligenz hat insbesondere durch Fortschritte im Bereich der Sprachmodelle beeindruckende Fortschritte erzielt. Sprachmodelle wie GPT, BERT oder ihre Nachfolger dominieren die Forschung und Anwendungen im Bereich der automatischen Textgenerierung, Sprachverarbeitung und vielen weiteren Gebieten. Ein wesentlicher Faktor, der die Leistungsfähigkeit dieser Modelle bestimmt, ist ihre Fähigkeit, Wissen zu speichern und zu verarbeiten. Dies wirft fundamentale Fragen auf: Wie viel Speicherfähigkeit besitzen Sprachmodelle tatsächlich? Wie viel Wissen können sie sich merken? Und wie funktioniert dieser Prozess der sogenannten Memorierung im Vergleich zur Generalisierung? Aktuelle Forschungsergebnisse zeigen erstaunliche Fakten über die exakte Speicherleistung von Sprachmodellen und eröffnen neue Perspektiven auf den Umgang mit Trainingsdaten und Modelloptimierungen. Grundlagen der Memorierung in Sprachmodellen Sprachmodelle sind darauf ausgelegt, auf Basis großer Textmengen Muster zu erkennen, um anschließend neue Texte zu generieren oder auf Eingaben sinnvoll zu reagieren.

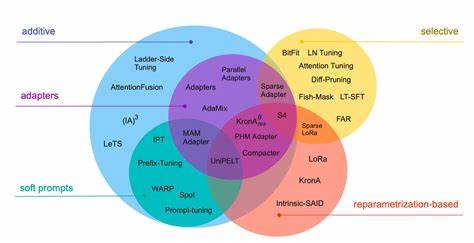

Dabei wird nicht nur Wissen über die Natur der Sprache, Grammatik oder Bedeutung gespeichert, sondern auch spezifische Informationen aus Trainingsdaten. Diese Fähigkeit kann in zwei Hauptkomponenten unterteilt werden: Memorierung und Generalisierung. Memorierung bezeichnet dabei das direkte Abspeichern von Informationen aus den Trainingsdaten, ohne dass das Modell diese kontextuell oder kollokativ verallgemeinert. Generalisierung hingegen beschreibt das Erkennen zugrundeliegender Sprachgesetze und Zusammenhänge, um neue, ungesehene Situationen oder Daten korrekt zu interpretieren. Eine neue wissenschaftliche Studie hat diese Unterscheidung präzisiert und formalisiert.

Die Forscher konnten Memorierung in sogenannte „beabsichtigte“ und „unbeabsichtigte“ Informationen untergliedern. Während die beabsichtigte Memorierung gewollt und oftmals hilfreich für die Modellfunktion ist, gibt es auch unbeabsichtigte Memorierung, bei der das Modell Daten direkt speichert, die eigentlich nicht zur Verallgemeinerung dienen sollten. Dies ist besonders im Kontext von Datenschutz und Sicherheitsfragen relevant, da solche Informationen potenziell sensible Daten enthalten können. Die exakte Kapazität von Sprachmodellen in Bits pro Parameter Durch umfangreiche Experimente konnten die Forscher die maximale Speicherkapazität der modernen Sprachmodelle quantifizieren. Sie fanden heraus, dass GPT-ähnliche Modelle eine Speicherkapazität von exakt etwa 3,61 Bits pro Parameter besitzen.

Diese Zahl ist überraschend präzise und bietet eine neue Grundlage für das Verständnis der effektiven Leistungsgrenze dieser KI-Modelle. Dabei bedeutet ein einzelner Parameter in einem Transformer-Modell eine Zahl, die dazu beiträgt, Eingaben zu wichtigen Ausgaben in einem neuronalen Netzwerk umzuwandeln. Die Gesamtzahl der Parameter korreliert mit der Komplexität und Lernfähigkeit eines Modells. Das Ergebnis von 3,61 Bits zeigt, dass trotz des massiven Umfangs der Modelle – einige bestehen aus Milliarden Parametern – deren effektive Speicherkapazität klar begrenzt und messbar ist. Die Forscher kamen unter anderem zu dieser Erkenntnis, indem sie Modelle trainierten, die ausschließlich memorieren sollten, indem sie alle Möglichkeiten zur Generalisierung ausschlossen.

So konnten sie den reinen Memorierungseffekt isolieren und quantifizieren. Ihre Experimente umfassten hunderte von Modellen mit unterschiedlichen Größen, die von 500.000 bis zu 1,5 Milliarden Parametern reichten. Dies ermöglichte die Ableitung von Skalenbeziehungen zwischen Modellgröße, Datengröße und der Wahrscheinlichkeit, dass ein Modell Ansprechpartnerinformationen oder Details aus dem Trainingsdatensatz erinnert – ein Phänomen, das als „Membership Inference“ bekannt ist. Memorierung vs.

Generalisierung – ein Balanceakt Interessanterweise zeigen die Ergebnisse, dass Sprachmodelle erst dann memorieren, wenn ihr Kapazitätslimit nicht erreicht ist. In den frühen Trainingsphasen speichern sie hauptsächlich spezifische Dateninhalte. Sobald die Kapazität jedoch ausgenutzt wird, sinkt die reine Memorierung zugunsten einer besseren Generalisierung der dargestellten Sprache. Dies erklärt auch, warum sehr große Modelle trotz enormer Parametermengen nicht zwangsläufig mehr über spezifische Datenpunkte memorieren, sondern vielmehr komplexere Zusammenhänge und Regeln erfassen. Die Implikationen dieser Erkenntnisse sind weitreichend.

Zum Beispiel kann dieser Sachverhalt genutzt werden, um Datenschutzrisiken gezielt zu minimieren, indem man die Kapazitätsgrenzen kennt und dadurch das Risiko unerwünschter Datenspeicherung reduziert. Zudem hilft dieses Wissen, Trainingsprozesse besser zu steuern und Modelle so zu gestalten, dass sie Informationen effizient und verantwortungsbewusst speichern. Auswirkungen auf die Praxis und Forschung Die Feststellung, dass Sprachmodelle exakt 3,61 Bits pro Parameter memorieren, liefert zahlreiche Anhaltspunkte für Entwicklungen im Bereich KI und maschinelles Lernen. Auf technischer Ebene können Entwickler und Forscher Modellarchitekturen besser anpassen, Speicher- und Rechenressourcen effizienter einsetzen und die Trainingsdaten gezielter auswählen. Darüber hinaus eröffnet es Möglichkeiten zur Verbesserung der Modellinterpretiertbarkeit.

Wenn bekannt ist, mit welchem Informationsvolumen ein Modell arbeitet, können Erklärbarkeitsmethoden verfeinert werden, was eine transparentere Interaktion mit der KI ermöglicht. Gerade in sicherheitskritischen oder regulierten Bereichen, in denen Vertrauen eine große Rolle spielt, ist dies ein großer Vorteil. Ein weiterer wichtiger Aspekt betrifft die Skalierbarkeit. Die Studie verdeutlicht, wie das Verhältnis zwischen Datengröße und Modellkapazität optimale Einsatzbereiche absteckt. Große Datenmengen allein garantieren keine bessere Leistung, wenn die Kapazität des Modells nicht ausreicht, diese Informationen sinnvoll zu verarbeiten.

Somit wird auch die Effizienz bei der Datenverarbeitung und -speicherung neu bewertet und neu gedacht. Zukünftige Entwicklungen und ethische Überlegungen Mit der Relevanz der exakten Speicherfähigkeit von Sprachmodellen steigt auch die Verantwortung bei der Entwicklung und dem Einsatz dieser Technologien. Unternehmen und Entwickler sind angehalten, die Grenzen der Memorierungslosigkeit zu kennen und einzuhalten, um den Schutz sensibler Daten tiefgreifend sicherzustellen. Parallel dazu verlangt die Forschung nach weiteren Erkenntnissen zur Funktionsweise der Modelle, insbesondere hinsichtlich der Kombination von Memorierung und Generalisierung in realen Anwendungen. Die Frage, wie Modelle effizienter und ethisch vertretbarer trainiert und genutzt werden können, wird zunehmend ins Zentrum rücken.

Auch rechtliche Vorgaben und Datenschutzbestimmungen werden durch diese neuen wissenschaftlichen Erkenntnisse weiter beeinflusst und definiert. Abschließend lässt sich festhalten, dass die Entdeckung der genauen Zahl von 3,61 Bits pro Parameter eine Revolution im Verständnis der Kapazität von Sprachmodellen darstellt. Sie gibt nicht nur klare Grenzen vor, sondern setzt auch neue Impulse für Innovationen in der KI-Forschung, die zu präziseren, sichereren und leistungsfähigeren Systemen führen wird. Die Zukunft der Sprachmodelle hängt maßgeblich davon ab, wie gut es gelingt, den Spagat zwischen effizienter Datenspeicherung und verantwortungsvollem Umgang mit Informationen zu meistern.

![Faulty 120W charger analysis (Anker GAN Prime) [video]](/images/16EF8747-791A-4814-8817-21E4FFA25C9F)