Die rasante Entwicklung von Künstlicher Intelligenz und insbesondere großer Sprachmodelle (LLMs) hat maßgeblichen Einfluss auf die Art und Weise, wie Unternehmen Dokumente verarbeiten und analysieren. Gerade in hochsensiblen Branchen wie dem Finanzwesen oder dem Gesundheitssektor ist die Qualität der Datengrundlage ausschlaggebend für den Erfolg von KI-gestützten Automatisierungen und Entscheidungsprozessen. Hier setzt Tensorlake Cloud an und zeigt eindrucksvoll, wie man die Herausforderung der komplexen, heterogenen Dokumentenlandschaft meistert. Ein großes Problem bei der Arbeit mit KI-Anwendungen in Unternehmen ist die mangelnde Zuverlässigkeit der zugrundeliegenden Daten. Selbst die besten Modelle sind auf saubere, vollständige und kontextuell interpretierbare Eingabedaten angewiesen.

Werden Dokumente falsch gelesen, fragmentiert oder unvollständig verarbeitet, entstehen Halluzinationen und Fehler, die das Vertrauen in KI-Lösungen erschüttern und damit die breite Adoption verzögern. Genau diese Problematik adressiert Tensorlake Cloud, indem es manuelle und erschöpfende Vorverarbeitungsmethoden durch eine intelligente, automatisierte Plattform ersetzt. Die typischen Herausforderungen bei der Dokumentenverarbeitung liegen in der Vielfalt der Dokumenttypen und ihrer diversen Layouts. Ein einfaches Beispiel ist ein Kontoauszug, der Textbereiche, Tabellen mit Transaktionen, Metadaten und Unterschriften auf einer Seite vereint. Die herkömmlichen Systeme arbeiten häufig mit linearen Parsingsmethoden, die versuchen, das Dokument als durchgängige Textquelle zu interpretieren.

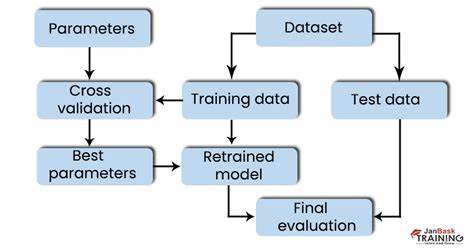

Dabei gehen wichtige Details verloren oder werden falsch zugeordnet. Tensorlake hat eine revolutionäre Technik entwickelt, die das Dokument ähnlich wie ein Mensch betrachtet: Die Plattform erkennt, dass Dokumente mehrdimensional sind und aus mehreren semantisch unterschiedlichen Segmenten bestehen. Sie zerlegt das Dokument zuerst in logisch zusammenhängende Blöcke, etwa Tabellen, Überschriften, Absätze oder Unterschriften. Anschließend kommen spezialisierte KI-Modelle zum Einsatz, die jeweils auf den jeweiligen Dokumentensegmenttyp optimiert sind. So analysiert Tensorlake Texte, Tabellen, Diagramme und sogar Formeln mit den jeweils passenden Algorithmen.

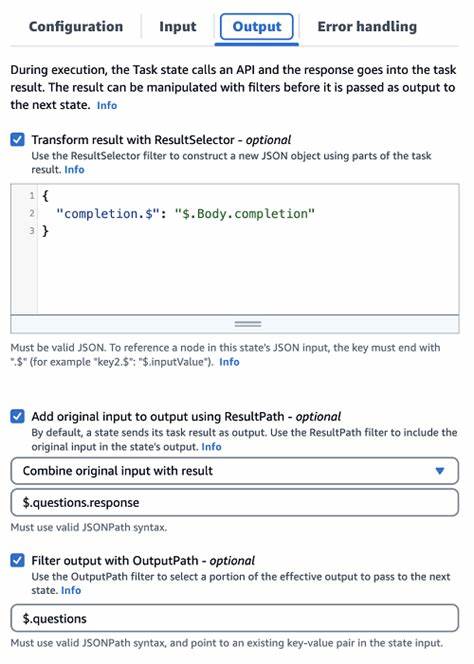

Dies führt zu einer wesentlich präziseren und umfassenderen Extraktion, die nicht nur vollständiger ist, sondern auch der menschlichen Interpretation stark ähnelt. Das Ergebnis sind strukturierte Datensätze im JSON-Format, die sich hervorragend für den Einsatz in Retrieval-Augmented-Generation (RAG) Workflows, Suchindizes, automatisierte Entscheidungsprozesse oder Trainingsdatensätze eignen. Ob es darum geht, finanzielle Transaktionen aus Kontoauszügen auszulesen oder Formularantworten zu erfassen – Tensorlake bringt Konsistenz und Skalierbarkeit in den Prozess. Doch die Verarbeitung der Dokumente ist nur der erste Schritt. Unternehmen benötigen eine leistungsfähige Orchestrierung, um die extrahierten Daten weiterzuverarbeiten, zu validieren, zu transformieren und für verschiedene Endsysteme nutzbar zu machen.

Häufig müssen hierfür mehrere Systeme wie Airflow, Spark oder andere Orchestrierungstools und Speichersysteme miteinander verbunden werden, was komplex und anfällig für Fehler ist. Tensorlake verzichtet auf diese komplexe Infrastruktur und bietet eine einheitliche Data-Orchestration-API. Damit lassen sich komplette Verarbeitungspipelines in Code definieren, von der Ingestion über die Transformation bis hin zur Ausgabe, und nahtlos auf einer vollständig verwalteten, serverlosen Plattform betreiben. Die dahinterstehende Architektur ist speziell für KI-Workloads optimiert, nutzt automatisierte Zuweisung von GPU- und CPU-Ressourcen und ermöglicht so die parallele Verarbeitung tausender Dokumente in Echtzeit – auf öffentlichen Clouds oder privaten Netzwerken. Besonders wichtig für Unternehmen ist die Verlässlichkeit und Vollständigkeit der Verarbeitung.

Tensorlake garantiert, dass keine Dokumente verloren gehen, keine fehlerhaften Extraktionen stillschweigend auftreten und keine aufwändigen Wiederherstellungsprozesse notwendig werden. So fließen alle Daten konsistent in die downstream Systeme, seien es Datenbanken, Embeddings-Speicher oder Analysewerkzeuge. Die Plattform eignet sich insbesondere für hochkritische Bereiche, in denen Unterschriften, rechtliche Änderungen oder Compliance-relevante Informationen von großer Bedeutung sind. Tensorlake erkennt beispielsweise Unterschriften mit nahezu perfekter Genauigkeit und entfernt ungewollte Streichungen aus Texten, was für die Versionierung und Zusammenfassung von juristischen Dokumenten essenziell ist. Auch verschiedene Chunking-Methoden zur effizienten Verarbeitung und Suche werden direkt unterstützt, sodass die Nutzer ohne zeitaufwendige Vorverarbeitung sofort loslegen können.

Tensorlake wird bereits erfolgreich in großen Finanzinstituten, Gesundheitseinrichtungen und öffentlichen Versorgungsunternehmen eingesetzt. Diese Organisationen profitieren von der hohen Performance, der Skalierbarkeit und der Compliance-Auslegung der Plattform. Vollständige Private-Network-Implementierungen und native Integration mit Systemen wie Amazon S3, SAP oder SharePoint vereinfachen das Onboarding. Zudem sind SOC 2 Type II Zertifizierungen in Vorbereitung, was für viele Unternehmen ein wichtiges Sicherheitsmerkmal darstellt. Für Spezialfälle bietet Tensorlake auch private Feinabstimmung von Modellen und die Möglichkeit, eigene Schemas zu definieren.

So lassen sich spezifische Anforderungen in puncto Genauigkeit, Compliance und Performance individuell abdecken. Der Einstieg in Tensorlake ist denkbar einfach. Entwickler und Data Scientists können die Plattform zunächst im Playground testen, um Parsing-Ergebnisse mit eigenen Dokumenten live zu begutachten. Die Python SDK ermöglicht eine einfache Integration in bestehende Anwendungen und Infrastruktur. Für größere Unternehmen gibt es maßgeschneiderte Onboarding-Angebote und eine aktive Community für Austausch und Support.