PostgreSQL gehört zu den beliebtesten Open-Source-Datenbanksystemen weltweit, die in Millionen von Anwendungen und Diensten zum Einsatz kommen. In den letzten Jahren hat sich jedoch eine grundlegende Diskussion über die optimale Speicherarchitektur für PostgreSQL in Cloud-Umgebungen entwickelt. Die klassische Architektur mit netzwerkgebundenem Speicher hat lange Zeit die Szene dominiert, da sie eine flexible Skalierbarkeit und eine hohe Datenverfügbarkeit ermöglichte. Doch die rasanten Fortschritte bei der Speicherhardware, insbesondere bei NVMe SSDs, stellen dieses Paradigma zunehmend in Frage und eröffnen neue Perspektiven für die Speicherung von Daten in PostgreSQL-Datenbanken. Ein genaues Verständnis dieser Entwicklung ist essenziell für Unternehmen, die Performance, Zuverlässigkeit und Kosten in Einklang bringen möchten.

Historischer Blick auf Speicherarchitekturen in der Datenbankwelt Historisch gesehen wurden Datenbanken meist auf lokalen Festplatten (HDDs) betrieben. Diese Speichertechnik war damals zwar weit verbreitet, hatte aber ihre Grenzen. Die mechanischen Bauteile führten bei zufälligen Lese- und Schreibzugriffen zu erheblichen Verzögerungen. Die Performance war zudem durch eine begrenzte Haltbarkeit der Platten eingeschränkt. Um dem entgegenzuwirken, nutzten viele Unternehmen aufwendig konfigurierte RAID-Systeme oder spezialisierte Speicherlösungen.

Mit dem Aufstieg des Cloud Computing änderte sich die Speicherinfrastruktur grundlegend. Cloud-Anbieter wie Amazon Web Services etablierten die Idee, Speicher von den zugrundeliegenden Servern zu entkoppeln und ihn netzwerkgebunden zur Verfügung zu stellen. Diese Netzwerkspeicherlösungen boten mehrere Vorteile zugleich. Durch die Verteilung der Daten auf viele physische Laufwerke konnte die Leistung verbessert werden, während gleichzeitig hohe Redundanz- und Ausfallsicherheit gewährleistet wurden. Obwohl diese Lösung auf den ersten Blick mit einem zusätzlichen Netzwerk-Hops verbunden war, zeigte sich in vielen Anwendungsszenarien, dass die Performance ausreichend stabil und robust war.

Somit setzte sich netzwerkgebundener Speicher über Jahre hinweg als Standard in Cloud-Datenbanken durch. Der Durchbruch der SSD-Technologie und NVMe Der wahre Game Changer für die Speichertechnologie war jedoch der Wechsel von HDDs hin zu Solid State Drives (SSDs). Diese Flash-basierten Speichergeräte bieten eine deutlich höhere Geschwindigkeit bei Zugriffen und sind zudem robuster, da sie keine beweglichen Teile besitzen. Das Resultat ist eine geringere Latenz, höhere Durchsatzraten und eine bessere Haltbarkeit. Darüber hinaus sanken die Preise für leistungsfähige SSDs in den letzten Jahren erheblich, was sie auch für viele Cloud-Anwendungen erschwinglich macht.

Noch bemerkenswerter ist die Entwicklung der NVMe (Non-Volatile Memory Express)-Technologie. Während traditionelle SSDs häufig über SATA- oder SAS-Schnittstellen laufen, die ursprünglich für mechanische Festplatten entwickelt wurden, basiert NVMe auf dem PCIe-Bus und ist speziell für Flash-Speicher optimiert. Diese Verbindung ermöglicht parallele Datenpfade, reduziert die Latenz weiter und erlaubt eine wesentlich höhere Anzahl von IOPS (Input/Output Operations Per Second). In Zahlen übersetzt bedeutet dies, dass moderne NVMe SSDs Millionen von IOPS mit Kosten erreichen können, die um ein Vielfaches günstiger sind als netzwerkgebundene Lösungen in herkömmlichen Cloud-Datenbanken wie Amazon Aurora. Warum lokale NVMe SSDs für PostgreSQL sinnvoll sind Die Vorteile lokaler NVMe SSDs für PostgreSQL eröffnen sich beim genaueren Blick auf die Datenbankperformance und Kostenstruktur.

Die hohe Geschwindigkeit und niedrige Latenz ermöglichen eine deutlich bessere Verarbeitung von Transaktionen und Abfragen. Benchmark-Untersuchungen zeigen, dass PostgreSQL mit lokalen NVMe-SSDs im Vergleich zu netzwerkgebundenen Cloud-Diensten wie Amazon RDS oder Aurora signifikant mehr Transaktionen pro Sekunde abwickelt und dabei eine stabilere und geringere Latenz aufweist. Der Einfluss auf geschäftskritische Anwendungen, bei denen Echtzeitverarbeitung entscheidend ist, kann enorm sein. Ein weiterer nicht zu unterschätzender Punkt sind die Kosten. Während netzwerkgebundene Speicherarchitekturen mehrere tausend Euro im Monat für hohe IOPS-Zahlen verlangen können, lassen sich vergleichbare Leistungen mit einem lokalen NVMe-SSD-Speicher bereits für geringe dreistellige Eurobeträge realisieren.

Bei großen Datenbanken und umfangreichen Zugriffsanforderungen entsteht so ein erhebliches Sparpotenzial, das Unternehmen zu mehr wirtschaftlicher Effizienz verhilft. Netzwerkgebundener Speicher: Noch immer von Vorteil? Trotz dieser eindeutigen Performance- und Kostenargumente sprechen einige Gründe dafür, Netzwerk-Speicherlösungen in bestimmten Szenarien weiterhin einzusetzen. Ein wichtiger Vorteil ist die Elastizität. In dynamischen Cloud-Umgebungen, in denen sich der Speicherbedarf schnell und unvorhersehbar verändern kann, erlaubt netzwerkgebundener Speicher eine flexible und unabhängige Skalierung von Speicher und Rechenressourcen. Lokaler Speicher ist an die jeweilige Hardware des Servers gebunden, sodass Skalierungen oftmals mit komplexen Migrationen verbunden sind.

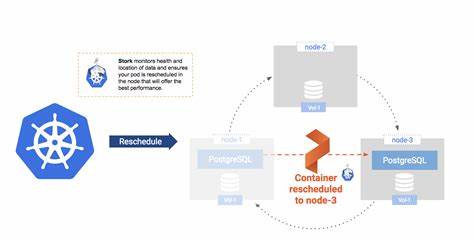

Weiterhin bietet netzwerkgebundener Speicher traditionell eine stärkere eingebaute Datenredundanz und hohe Ausfallsicherheit. Durch die automatische Replikation und verteilte Speicherung der Daten sind Ausfälle einzelner Laufwerke oder Server besser abzufangen. Zwar sind NVMe SSDs inzwischen sehr robust, dennoch braucht es bei lokalem Speicher eine durchdachte Strategie für Replikation und Backups, um Ausfallsicherheit auf Unternehmensniveau zu gewährleisten. PostgreSQL bringt hierfür eine Vielzahl von Werkzeugen mit, die exzellente Replikation und Hochverfügbarkeit garantieren, sodass lokale Systeme ebenfalls mit robusten Schutzmechanismen ausgestattet werden können. Performance-Vergleiche in der Praxis Um die theoretischen Vorteile real zu untermauern, führten unabhängige Tests und Benchmarks praxisnahe Vergleiche verschiedener Speicherarchitekturen durch.

Dabei wurden Instanzen mit lokalen NVMe SSDs, gängigen EBS-GP3-Speichern bei AWS RDS sowie optimierten I/O-Instanzen von Amazon Aurora gegenübergestellt. In einem typischen OLTP-Lasttest, der typische Transaktionen bei gleichzeitigen Nutzern simuliert, zeigte sich, dass lokale NVMe SSDs deutlich höhere Transaktionsraten erzielten und gleichzeitig die Latenz um ein Vielfaches reduzierten. Auch analytische Abfragen, welche für komplexe Datenanalysen stehen, liefen auf lokalen NVMe SSDs wesentlich schneller. Diese Daten sprechen eine klare Sprache: Für datenintensive Anwendungen, die auf PostgreSQL basieren, ist der Einsatz von lokalem NVMe-Speicher nicht nur eine technische Verbesserung, sondern auch ein wirtschaftlich sinnvoller Schritt. Zukunftsausblick: Die Postgres-Cloud braucht neue Standards Die gespeicherte Infrastruktur, mit der Cloud-Datenbanken heute betrieben werden, basiert auf Prinzipien, die vor mehr als einem Jahrzehnt entstanden.

Diese Architektur spiegelte damals die Limitationen der verwendeten Hardware wider. Heute aber hat sich die Hardware drastisch weiterentwickelt, die Kosteneffizienz hat sich verbessert und gleichzeitig sind die Anforderungen an Datenbanken komplexer geworden. All das legt nahe, dass die Zukunft der Cloud-Datenbanken im lokalen Speicher liegt. Unternehmen und Cloud-Anbieter sind daher gut beraten, die festgefahrenen Speicherarchitekturen zu hinterfragen und neue Wege zu beschreiten. Die Kombination aus lokalen NVMe SSDs, modernen Orchestrierungs- und Automatisierungstechniken sowie den fortschrittlichen Features von PostgreSQL schafft ein Ökosystem, in dem Performance, Skalierbarkeit und Zuverlässigkeit in Einklang stehen.

Abschließend zeigt sich, dass es für PostgreSQL keinen Grund mehr gibt, Speicher vom Server zu entkoppeln, wenn lokale SSDs diese Anforderungen kostengünstiger, schneller und zuverlässiger erfüllen können. Die Postgres-Community und Betreiber von Cloud-Datenbanken sollten daher lokalem Speicher den Vorzug geben und ihre Architekturen entsprechend anpassen. In Zeiten von immer größer werdenden Datenmengen, Echtzeitanalysen und verteilten Systemen entsteht dadurch ein Wettbewerbsvorteil für diejenigen, die frühzeitig auf moderne Speichertechnologien setzen.