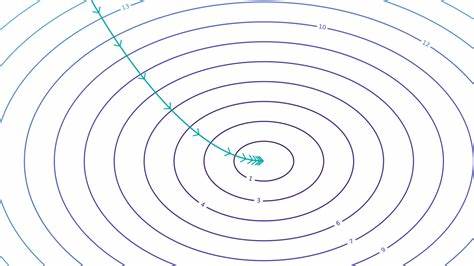

Frontier-Sprachmodelle, also die leistungsfähigsten und innovativsten KI-Sprachmodelle, durchliefen seit der Veröffentlichung des ursprünglichen Transformer-Modells im Jahr 2017 eine Phase rasanter Vergrößerung. Parameterzahlen explodierten von 117 Millionen bei GPT-1 auf gigantische 175 Milliarden bei GPT-3 binnen nur zwei Jahren. Dieser Wachstumstrend setzte sich weiter fort, sodass GPT-4 sogar beeindruckende 1,8 Billionen Parameter enthielt und damit eine zehnmal größere Architektur als sein Vorgänger war. Doch 2023 zeichnete sich eine überraschende Kehrtwende ab: Statt immer größer zu werden, sind die neuesten Frontier-Sprachmodelle plötzlich wieder viel kleiner. Dieser Umbruch ist faszinierend und herausfordernd zugleich, denn er widerspricht den bisherigen Erwartungen an die Entwicklung von KI-Systemen und wirft Fragen hinsichtlich der zugrundeliegenden Gründe und zukünftigen Perspektiven auf.

Die Erkenntnis, dass aktuelle Spitzenmodelle im Vergleich zu GPT-4 kleiner sind, lässt sich an verschiedenen Indikatoren festmachen. Zwar veröffentlichen große Unternehmen wie OpenAI oder Anthropic selten detaillierte Architekturinformationen zu ihren neuesten Produkten. Doch Branchenbeobachtungen und Benchmark-Analysen liefern Hinweise. So zeigen Open-Weights-Modelle wie Mistral Large 2 und Llama 3.3, die mit 123 bzw.

70 Milliarden Parametern auskommen, eine Leistungsfähigkeit, die frühere Generationen übertrifft – und das bei deutlich geringeren Kosten und schnellerer Verarbeitung. Ähnlich verhält es sich bei geschlossenen Modellen: GPT-4o etwa wird mit circa 200 Milliarden Parametern geschätzt, was etwa einem Achtel der Größe von GPT-4 entspricht – und doch wird es schneller ausgespielt und ist für Nutzer deutlich günstiger. Diese Entwicklung überrascht zunächst, denn in den vergangenen Jahren galten größere Modelle als der Königsweg zu immer besseren Ergebnissen. Je höher die Parameteranzahl, desto komplexer und vielseitiger die Fähigkeiten – zumindest nach klassischer Lehrmeinung. Doch eine nähere Betrachtung der realen Nutzungsanforderungen und technischer Rahmenbedingungen offenbart die tiefgreifenden Gründe für den Trend zurück zu kleineren Modellen.

Einer der wichtigsten Treiber ist der enorme Anstieg der Nachfrage nach KI-Diensten seit der Einführung von GPT-4 und dem großen öffentlichen Interesse an Chat-basierten Anwendungen. Unternehmen sahen sich mit einem sprunghaften Anstieg an Inferenzanfragen konfrontiert, die ihre Erwartungen oft weit übertrafen. Die Kosten für Rechenzeit und Datenverarbeitung, die beim Einsatz großer Sprachmodelle anfallen, sind erheblich. Deshalb wird es wirtschaftlich zunehmend attraktiver, Modelle effizienter zu gestalten – also kleiner und schneller – um den enormen Traffic zu bewältigen und gleichzeitig bezahlbar zu bleiben. Die KI-Forschung hat zudem Fortschritte in der Trainingsmethodik realisiert, die es ermöglichen, mit kleineren Modellen vergleichbare oder sogar bessere Ergebnisse zu erzielen.

Dabei spielt die sogenannte Distillation eine zentrale Rolle: Große, bereits trainierte Modelle dienen als Lehrmeister, um kleinere Modelle zu trainieren, die anschließend ähnlich gute Leistungen erbringen. Diese Technik hilft, den Ressourcenaufwand deutlich zu reduzieren, ohne die Qualität stark zu beeinträchtigen. Man kann sagen, dass kleinere Modelle heutzutage cleverer trainiert werden als früher, wodurch ihr Potenzial maximiert wird. Zudem wird die Veränderung der sogenannten Skalierungsgesetze immer wichtiger. Zuvor wurden Modelle nach den Kaplan-Skalierungsgesetzen entworfen, die ein hohes Verhältnis von Parametern zu Trainingsdaten bevorzugten.

Die neueren Chinchilla-Skalierungsgesetze empfehlen hingegen, kleinere Modelle auf deutlich umfangreicheren Datensätzen zu trainieren. Das Ergebnis sind kompaktere Modelle, die aber durch intensiveren Dateninput in der Lage sind, erstaunliche Leistungen zu erbringen. Dieses bessere Verständnis von Trainingsstrategien hat somit maßgeblich zu dem Schrumpfen der Modellgrößen beigetragen, ohne dabei Abstriche bei der Performance zu machen. Auch technische Innovationen bei der Inferenz, also der Laufzeit-Ausführung der Modelle, spielen eine Rolle. Die Anforderungen steigen zunehmend, da komplexere Interaktionen mit mehr Kontext und schnellere Antwortzeiten nötig sind.

Labs investieren verstärkt in Testzeit-Compute-Skalierung, also die Optimierung der Modelllaufzeit, um bei gleicher Rechenleistung mehr und tiefere Rückschlüsse im Dialog ziehen zu können. Dabei profitierte man davon, kleinere Modelle einsetzen zu können, die sich schneller und kostengünstiger skalieren lassen. Große Modelle können zwar mehr Muster erfassen, ihre komplexen Abläufe sind jedoch häufig langsamer und ressourcenintensiver, was bei sehr kurzen Antwortzeiten ein Nachteil werden kann. Ein immer relevanterer Faktor ist die Nutzung synthetischer Daten während des Trainings. Im Gegensatz zu traditionellen Methoden, bei denen Trainingsdaten aus dem Internet gesammelt werden, wird durch KI-generierte Inhalte die Menge an qualitativ hochwertigen Trainingsbeispielen künstlich erhöht.

Dies ermöglicht ein noch effizienteres Training kleinerer Modelle, da der Nutzen pro Trainingsstück deutlich steigt. Ähnlich wie bei AlphaGo, das seine eigenen Partien zur Verbesserung nutzte, können Sprachmodelle durch selbstgenerierte Daten besser lernen, ohne ihre Größe erhöhen zu müssen. Dies stellt eine neue Dimension des Trainings-Optimierens dar, die sich zukünftig noch stärker ausprägen dürfte. Aus all diesen Gründen argumentieren Experten, dass die Phase des grenzenlosen Wachstums bei der Parameteranzahl wahrscheinlich vorerst beendet ist. Mit sehr hoher Wahrscheinlichkeit werden kommende Generationen, wie GPT-5 oder Claude 4, zwar wieder eine moderate Zunahme an Parametern zeigen, die Entwicklung wird jedoch voraussichtlich weniger sprunghaft verlaufen als in den vergangenen Jahren.

Die Modelle werden nach einer Phase der Modellverkleinerung eher etwas größer, aber mit deutlich intelligenten und effizienten Trainings- und Inferenzmethoden ausgestattet sein. Die Hardwareentwicklung unterstützt diesen Trend ebenfalls. Moderne GPUs und spezialisierte Chips verbessern die Rechenleistung und erlauben es, komplexere Modelle kosteneffizienter auszuführen. Gleichzeitig bleiben jedoch Kosteneffizienz und geringe Latenz wichtige Ziele. Große Modelle mit 100 Billionen Parametern sind theoretisch möglich, aber wirtschaftlich derzeit kaum tragbar.

Kundenbudgets und praktische Einsatzfälle limitieren die Nachfrage nach extrem großen Modellen. Es ist wahrscheinlicher, dass Modelle mit einer Größe zwischen einer und zehn Billionen Parametern, die dank effizienter Inferenz besonders leistungsfähig sind, den Markt dominieren werden. Zusammenfassend haben Frontier-Sprachmodelle eine bedeutende Wende erlebt: Statt unendlich zu wachsen, setzen Entwickler wieder verstärkt auf kleinere, effizientere Modelle, die dank verbesserter Trainingsmethoden, distillierter Wissensvermittlung und innovativer Nutzung synthetischer Daten erstklassige Leistungen liefern. Die neue Modellgeneration wird dadurch nicht nur ökonomisch sinnvoller, sondern auch schneller und besser skalierbar für die massenhafte Nutzung. Dies markiert einen wichtigen Meilenstein in der KI-Geschichte und hilft, die Technologie für die breite Öffentlichkeit zugänglicher und nachhaltiger zu gestalten.

Die kommenden Jahre werden spannend, da diese Entwicklung die Weichen für die nächste Innovationsphase in der KI-Forschung stellt.

![Basic and Necessary Tooling for Creating FPGA Retro Hardware Game Cores [video]](/images/46287C1B-D670-4FD3-B070-07118AF995E9)