Common Lisp ist eine der ältesten und vielseitigsten Programmiersprachen, die gleichzeitig eine hohe Ausdruckskraft und Flexibilität bietet. Viele Entwickler schätzen Lisp für seine makrobasierten Erweiterungsmöglichkeiten und dynamische Natur. Dennoch wird oft angenommen, dass Lisp-Code im Vergleich zu anderen Sprachen wie C++ oder Rust bei der Ausführungsgeschwindigkeit und beim effizienten Umgang mit Ressourcen hinterherhinkt. Diese Annahme ist jedoch nicht unbedingt korrekt, insbesondere wenn moderne Lisp-Implementierungen wie SBCL genutzt und gezielte Optimierungstechniken angewandt werden. Es gibt eine Reihe von Best Practices und Werkzeugen, mit denen sich Common Lisp Programme signifikant beschleunigen und den Speicherverbrauch deutlich senken lassen.

Dieser umfassende Leitfaden gibt einen Einblick in die wichtigsten Strategien, um Leistungseinbußen zu vermeiden und den maximalen Nutzen aus Common Lisp herauszuholen. Die Grundlage jeglicher Optimierung ist eine genaue Analyse dessen, wo die meiste Zeit und welcher Speicher am intensivsten genutzt werden. Moderne Lisp-Implementierungen enthalten dafür eingebaute Profiler. Ein markantes Beispiel ist sb-sprof, ein statistischer Profiler, der es ermöglicht, den Aufrufstapel in regelmäßigen Abständen auszulesen und so Hotspots in der Laufzeit und Speicherbelegung aufzudecken. Diese Methode bietet viel mehr Erkenntnisse als einfache Zeitmessungen und erlaubt es, gezielt die ineffizientesten Stellen zu identifizieren.

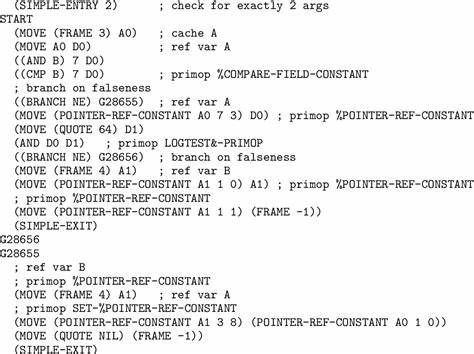

Die Anwendung von sb-sprof gestaltet sich erfreulich simpel. Durch Einbinden des Moduls und Umhüllen der entsprechenden Funktionsaufrufe mit „with-profiling“ erhält man detaillierte Reports über CPU-Auslastung und Speicherzuweisungen. Besonders nützlich ist hierbei die Auswahl des Modus, da neben der Standard-CPU-Auslastung auch der Speicherverbrauch mittels Allocation-Profiling analysiert werden kann. Durch visuelle Darstellungen als Graphen wird zudem ersichtlich, wie einzelne Funktionen aufgerufen werden und welche Unterfunktionen sie triggern. Diese Form der Analyse offenbart oft überraschende Erkenntnisse.

So kann es durchaus vorkommen, dass vermeintlich komplexe Funktionen nur einen kleinen Teil der Laufzeit ausmachen, während andere, auf den ersten Blick triviale Routinen dominante Ressourcenfresser sind. So zeigte ein reelles Beispiel, dass eine Parser-Funktion namens „consume“ überdurchschnittlich häufig aufgerufen wurde und dort der Großteil der Zeit verbraucht wurde, während andere als rechenintensiv angenommene Teile wesentlich weniger relevant waren. Die Konsequenz ist klar: Zunächst lohnen sich Optimierungen vor allem bei den tatsächlichen Hotspots. Ein häufig begangener Fehler ist das Optimieren von Bereichen, die zwar komplex wirken, aber kaum zur Gesamtlaufzeit beitragen. Diese Fokussierung ermöglicht einen effizienteren Einsatz der Optimierungsressourcen.

Neben der Profilerstellung und der Fokussierung auf Hotspots lässt sich mit grundlegenden Programmierpraktiken und speziellen Eigenarten von Common Lisp der Code weiter beschleunigen und optimieren. Dabei steht das Vermeiden unnötiger Arbeit und damit redundanter Berechnungen an erster Stelle. Die beste Optimierung ist bekanntlich die Entfernung von Überflüssigem. Wenn eine Aufgabe komplett entfallen oder durch präzisere Algorithmen ersetzt werden kann, sitzt der Programmablauf am schnellsten. Ein Klassisches Problem bei der Verarbeitung von Text, insbesondere bei Parsen, ist die übermäßige Allokation von Datenstrukturen wie Listen.

Für Tokens, die in Strings enden, werden manchmal große Listen von Einzelelementen temporär angelegt und später wiederum zu Strings zusammengesetzt. Dieses doppelte Erzeugen von Listen und Strings verursacht erheblichen Overhead bei Zeit und Speicher. Eine Lösung bietet hier das sogenannte „displaced arrays“ Konzept, bei dem man statt der Kopie eines Strings einen Pointer auf einen Ausschnitt (Slice) verwendet. Dies entlastet Speicher und erhöht die Geschwindigkeit, weil teure Kopiervorgänge entfallen. Noch besser ist es, wenn man identifiziert, dass man die Zwischenschritte gar nicht benötigt und stattdessen direkt mit Indizes oder Offsets innerhalb des Originalstrings arbeitet.

So werden Speicherallokationen weiter drastisch reduziert, da weniger temporärer Speicher erzeugt wird. Diese Art der Analyse und gezielten Veränderung macht sich am Ende durch eine um ein Vielfaches niedrigere Speicherbelegung und schnellere Laufzeit bemerkbar. Ein weiterer wesentlicher Punkt liegt in der Verwendung von speziellen Datentypen, die von Lisp in der Kompilierung erkannt werden und die Speicherzugriffe optimieren. So sind für Strings einfache Arrays von Zeichen („simple-string“) meist deutlich schneller zu handhaben als allgemeine Array-Typen. Der Zugriff auf Elemente kann durch Funktionen wie „schar“ deutlich effizienter erfolgen, weil sie intern geringere Sicherheitsprüfungen benötigen und direkt Indizes auf den zugrunde liegenden Speicher adressieren.

Dies ist vor allem dann relevant, wenn solche Zugriffe sehr häufig in Schleifen stattfinden. Neben der Verwendung der passenden Datenstruktur sollte auch eine präzise Typdeklaration nicht unterschätzt werden. In statischeren Sprachen ist dies selbstverständlich, in Common Lisp wird trotzdem oft auf dynamische Typen gesetzt, was zu generischen und damit langsameren Operationen führt. Typdeklarationen für Funktionen und Variablen – besonders bei numerischen Werten wie Fixnum – helfen dem Compiler, interne Verwaltungsaufwände zu vermeiden und schneller zu arbeiten. Selbst kleine Änderungen wie die Deklaration eines Loop-Indices als Fixnum können deutliche Verbesserungen bewirken.

Auch im Bereich der Schleifen zeigt sich dies eindrucksvoll. Schleifenvariablen, die nicht mit Typinformationen versorgt sind, führen häufig zu umfangreichen internen Typprüfungen und generischen Operationen wie „generic +“, was viel Rechenzeit verbrät. Eine einfache Typdeklaration reduziert diese Last und ermöglicht die Nutzung schneller, nativer CPU-Instruktionen. Ein oft übersehener Aspekt bei Common Lisp und teilweise ein Grund für erhöhte Speicherbelastung ist die Verwendung von Konstruktionen, die implizit Heap-Speicher allokieren, beispielsweise die konsbasierte Rückgabe von mehrfachen Werten als Paare (cons cells). In anderen Sprachen werden Mehrfachrückgaben häufig durch Register oder per Wert abgewickelt, ohne dass ein Speicherblock neu alloziert werden muss.

Daher ist es in Common Lisp ratsam, wo immer möglich das native Werte- und Multiple-Value-System zu verwenden, um ohne Heap-Allokationen mehrere Ergebnisse auszutauschen. Die gleichzeitige Nutzung von „multiple-value-bind“ unterstützt diese effiziente Arbeitsweise und spart signifikant Speicher und Rechenzeit. Ebenso maßgeblich ist der bewusste Umgang mit Speicherallokationen für temporäre Datenstrukturen. Common Lisp erlaubt es, mittels sogenannter „dynamic-extent“ Deklarationen lokale Variablen und Arrays auf dem Stack zu verwalten statt im Heap. Dies hat zur Folge, dass die Speicherfreigabe unmittelbar nach Verlassen des Blocks erfolgt, wodurch der Garbage Collector weniger belastet wird und sich insgesamt die Speicherverwaltung beschleunigt.

Branchenspezifische Benchmarks zeigten, dass das Hinzufügen von „dynamic-extent“ bei einem zentralen Parser-Array den Speicherbedarf um beeindruckende 30 Prozent reduzierte. Ein weiterer, wenn auch subtilerer Punkt sind so genannte „Lambda Caches“. Viele Parser, gerade bei Parsercombinatorik wie bei JSON-Parsing, sind höherwertige Funktionen, die Funktionen zurückgeben. Im SBCL-Compiler führt dies häufig zur Neuzuweisung von anonymen Funktionen (Lambdas) bei jedem Aufruf. Dies kostet nicht nur Zeit durch Speicherallokation, sondern erhöht auch die Last auf den Garbage Collector.

Um dem entgegenzuwirken, bietet es sich an, diese Lambdas zwischenspeichern. Statt bei jedem Charakter den entsprechenden Parser neu anzulegen, wird eine Hashtabelle benutzt, um bereits erzeugte Lambdas wiederzuverwenden. Diese Caching-Technik schafft einen guten Kompromiss aus Speicherverbrauch und Ausführungsgeschwindigkeit. Große Sorge bereitet manchen Programmierern die Frage, ob die Verwendung von Fixnums – einer festen, maschinennahen Ganzzahlform – auf verschiedenen Implementierungen portabel sei. Tatsächlich zeigen sich teilweise Unterschiede in der maximalen Größe von Fixnums zwischen SBCL, ECL, ABCL und weiteren Lisp-Dialekten.

Die Grenzen liegen jedoch derart hoch, dass sie im praktischen Alltag fast keine Rolle spielen, insbesondere wenn man sich auf in-Memory-Verarbeitung moderater Dateigrößen beschränkt. Für sehr große Datensätze sind ohnehin andere Strategien nötig, und der Gebrauch von Fixnums gewinnt so immer mehr an Akzeptanz. Ein weiterer Diskussionspunkt ist die Einstellung von Sicherheitsleveln im Compiler. Tiefergehende Profiling- und Benchmarktests demonstrieren, dass das Umschalten von Sicherheitsstufe 0 auf 1 durchaus je nach Implementierung Performanceeinbußen verursachen kann. Während SBCL hier kaum Unterschiede zeigt, kann es bei anderen wie ECL spürbar langsamer werden.

Entscheidend ist, diese Einstellungen nur an Stellen mit kontrolliertem, sicherem Code zu verhängen und nicht global. So kombiniert man Sicherheit mit Geschwindigkeit an den geeigneten Stellen und stabilisiert den Entwicklungsprozess. Zusammengefasst ist die Optimierung von Common Lisp Code ein facettenreiches Unterfangen, das sowohl die Analyse von Laufzeit und Speicher als auch das bewusste Programmieren mit typischen und speziellen Mainstreamfunktionen umfasst. Die besten Resultate werden erzielt, wenn man zunächst Hotspots mit Tools wie sb-sprof identifiziert, redundante Arbeit vermeidet und dann gezielt die Parameter wie Datentypen und Speicherallokation optimiert. Die Kombination aus interaktivem Profiling, zielgerichtetem Type-Hinting, Speichermanagement im Stack und der Nutzung von Multiple-Value-Bindings führt zu signifikanten Verbesserungen in Laufzeit und Heap-Nutzung.

Dies zeigt eindrucksvoll, dass Common Lisp nicht nur eine elegante Sprache für Ausdruckskraft und Flexibilität ist, sondern mit den richtigen Kniffen auch sehr leistungsfähigen und effizienten Code liefern kann. Für Entwickler, die Lisp privat oder beruflich nutzen, lohnt sich der Aufwand großes Interesse und Beschäftigung mit diesen Techniken. Die Praxis bietet genug Anlass, um Parsersysteme, anspruchsvolle Anwendungen und umfangreiche Datenmanipulationen mit hoher Geschwindigkeit sowie reduziertem Speicherverbrauch umzusetzen und somit die volle Leistungsfähigkeit von Common Lisp im Jahr 2025 auszuschöpfen.