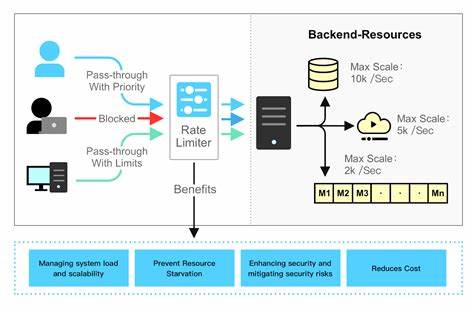

In der heutigen digitalen Welt, in der Anwendungen und Dienste in Echtzeit auf eine Vielzahl von Nutzern und Anforderungen reagieren müssen, wird die Kontrolle des Zugriffs auf Ressourcen immer wichtiger. Rate Limiting ist hierbei eine unverzichtbare Technik, um sicherzustellen, dass Systeme nicht durch eine Überlastung abstürzen oder beeinträchtigt werden. Insbesondere bei APIs, Webservices und Backend-Systemen, die mit hohen Datenraten und vielen parallelen Anfragen umgehen, ermöglicht ein effektives Rate Limiting die Wahrung von Stabilität und Performance. Die Go-Programmiersprache (Golang) hat sich als eine der beliebtesten Optionen für die Entwicklung von Backend-Systemen etabliert. Durch ihre Effizienz, einfache Parallelität und robuste Performance bietet sie ideale Voraussetzungen für anspruchsvolle Anwendungen.

Ein neues Open-Source-Projekt stellt eine hochperformante Rate Limiting Bibliothek vor, die speziell auf den Einsatz in Go-Anwendungen zugeschnitten ist und gleich mehrere Vorteile gegenüber herkömmlichen Lösungen bietet. Eine Schlüsselstärke dieser Bibliothek liegt in der extrem schnellen Ausführung der Kernoperationen. Tokenverbrauch oder -prüfung sowie die Verarbeitung von zeitabhängigen Daten geschehen in wenigen Nanosekunden, ohne dabei zusätzlichen Speicher zu allozieren. Damit kann sie Millionen von Operationen pro Sekunde bewältigen. Dies ist für Systeme, die unter hoher Last stehen, von unschätzbarem Wert, da die Rate Limiter selbst nicht zum Flaschenhals werden.

Die Parallelität wird durch ein durchdachtes Konzept, bei dem eine große Anzahl sogenannter Token Buckets zum Einsatz kommt, weiter optimiert. Diese Buckets verteilen die Last auf verschiedene kleine Einheiten, wodurch Engpässe und Konflikte beim gleichzeitigen Zugriff von vielen Threads vermieden werden. Die intelligente Verwendung von atomaren Operationen stellt sicher, dass diese Zugriffe lockfrei und dennoch konsistent ablaufen. Ein weiteres herausragendes Merkmal ist die Vielzahl an unterstützten Rate Limiting Algorithmen. Neben dem klassischen Token Bucket Algorithmus, der seit Jahren bewährt ist, kommt ein innovativer Additive-Increase/Multiplicative-Decrease (AIMD) Token Bucket zum Tragen, der Inspiration aus der TCP Netzwerksteuerung zieht.

Dieses adaptive Verfahren passt die erlaubte Anfragerate dynamisch an, indem es bei erfolgreicher Verarbeitung die Rate langsam erhöht und bei Fehlern oder Überlast schnell absenkt. Dadurch wird ein Gleichgewicht gefunden, das sowohl Auslastung maximiert als auch Schutz bietet. Die Implementierung ist besonders speichereffizient. Durch kompakte Datenstrukturen, eine ausgeklügelte interne Speicherung und maßgeschneiderte Zeitstempel mit 56 Bits wird der Speicherbedarf minimiert, ohne die Geschwindigkeit zu beeinträchtigen. Das Fehlen externer Abhängigkeiten macht die Bibliothek unkompliziert in bestehende Projekte integrierbar und senkt Sicherheitsrisiken.

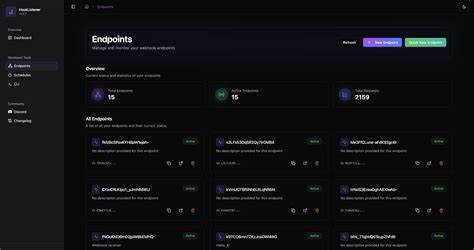

Für Entwickler gestaltet sich die Anwendung denkbar einfach. Die Initialisierung eines Token Bucket Limiters erfolgt mit wenigen Parametern wie Anzahl Buckets, maximaler Burstkapazität und Refllrate. Die Auswahl der Bucket-Anzahl wird dabei automatisch auf eine Zweierpotenz gerundet, um eine optimale Hash-Verteilung zu garantieren. Die Verbrauchs- und Abfrage-Methoden ermöglichen eine direkte und schnelle Abfrage, ob dem jeweiligen Nutzer oder der ID ein Token zur Verfügung steht. Ebenso elegant ist der AIMD Token Bucket Limiter zugänglich.

Hier können Parameter für minimalen, maximalen und initialen Tokenstand sowie die Geschwindigkeit des Anpassungsverhaltens festgelegt werden. Die Bibliothek übernimmt zudem umfangreiche Validierungen, um Fehlkonfigurationen vorzubeugen und dem Entwickler aussagekräftige Fehlermeldungen zu liefern. Eines der häufigsten Probleme bei skalierenden Rate Limitern sind Kollisionen. Dadurch, dass verschiedene IDs mittels Hashfunktion auf den gleichen Bucket verteilt werden, können sich Anfragen gegenseitig beeinträchtigen. Die hier vorgestellte Lösung analysiert dieses Szenario ausführlich und gibt bewährte Empfehlungen, wie die Anzahl der Buckets im Verhältnis zur Nutzerzahl gewählt werden sollte, um die Auswirkungen zu minimieren.

Dabei wird ein Kompromiss zwischen Speicherverbrauch und Fairness hergestellt. Selbst bei einer großen Anzahl an Nutzern bleibt der Überschneidungsgrad gering, wenn die Bucket-Anzahl entsprechend hoch ist, was jedoch mehr Speicher benötigt. Bei sehr großen Systemen bieten sich zusätzliche Techniken an, wie das Aufteilen der Rate Limiter nach logischen Partitionen oder die Verwendung verschiedener Hash-Algorithmen. Auch diese Möglichkeiten werden dokumentiert und aufgezeigt. Die Geschwindigkeit und Skalierbarkeit zeigen sich eindrucksvoll in mitgelieferten Benchmarks.

So können mehrere hundert Millionen Tokenpool-Operationen pro Sekunde auf typischer Hardware ausgeführt werden – und das mit nahezu keinem Speicheraufwand oder gar Heap-Allokationen. Selbst bei stark paralleler Nutzung bleibt die Verzögerung minimal. Für Entwickler, die hohe Anforderungen an Performance und Verfügbarkeit stellen, ist das Risikominimierung durch einen Lingering-Limiter ein enormer Vorteil. Wie bei jedem komplexen System gibt es auch Grenzen: Die Bibliothek kann keine perfekte absolute Fairness garantieren, da Kollisionen trotz guter Verteilung unvermeidbar sind. Außerdem braucht eine einzelne stark beanspruchte ID bei hoher Konkurrenz höhere Retry-Zeiten aufgrund atomarer Operationen.

Diese Punkte sind jedoch durch Architekturentscheidungen und Scale-out-Ansätze in den meisten Fällen beherrschbar. Der insgesamt modular aufgebaute Code ist gut verständlich und offen für Weiterentwicklungen. Die offenen Quelltexte stehen auf GitHub bereit, inklusive umfassender Dokumentation, Beispielanwendungen und automatischer Tests. Das aktive Management des Repositories und regelmäßige Updates vermitteln ein hohes Maß an Zuverlässigkeit und lebendige Community-Unterstützung. Zusammenfassend stellt diese Rate Limiting Bibliothek für Go einen erheblichen Zugewinn in Sachen Effizienz und Flexibilität dar.