Die rapide Entwicklung Generativer Künstlicher Intelligenz (GenAI) hat in den letzten Jahren eine regelrechte Euphorie ausgelöst. Viele Stimmen aus Wissenschaft, Bildung und Technologie feiern diese Systeme als den nächsten großen Schritt in der Wissensvermittlung und Zusammenarbeit. Besonders im Hochschulbereich kursiert die Vorstellung, GenAI könne als persönlicher Tutor oder sogar als kollaborativer Lernpartner fungieren. Doch dieser Optimismus übersieht fundamentale Probleme, die den Einsatz von GenAI in pädagogischen Kontexten stark einschränken – wenn nicht gar gefährlich machen. Ein entscheidender Kritikpunkt an GenAI-Systemen ist deren inhärente epistemische Verantwortungslosigkeit.

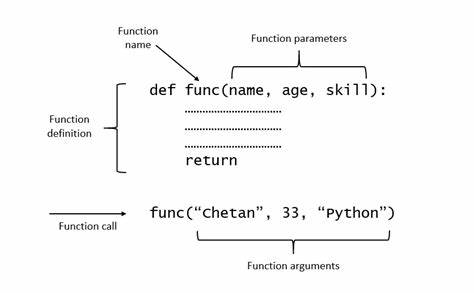

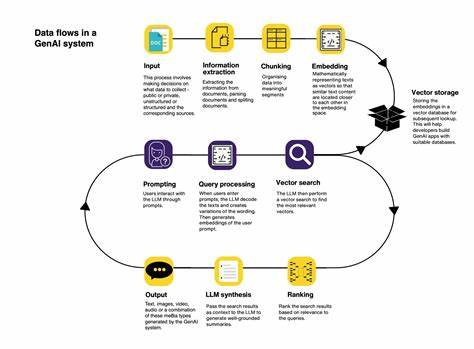

Anders ausgedrückt: Diese KI-Modelle haben keine echte Einsicht in die Wahrheit ihrer Ausgaben. Sie generieren Inhalte, indem sie aus umfangreichen Datenmengen Muster erkennen und probabilistisch Wörter aneinanderreihen, ohne ein tatsächliches Verständnis oder ein Bewusstsein über die Richtigkeit der Informationen. Harry Frankfurt, ein bekannter Philosoph, analysierte den Begriff des ‚Bullshits‘ genau in diesem Zusammenhang und beschrieb ihn als Aussagen, denen die Wahrheit egal ist – nicht zwingend Lügen, aber doch fundamental unverantwortlich im Hinblick auf Glaubwürdigkeit und Verlässlichkeit. Dieses Konzept trifft den Nagel auf den Kopf, wenn man die Ausgaben von GenAI betrachtet. Die Folge ist, dass GenAI-Ausgaben nicht verlässlich sind und oft sogenannte „Halluzinationen“ produzieren können – das heißt, sie generieren falsche oder irreführende Inhalte, die auf den ersten Blick plausibel wirken.

Für Lernende ist das besonders problematisch, da sie oft nicht in der Lage sind, die Richtigkeit der von der KI gelieferten Informationen zu beurteilen. Die Verantwortung wird folglich auf sie abgewälzt, was pädagogisch gesehen hochgradig problematisch ist. Studenten sollen als Nutzer von GenAI quasi selbst die Rolle eines kritischen Prüfers und Verfechters der Wahrheit übernehmen, obwohl sie weder über die notwendigen Mittel noch Erfahrungen verfügen, um die Datenvalidität sicherzustellen. Diese Forderung ist zudem kontraproduktiv für die Entwicklung essenzieller Kompetenzen im Hochschulbereich. Kritisches Denken, die Fähigkeit, Quellen zu bewerten und differenziert Wissen zu erwerben, basieren maßgeblich auf der Interaktion mit kompetenten menschlichen Lehrenden.

Werden diese durch KI-Systeme ersetzt oder ersetzt, fehlen die Impulse und Rückmeldungen, die durch den menschlichen Austausch entstehen. Die Entwicklung der Motivation und der kritischen Haltung gegenüber infrage gestellten Inhalten wird dadurch erschwert, was langfristig die Qualität der Ausbildung und den intellektuellen Fortschritt lähmt. Philosophisch lässt sich dieser Umstand mit Platons Skepsis gegenüber dem Schreiben vergleichen. Bereits vor knapp 2500 Jahren war Plato besorgt, dass schriftliche Überlieferungen das kritische Denken schwächen, da sie die Höflinge abhalten, Wissen selbst zu hinterfragen und aktiv zu erinnern. Genau das gleiche Phänomen erleben wir mit modernen GenAI-Systemen, nur in einer noch komplexeren und mechanisierten Form.

Die „authentischen“ Autoren sind unbekannt und nicht ansprechbar. Ohne die Möglichkeit, Aussagen zu hinterfragen oder deren Ursprung zu beleuchten, wächst das Risiko, unreflektiert auf falsche Informationen hereinzufallen. Einige optimistische Stimmen greifen auf Dekonstruktionstheorien zurück und sehen in der „Auflösung“ dieser traditionellen Autorenrollen eine neue Bildungs- und Erkenntnissituation, die kreative Möglichkeiten eröffnen soll. Dennoch bleibt der pädagogische Pragmatismus wichtig: Bildung lebt von dialogischem Austausch und Verantwortlichkeit. KI-Systeme können diese Grundpfeiler nicht ersetzen, da ihnen die intentionale Haltung fehlt, also der innere Antrieb, sich um Wahrheit oder Wissensqualität zu kümmern.

Sie erzeugen vielmehr das, was Philosophen als „Scheinwahrheit“ oder oberflächliche Plausibilität bezeichnen würden. Da GenAI-Systeme nicht als verantwortliche Agenten gelten können, sind die daraus resultierenden „Erkenntnisse“ oder „Lernerfahrungen“ keine echten Wissensansprüche. Der entstandene sogenannte „Zeugnis-Gap“ tritt ein, wenn Lernende oder Lehrende sich auf Informationen stützen müssen, die weder zuverlässig noch nachvollziehbar sind. Dadurch entsteht eine Bildungslücke, in der Vertrauen, Transparenz und epistemische Sicherheit fehlen – fundamentale Eigenschaften, die qualitätsvolle Lehre und Forschung ausmachen. Auf einer praktischen Ebene müssen Hochschulen und Bildungsverantwortliche daher sehr vorsichtig mit dem propagierten Einsatz von GenAI umgehen.

Die technologischen Systeme können unterstützend sein, zum Beispiel als Werkzeug zum schnellen Auffinden von Literaturverweisen, zur Textanalyse oder als kreative Ideenquelle. Sie dürfen jedoch niemals als Ersatz für menschliche Expertise, kritische Reflexion und dialogische Betreuung betrachtet werden. Die Gefahr besteht, dass durch den übermäßigen Verlass auf GenAI eine Kultur des „Einfach-hinzunehmen“ entsteht, die tiefgreifende Lernprozesse unterminiert und Pädagogik zu einer bloßen Aneinanderreihung oberflächlicher Wissensfragmente verkommen lässt. Es bedarf zudem der kritischen Medienkompetenz, die Studierenden vermittelt werden muss, um den Umgang mit solch mächtigen Werkzeugen zu erlernen. Dazu gehört nicht nur das Erkennen von möglichen Fehlern der KI, sondern auch das Verständnis der technologischen Mechanismen, die hinter GenAI stehen.

Nur so lässt sich der normative Anspruch etablieren, KI-Ausgaben nicht blind zu übernehmen, sondern stets durch menschliche Urteilskraft zu prüfen und in größere wissenschaftliche Kontexte einzuordnen. Schließlich werfen diese Überlegungen auch wichtige ethische Fragen auf. Die Vermarktung von GenAI als Tutor oder Kollaborateur ist mitunter täuschend und kann falsche Erwartungen wecken. Solche Systeme suggerieren eine Partnerschaft auf Augenhöhe, die in Wirklichkeit eine Einbahnstraße ihrer programmierten Funktionalitäten bleibt. Nutzern wird so eine Rolle zugeschoben, für die sie weder voll ausgebildet noch rechtlich abgesichert sind.

Die Verantwortung für Fehler oder Missverständnisse liegt de facto bei den Lernenden selbst, was ethisch fragwürdig ist. Zusammenfassend lässt sich sagen, dass Generative KI zweifellos beeindruckende technische Errungenschaften darstellt und vielfach das Potenzial hat, Bildung zu unterstützen. Dennoch sind die Grenzen dieser Technologie in Hinblick auf die Vermittlung von Wissen und Zusammenarbeit klar definiert. GenAI-Systeme sind weder authentische Lernpartner noch verlässliche Tutoren. Sie produzieren Inhalte ohne epistemische Verantwortung, fördern keine kritische Reflexion und bergen zahlreiche Risiken für die Qualität und Integrität von Bildungsprozessen.

Es liegt an der akademischen Gemeinschaft, diese Herausforderungen offen zu diskutieren, den Einsatz von KI sachlich zu bewerten und Bildungsansätze zu entwickeln, die Technologie sinnvoll integrieren, ohne die menschliche Kompetenz und pädagogische Verantwortung zu vernachlässigen.

![Elton John: I would take government to court over AI plans [video]](/images/4BAD25F0-ACBB-40E3-9C72-A9B4D2361652)