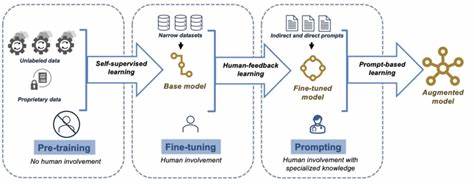

Die rasanten Fortschritte im Bereich der künstlichen Intelligenz erfordern immer leistungsfähigere und vielseitigere Schnittstellen, um die stetig wachsenden Anforderungen von Entwicklergemeinschaften und Unternehmen abzudecken. OpenAI hat mit der Responses API ein zentrales Werkzeug bereitgestellt, das die Entwicklung agentenbasierter Anwendungen durch eine direkte Einbindung vielfältiger Tools und Funktionen deutlich erleichtert. Im Mai 2025 wurden der Responses API neue, integrierte Werkzeuge und Features hinzugefügt, die bedeutende Verbesserungen für Entwickler bieten und gleichzeitig die Leistungsfähigkeit der eingesetzten Modelle erheblich steigern. Diese neuen Funktionen setzen Maßstäbe für die Zukunft intelligenter Anwendungen und verstärken die Rolle der Responses API als unverzichtbares Tool in der KI-gestützten Softwareentwicklung. Eine der wichtigsten Neuerungen ist die Unterstützung für Remote Model Context Protocol (MCP) Server.

MCP ist ein offener Standard, der definiert, wie Anwendungen Kontextinformationen zu Sprachmodellen verbinden. Die Integration von Remote MCP-Servern in die Responses API ermöglicht es Entwicklern, bestehende Tools und Datenquellen über einfache Schnittstellen einzubinden und so ihre KI-Modelle mit relevanten, aktuellen Informationen zu versorgen. Dabei kann eine Vielzahl populärer MCP-Server, etwa von Shopify, Twilio oder Stripe, nahtlos in die Anwendungen eingebunden werden, was die Entwicklungszeiten erheblich verkürzt und die Funktionalität der erstellten Agenten deutlich erweitert. Dadurch steigt die Effizienz der Arbeitsschritte, da Modelle nun gezielt auf externe Dienste zugreifen, sie auswerten und in ihre Antwortlogik einarbeiten können, was zu kontextuell reicheren und relevanteren Ergebnissen führt. Darüber hinaus hat OpenAI neue Werkzeuge in der Responses API integriert, die über die bereits bestehenden Web- und Dateisuche hinausgehen.

Die Einbindung der Bildgenerierung über das neue Modell gpt-image-1 erlaubt es, Bilder direkt während der Interaktion mit der API in Echtzeit zu erzeugen und sogar mehrstufige Bearbeitungen durchzuführen. Diese Funktion eröffnet unzählige Möglichkeiten, vor allem für Anwendungen im Bereich Marketing, Design und Bildung, die visuelle Inhalte benötigen und dabei dynamisch auf Nutzeranfragen reagieren wollen. Gleichzeitig wurde der Code Interpreter als Werkzeug ergänzt, ein mächtiges Tool, das es erlaubt, komplexe Datenanalysen, mathematische Berechnungen und sogar die Verarbeitung von Bildern innerhalb der API durchzuführen. Die Fähigkeit, den Code Interpreter nahtlos in den Denkprozess der Modelle einzubinden, führt zu einer deutlichen Verbesserung der Leistungsfähigkeit, insbesondere bei Aufgaben, die präzises Rechnen oder komplexes logisches Schlussfolgern erfordern. Entwickler profitieren so von einer größeren Flexibilität bei der Problemlösung und einer effizienteren Nutzung der verfügbaren Rechenressourcen.

Die Weiterentwicklung der Dateisuche stellt ebenfalls einen bedeutenden Fortschritt dar: Mit der neuen Version können mehrere Vektor-Datenbanken durchsucht und Attribute mit Arrays gefiltert werden, was die Präzision und den Informationsgehalt der Suchergebnisse verstärkt. Gerade in Enterprise-Umgebungen, in denen große Datenmengen strukturiert analysiert werden müssen, bietet dieses Update wertvolle Vorteile hinsichtlich Performance und Genauigkeit. Ein weiteres Highlight der neuen Response API Features ist der sogenannte Hintergrundmodus, der für die Ausführung langlaufiger Aufgaben entwickelt wurde. Intelligente Modelle benötigen manchmal mehrere Minuten, um komplexe Probleme zu bearbeiten, was bei synchronen Systemen zu Zeitüberschreitungen oder Verbindungsabbrüchen führen kann. Im Hintergrundmodus können diese aufwändigen Prozesse asynchron ausgeführt werden, die Entwickler haben mit ihrer Anwendung dann die Möglichkeit, den Fortschritt zu überprüfen oder bei Bedarf Ereignisse zu streamen, um stets auf dem aktuellen Stand zu bleiben.

Diese Funktion verbessert nicht nur die Zuverlässigkeit der Anwendungen, sondern schafft auch Raum für neue Produkte im Bereich Deep Research, automatisierte Analyseplattformen oder intelligente Agenten, die kontinuierlich arbeiten. Neben diesen technischen Erneuerungen bietet die Responses API jetzt auch die Möglichkeit, natürliche Sprach-Zusammenfassungen der internen Denkprozesse der KI-Modelle zu generieren. Diese sogenannten Reasoning Summaries erleichtern Entwicklern das Debugging, die Überprüfung und das Auditieren von KI-Operationen erheblich. Da diese Zusammenfassungen kostenfrei zur Verfügung stehen, können Entwicklungszyklen beschleunigt und die Qualität der daraus resultierenden Lösungen verbessert werden, ohne das Budget zu belasten. Datenschutz und Datensicherheit erhalten ebenfalls besondere Beachtung: Mit der Einführung verschlüsselter Reasoning Items ermöglicht OpenAI Kunden mit Zero Data Retention (ZDR)-Status, Inhalte zwischen API-Aufrufen wiederzuverwenden, ohne dass diese Daten auf den Servern gespeichert werden.

Dieses Feature bietet nicht nur mehr Sicherheit, sondern trägt auch zur Optimierung der Systemintelligenz bei, da gespeicherte Kontextinformationen zwischen den Aufrufen genutzt werden können, was Tokenverbrauch senkt und das Antwortverhalten der Modelle verbessert. Gesamt betrachtet tragen die Neuerungen in der Responses API dazu bei, dass Entwickler leistungsfähigere, flexiblere und kosteneffizientere Anwendungen erstellen können, die auf den hochmodernen GPT-4o und GPT-4.1 Modellen sowie den OpenAI o-Serie Reasoning Models basieren. Die Integration zusätzlicher Tools wie Bildgenerierung und Code Interpreter erschließt neue Anwendungsfelder und steigert die Vielseitigkeit der API im Bereich der Künstlichen Intelligenz spürbar. Die verbesserte Unterstützung von Remote MCP-Servern ermöglicht es, bereits bestehende Ökosysteme und Datenquellen intelligent einzubinden, wobei OpenAI als Mitglied des MCP Steering Committee aktiv die Weiterentwicklung dieses offenen Protokolls vorantreibt.

Unternehmen und Entwickler profitieren von einer erhöhten Zuverlässigkeit dank Hintergrundmodus, umfassender Kontrolle durch Reasoning Summaries und einem gesteigerten Datenschutz durch verschlüsselte Reasoning Items. Sämtliche Neuerungen stehen bereits jetzt zur Verfügung und sind für Entwickler mit einer Vielzahl von Preismodellen attraktiv, wobei durch Cache-Mechanismen und optimierten Tokenverbrauch viele Kosten minimiert werden können. Die konstant wachsende Entwicklergemeinschaft hat bereits zahllose Anwendungen realisiert, die von marktintelligenten Agenten über Bildungsassistenzsysteme bis hin zu spezialisierten Coding-Agenten reichen. Mit den neuen Funktionen der Responses API dürfte die Entwicklung noch fortschrittlicherer, kontextsensitiver sowie selbstständiger Agenten künftig leichter und wirtschaftlicher vonstattengehen. Insgesamt setzt OpenAI mit der Erweiterung der Responses API einen neuen Standard für die Integration komplexer KI-Technologien in Echtzeitapplikationen.

![Local poser hat: a programmable e-ink hat [video]](/images/B97D2354-6A44-4F52-8169-299DD0F98F73)