Hybrid Transactional/Analytical Processing, kurz HTAP, steht seit mehr als einem Jahrzehnt im Zentrum ambitionierter Datenbankentwicklungen. Die Idee ist ebenso einfach wie verlockend: eine einzige Datenbankarchitektur, die gleichzeitig schnelle transaktionale Vorgänge (OLTP) und umfangreiche analytische Abfragen (OLAP) effizient verarbeitet. Während Unternehmen bis heute häufig getrennte Systeme für operative Anwendungen und Datenanalysen nutzen, verspricht HTAP die nahtlose Vereinigung beider Welten mit einer einzigen Datenquelle und ohne komplizierte Datenreplikationen oder zeitverzögerte Batch-Prozesse. Die ursprüngliche Vision klingt nach einer großen Vereinfachung der Dateninfrastruktur. Keine Datenverschiebungen zwischen Datenbanken und Data Warehouses mehr, keine ständigen Synchronisationsprobleme.

Anwendungen und BI-Tools greifen auf dieselben aktuellen Daten zu, wodurch Echtzeitanalysen und operative Entscheidungen unmittelbar möglich werden. Doch der Anspruch der HTAP-Systeme ist sehr hoch, da sich die Anforderungen an OLTP- und OLAP-Workloads grundlegend unterscheiden. Transaktionale Datenbanken sind auf kleine, schnelle Schreibvorgänge optimiert und setzen auf normalisierte Datenstrukturen mit zeilenorientierter Speicherung. Sie müssen Datenintegrität und hohe Verfügbarkeit gewährleisten sowie zahlreiche parallele Transaktionen effizient abwickeln. Analytische Systeme hingegen arbeiten mit massiven Datenmengen, führen komplexe Abfragen und Aggregationen durch und bevorzugen den schnellen Zugriff auf spaltenorientierte, denormalisierte Datenmodelle, um Lesegeschwindigkeiten zu maximieren.

Die technischen und architektonischen Differenzen erschweren es seit Jahren, ein System zu entwickeln, das beiden Anforderungen gleichwertig gerecht wird. Seit den frühen Tagen der HTAP-Idee gab es verschiedenste Ansätze und technologische Generationen, um diesen Traum zu realisieren. Die erste Welle verfolgte das Konzept, alles im Arbeitsspeicher zu halten – bekannt durch Pioniere wie SAP HANA. Dabei wurden Daten vollständig im RAM gehalten, um immens schnelle Zugriffszeiten zu erreichen und OLTP sowie OLAP auf den gleichen Tabellen zu ermöglichen. Der Nachteil war der enorme Kosten- und Hardwarebedarf, denn RAM ist teuer und wächst nicht beliebig skalierbar.

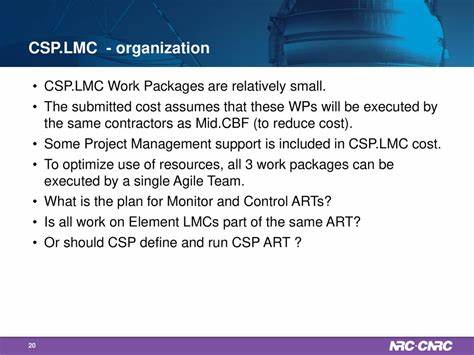

Für große Datenbestände oder Startups war das keine praktikable Lösung, auch wenn es in spezialisierten Branchen wie Finanzen und Telekommunikation erste Erfolge gab. Die zweite Generation von HTAP-Systemen trat mit Cloud-nativen, verteilten Architekturen an. Beispiele wie SingleStore, Alibaba PolarDB-X oder das Open-Source-System TiDB versuchten, Skalierbarkeit und Verfügbarkeit über verteilte Storage- und Compute-Mechanismen abzubilden. Diese Lösungen brachten einige Vorteile mit sich, darunter bessere Elastizität und hohe Ausfallsicherheit. Dennoch hatten sie eigene Herausforderungen: Der Betrieb war oft komplex, die Performance bei Transaktionen konnte gegenüber klassischen OLTP-Datenbanken nicht ganz mithalten, und viele Systeme mussten mit proprietären Komponenten oder eingeschränkten Ökosystemen leben, was die breite Akzeptanz hemmte.

Die jüngste und dritte Generation hingegen hebt HTAP in die Ära von Data Lakes, Lakehouses und Künstlicher Intelligenz. Hier geht es nicht mehr allein darum, OLAP-Engines mit Transaktionalität zu versehen. Vielmehr versuchen Plattformen wie Snowflake mit Hybrid Tables, Google AlloyDB oder Databricks Lakebase, den Spagat zu schaffen, indem sie modulare Lösungen miteinander verknüpfen und so die besten Eigenschaften für unterschiedliche Anwendungen miteinander kombinieren. Lakebase von Databricks ist ein vielversprechendes Beispiel für diesen pragmatischen Ansatz. Es funktioniert als serverlose, Postgres-basierte OLTP-Schicht, eingebettet in den Databricks Lakehouse, und synchronisiert sich aus Delta Lake-Tabellen.

Dadurch können Anwendungen mit frischen, transaktionalen Daten betrieben werden, während Analyse- und ML-Workloads weiterhin auf der analytischen Schicht sitzen. Diese modulare Herangehensweise ist ein Paradigmenwechsel. Anstatt zu versuchen, alles in einem monolithischen System zusammenzufassen, akzeptieren moderne HTAP-Konzepte die unterschiedlichen Anforderungen und bieten eine klare Trennung zwischen OLTP und OLAP. Die Integration erfolgt über native Synchronisationsmechanismen, die Daten komfortabel und zuverlässig zwischen den Speicherschichten bewegen. Dieser Ansatz bietet entscheidende Vorteile: Es erlaubt den Einsatz bewährter Best-of-Breed-Technologien, erleichtert die Skalierung und hält die Systeme einfacher wartbar.

Gleichzeitig ist man sich bewusst, dass eine hundertprozentige Synchronität und „ein System für alles“ noch Zukunftsmusik sind. Praktisch arbeitet man mit eventual consistency und plant Datenaktualisierungen und Frischefenster bewusst ein. Seit der Veröffentlichung von Databricks Lakebase hat sich die Diskussion erneut intensiviert. Lakebase nutzt die Innovationen von Neon, einem Cloud-native Postgres-Projekt auf Rust-Basis, das eine Trennung von Speicher und Berechnung ermöglicht, punktgenaue Wiederherstellung erlaubt und nahezu unbegrenzt skaliert. Postgres-Anwender schätzen besonders die gewohnte SQL-Kompatibilität, Stabilität und Flexibilität, während die Integration in den Lakehouse-Stack den Betrieb erheblich vereinfacht.

So entsteht ein System, das sich bestens für KI-Anwendungen eignet, in denen Features, Modelldaten oder Agenten mit aktuellen Transaktionen versorgt werden müssen. Trotzdem ist auch Lakebase kein Wundermittel. Es bietet keine vollumfängliche HTAP-Konsolidierung mit gemeinsamen Anfrageoptimierungen und ist derzeit als einseitige Brücke von Delta Tabellen hin zu Postgres konzipiert. Das bedeutet, die klassische Rollenverteilung von OLTP als App-Backend und OLAP als analytischer Motor bleibt bestehen, nur sind die Übergänge wesentlich reibungsloser und besser orchestriert als früher. Diese Kompromissbereitschaft ist jedoch kein Nachteil, sondern gilt als pragmischer Wegweiser für die Zukunft des Datenmanagements.

Insgesamt zeichnet sich ab, dass der HTAP-Traum nicht vergessen ist, sondern sich weiterentwickelt hat. Die Idee, OLTP- und OLAP-Anwendungen mit einer einzigen Datenquelle zu versorgen, bleibt attraktiv, wird jedoch zunehmend durch das Konzept moderner, modularer Architekturen ersetzt. Serverless-Betrieb, Cloud-Native-Design und nahtlose Integrationen werden zum Standard. Die Pergamente des HTAP-Wunschdenkens werden ersetzt durch handfeste Technologien, die in der Praxis funktionieren und auf bestehende Infrastruktur aufsetzen. Für Unternehmen bedeutet das, dass der Fokus zunehmend auf smarter Orchestrierung, Governance-Integration sowie der Kombination bewährter Systeme liegt, statt auf der Suche nach der ultimativen All-in-One-Datenbank.

Wer heute flexibel und skalierbar arbeiten will, setzt auf eine Kombination aus soliden transaktionalen Kernsystemen wie Postgres, leistungsfähigen analytischen Schichten wie Delta Lake und einer robusten Synchronisationslage dazwischen. KI-gestützte Anwendungen können so mit frischen Daten versorgt werden, während gleichzeitig Großanalysen und Statistikmodelle unbeeinträchtigt laufen. Die Zukunft von HTAP ist keine einzelne Revolution, sondern ein leises Aufeinanderfolge von Innovationen, die zusammenwirken. Je besser die Komponenten aufeinander abgestimmt sind und je einfacher Unternehmen ihre Datenlandschaften orchestrieren können, desto näher rückt die Verwirklichung der einst großen Vision. HTAP ist somit kein überholtes Konzept, sondern eine adaptierte Realität, die sich an die Komplexität und Anforderungen moderner Datenökosysteme anpasst.

Damit bleibt HTAP auch eine dekade nach seiner großen Ankündigung ein relevant bleibender Traum – diesmal vielleicht realistischer, praktikabler und integrativer als jemals zuvor.