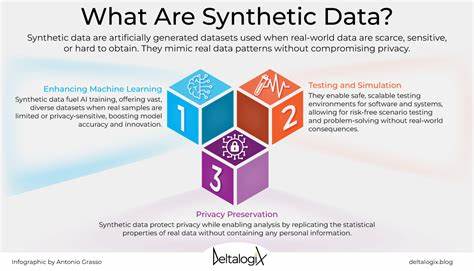

Die rasante Entwicklung großer Sprachmodelle (LLMs) hat in den letzten Jahren die Künstliche Intelligenz maßgeblich vorangetrieben. Modelle wie die der Llama-3-Familie zeichnen sich durch hohe Leistungsfähigkeit in natürlichen Sprachverstehens- und -generierungsaufgaben aus. Um jedoch das Potenzial solcher Modelle voll auszuschöpfen, ist die Feinabstimmung mit hochwertigen Trainingsdaten unabdingbar. Hier setzt das Meta Synthetic Data Kit, ein modernes Werkzeug von Meta, an – es bietet eine umfassende Lösung für die Erzeugung und Aufbereitung synthetischer Datensätze, die speziell auf die Bedürfnisse von LLMs zugeschnitten sind.Synthetische Daten spielen eine entscheidende Rolle, wenn es darum geht, Modelle gezielt zu trainieren oder sie für spezifische Aufgaben zu optimieren.

Der Vorteil synthetischer gegenüber realen Daten liegt in ihrer Flexibilität und Verfügbarkeit. Während echte Daten oft begrenzt, teuer oder mit Datenschutzproblemen verbunden sind, können synthetische Datensätze beliebig groß und zielgerichtet generiert werden. Das Meta Synthetic Data Kit unterstützt diesen Prozess, indem es eine modulare Pipeline bereitstellt, die das Erzeugen, Kuratieren und Speichern solcher Daten einfach und effizient gestaltet.Das Kernprinzip des Kits besteht darin, Rohdaten aus verschiedenen Quellen zu verarbeiten – seien es PDFs, HTML-Dokumente, YouTube-Transkripte oder andere Textformate – und daraus auf Basis leistungsstarker LLMs hochwertige Frage-Antwort-Paare sowie komplexe Ketten-von-Gedanken (Chain of Thought, CoT) Beispiele zu erstellen. Über eine klar strukturierte Befehlszeilenschnittstelle lassen sich die einzelnen Schritte des Workflows steuern: Zunächst werden Daten eingelesen, anschließend synthetische Beispiele generiert und dann anhand qualitativer Kriterien von einem LLM beurteilt.

Abschließend können die Ergebnisse in für diverse Fine-Tuning-Frameworks kompatiblen Formaten abgespeichert werden.Ein großer Mehrwert des Meta Synthetic Data Kit ist die Unterstützung unterschiedlicher Kopplungsmöglichkeiten an Large Language Models. Sowohl lokal gehostete Instanzen mit vLLM als auch externe API-Endpunkte lassen sich als Backend konfigurieren, was eine flexible Integration in bestehende Umgebungen ermöglicht. Die generierten Daten lassen sich auf Knopfdruck mit spezifizierten Parametern wie Temperatur, Anzahl der Beispielpaare oder qualitativen Filterkriterien individualisieren. Konfigurationsdateien im YAML-Format sorgen für Reproduzierbarkeit und erleichtern Anpassungen.

Insbesondere die Möglichkeit, Ketten-von-Gedanken-Beispiele zu generieren, hebt das Kit von vielen Wettbewerbern ab. Diese CoT-Beispiele simulieren komplexe logische oder mehrstufige Überlegungen, die das Modell nachahmen soll, was wesentlich zur Verbesserung des Verständnisses und der Argumentationsfähigkeit beiträgt. Dank der modularen Architektur können Anwender außerdem eigene Prompt-Vorlagen anpassen und so den Fokus der Datengenerierung nach individuellen Bedürfnissen steuern – beispielsweise zur juristischen Beratung, technischen Dokumentation oder anderen spezialisierten Gebieten.Die einfache Handhabung und klare Struktur des Toolkits steigern die Produktivität bei der Datenvorbereitung deutlich. Nutzer müssen keine technischen Hürden wie Formatkonvertierungen oder JSON-Parsing bewältigen, da das Kit diese Schritte automatisiert und intelligente Qualitätsfilter einsetzt.

Zudem sind Tipps zur Fehlerbehandlung und Hinweise zum Einsatz geeigneter Parser für PDF, DOCX oder YouTube-Transkripte hilfreich für eine reibungslose Nutzung.Ein weiterer Vorteil liegt in der Kompatibilität mit mehreren Ausgabeformaten, darunter offene Formate wie JSONL sowie proprietäre Fine-Tuning-Schemata wie Alpaca- oder OpenAI-Feinabstimmungsformate. Das ermöglicht Entwicklern, die generierten Daten direkt in bestehenden Machine-Learning-Pipelines einzusetzen und damit Trainingszeiten sowie Kosten zu optimieren. Die Möglichkeit, Datensätze auf Hugging Face Dataset Hub zu speichern, unterstützt darüber hinaus den kollaborativen Austausch.Im Bereich der Forschung und Entwicklung eröffnet das Meta Synthetic Data Kit neue Horizonte für Experimente mit synthetischen Daten.

Die Fähigkeit, Trainingssets anhand verschiedener Qualitätsmetriken automatisch zu filtern, macht es einfacher, in kurzer Zeit eine große Menge an hochwertigen Trainingsbeispielen zu erstellen. Dies erleichtert sowohl akademische als auch industrielle Innovationsprozesse, da individuelle Modelle präzise anpassen und trainieren lassen.Auch hinsichtlich der Skalierbarkeit liefert das Kit überzeugende Ansätze. Mit vLLM-Integration kann das Tool lokal auf leistungsfähiger Hardware betrieben werden, was Reaktionszeiten optimiert und den Datenschutz erhöht. Gleichzeitig lässt sich die Lösung über API-Endpunkte flexibel in Cloud-Umgebungen einbinden und skaliert dadurch mit dem Bedarf.

Anwender können so bei Projekten jeder Größenordnung vom Toolkit profitieren.Für User, die mehrere Dokumente oder diverse Quellen gleichzeitig verarbeiten möchten, bietet sich die Möglichkeit, Batch-Skripte zu verwenden, die den gesamten Workflow automatisieren. Dadurch wird die Datenpipeline noch effizienter und Fehlerrisiken sinken deutlich. Die aktive Community auf GitHub unterstützt darüber hinaus durch regelmäßige Beiträge, Tutorials und beispielhafte Anwendungsfälle, was den Einstieg weiter erleichtert.Zusammenfassend stellt das Meta Synthetic Data Kit eine äußerst leistungsfähige und flexible Lösung für die Generierung synthetischer Datensätze im Bereich der großen Sprachmodelle dar.

Das Tool verbindet komfortable Bedienung mit hoher Anpassbarkeit und integriert moderne Methoden zur Qualitätssicherung. Es erleichtert sowohl Entwicklern als auch Forschern, ihre Modelle mit maßgeschneiderten Daten zu versorgen und so Fähigkeiten zu erweitern oder neue Anwendungsfälle zu erschließen.Die wachsende Bedeutung synthetischer Daten in der AI-Welt wird durch solche innovativen Werkzeuge weiter unterstrichen. Meta setzt mit diesem Kit auf nachhaltige Lösungen, die den komplexen Datenvorbereitungsprozess transparent und zugänglich machen. Unternehmen und Entwickler, die auf Suchmaschinenoptimierung, effiziente Datengenerierung und smarte Entwicklungstools setzen, finden im Synthetic Data Kit ein durchdachtes Werkzeug, das die Grundlagen moderner KI-Anwendungen legt und erweitert.

Durch die Verfügbarkeit auf PyPI und die Möglichkeit zur Quellcode-Installation profitieren Anwender von leichter Integration und schneller Aufsetzbarkeit. Unterstützung für diverse Dateiformate sowie komfortable Konfigurationsoptionen ermöglichen es, verschiedenste Projekte von spezialisierten Chatbots bis hin zu fachlichen Auswertungen erfolgreich umzusetzen. In Kombination mit aktuellen LLM-Modellen wie Llama-3 oder Llama-4 wird so die Brücke zwischen rohen Inhalten und effektiven Trainingsdaten geschlagen.Nicht zuletzt trägt das Meta Synthetic Data Kit dazu bei, Barrieren für die Nutzung großer Sprachmodelle zu reduzieren. Wenn Datenaufbereitung einfach, schnell und qualitativ hochwertig gelingt, können auch kleinere Teams und Forschungslabore von den Fortschritten in der KI profitieren.

Die Weiterentwicklung solcher Tools wird vermutlich maßgeblich zur Demokratisierung und Verbreitung künstlicher Intelligenz beitragen und neue Anwendungsfelder erschließen.In Zukunft ist zu erwarten, dass das Synthese-Toolkit weiter an Funktionalität gewinnt und tiefer in komplette ML-Workflows integriert wird. Features wie automatische Labeling-Strategien, erweiterte Qualitätsmetriken und neue Ausgabeformate sind denkbar. Solche Innovationen könnten das Training großer Sprachmodelle weiter beschleunigen und produktiver gestalten. Nutzer profitieren von einer offenen, aktiven Community und Meta’s Engagement für kontinuierliche Verbesserung.

Wer also auf der Suche nach einer effizienten, robusten und vielseitigen Lösung zur Erstellung hochwertiger synthetischer Datensätze für LLMs ist, findet im Meta Synthetic Data Kit ein leistungsstarkes Werkzeug, das durch seine Modularität, Benutzerfreundlichkeit und Qualitätsorientierung überzeugt. Es schließt die Lücke zwischen Rohdaten und trainierfähigen Datensätzen und spielt eine zentrale Rolle in der Weiterentwicklung intelligenter KI-Anwendungen.