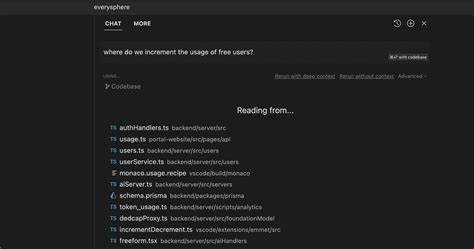

In den letzten Jahren hat die Integration von Künstlicher Intelligenz in Entwicklungsumgebungen einen erheblichen Einfluss auf die Softwareentwicklung genommen. Besonders KI-unterstützte IDEs wie Cursor haben das Potenzial, den Entwicklungsprozess effizienter zu gestalten, indem sie beispielsweise Codevorschläge machen, Automatisierungen ermöglichen und die Fehleranfälligkeit reduzieren. Trotz dieser Vorteile gibt es eine lebhafte Debatte darüber, inwieweit solche Tools im Kontext von proprietärem oder closed-source Code genutzt werden und welche Risiken daraus entstehen können. Die Frage, wie viele Entwickler und Unternehmen tatsächlich KI-gestützte Tools wie Cursor zur Erstellung proprietärer Software verwenden, ist weniger leicht zu beantworten, beeinflusst aber maßgeblich die Wahrnehmung dieser Technologie innerhalb der IT-Branche. Auf Plattformen wie Hacker News wird kritisch diskutiert, ob Unternehmen sensible, geschützte Quellcodes über APIs von AI-Services einspeisen und damit möglicherweise geistiges Eigentum und Datenschutz gefährden.

Diese Unsicherheiten werfen grundlegende Fragen hinsichtlich Datenschutz, Compliance und Geschäftsgeheimnissen auf. Proprietärer Code deutet dabei auf softwarebezogene Arbeit hin, die nicht öffentlich zugänglich ist und unterliegt strengen Vertraulichkeitsvereinbarungen und Datenschutzrichtlinien. Entwickler, die KI-Assistenzsysteme einsetzen, übertragen bei der Nutzung oft Codefragmente an externe Server, wo die eigentliche Verarbeitung der Daten stattfindet. Hier entsteht die zentrale Sorge: Könnten sensible Informationen dabei ungewollt weitergegeben oder durch die KI-Anbieter gespeichert oder ausgewertet werden? Obgleich viele Dienste Sicherheitsmaßnahmen implementiert haben, bleibt die Entscheidungsgewalt beim Nutzer und Unternehmen, wie sie mit dieser Thematik umgehen. Ein wesentliches Argument gegen die Verwendung von Cursor und ähnlichen Tools für proprietären Code ist die Möglichkeit des Datenlecks.

Unternehmen müssen abwägen, ob der Produktivitätszuwachs, der sich durch automatisches Codevervollständigen oder Generieren ergeben kann, die potenziellen Risiken eines Datenverlusts oder einer Offenlegung von Geschäftsgeheimnissen überwiegt. Die Sensibilität der branchenüblichen Software, beispielsweise im Finanzsektor, der Medizintechnik oder bei sicherheitskritischen Systemen, verschärft diese Bedenken noch. Gleichzeitig gibt es auch globale Bestrebungen, die Verwendung dieser Technologien sicherer zu machen. Anbieter von KI-gestützten Tools entwickeln zunehmend Lösungen, die lokale Verarbeitung ermöglichen, also ohne dass der Code zur Cloud übertragen wird. Dies könnte der klassische Sorge vor der Offenlegung sensibler Daten entgegenwirken und die Akzeptanz in Unternehmen steigern.

Darüber hinaus schaffen in-house geleitete LLMs (Large Language Models), die unter eigener Kontrolle betrieben werden, eine Möglichkeit, proprietären Code innerhalb der eigenen Sicherheitsinfrastruktur zu verarbeiten. Ein weiterer wesentlicher Aspekt betrifft die Rechtmäßigkeit und Lizenzfragen. Bei der Nutzung von KI-Modellen, die auf riesigen öffentlich verfügbaren Datensätzen trainiert wurden, inklusive eventuell öffentlich einsehbarem Quellcode, stellt sich die Frage nach dem Urheberrecht an generiertem Code. Wenn Unternehmen KI zur Generierung proprietärer Funktionen verwenden, muss geklärt werden, ob und inwieweit der das Trainingsmaterial berücksichtigende Code rechtlich als Originalwerk gilt und ob potentiell Lizenzverletzungen vorliegen könnten. Diese Rechtsunsicherheit kann ein Hindernis für eine breite Nutzung in der Industrie darstellen.

Die Realität auf Entwicklerseite zeigt, dass viele Einzelnutzer und kleinere Teams durchaus Tools wie Cursor verwenden, um tägliche Aufgaben zu erleichtern. Sie profitieren vor allem von der Produktivitätssteigerung, die sich aus automatischen Vorschlägen und Korrekturen ergibt. Ob sie dabei proprietären Code unbeabsichtigt teilen, ist oft nicht ausreichend bewusst. Dies stellt eine Herausforderung sowohl für die Sensibilisierung als auch für die technische Gestaltung der Dienste dar. Unternehmen hingegen zeigen sich oft zurückhaltend und suchen nach Wegen, KI-Technologien intern sicher und konform einzuführen.

Manche investieren in eigene KI-Lösungen oder setzen auf dedizierte KI-Tools, die keine Daten ins öffentliche Internet übertragen. Andere hingegen verbieten ausdrücklich die Nutzung externer KI-Angebote bei der Arbeit an sensiblen Projekten. In der Praxis findet sich hier ein Spannungsfeld zwischen Innovationswunsch und Risikovermeidung. Aus strategischer Sicht liefert die Nutzung von KI-basierten Tools wie Cursor durchaus Vorteile, die sich auf die Wettbewerbsfähigkeit auswirken können. Schnellere Codeerstellung, effizientere Fehlersuche und automatisierte Dokumentation ermöglichen es Entwicklungsteams, sich auf komplexere und kreative Aufgaben zu konzentrieren.

In einer Ära, in der Time-to-Market für Softwareprodukte entscheidend ist, sind solche Verbesserungen ein bedeutender Wettbewerbsvorteil. Nicht zuletzt bringt die anhaltende Diskussion um die Nutzung von KI-Technologien in der Softwareentwicklung auch neue Impulse für die Weiterentwicklung der Tools selbst. Transparenz, Datenschutz und Interoperabilität rücken in den Fokus, und Anbieter entwickeln zunehmend Funktionen zur Kontrolle und Anpassung der Datenverarbeitung. Zwei- oder mehrstufige Authentifizierungsmechanismen, Verschlüsselung der übertragenen Inhalte und Audit-Logs sind nur einige der Maßnahmen, die Vertrauen schaffen sollen. Zusammenfassend lässt sich festhalten, dass die Nutzung von Cursor und ähnlichen AI-unterstützten Entwicklungsumgebungen für proprietären Code sowohl Chancen als auch relevante Risiken mit sich bringt.

Wie weit die Verbreitung ist, hängt stark vom Sicherheitsverständnis und den Unternehmensrichtlinien ab. Für Entwickler und Unternehmen gilt es, sich mit den Möglichkeiten der Technologie auseinanderzusetzen, Sicherheitsaspekte nicht zu vernachlässigen und rechtskonforme Strategien für die Anwendung zu entwickeln. Angesichts des rasanten Fortschritts der KI ist es auch wahrscheinlich, dass sich diese Balance in Zukunft weiterverschiebt und neue Lösungen entstehen, die sowohl Innovationspotenzial als auch Datenschutzbedenken optimal adressieren.