Die Nutzung von Sprachmodellen hat in den letzten Jahren in vielen Disziplinen rasch an Bedeutung gewonnen. Besonders im Bereich der Geisteswissenschaften und der sozialen Forschung eröffnen sich durch Künstliche Intelligenz (KI) und maschinelles Lernen neue Möglichkeiten, historische Texte zu analysieren, zu interpretieren und zu reproduzieren. Doch eine zentrale Frage bleibt: Können moderne Sprachmodelle die Vergangenheit wirklich authentisch darstellen, ohne zeitliche Fehlproportionen oder Anachronismen einzuführen? Dieser Beitrag widmet sich genau dieser Herausforderung und untersucht die Möglichkeiten und Grenzen heutiger KI-Systeme bei der Darstellung historischer Sprachstile.Der Begriff Anachronismus beschreibt eine zeitliche Fehlplatzierung von Begriffen, Ausdrucksweisen oder Handlungsweisen, die nicht in die Epoche passen, die dargestellt werden soll. In der Geschichtswissenschaft gilt es besonders als Problem, wenn spätere Sprach- oder Denkstrukturen auf frühere Epochen übertragen werden, da dies die historische Authentizität verfälschen kann.

Für Sprachmodelle, die auf umfangreichen zeitgenössischen Daten trainiert werden, ist die Vermeidung von Anachronismen eine besondere Herausforderung. Da die meisten dieser Modelle auf Datensätzen basieren, die moderne oder gemischte Sprachformen enthalten, besteht die Gefahr, dass beim Versuch, vergangene Schreibstile zu simulieren, unabsichtlich moderne Ausdrücke oder Strukturen mit einfließen.Neuere Forschungen im Bereich der Computational Humanities und Natural Language Processing (NLP) untersuchen diese Problematik nun systematisch. In einer Studie von Underwood, Nelson und Wilkens, die im April 2025 veröffentlicht wurde, wurden verschiedene Ansätze getestet, wie Sprachmodelle mit historischen Texten umgehen können. Dabei fanden die Wissenschaftler heraus, dass einfaches Prompting – also das Verfüttern historischer Textbeispiele an ein modernes Modell – nicht ausreicht, um konsistente, epoche-gerechte Ergebnisse zu erzielen.

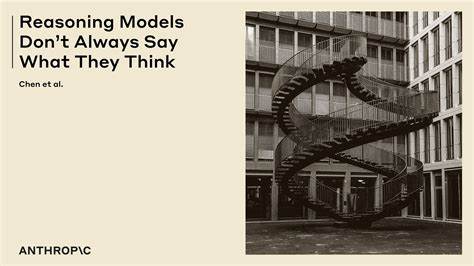

Das Modell generierte trotz der Eingabe historischer Beispiele Ausgaben, die im Stil nicht überzeugend genug waren und häufig moderne sprachliche Muster enthielten.Die Forscher gingen einen Schritt weiter und versuchten, die Modelle gezielt mit periodenspezifischen Korpora feinzujustieren, ein Prozess der Fine-Tuning genannt wird. Dieses Vorgehen führte zu Ergebnissen, die bei automatischen Prüfungen als stilistisch passend erkannt wurden und somit „täuschend echt“ wirken konnten. Es zeigte sich jedoch, dass menschliche Gutachter weiterhin Unterschiede zwischen tatsächlich historischen Texten und den maschinell generierten Versionen erkennen konnten. Das weist darauf hin, dass obwohl maschinelles Fine-Tuning ein vielversprechender Weg ist, die Interessensgemeinschaft von Texthistorikern und Sprachwissenschaftlern noch nicht vollständig überzeugt werden konnte.

Diese Beobachtungen deuten auf einen wichtigen Faktor hin: Die wichtigste Voraussetzung für ein wirklich anachronismusfreies Sprachmodell stellt offenbar das Pretraining auf umfangreichen, authentischen historischen Texten dar. Nur durch die Einbeziehung originaler periodenspezifischer Daten in den Trainingsprozess scheinen KI-Modelle das nötige historische Sprachgefühl zu entwickeln und sich überzeugend in vergangene Zeiten hineinversetzen zu können. Die Herausforderung liegt dabei nicht nur im Finden ausreichend großer und verlässlicher Textsammlungen, sondern auch in der Aufbereitung der Daten hinsichtlich Rechtschreibung, Semantik und Stilistik, die sich im Laufe der Jahrhunderte stark verändert haben.Die Implikationen für die Social Sciences und digitale Geisteswissenschaften sind vielfältig. Forschende, die KI-basierte Simulationen historischer Texte einsetzen wollen, müssen sich der Gefahr bewusst sein, dass moderne Sprachmodelle ohne angemessenes Training auf Quellen der jeweiligen Epoche ungewollt historische Verzerrungen erzeugen könnten.

Das könnte die Ergebnisse von Analysen verfälschen oder Fehlschlüsse auf Basis nicht authentischer Sprachmuster nach sich ziehen. Andererseits eröffnen fortschrittlich trainierte Modelle die Chance, historische Perspektiven besser zu verstehen und Sprachstrukturen vergangener Zeiten zugänglich zu machen, was neue Interpretationsansätze und interdisziplinäre Forschungen ermöglicht.Neben dem Pretraining stellt die Evaluation historischer Sprachmodelle eine besondere Herausforderung dar. Automatische Stilprüfungen können zwar eine erste Einschätzung liefern, doch menschliche Experten bleiben aufgrund ihrer Fähigkeit zur kritischen Kontextualisierung und kulturellen Sensibilität unverzichtbar. Die Zusammenarbeit von Computerwissenschaftlern, Historikern und Linguisten wird daher immer wichtiger, um Entwicklung und Anwendung solcher Modelle verantwortungsvoll zu gestalten.

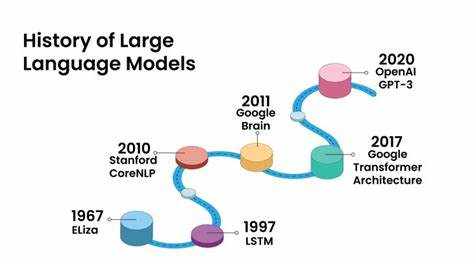

Auch technische Fortschritte in der Modellarchitektur könnten die Zukunftsaussichten verbessern. Momentan werden vor allem große Transformer-Modelle wie GPT (Generative Pre-trained Transformer) eingesetzt, die enorm mächtig, aber auch datenhungrig sind. Die Integration von Metadaten zur zeitlichen Einordnung von Texten oder die Entwicklung von Modellen, die explizit zeitliche Dynamiken in der Sprache erfassen, könnten dazu beitragen, Anachronismen weiter zu reduzieren. Forscher arbeiten daher bereits an sogenannten temporalen Sprachmodellen, die sprachliche Veränderungen über die Zeit hinweg abbilden.Daneben gewinnen Ansätze an Bedeutung, die eine aktive Steuerung der Textgenerierung hinsichtlich Stil, Syntax und Vokabular ermöglichen.

So können Nutzer oder Entwickler gezielter auf historische Authentizität hinarbeiten, indem sie Parameter anpassen oder spezielle Constraints definieren. Das erlaubt eine differenziertere Kontrolle über die erzielten Resultate und könnte dabei helfen, klassische Probleme der Stilvermischung zu umgehen.Es bleibt die Frage, wie Sprachmodelle zukünftig in der Praxis eingesetzt werden sollen, um historische Studien zu unterstützen. Neben der reinen Textgenerierung und Simulation eignen sie sich auch für die Entdeckung und Analyse von sprachlichen Wandelprozessen, der Erkennung sozio-kultureller Trends und der Textklassifizierung nach Epoche oder Stil. Dabei ist wichtig, Modelle und Methoden kontinuierlich zu validieren und zu verbessern, um die Gefahr von Verzerrungen so gering wie möglich zu halten.