Die rasante Entwicklung großer Sprachmodelle (Large Language Models, kurz LLMs) hat die Art und Weise, wie Software programmiert wird, grundlegend verändert. LLMs wie GPT-4, Claude oder diverse Modelle von Open-Source-Anbietern unterstützen Entwickler bei der Codegenerierung, Fehlersuche und der Automatisierung vieler Programmieraufgaben. Doch wie gut schlagen sich diese Modelle tatsächlich in verschiedenen Programmiersprachen und wo liegen die Stärken und Schwächen? Wie wirken sich diese Unterschiede auf die Wahl der Programmiersprache und damit auf den Softwareentwicklungsprozess aus? Diese Fragen stehen im Fokus einer aktuellen umfassenden Untersuchung, die 17 große Sprachmodelle auf ihre Performance in vier stark typisierten Programmiersprachen testet – Python, TypeScript, Swift und Rust. Die Ergebnisse liefern wertvolle Informationen darüber, welche Kombinationen aus LLM und Programmiersprache für KI-unterstützte Programmierung besonders geeignet sind und wie ein eventuelles Ungleichgewicht Entwicklungstrends beeinflussen könnte. Historisch betrachtet sind Programmiersprachen mit umfangreicher Codebasis und aktiver Community bei KI-Modellen im Vorteil.

Dies hängt damit zusammen, dass LLMs auf riesigen Mengen an existierendem Quellcode und Dokumentation trainiert werden, wodurch sie für Sprachen mit umfangreicher Repräsentanz im Trainingsdatensatz besser geeignet sind. Python und JavaScript sind hier typisch, da diese Sprachen weit verbreitet sind und besonders viel öffentlich verfügbaren Code besitzen. Im Gegensatz dazu haben Languages wie Swift oder Rust, trotz wachsender Beliebtheit, eine relative geringere Präsenz. Rust punktet zwar mit anspruchsvoller Typsicherheit und modernen Features, die das Schreiben von sicherem und performanten Code fördern, doch gerade diese Komplexität stellt für die automatisierte Codegenerierung eine Herausforderung dar. Das erwähnte Forschungsvorhaben nutzt eine eigens entworfene Datenbank von Programmieraufgaben, welche jeweils spezifische Anforderungen an die jeweiligen Sprachen stellen.

Dabei gibt es sowohl allgemeinsprachige Aufgaben, die prinzipiell in jeder der getesteten Sprachen lösbar sind, als auch sprachspezifische Aufgaben, die tiefergehendes Wissen über die Ökosysteme und typische Features der Sprachen erfordern. Die Resultate basieren auf hunderten von Experimenten, die in Serie ausgeführt wurden, um sowohl die Erfolgsquote als auch die Stabilität der Antworten über mehrere Durchläufe hinweg zu beurteilen. Dabei wurden strenge Kriterien wie Typprüfungen, funktionale Ausführung und sogar Serverimplementierung in praktischen Tests angewandt. Eines der spannenden Forschungsergebnisse ist die signifikante Leistungsspanne eines und desselben LLM im Kontext verschiedener Sprachen. So zeigt etwa das Modell Sonnet 3.

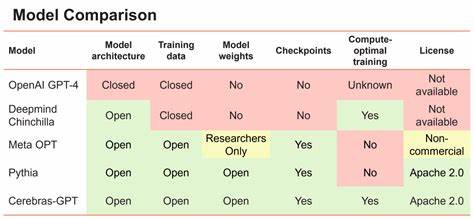

5 eine bemerkenswerte Erfolgsquote von 81 Prozent bei Python und TypeScript, während Swift und Rust mit 71 beziehungsweise 62 Prozent deutlich abfallen. Das verdeutlicht, dass LLMs nicht nur generell ausgezeichnete Programme erzeugen, sondern dass diese Qualität stark vom jeweiligen Sprachkontext abhängt. Dies hat erhebliche Auswirkungen auf die Praxis: Entwickler, die von LLM-Unterstützung profitieren wollen, könnten in Versuchung geraten, sich auf Sprachen mit besseren AI-Unterstützungen zu konzentrieren, was langfristig eine Verschiebung im Sprachgebrauch zur Folge haben könnte. Die Analyse umfasst darüber hinaus eine breite Auswahl an LLMs auf unterschiedlichen Architekturen, angefangen bei OpenAI-Modellen wie GPT-4o und GPT-4o-mini über gewerbliche Varianten von Anthropic wie Claude Sonnet und Haiku bis hin zu Modellen von Deepseek, Meta und Mistral. Auffällig ist die enorme Diskrepanz in puncto Performance, Kosten und Geschwindigkeit bei der Ausführung von Programmieraufgaben.

Manche Modelle überzeugen mit einer guten Balance aus Genauigkeit, Nutzungskosten und Rechenzeit, andere wiederum sind zwar günstig, benötigen aber unverhältnismäßig viel Zeit oder liefern dafür eine niedrige Erfolgsquote. Besonders die Modelle von Deepseek sind in dieser Hinsicht hervorgehoben worden: Sie sind zwar preiswert, scheitern jedoch teilweise an der Geschwindigkeit, was in realen Entwicklungsumgebungen zu Performanceproblemen führen kann. Ein weiterer wichtiger Punkt ist die Stabilität der Modelle. Da LLMs probabilistisch arbeiten und nicht deterministisch sind, ist es entscheidend, wie oft ein identisches Problem beim wiederholten Abfragen richtig gelöst wird. Die Studie testet alle Aufgaben dreimal und bewertet die Konstanz der Ergebnisse.

Modelle wie o3-mini zeigen dabei beeindruckende Stabilität, was für den praktischen Einsatz ebenfalls von großer Bedeutung ist, um wiederholbare und verlässliche Qualität für Entwickler zu gewährleisten. Neben der Performance der Modelle wurde außerdem die Frage untersucht, welche Sprache sich insgesamt am besten für KI-gestützte Programmierung eignet. Hierbei brilliert Python mit einem Spitzenwert von 89 Prozent bei der erfolgreichen Umsetzung komplexer, sprachspezifischer Aufgaben. TypeScript folgt auf Abstand mit 73 Prozent, während Swift und Rust mit 69 beziehungsweise 65 Prozent abschließen. Dieses Ergebnis korrespondiert mit der Verfügbarkeit von Trainingsdaten sowie mit der Komplexität der jeweiligen Sprachfeatures.

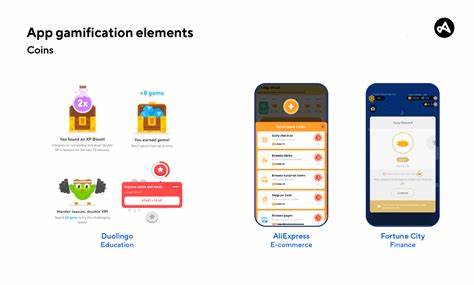

Python profitiert von seiner Flexibilität, großen Community und weitverbreiteter Nutzung in Open-Source-Projekten und Data-Science-Anwendungen, wodurch genug Datenmaterial vorhanden ist, damit LLMs dieses Wissen effizient nutzen können. Die Untersuchung zeigt zudem, dass kostengünstigere Modelle wie Qwen-Max mit etwa 30 Prozent der Kosten großer Modelle wie Sonnet vergleichbare Resultate erzielen können, was für Unternehmen und Entwicklerteams mit begrenztem Budget eine interessante Option darstellt. Hierbei werden aber auch Kompromisse bei der Antwortgeschwindigkeit und den Antwortzeiten sichtbar. Langfristig werfen diese Erkenntnisse Fragen zu den Auswirkungen auf die Programmiersprachenlandschaft auf. Wenn LLMs in der Lage sind, in gewissen Sprachen qualitativ besseren Code zu generieren, könnten sich Entwicklungsteams vermehrt für diese Sprachen entscheiden, wodurch ein Übergewicht entsteht.

Dieses Ungleichgewicht könnte in den kommenden Jahren verstärkt auftreten, was wiederum die Entwicklung neuer LLMs beeinflussen könnte, da Trainingsressourcen möglicherweise speziell auf stark genutzte Sprachen optimiert werden. Um dem entgegenzuwirken, empfehlen Experten die kontinuierliche Weiterentwicklung und Diversifizierung der Trainingsdaten sowie das gezielte Fördern von Modellen, die auch komplexe Sprachfeatures wie Rusts Trait-basiertes System gut unterstützen. Auch sollte die Community weiterhin Aufgaben und Benchmarks bereitstellen, die eine faire und ausgewogene Beurteilung ermöglichen, um diese Entwicklung transparent zu gestalten. Die Kombination einer detaillierten, realitätsnahen Testumgebung mit einer Vielzahl von LLMs bietet Entwicklern, Forschern und Unternehmen eine hervorragende Grundlage um Tools und Strategien für die eigene Softwareentwicklung mit KI-Unterstützung auszuwählen. Für Entwickler zeigt sich, dass neben dem reinen Modell die gewählte Programmiersprache einen erheblichen Einfluss darauf hat, wie effektiv und schnell die Zusammenarbeit mit LLMs erfolgt.

Genauere Kenntnisse über die Stärken und Grenzen der jeweiligen Modelle in bestimmten Sprachen helfen dabei, die Produktivität zu steigern und Fehler zu reduzieren. Abschließend ist festzuhalten, dass die KI-gesteuerte Programmierung eine neue Dimension der Softwareentwicklung einläutet, in der Sprachmodellqualität und Sprachwahl wesentlich für den Projekterfolg sind. Die hier vorgestellten Vergleichsdaten bieten wichtige Orientierungspunkte, um diese komplexe Dynamik besser zu verstehen und konstruktiv in die tägliche Arbeit einzubeziehen. Während sich große Sprachmodelle weiterhin rasant verbessern, sollten Entwickler und Unternehmen die entstehenden Chancen nutzen und zugleich darauf achten, ein ausgewogenes und nachhaltiges Ökosystem für alle Programmiersprachen zu erhalten.