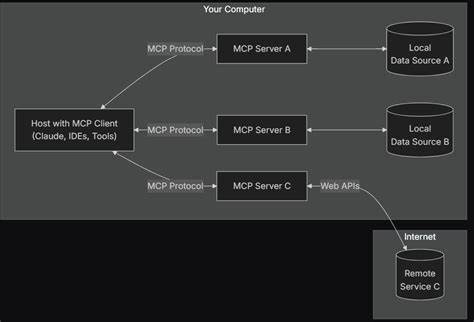

Mit dem rapiden Fortschritt künstlicher Intelligenz wächst auch der Bedarf an Systemen, die diese Intelligenz nicht nur nutzen, sondern sie auch kontextuell einbetten und operativ einsetzen können. llmbasedos ist ein Minimal-Linux-Betriebssystem, das genau diesen Anspruch verfolgt – es transformiert herkömmliche Computer von passiven Ausführenden zu autonomen Partnern, die über Wahrnehmung, Vernunft und Handlungskapazitäten im lokalen und Cloud-Kontext verfügen. Die zentrale Innovation dabei ist das Model Context Protocol Gateway, kurz MCP, das als einfacher, aber leistungsstarker JSON-RPC Layer über UNIX-Sockets und WebSockets agiert, um sämtliche Systemfähigkeiten für intelligente Modelle – seien es große Sprachmodelle (LLM) oder andere KI-Formate – zugänglich zu machen. Was llmbasedos grundsätzlich von anderen Systemen unterscheidet, ist sein holistischer Ansatz, der auf einem einheitlichen Abstraktionslayer beruht. Alle Systemressourcen wie Dateisystem, Maildienste, APIs oder externe Agenten werden als MCP-Methoden angeboten, die vollständig entdeckbar und aufrufbar sind.

Diese Umsetzung erlaubt es einer Vielzahl unterschiedlicher Modelle, von OpenAI über Gemini bis hin zu lokal gehosteten Modellen wie LLaMA.cpp, nahtlos miteinander zu interagieren und die für die jeweilige Aufgabe beste Lösung zu wählen. Die Auswahl erfolgt dynamisch, gesteuert von den Bedürfnisse des Nutzers oder der jeweiligen Anwendung. Im Gegensatz zu anderen AI-basierten Automationswerkzeugen verzichtet llmbasedos bewusst auf starre YAML-Workflows zugunsten von vollwertigen Python-Skripten. Diese bieten erheblich mehr Flexibilität, erlauben komplexe Logikstrukturierung, ausführliche Debugging-Möglichkeiten und ermöglichen einen agileren Entwicklungsprozess.

So lassen sich intelligent gesteuerte, vollautomatisierte Workflows auf einfachem Wege maßschneidern – wobei der Code stets verständlich bleibt und direkt mit MCP-Kommunikationen verknüpft ist. Ein Paradebeispiel für die Leistungsfähigkeit der Plattform ist die Fähigkeit, ohne großen Boilerplate-Code einen auf Künstlicher Intelligenz basierenden Outreach-Agenten zu programmieren. Durch die Verwendung nur weniger MCP-Aufrufe kann das System automatisch Kontakte verfolgen, neue Interessenten identifizieren und Kontakthistorien aktuell halten. Der Fokus liegt dabei nicht nur auf Intelligenz, sondern auf einer integrativen User Experience, die Bahn bricht für praktische Anwendungen, die sowohl lokal gesichert als auch transparent im Betrieb sind. Die Implementierung von llmbasedos ist dabei auch auf Sicherheit ausgelegt.

Der lokale Betrieb stellt sicher, dass sensible Daten nicht unbeabsichtigt in die Cloud übertragen werden. Die Architektur verwendet einen sogenannten Virtual Path Jail, der die Dateizugriffe auf bestimmte Pfade beschränkt und so eine zusätzliche Schutzebene schafft. Zudem basiert die Lizenzierung auf Schlüssel-konformen Tiers, die durch das MCP-Gateway kontrolliert werden, um unerlaubte Nutzung zu verhindern. Geheimnisse und Tokens verbleiben ausschließlich in gesicherten Umgebungen und werden nicht in den Container Images eingebettet. Die technische Basis von llmbasedos kombiniert modernste Open-Source-Technologien wie Python 3.

10+, FastAPI mit WebSocket-Unterstützung, Supervisord zur Mikroservice-Verwaltung sowie Docker und Docker Compose für einfache Deployment-Prozesse. Dieser Stack erlaubt es Entwicklern und Anwendern, die gesamte Umgebung konsistent und reproduzierbar zu betreiben. Die Philosophie dahinter ist klar: die Barrieren für Einsteiger senken und durch modulare Offenheit ein Ökosystem von Erweiterungen, welche die Kommunikation zwischen KIs und lokalen Systemressourcen erleichtern, schaffen. Die Rolle des MCP, des Model Context Protocol, ist besonders interessant, da es eine Art Brücke zwischen der kognitiven Intelligenz der Modelle und den lokalen operativen Fähigkeiten des Systems bildet. Das Protokoll ist einfach genug, um schnell erlernt und angewandt zu werden, bietet aber gleichzeitig genügend Tiefe, um komplexe Interaktionen zu unterstützen.

Es erlaubt den Zugriff auf Dateien, Mail-Kommunikation, Web-Schnittstellen sowie weitere Dienste und Agenten und schafft so ein einheitliches Interface für intelligente Automatisierung. llmbasedos verfolgt konsequent einen „local-first“ Ansatz, der nicht nur Datenschutz gewährleistet, sondern auch Latenzzeiten minimiert und ein besseres Control-Framework über kritische Datenströme bietet. Überraschend flexibel ist die Einsetzbarkeit der Lösung, die sich an verschiedenste Nutzergruppen richtet. Von Entwicklern, die den Schmerz des manuellen API-Gewerkelns leid sind, über Forscher im Bereich der Agenten, die eine saubere und wiederverwendbare Substratschicht für Experimente benötigen, bis hin zu Indie-Hackern, die GPT-basierten Anwendungen echten Nutzen entlocken wollen. Das Ökosystem von llmbasedos wird durch eine Reihe von Python-Microservices erweitert, die funktionale Bereiche abdecken.

Beispielsweise legt der fs-Server ein virtualisiertes Dateisystem mit semantischer Suche auf Basis von FAISS an, der mail-Server unterstützt IMAP-Mail Parsing und Entwurfsverwaltung und der sync-Server nutzt rclone, um Datei-Synchronisationen zuverlässig zu realisieren. Diese Vielfalt an Diensten wird zentral über den MCP-Gateway orchestriert, der nicht nur die Authentifizierung sicherstellt, sondern auch die Lastverteilung und das Lizenzmanagement übernimmt. Eine bedeutende Weiterentwicklung befindet sich bereits in der Pipeline: Der orchestrator_server soll es ermöglichen, natürliche Sprachabsichten zu interpretieren und diese selbstständig in Python-Skripte zu übersetzen. Das bedeutet, dass Anwender künftig Aufgaben verbal oder schriftlich eingeben können und das System automatisch die dafür notwendigen Schritte generiert und auf Wunsch umsetzt. Damit entsteht eine innovative Kompilierungsstufe für Intentionen, die weit über reine Sprachverarbeitung hinausgeht und die automatisierte Arbeitsflussgestaltung auf ein neues Level hebt.

Das Potenzial von llmbasedos reicht weit über erste Anwendungsfälle hinaus. Indem die Plattform eine flexible und erweiterbare Schnittstelle bietet, entstehen zahlreiche Szenarien, in denen intelligente Agenten aktiv in den Alltag und in professionelle Umgebungen integriert werden können. Personal Assistenten, automatisierte Datenanalysen, intelligente Kommunikationsdienste oder proaktive Informationsrecherche sind nur einige Bereiche, in denen der Einsatz Erfolg versprechend ist. Die Offenheit des Projekts lädt zudem zu einer lebendigen Community-Nutzung ein. Der Quellcode steht öffentlich zur Verfügung, und Beiträge in Form von Pull Requests, Forks oder Stars sind ausdrücklich erwünscht.

Die Entwicklerstruktur setzt zudem auf moderne DevOps-Methoden, die schnelle Iterationen und ein agiles Vorantreiben von Innovationen fördern. Zusammenfassend bietet llmbasedos mit seinem zentralen MCP-Gateway eine hochwertige, skalierbare und sichere Lösung für die Integration künstlicher Intelligenz in Betriebssysteme und lokale Umgebungen. Es schafft eine Brücke zwischen der kognitiven Welt intelligenter Modelle und der physischen Infrastruktur herkömmlicher Computerlandschaften. Indem es die Komplexität der Verbindung vereinfacht und zugleich mächtige Werkzeuge bereitstellt, macht es den Sprung von der passiven Ausführung hin zur autonomen Unterstützung eines Computers real. Betrachtet man die Zukunft von llmbasedos, so lässt sich mit Sicherheit eine steigende Relevanz für Anwendungen absehen, die auf intelligenten Assistenz- und Automatisierungssystemen basieren.

Projekte wie der einbindende orchestrator_server versprechen zudem, die Art und Weise, wie Menschen und Maschinen interagieren, nachhaltig zu verändern. llmbasedos öffnet dabei Türen für eine Welt, in der Künstliche Intelligenz nicht nur Wissen generiert, sondern direkt handelt und den Alltag erleichtert – lokal, sicher und flexibel.