In der heutigen Zeit prägen Künstliche Intelligenz und speziell ChatGPT zunehmend die Lern- und Arbeitsweise von Studierenden. Diese leistungsstarken KI-Tools bieten eine enorme Unterstützung bei der Problemlösung, dem Verstehen komplexer Themen und dem Verfassen von Texten. Doch genau diese Entwicklung wirft wichtige Fragen in der akademischen Ausbildung und in der Gestaltung von Prüfungen auf: Wie kann man sicherstellen, dass Studierende nicht nur KI-Ergebnisse wiedergeben, sondern wirklich die zugrundeliegenden Konzepte verstehen und anwenden? Wie gelingt es, Studierende herauszufordern, die sich übermäßig auf ChatGPT verlassen und so die eigene aktive Auseinandersetzung vermeiden? Diese Fragen gewinnen insbesondere in technischen Fachgebieten wie dem digitalen Design und der Hardwarebeschreibungssprache Verilog an Bedeutung. Ein innovativer Ansatz, der in der Verilog Meetup-Community entstand, zeigt eindrucksvoll, wie man diesen Herausforderungen begegnen kann und warum traditionelle Methoden nicht mehr ausreichen. Das zentrale Problem bei der Verwendung von ChatGPT in technischen Aufgabenstellungen liegt in den inhärenten Grenzen der KI selbst.

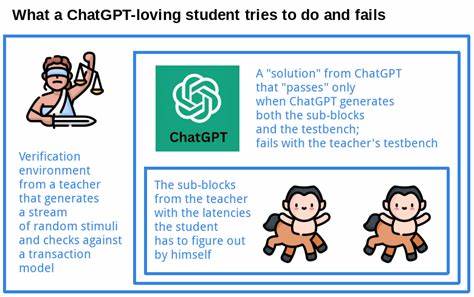

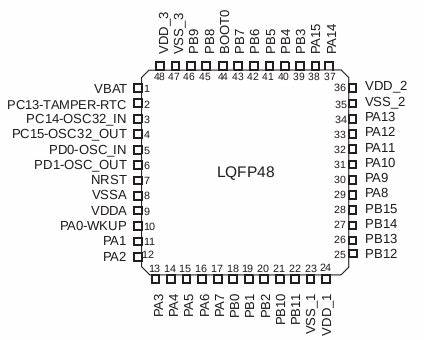

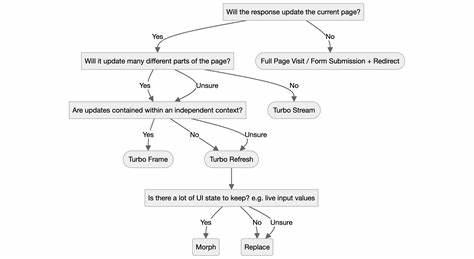

Während ChatGPT in der Lage ist, Code zu generieren und logische Zusammenhänge herzustellen, fehlt es ihm an der Fähigkeit, dynamische Prozesse tatsächlich auszuführen, zu simulieren und unabhängige Untersuchungen durchzuführen. Insbesondere in der Entwicklung von Hardware, wo temporale Aspekte wie Latenzen, Pipeline-Stufen und Ablaufsteuerungen eine entscheidende Rolle spielen, ist das ‚Verstehen‘ durch Simulation oder dedizierte Analyse nötig. Genau hier setzt das von der Verilog Meetup entwickelte Prüfungskonzept an. Im Kern geht es um eine Aufgabenstellung, die Studierende vor die Herausforderung stellt, eine pipelined Hardware-Baustein zu entwerfen, welcher eine einfache Formel basierend auf vorgefertigten, pipelined Submodulen für Gleitkomma-Multiplikation und -Addition berechnet. Die entscheidende Hürde ist, dass die exakte Latenz dieser Submodule im Aufgabenstatement nicht vorgegeben ist und aktiv vom Lernenden herausgefunden werden muss.

Ohne eigenes Simulieren oder sorgfältige Analyse der Quellcodes lassen sich die korrekten Zeitpunkte der Datenverarbeitung nicht bestimmen, was zu fehlerhaften Implementierungen führt. Das Problem wird anschließend durch einen vorinstallierten Testbench auf Transaktionsebene geprüft, der zufällige Werte und unregelmäßige Zeitabstände testet und so eine robuste und korrekte Lösung erzwingt. Da ChatGPT weder RTL-Simulationen ausführen noch komplexe und parametrische Hardwarebeschreibungen fehlerfrei analysieren kann, zeigt sich bei KI-gestützten Lösungen schnell deren Grenzen. Lösungen, die von ChatGPT generiert werden, versagen oft beim strengen Testbench, sodass Studierende in eine Sackgasse geraten und zum Frust neigen. Dies illustriert nicht nur den Unterschied zwischen rein theoretischem oder statischem Codeverständnis und praxisnaher Verifikation, sondern verdeutlicht auch, dass die Beherrschung moderner Funktionstests und Verifikationsmethoden im digitalen Hardwaredesign essenziell ist.

Der didaktische Wert dieser Aufgaben besteht darin, Lernende dazu zu bringen, den gesamten Entwicklungsprozess ernsthaft zu durchlaufen: von der Quellcodeanalyse über Simulation bis hin zur Evaluierung mit fortgeschrittenen Testumgebungen. Neben dem Codeverständnis lernen sie so auch, wie wichtig Timing, Pipeline-Steuerung und Datenflusskontrolle in realen Chips sind. Solche Fähigkeiten sind hochgradig relevant für den Berufsalltag eines RTL-Entwicklers, der CPU-, GPU- oder Netzwerkprozessoren entwirft. Die Fähigkeit, Submodule zu integrieren, Latenzen korrekt zu verwalten und robuste Lösungen in komplexen Umgebungen herzustellen, entscheiden über den Erfolg solcher Projekte. Studierende, die ChatGPT als reine Abkürzung einsetzen und versuchen, komplette Lösungen inklusive Submodule und Testbench von der KI erstellen zu lassen, werden von den Prüfern abgelehnt.

Die Aufgaben wurden genau so konzipiert, dass sie mit vorgefertigten Modulen arbeiten müssen und keine vollständige Neuentwicklung der Bausteine gemacht werden darf. Wer die Aufgabe noch dazu mit Eigeninitiative, kritischem Denken und praktischer Analyse angeht, hat gute Chancen, erfolgreich zu bestehen. Dieses Vorgehen fördert nebenbei die Fähigkeit zum Selbststudium und zur systematischen Fehlersuche – beides grundlegende Kompetenzen für jeden Ingenieur. Kritische Fragen von Studierenden, wie etwa Nachfragen zu exakten Zykluszahlen oder das Teilen von Zwischenergebnissen zur Unterstützung durch Lehrer oder KI, zeigen oft eine fehlende eigenständige Herangehensweise. Ebenso sind Zweifel am Praxisrelevanzbezug der Aufgabe ein Indikator dafür, dass viele Lernende die komplexen Anforderungen der modernen Chipentwicklung unterschätzen.

Dabei werden in der Industrie die meisten digitalen Verarbeitungseinheiten tatsächlich durch komplexe Pipeline-Steuerungen charakterisiert, was die Bedeutung solcher Lerninhalte unterstreicht. Zusammenfassend entsteht mit solchen Prüfungsformaten ein edukatives Umfeld, das nicht nur die reine Programmierfähigkeit abfragt, sondern die umfassende Kompetenz im Umgang mit digitaler Hardware, deren zeitlicher Dynamik und Verifikationskultur verlangt. Der Schlüssel liegt darin, Lerninhalte anzubieten, die KI-Werkzeuge ergänzen, jedoch nicht ersetzen können. So wird verhindert, dass ChatGPT zu einer unreflektierten Abkürzung wird, und vielmehr zu einem Werkzeug, das zur eigenen Weiterentwicklung genutzt werden kann. Für Hochschulen und Lehrende bedeutet dies, frühzeitig, idealerweise bereits im zweiten Studienjahr, derartige mikroarchitektonische Übungen in die Curricula aufzunehmen.

So können Studierende sich mit Pipelining, Flusskontrolle und funktionaler Verifikation nach modernen Standards vertraut machen. Auf lange Sicht stärkt dies nicht nur die Qualität der Ausbildung, sondern sorgt auch dafür, dass Absolventen auf die tatsächlichen Anforderungen der Industrie vorbereitet sind und nicht auf KI-Resultate angewiesen bleiben. Die Integration moderner Verifikationsmethoden bringt zudem den großen Vorteil mit sich, dass Designfehler in den eigenen Schaltungen frühzeitig erkannt und behoben werden können – ein Faktor, der in professionellen Entwicklungszyklen von entscheidender Bedeutung ist. Dies stärkt das Verständnis für sogenannte Corner Cases, die oft in dynamischen Arbeitszuständen auftreten, und ohne entsprechende Prüfung verborgen bleiben. Ein weiterer gewinnbringender Effekt ist, dass die Studierenden bereits früh im Studium erfahren, ob die Arbeit im Hardwaredesign ihren Fähigkeiten und Interessen entspricht.

ChatGPT als vermeintliche Rettung ist keine Lösung für diejenigen, die Schwierigkeiten haben oder nicht bereit sind, die nötige Praxis zu investieren. Der Markt bietet vielfältige alternative Karrierewege, und ein frühzeitiges Erkennen der eigenen Neigungen und Fertigkeiten ist für den beruflichen Erfolg entscheidend. In einer Zeit, in der KI-Tools wie ChatGPT zunehmend in den Alltag von Studierenden einziehen, ist es wichtiger denn je, durchdachte didaktische Strategien zu entwickeln. Die Kombination anspruchsvoller, praxisnaher Aufgaben mit modernen Verifikationsmethoden schafft ein solides Fundament, um die digitale Zukunft kompetent mitzugestalten. Dies schließt nicht aus, dass KI sinnvoll eingesetzt wird – im Gegenteil, wer sich mit den Grenzen der Werkzeuge auskennt, kann sie gezielt zur eigenen Weiterentwicklung nutzen.

![Choicejacking: Compromising Mobile Devices Through Malicious Chargers [pdf]](/images/A8C6C188-D27F-4616-8BCB-3BFE6CA10D9D)