Mit der rasanten Entwicklung der Computerhardware wächst bei vielen Nutzern und Unternehmen die Erwartung, dass neue Maschinen automatisch alte Software deutlich beschleunigen. Doch die Realität sieht oft anders aus: Neue Computer versprechen zwar höhere Taktfrequenzen, mehr Kerne und modernere Architektur, doch alte Programme profitieren nicht zwangsläufig von diesen Fortschritten. Dieses Phänomen wirft Fragen auf – warum beschleunigt sich alter Code nicht im gleichen Maß wie die Hardwareentwicklung? Welche Faktoren spielen dabei eine Rolle und wie lässt sich der Flaschenhals beseitigen? Zunächst ist es entscheidend zu verstehen, dass Software und Hardware eine symbiotische Beziehung eingehen müssen, um ihre Leistung gegenseitig zu steigern. Alte Programme sind häufig auf bestimmte Hardware-Designs optimiert oder entsprechen Programmierparadigmen, die auf die damalige Technik zugeschnitten waren. Das bedeutet, dass beispielsweise streng sequenzielle Algorithmen, die keine Parallelverarbeitung unterstützen, von mehreren Prozessorkernen wenig bis gar nicht profitieren.

Parallelisierung ist ein Schlüsselthema moderner Hardwareoptimierung. Während CPUs heute häufig aus mehreren Kernen bestehen, mit denen verschiedene Rechenaufgaben gleichzeitig abgearbeitet werden können, sind viele ältere Programme so geschrieben, dass sie nur einen einzigen Kern nutzen. Selbst wenn ein neuer Computer zig Kerne besitzt, bleibt die Leistungsfähigkeit eines Programms, das nicht für Parallelität konzipiert wurde, auf einen Kern beschränkt. Somit kann die theoretische Leistungssteigerung durch Multi-Core-Prozessoren in diesem Fall kaum realisiert werden. Darüber hinaus beeinflussen auch die Speichersysteme die Performance älterer Software.

Neue CPUs verfügen zwar über schnellere Caches und verbesserte Speicherzugriffe, aber wenn der Code schlecht für die Cache-Architektur optimiert ist oder ineffiziente Speicherzugriffe durchführt, werden diese Verbesserungen nicht gut ausgenutzt. Alte Programme, die nicht auf moderne Speicherhierarchien abgestimmt sind, leiden deshalb weiterhin unter Speicherlatenzen und Bandbreitenlimitierungen. Ein weiterer Aspekt ist die Optimierung durch den Compiler. Frühere Compiler waren oft weniger intelligent und bezogen sich auf damalige Prozessorarchitekturen. Heutige Compiler bieten ausgefeilte Optimierungstechniken, die moderne Instruktionssätze und Architekturmerkmale ausnutzen.

Wenn jedoch ein altes Programm nicht neu kompiliert oder umgeschrieben wird, bleiben diese Vorteile ungenutzt. Alte Binärdateien verlieren dadurch die Chance, durch fortschrittliche Compileroptimierungen beschleunigt zu werden. Moderne Prozessoren bieten auch verbesserte Instruktionssätze, sogenannte Erweiterungen, die bestimmte Operationen in wenigen Takten ausführen können. Programme müssen diese Erweiterungen jedoch explizit unterstützen, um davon zu profitieren. Älterer Code zeigt oft keine dieser Erweiterungen, weil diese zur Entstehungszeit schlicht nicht existierten.

Das führt dazu, dass neue CPUs nicht ihr volles Potenzial entfalten können, wenn alte Programme darauf laufen. Auch der Einfluss von Betriebssystemen und Laufzeitumgebungen ist nicht zu unterschätzen. Veraltete Software kann systemnahe Aufrufe tätigen, die heute als ineffizient gelten oder sich geändert haben – etwa bei der Speicherverwaltung oder Multithreading-Modellen. Ohne Anpassung an aktuelle Betriebssystemarchitektur kann die Performance trotz schnellerer Hardware stagnieren. In der Praxis bedeutet das, wenn man auf neuer Hardware ausschließlich alte Software verwendet, sind die Geschwindigkeitsverbesserungen oft marginal oder gar nicht vorhanden.

Neue Maschinen passen ihre Architektur an moderne Softwareanforderungen an und setzen auf Technologien, die älteren Programmen verborgen bleiben. Entwickler und Unternehmen sollten sich deshalb darüber bewusst sein, dass nur die Überarbeitung und Optimierung von Code den Leistungsgewinn durch neue Hardware tatsächlich ermögliche. Die Lösung liegt oft in der Kombination aus Softwaremodernisierung und Hardwareentwicklung. Das bedeutet, dass Entwickler bestehende Anwendungen auf Multi-Core-Architektur optimieren, moderne Parallelisierungsansätze implementieren und den Code für aktuelle Compiler und Prozessorinstruktionen anpassen müssen. Durch diesen Aufwand kann die Hardware mehr zum Tragen kommen und die Effizienz gesteigert werden.

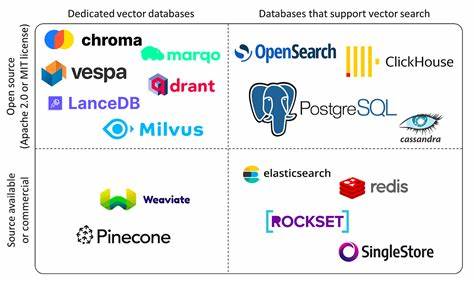

Zusätzlich spielen Frameworks und Bibliotheken eine Rolle. Ältere Programme verwenden oft Legacy-Bibliotheken, die ebenfalls nicht für moderne Hardware optimiert sind. Durch den Austausch oder die Aktualisierung dieser Komponenten lassen sich Performancevorteile erschließen. Es lohnt sich also, den gesamten Software-Stack zu überprüfen, wenn man eine signifikante Beschleunigung auf neuer Hardware erreichen möchte. Abschließend lässt sich festhalten, dass die vermeintlich einfache Rechnung „neue Hardware = schnellere Software“ nicht zutrifft.

Die Realität ist deutlich komplexer und verlangt einen bewussten Umgang mit Softwarearchitektur, Optimierungsmethoden und modernen Entwicklungspraktiken. Unternehmen, die den Weg der Softwaremodernisierung gehen, profitieren langfristig von den Investitionen in neueste Hardware und sichern sich wettbewerbsfähige Leistungsfähigkeit. Ein Video, das diese Problematik anschaulich darstellt, verdeutlicht anschaulich, wie neue Computer alte Programme nicht automatisch beschleunigen und welche Konsequenzen das für Entwickler und Nutzer hat. Es unterstreicht die Bedeutung, sich aktiv mit der Anpassung und Neuentwicklung von Software an beliebte Hardwaretrends auseinanderzusetzen. In einer Ära, in der Effizienz und Geschwindigkeit eine immer größere Rolle spielen, ist es essenziell, Software als lebendigen Prozess zu verstehen, der kontinuierlich weiterentwickelt werden muss, um mit dem Fortschritt der Hardware Schritt zu halten.

Nur so können die enormen Ressourcen moderner Computer wirklich ausgeschöpft und genutzt werden, anstatt ungenutzt zu verfallen. Neue Computer bieten eine enorme Chance – doch ohne angepasstes und modernes Programmieren bleibt diese Chance oft ungenutzt.

![New computers don't speed up old code [video]](/images/9CFB9055-4ED3-42CA-B8DC-D10F7B7A6E8B)