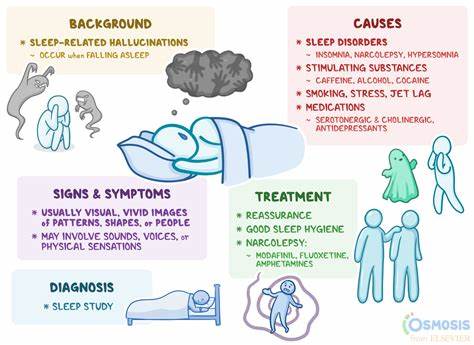

In der heutigen Zeit, in der Künstliche Intelligenz und insbesondere Large Language Models (LLMs) immer mehr in den Arbeitsalltag integriert werden, gewinnt das Thema „Halluzinationen“ zunehmend an Bedeutung. Halluzinationen, wie sie in der KI beschrieben werden, beziehen sich auf Situationen, in denen Modelle überzeugt falsche Informationen liefern oder schlichtweg „Fantasien“ erstellen. Doch erstaunlicherweise gibt es bemerkenswerte Parallelen zwischen solchen Fehlerquellen bei KI-Systemen und den Denkfehlern, die auch bei Menschen im Berufsalltag auftreten. Beide Systeme – menschliche Teams und KI – sind von den Rahmenbedingungen, Kontexten und vor allem kommunikativen Strukturen abhängig, die ihr Verhalten maßgeblich prägen. Um die Herausforderungen gemeinsamer Zusammenarbeit von Mensch und Maschine bestmöglich zu meistern, lohnt sich deshalb ein Blick auf die systemischen Ursachen menschlicher „Halluzinationen“ und wie man sie vermeiden kann.

Ein Beispiel, das dies verdeutlicht, ist der fiktive Fall einer Führungskraft namens Alice, die in einem aufstrebenden Social-Media-Unternehmen arbeitet und vor der schwierigen Aufgabe steht, ihr Team effizient zu organisieren und Fehlerquellen zu minimieren, ohne sich selbst zu überlasten. Alice stellt drei Mitarbeitende ein: Bob, Marketing-Analyst, Charlie, Softwareentwickler, und Dave, Recruiter. Alle drei sind talentiert, doch treten bei jedem von ihnen typische Fehler auf, die den sogenannten Halluzinationen bei LLMs sehr ähnlich sind. Bei Bob zeigt sich eine „Phantom-Wachstumskurve“, die auf widersprüchlichen und ungesicherten Datenquellen beruht. Er gerät in die Falle, nur scheinbar offizielle Daten zu verwenden, ohne die Qualität oder Aktualität ausreichend zu prüfen.

Zudem ahnt er nicht, dass unterschiedliche Teams im Unternehmen denselben Begriff „Activation“ unterschiedlich nutzen. Hier scheitert die Kommunikation und Kontextklärung, was Alice durch klare Datenquellenkennzeichnung, Einführung von Signalhierarchien und eine Glossar-basierte Sprachsicherheit behebt. Charlie erlebt einen „Gedanken-Einschränkungs-Halluzination“ in Form eines überstürzten Quick-Fixes an kritischem Code, der ohne ausreichend Planung, Validierung und Alternativüberlegungen zu einem Deadlock in der Anwendung führt. Die Ursache liegt in Zeitdruck, mangelndem Dokumentationsaufwand und oberflächlichen Prüfungen. Alice kontert hier mit der Einführung von Design-Dokumenten vor Änderungen, Selbstvalidierungsritualen und ermuntert das Team zum explorativen Denken im Vorfeld.

Dave hingegen stolpert über eine „Ambiguitäts-Halluzination“, da ihm vertraute Rahmenbedingungen und klare Zieldefinitionen fehlen. Eine vage Zielsetzung und das Festhalten an veralteten Vorlagen führen dazu, dass er Kandidaten sucht, die nicht den aktuellen Bedürfnissen entsprechen, was das gesamte Einstellungsverfahren verwässert. Alice reagiert mit einem klaren „Scope-Charter“, einem Kollaborationsplan und eindeutigen Akzeptanzkriterien für jede Rolle. Dieser Fall illustriert exemplarisch, dass bei Menschen, ähnlich wie bei KI-Systemen, Fehler häufig weniger an individueller Unfähigkeit sondern viel mehr an unklaren Rahmenbedingungen, mangelhafter Kommunikation und fehlender Prozessstruktur hängen. Die Lösungen sind dementsprechend systeminhärent und entziehen den menschlichen Akteuren die alleinige Verantwortung für Misserfolge.

Stattdessen setzt Alice auf klare Informationshierarchien, präzise Dokumentationen und etablierte Kommunikationsprotokolle, die den Kontext transparent machen und definierte Schnittstellen schaffen. Spannend wird es, wenn man diese Erkenntnisse auf den Umgang mit KI überträgt. Die Tatsache, dass KI-Modelle inhaltlich fehlerhafte Antworten geben, liegt oft nicht an deren inhärenter „Dummheit“, sondern daran, dass die Eingaben zu ungenau oder widersprüchlich sind, oder dass die Modelle in ihrem Denkprozess durch mangelnden Kontext oder begrenzte Rechenressourcen eingeschränkt werden. Der sogenannte „Law of Relative Intelligence“ beschreibt dabei allgemein, dass intelligente Systeme – egal ob menschlich oder maschinell – tendenziell dann falsche Antworten liefern, wenn Eingaben unscharf, widersprüchlich oder unvollständig sind, wenn das verfügbare Denkvermögen begrenzt ist und wenn Belohnungen eher aus der Ausgabe selbst als aus deren Richtigkeit resultieren. Daher gibt es eigentlich kein Patentrezept zum „Lösen“ von Halluzinationen, sondern man muss die Rahmenbedingungen so gestalten, dass die Wahrscheinlichkeit von Fehlern sinkt, sei es bei Menschen oder Maschinen.

In der Praxis bedeutet dies für Unternehmen, klare Anweisungen und Rahmenkonzepte zu etablieren und sowohl bei Mitarbeitenden als auch bei KI-Systemen kontinuierlich den Informationskontext zu aktualisieren, zu hinterfragen und transparent zu kommunizieren. Die fehlende kontinuierliche Lernfähigkeit der meisten LLMs erfordert vom Menschen eine ergänzende Rolle als aktiver Kontextgenerator. Sie müssen Fehler, Unklarheiten und unvollständige Daten identifizieren und gezielt in Folgeinteraktionen korrigieren. Gleichzeitig sollte die Implementierung von Rückzugsklauseln und Back-out-Mechanismen erlaubt sein, dass bei auftretenden Problemen proaktiv eine Pause eingelegt und nachjustiert wird. Ein weiterer wichtiger Faktor ist die Kalibrierung von Modellen auf Basis klarer sprachlicher Aufforderungen („prompts“), die nicht nur beschreiben, was getan werden soll, sondern auch explizit was zu vermeiden ist.

So wird verhindert, dass KI einfach nur blind Befehle ausführt, die missverständlich oder sogar widersinnig sind. Die Vertrauenswürdigkeit einer KI-Lösung hat also stark mit deren Transparenz zu tun. Wenn Nutzer verstehen, welche Informationen das Modell steuern und wie aktuell und valide diese sind, wächst das Vertrauen und die Kooperationsfähigkeit. Auch menschliche Führungskräfte profitieren davon, ihre Teams bewusst als komplexe Systeme zu betrachten und Fehler als Symptome systemischer Schwächen zu erkennen statt als individuelle Versagen. Indem Kernelemente wie klare Rollenzuweisung, Kommunikationsregeln und Dokumentation etabliert werden, können Fehlerquoten drastisch gesenkt und Produktivität sowie Zufriedenheit langfristig gesteigert werden.

Zusammenfassend lässt sich sagen, dass das „Stoppen menschlicher Halluzinationen“ weit mehr ist als nur ein individuelles Problem. Es erfordert systemisches Denken, proaktive Prozessgestaltung und eine Kultur der Kommunikation und Transparenz. Ob im Umgang mit Menschen oder KI – wer die Rahmenbedingungen schafft, in denen Kontext klar, Erwartungen verständlich und Lernzyklen kurz sind, erlebt weniger Fehler und damit nachhaltigen Erfolg. Für die Zukunft gilt es, Mensch und Maschine nicht als Konkurrenten sondern als interdependente Partner zu begreifen, die sich gegenseitig in ihren Stärken ergänzen und Schwächen abfedern. Eine Leistungssteigerung ist vor allem durch das Zusammenspiel aus gut strukturierten Menschenprozessen und technologischen Innovationen möglich.

Letztendlich liegt der Schlüssel darin, mit Empathie und klarem Systemverständnis Fehlerquellen frühzeitig zu erkennen, sie durch smarte Prozessoptimierungen zu reduzieren und so eine produktive und belastbare Arbeitsumgebung zu schaffen – in der Menschen effizient und KI-Systeme sinnvoll zusammenarbeiten.

![I tested every EU alternative to US digital products (ditching Big Tech) [video]](/images/E30A7E45-17EF-45AE-82C0-DBAF1A412949)