Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat viele Bereiche der Wissenschaft und Technik revolutioniert, so auch die Chemie. In den letzten Jahren konnten diese Modelle, die anhand riesiger Textmengen trainiert werden, zunehmend Aufgaben lösen, für die sie nicht explizit programmiert wurden. Dies beinhaltet unter anderem das Verstehen und Beantworten chemischer Fragestellungen, die Generierung von Syntheseplänen und die Vorhersage chemischer Eigenschaften. Doch wie verhalten sich diese KI-Systeme im Vergleich zu der fundierten Expertise von menschlichen Chemikern? Eine aktuelle Studie nutzt ein speziell dafür entwickeltes Benchmark-Framework namens ChemBench, um die Fähigkeiten dieser LLMs systematisch zu evaluieren und mit denen von professionellen Chemikern zu vergleichen. ChemBench repräsentiert eine neue Qualität im Testen chemischer Kompetenz von KI.

Es umfasst über 2.700 Frage-Antwort-Paare, die aus verschiedenen Quellen stammen, darunter handverfasste Prüfungsfragen und semi-automatisiert generierte Aufgaben. Diese Fragen decken eine breite Palette chemischer Teilgebiete ab – von der allgemeinen und anorganischen Chemie über technische und analytische Chemie bis hin zu sicherheitsrelevanten Themen. Dabei werden unterschiedliche Fähigkeiten wie reines Faktenwissen, logisches Schlussfolgern, mathematische Berechnungen und chemische Intuition abgefragt. Die Studie ermöglicht so eine ganzheitliche Bewertung der Fähigkeiten und begrenzt dabei nicht nur auf Multiple-Choice Fragen, sondern verwendet auch offene Antwortformate.

Zur Transparenz und Vergleichbarkeit wurde ein Teil der ChemBench-Aufgaben auch menschlichen Chemieexperten vorgelegt. Etwa 19 Fachleute mit unterschiedlichem Ausbildungshintergrund beantworteten diese Fragen unter realistischen Bedingungen, teils mit Zugriff auf externe Hilfsmittel wie Websuche oder Chemiezeichenprogramme. Die Ergebnisse zeigen auf faszinierende Weise, dass die besten der getesteten LLMs, wie beispielsweise das Modell o1-preview, in der Gesamtauswertung die menschlichen Experten hinsichtlich der korrekten Antworten übertreffen konnten. Damit verschiebt sich die Perspektive darauf, welche Rolle KI-gestützte Systeme zukünftig in der chemischen Forschung spielen könnten. Nichtsdestotrotz offenbaren die Analyse und der Vergleich eine Reihe von Schwächen bei den Maschinen.

Gerade bei basalem Chemiewissen, das ein exaktes Faktenverständnis verlangt, konnten die Modelle teilweise nicht überzeugen. Beispielsweise blieben Fragen zur Strukturaufklärung in der analytischen Chemie eine Herausforderung, insbesondere wenn diese das tiefgreifende Verständnis molekularer Symmetrien und Isomerie erfordern. Dies resultiert häufig daraus, dass die LLMs komplexe chemische Strukturen lediglich als textuelle Notationen in Form von SMILES-Codes erhalten und keine wirklich graphenbasierte molekulare Repräsentation oder dreidimensionale Perspektive mit einbeziehen können. Ein weiteres bedeutendes Thema ist die Fähigkeit der Modelle, ihre eigenen Grenzen zu erkennen. Die Modelle sollen idealerweise einschätzen können, wie sicher ihre Antwort ist, um Fehlinformationen zu minimieren.

Studien zeigen jedoch, dass die verbalen Selbstbewertungen der LLMs oft nicht gut kalibriert sind. Manche Modelle geben in schwierigen Fällen eine hohe Sicherheit an, was im realen Einsatz besonders bei sicherheitsrelevanten Aspekten problematisch sein kann. Dies erfordert innovative Ansätze zur besseren Unsicherheitsmodellierung und zur Integration spezieller Sicherheitsschichten in die Systeme. Die Auswertung der Performance über verschiedene chemische Themenbereiche hinweg zeigt zudem eine unterschiedliche Leistungsfähigkeit. Während allgemeine und technische Chemie oft gut gemeistert werden, schneiden die Modelle bei Fragen zu Toxizität, chemischer Sicherheit oder der Interpretation von experimentellen Daten schlechter ab.

Dies verdeutlicht die Notwendigkeit, Trainingsdaten und Modelle gezielt mit spezialisierten Datensätzen aufzuwerten oder externe Fachdatenbanken in die Auswertung einzubinden. Auch zeigt sich, dass die Größe des Modells grundsätzlich mit der Leistungssteigerung korreliert, was auf weiteres Potential durch Skalierung hindeutet. Neben den rein fachlichen Aspekten werfen die Studie und das ChemBench-Framework auch entscheidende Fragen zur Zukunft von Chemieausbildung und Wissensvermittlung auf. Das traditionelle Lernen durch Auswendiglernen oder das Lösen standardisierter Prüfungsfragen ist offenbar eine Domäne, in der LLMs Menschen bereits heute weit übertreffen. Zukünftig wird daher mehr Wert auf kritisches Denken, kreatives Problemlösen und die Interpretation komplexer experimenteller Sachverhalte gelegt werden müssen.

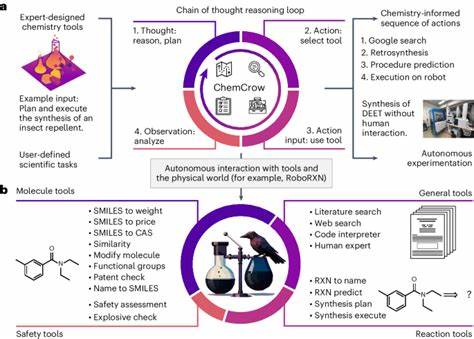

KI-Systeme könnten so als Copiloten fungieren, die Routineaufgaben übernehmen und Wissenschaftler entlasten – die Menschen entwickeln dabei ihre Fähigkeiten in höherwertigen Bereichen weiter. Im breiteren Kontext bringen die neuen Technologien sowohl Chancen als auch Risiken mit sich. Einerseits können Automatisierung und intelligente Assistenz die Forschung beschleunigen, neue Hypothesen generieren und innovative Werkzeuge für die Entwicklung neuer Materialien oder Medikamente bereitstellen. Andererseits muss sorgfältig kontrolliert werden, dass die Systeme nicht für schädliche Anwendungen missbraucht werden, etwa bei der Entwicklung toxischer Substanzen. Die offene Nutzung durch Laien oder Studierende stellt eine weitere Herausforderung dar, wenn sie auf unsichere oder fehlerhafte Informationen zugreifen.

Vor diesem Hintergrund ist ChemBench weit mehr als nur ein Testinstrument. Es stellt eine Referenzbasis für die Entwicklung zukünftiger LLMs dar, die explizit auf chemisches Wissen und wissenschaftliches Denken ausgerichtet sind. Die Möglichkeit, Modelle systematisch und transparent zu bewerten, fördert die gezielte Verbesserung, Vergleichbarkeit und letztlich die sichere Integration der KI-Technologien in Forschung und Lehre. Die offene Bereitstellung von Daten und Code unterstreicht den kollaborativen Charakter dieses Fortschritts. Zusammenfassend lässt sich sagen, dass große Sprachmodelle im Bereich der Chemie heute bereits beachtliche Leistungen erzielen und in bestimmten Aspekten sogar menschliche Experten übertreffen können.

Gleichzeitig zeigen sich klare Grenzen vor allem im Bereich struktureller Chemie, tiefgehender Modellierung und der verlässlichen Selbsteinschätzung. Die Kombination von KI und menschlicher Expertise bietet enormes Potenzial, erfordert aber auch neue Ansätze in der Ausbildung von Chemikerinnen und Chemikern, um die Stärken beider Seiten zu nutzen und Risiken zu minimieren. Die fortwährende Entwicklung und Evaluation mittels Rahmenwerken wie ChemBench ist ein zentraler Baustein auf diesem Weg in eine digital unterstützte Zukunft der chemischen Wissenschaften.