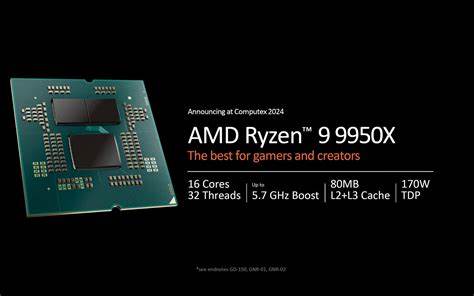

Die Verarbeitung großer CSV-Dateien stellt in zahlreichen Branchen eine essenzielle Herausforderung dar. Datenanalysen, Machine Learning Anwendungen und andere datenintensive Systeme sind oft darauf angewiesen, möglichst schnell und effizient große Datenmengen zu strukturieren und zugänglich zu machen. Dabei spielt die Schnelligkeit des Parsings eine entscheidende Rolle – insbesondere dann, wenn es um Echtzeitanalysen oder umfangreiche Batch-Prozesse geht. Die Kombination aus moderner Hardware und ausgeklügelten Softwareverfahren eröffnet neue Horizonte für Entwickler und Datenwissenschaftler. Im Fokus dieser Entwicklung steht die kürzliche Durchbruchleistung eines CSV-Parsers, der in der Lage ist, auf dem AMD Ryzen 9 9950X beeindruckende 21 GB Daten pro Sekunde zu verarbeiten.

Dieses Resultat markiert nicht nur einen Meilenstein für die Verarbeitungsgeschwindigkeit, sondern verdeutlicht auch, wie tiefgehende Hardwarespezifikationen genutzt werden können, um Softwarekomponenten zu optimieren und somit die gesamte Datenpipeline zu beschleunigen. Auf Basis von SIMD-Optimierungen (Single Instruction, Multiple Data) und der Nutzung der erweiterten AVX-512-Befehlssätze zeigt der neueste Stand der Technik auf, wie sich parallele Datenverarbeitung auf niedrigster Ebene fruchtbar machen lässt. SIMD ist eine zentrale Technologie, die es ermöglicht, mehrere Datenpunkte gleichzeitig zu verarbeiten und somit die Effizienz von Algorithmen enorm zu steigern. In der Praxis heißt das, dass anstelle von seriellen Vergleichen oder Operationen auf einzelnen Byte-Einheiten große Datenblöcke in einem Durchgang geprüft und bearbeitet werden können. Gerade bei strukturierten Textformaten wie CSV, die häufig spezielle Trennzeichen und Zeilenumbrüche enthalten, bietet SIMD eine strategische Möglichkeit, durch Mustervergleich und Bitmasken auf Vektorregistern relevante Stellen im Datenstrom blitzschnell zu identifizieren.

Schlüssel zum Erfolg ist dabei nicht nur die rohe Leistung der CPU, sondern auch der JIT-Compiler im Rahmen von .NET 9.0, der den Maschinencode generiert. Im vorliegenden Fall hat sich gezeigt, dass die Standard-Maschinenbefehle für AVX-512-Operationen suboptimal erzeugt wurden, insbesondere durch ineffiziente Nutzung der Maskenregister. Das Entwicklerteam hat diese Problematik analysiert und durch geschickte Codeumstellungen und algorithmische Verbesserungen die Leistung weiter gesteigert.

Insbesondere durch das frühzeitige Anwenden von MoveMask-Instruktionen und das Umgehen häufigen Wechsels zwischen Masken- und normalen Registern konnte die Anzahl der Maschinenbefehle signifikant reduziert werden. Ein weiterer bedeutender Schritt war die Entwicklung eines neuen Parsers, der einen hybriden Ansatz verfolgt: Er lädt Daten mit 512-Bit-Operationen, wandelt sie jedoch mittels AVX-512-Instruktionen in 256-Bit-Byte-Vektoren mit Sättigung um. Diese Technik eliminiert die bisherigen Performance-Einbrüche, die durch das Maskenregistermanagement entstanden sind, und bringt die Parsing-Geschwindigkeit auf 21 GB/s, was eine deutliche Steigerung gegenüber vorangegangenen Versionen darstellt. Derartige Fortschritte werden neben dem Software-Tuning auch durch fortschrittliche Hardware-Funktionen ermöglicht. Der AMD Ryzen 9 9950X basiert auf der Zen 5-Architektur und bringt als einer der ersten Desktop-Prozessoren AVX-512-Unterstützung mit.

Darüber hinaus profitiert er von einer höheren Boost-Taktfrequenz von bis zu 5,7 GHz im Vergleich zum Vorgänger 5950X mit Zen 3 und 4,9 GHz. Diese Kombination aus fortschrittlichen SIMD-Befehlssätzen und hohen Taktraten führt zu einem beschleunigten Datenfluss, der sich direkt in den Benchmarks widerspiegelt. Die Entwicklung des Sep CSV-Parsers seit seiner ersten Version im Jahr 2023 illustriert eindrucksvoll, wie Software und Hardware-Hand in Hand gehen, um immer neue Performancelevels zu erreichen. Mit einer anfangs langsamen Geschwindigkeit von rund 7 GB/s auf einem 5950X und .NET 7.

0, kletterte die Leistung durch gezielte Optimierungen, Framework-Updates auf .NET 9.0 und Umstieg auf den 9950X auf bis zu 21 GB/s. Dies zeigt eine fast dreifache Beschleunigung innerhalb von weniger als zwei Jahren und verdeutlicht den Innovationsdruck und Fortschrittswillen in der Softwareentwicklung für performante Datenverarbeitung. Auch die Vergleichsmessungen zwischen unterschiedlichen SIMD-Instruktursätzen sind faszinierend.

Obwohl AVX-512 technisch leistungsfähiger als AVX2 ist und breitere Register verwendet, konnte anfänglich ein AVX2-basierter Parser auf dem 9950X sogar bessere Ergebnisse erzielen. Dies lag vor allem an der suboptimalen Maskenregisterbehandlung und überflüssigen Registrenumwandlungen in der AVX-512-Implementierung. Der neue hybride Ansatz umgeht diese Fallstricke elegant, bündelt die Vorteile beider Technologien und erreicht so die bislang schnellste Parsing-Leistung. Dabei wurden auch die Struktur und der Aufbau der Parsing-Methoden überarbeitet. Die zentrale Parse-Funktion ist generisch angelegt und wird durch starke Inlining-Hinweise an den Compiler übergeben, um Laufzeit-Overhead zu minimieren.

Die Verarbeitung erfolgt dabei auf signifikanten, aber Cache-freundlichen Datenblöcken von rund 16 KB. Innerhalb dieser Blöcke werden die Zeichen parallel mit SIMD-Registern geladen, in passende Formate gepackt und dann mittels byte-weiser Vergleiche gegen relevante Trennzeichen geprüft. Aus den Vergleichsergebnissen generieren Bitmasken schnell Indizes für spezielle Zeichen, welche dann sequenziell nachverarbeitet werden. Dieses Muster hat sich als besonders effizient erwiesen und lässt sich optimal auf die SIMD-Fähigkeiten der CPU anpassen. Neben der reinen Geschwindigkeit zeigen die Benchmarks auch die praktische Wirkung der Multi-Threading-Funktionalität des Parsers.

Während die Low-Level-Einzelthread-Performance bereits beeindruckend ist, kann die parallele Verarbeitung auf einem Multi-Core-System weitere Beschleunigungen erzielen. Ein Beispiel zeigt, dass beim Parsen von einer Million Zeilen im Multi-Threading-Modus das Ergebnis auf nur 72 Millisekunden auf dem 9950X gesunken ist, was eine effektive Datenrate von rund 8 GB/s darstellt. Das verdeutlicht, dass Sep nicht nur synthetische Bestleistungen anstrebt, sondern auch in realistischen Szenarien bemerkenswerte Effizienz liefert. Besonders hervorzuheben ist zudem die plattformübergreifende Flexibilität. Während spezielle SIMD-Instruktursätze wie AVX-512 nur auf neuesten CPUs verfügbar sind, bietet Sep auch optimierte Alternativen für AVX2, SSE2 und cross-plattformfähige Vector128 sowie Vector256 Versionen.

Dadurch gewährleistet der Parser eine hohe Leistung auf verschiedenen Geräten und Architekturen und ist nicht auf eine einzige Hardware-Generation beschränkt. Die Vielzahl der verfügbaren Parser-Varianten wird mittels einer Umgebungsvariablen konfiguriert, die eine gezielte Auswahl und den Vergleich verschiedener Implementierungen während der Entwicklung oder im produktiven Einsatz erlaubt. Ein weiterer Aspekt ist die Speichereffizienz des Parsers. Trotz extrem hoher Durchsatzraten bleibt der Speicherverbrauch niedrig und kontrolliert, was besonders in Szenarien mit begrenzten Ressourcen oder hohem Datenaufkommen von Bedeutung ist. Vergleichsweise zum Einsatz anderer populärer CSV-Bibliotheken wie CsvHelper oder ReadLine_ zeigt Sep nicht nur eine massive Geschwindigkeitssteigerung, sondern gleichzeitig eine geringere Speicherallokation.

Die Beschleunigung bei der CSV-Verarbeitung hat weitreichende Implikationen für die Praxis. Dateningenieure können große Dateien schneller importieren, ETL-Prozesse effizienter gestalten und auch Echtzeit-Analysen mit minimalen Latenzzeiten ermöglichen. Machine Learning Pipelines profitieren von der schnellen Vorverarbeitung, während Entwickler von einer schlanken API und moderner .NET Integration profitieren. Der steigende Bedarf an performanter Datenaufbereitung ist ungebrochen.

In Zeiten exponentiell wachsender Datenmengen und komplexerer Modelle wird jede Millisekunde bei der Datenvorbereitung wertvoll. Lösungen wie der optimierte Sep Parser in Kombination mit neuester Hardware zeigen, wie die Grenzen des Machbaren verschoben werden können. AMDs Zen 5 Architektur setzt hier als Hardwarebasis neue Maßstäbe hinsichtlich Energieeffizienz, Taktfrequenz und SIMD-Fähigkeiten. Die Softwareseite liefert mit gezielten JIT-Optimierungen und algorithmischer Finesse die dazu passende Ergänzung. Insgesamt demonstriert die Entwicklung rund um den Sep Parser und den AMD Ryzen 9 9950X eindrucksvoll, dass die Symbiose aus Hard- und Softwareoptimierung essenziell für die Performance von datenintensiven Aufgaben ist.

Wer heute große CSV-Dateien verarbeitet, sollte nicht nur auf rohe Hardware setzen, sondern auch auf modernste SIMD-Techniken und intelligente Parser-Architekturen. Der Schritt zu 21 GB/s Parsing-Geschwindigkeit markiert eine neue Ära der Datenverarbeitung, in der Software und Hardware effizient verschmelzen. Zugleich bleibt es spannend, wie zukünftige Hardwaregenerationen und Weiterentwicklungen im .NET JIT-Compiler diesen Trend weiter vorantreiben. Die kontinuierliche Verbesserung und das tiefe Verständnis über die zugrundeliegenden AVX-Befehle, Maskenregister und deren Umwandlung führen unweigerlich zu noch schnelleren, ressourcenschonenderen Lösungen.

Für Entwickler und Datenprofis bieten diese Fortschritte die Möglichkeit, Anwendungen auf das nächste Level zu heben, ohne auf proprietäre oder komplexe Spezialhardware zurückgreifen zu müssen. Abschließend betrachtet ist die Kombination aus AMD 9950X Prozessor, AVX-512 optimiertem Parsing unter .NET 9.0 und raffinierter Codearchitektur bei Sep ein Paradebeispiel dafür, wie technische Innovationen heute performante Datenanwendungen ermöglichen. CSV Parsing mit 21 GB pro Sekunde ist keine Vision mehr, sondern greifbare Realität.

Die Zukunft der schnellen Datenverarbeitung gehört der intelligenten Nutzung von SIMD-Technologien, hybriden Hardwareansätzen und softwareseitiger Präzision – wie es Sep eindrucksvoll unter Beweis stellt.