In einer Welt, in der Datenmengen exponentiell wachsen und Anwendungen immer schneller reagieren müssen, steigt die Bedeutung von Low-Latency-Speicherlösungen für Datenbanken kontinuierlich. Besonders bei der Arbeit mit Transaktionsprotokollen, sogenannten Write-Ahead-Logs (WAL), kann die Latenz der Schreiboperationen ein entscheidender Flaschenhals sein. Hier setzt das von der PostgreSQL-Datenbank bereitgestellte Tool pg_test_fsync an, das eine schnelle und präzise Messung der Schreiblatenz auf einem Datenträger ermöglicht. Es hilft, geeignete Speichermedien für Datenbank-Workloads zu evaluieren – dabei ist es egal, ob die Datenbank selbst PostgreSQL ist oder ein anderes System, denn die Ergebnisse sind universell aussagekräftig für alle Anwendungen mit hohem Schreibanspruch. Das Tool ist Teil der Standard-Postgres-Installation, sodass keine zusätzliche Softwareinstallation notwendig ist.

Es testet die Geschwindigkeit verschiedener Methoden, Daten physisch auf die Festplatte zu schreiben und synchron zu speichern. Diese Methoden reichen von klassischen fsync-Aufrufen über fdatasync bis hin zu modernen Ansätzen wie open_datasync oder open_sync. Dabei wird jeweils gemessen, wie viele Schreibvorgänge pro Sekunde möglich sind und wie lange ein einzelner Schreibvorgang im Durchschnitt dauert. Die Grundlage eines sinnvollen Tests ist natürlich ein geeigneter Datenträger. Im technischen Umfeld etablieren sich NVMe-SSDs mit unterschiedlicher Ausstattung und Leistungsfähigkeit als bevorzugte Speichermedien.

Dabei gibt es erhebliche Unterschiede zwischen Consumer-SSDs und Enterprise-Lösungen. Consumer-SSDs etwa weisen häufig keine DRAM-gestützte Cache-Struktur mit Power-Loss-Protection (PLP) auf, was die Latenz für synchrone Schreiboperationen deutlich erhöht. Enterprise-SSDs hingegen besitzen in der Regel solche Schutz- und Beschleunigungsmechanismen, wodurch synchrone Writes oft in wenigen Mikrosekunden bestätigt werden können. Wer eine Linux-Umgebung betreibt, kann schnell prüfen, welches Gerät welche Eigenschaften besitzt, zum Beispiel mit Tools wie lsds oder über Standardbefehle. Die Ausgabe zeigt wichtige Aspekte wie Schreibcache, Festplattenmodell, Command-Queue-Tiefe und vor allem die hardwareseitige Sicherung des Schreibcaches.

Diese Informationen helfen, das Verhalten der Hardware im Sinne von erwartbaren Schreiblatenzen besser abzuschätzen. Ein typischer Prüfvorgang mit pg_test_fsync startet im gewünschten Verzeichnis des Mountpoints und analysiert verschiedene Schreib-Synchronisationsmethoden anhand einer 8 Kilobyte großen Datei. Dabei zeigt sich häufig, dass fdatasync schneller arbeitet als fsync oder Versionen mit O_SYNC, weil es auf unnötige Journal-Operationen verzichten kann. Dennoch liegen die gemessenen Latenzen bei Consumer-SSDs für einzelne Schreibvorgänge oft im Bereich von mehreren Millisekunden – viel zu hoch für hochfrequente Transaktionssysteme. Richtig spannend wird es, wenn das gleiche Testverfahren auf eine Enterprise-SSD angewandt wird, die über PLP-geschützten Schreibcache verfügt.

Die Ergebnisse bringen dann überraschend niedrige Latenzen zu Tage – häufig im Bereich von einigen Dutzend Mikrosekunden pro Schreibvorgang. Diese niedrigen Latenzen sind ein Indiz dafür, dass die Hardware ideal für Datenbank-Workloads geeignet ist, wo schnelle, synchrone Logging-Operationen unabdingbar sind. Interessant ist auch die Analyse, wie sich die Schreiblatenz bei verschiedenen Schreibgrößen verhält. Das Tool zeigt, dass große Schreibblöcke oder das Zusammenfassen mehrerer kleiner Schreibvorgänge die Gesamtlatenz deutlich reduzieren kann. Im Gegensatz dazu kann das mehrfache Schreiben kleiner Blöcke in synchroner Art und Weise die SSD regelrecht überfordern und zu erheblichen Verzögerungen führen.

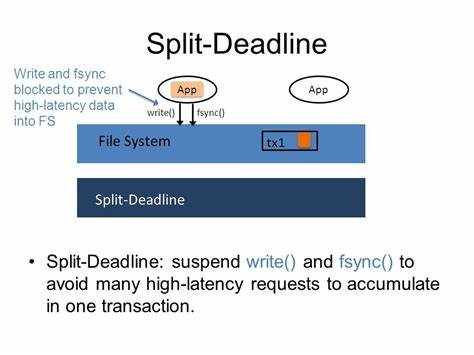

Moderne Systeme profitieren daher von Strategien, die die Schreiblast auf geeignete Weise im Arbeitsspeicher puffern und dann in größeren Blöcken synchronisieren. Ein weiterer Aspekt, den pg_test_fsync beleuchtet, ist die Frage, ob fsync auf einem Dateideskriptor auch das Synchronisieren von Daten abdeckt, die über einen anderen Deskriptor geschrieben wurden. Das Verhalten kann je nach Dateisystem oder Betriebssystemvarianten variieren, wird aber für ein konsistentes Datenbanksystem empfohlen. Im Idealfall sind die Latenzwerte für beide Varianten sehr ähnlich, was auf eine zuverlässige Synchronisierung hinweist. Die Ergebnisse eines solchen Tests erlauben es, gezielt fundierte Entscheidungen für den Betrieb von Datenbanken zu treffen.

Egal, ob eine lokale SSD, ein SAN oder cloudbasierte Blockspeicherlösungen zum Einsatz kommen, die gemessene Schreiblatenz gibt verlässliche Hinweise darauf, welche Hardware in der Lage sein wird, die gewünschte Performance zu erbringen. Dabei empfehlen sich Enterprise-SSDs mit integrierter Power-Loss-Protection als Standard für Transaktions- und Logging-Daten, während Consumer-Geräte eher für weniger latenzkritische Daten geeignet sind. Das Testen mit pg_test_fsync kostet nur wenig Zeit und erfordert keine komplexe Einrichtung. Die klare und verständliche Ausgabe macht es Systemadministratoren, Datenbank-Architekten und Performance-Experten leicht, eine objektive Bewertung der zugrundeliegenden Storage-Subsysteme vorzunehmen. So lassen sich kritische Engpässe schon vor produktiven Einsatz erkennen und Maßnahmen ergreifen, um teure Probleme im Bereich Datenkonsistenz oder Antwortzeiten zu vermeiden.

Darüber hinaus hilft die Arbeit mit pg_test_fsync auch dabei, das Zusammenspiel von Hardware, Betriebssystem und Datenbanksoftware besser zu verstehen. Alle drei Komponenten beeinflussen die tatsächliche Schreiblatenz in einem komplexen Zusammenspiel. Nur wenn alle richtig aufeinander abgestimmt sind, kann ein leistungsstarkes und zuverlässiges System entstehen. Im Fazit zeigt sich, dass die Nutzung von pg_test_fsync eine wertvolle Praxis für jedes Unternehmen ist, das Datenbanken mit hohen Anforderungen an Schreibgeschwindigkeit betreibt. Von der einfachen Messung der Latenz einzelner Datenträger bis hin zur Analyse komplexer Speicherarchitekturen bietet das Tool einen pragmatischen und aussagekräftigen Einblick.

Die Investition in Zeit und Know-how zur Durchführung solcher Tests zahlt sich vielfach aus und bildet eine solide Grundlage für hochwertige und performante Datenbanksysteme in der Zukunft.