Die rasante Entwicklung von Künstlicher Intelligenz (KI) und deren Integration in Suchmaschinen hat die Art und Weise, wie Informationen gesucht, gefunden und genutzt werden, grundlegend verändert. Plattformen wie ChatGPT und zahlreiche andere KI-basierte Suchdienste versprechen den Nutzern nicht nur schnelle Antworten, sondern auch die Möglichkeit, genauere und besser zitierte Ergebnisse zu erhalten. Doch eine aktuelle Studie des Tow Centers für Digitaljournalismus an der Columbia University zeigt ein ernüchterndes Bild: Über 60 % der von KI-Suchmaschinen bereitgestellten Zitate sind falsch oder irreführend. Diese alarmierende Erkenntnis lässt grundlegende Zweifel an der Verlässlichkeit dieser Technologien für journalistische und wissenschaftliche Zwecke aufkommen und stellt gleichzeitig die Zukunft der Informationsbeschaffung durch KI-gestützte Systeme infrage.Die Untersuchung von Klaudia Jaźwińska und Aisvarya Chandrasekar widmete sich der präzisen Überprüfung von insgesamt 1600 Testabfragen auf acht verschiedenen KI-Suchmaschinen, darunter bekannte Namen wie ChatGPT Search, Perplexity, Gemini und Grok-3.

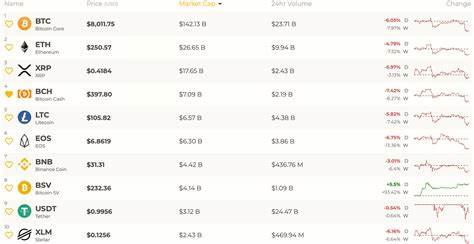

Dabei wurden die Systeme mit realen Quellen konfrontiert und aufgefordert, exakte Angaben wie Titel des Artikels, Veröffentlichungsdatum, den Namen des Mediums sowie die korrekte URL zu liefern. Die Ergebnisse waren enttäuschend: Mehr als 60 % der gelieferten Zitate wiesen Fehler auf, seien es falsche Titel, falsche Daten oder inklusive fehlerhafte oder gar nicht existierende URLs.Besonders auffällig war das unterschiedliche Ausmaß der Fehlerhäufigkeit bei den einzelnen Suchmaschinen. Perplexity, welches sich selbst als besonders für die Recherche geeignet positioniert, schnitt im Vergleich zur Konkurrenz besser ab, mit einer Fehlerquote von rund 37 %. Dies bedeutet jedoch trotz allem, dass nahezu jeder dritte Verweis auf eine Quelle ungenau oder falsch war.

Am entgegengesetzten Ende der Skala lag Grok-3 Search mit einer reinen Fehlerquote von 94 %. Diese Variante, die für zahlende Nutzer von X Premium+ derzeit rund 40 US-Dollar im Monat kostet, gelang es nicht nur, häufig falsche Zitate zu produzieren, sondern führte Nutzer in zahlreichen Fällen auf sogenannte 404-Fehlerseiten. Solche fehlerhaften URLs fanden sich ebenfalls gehäuft bei Gemini, was die Problematik der Zuverlässigkeit zusätzlich veranschaulicht.Ein weiterer wesentlicher Aspekt dieser Analyse war das Verhalten der KI-Systeme im Umgang mit Fehlern oder Unsicherheiten. Während einige Chatbots bei fehlendem Wissen auf Vorsicht oder unsichere Formulierungen setzen, neigen viele der populärsten KI-Suchmaschinen dazu, ihre Antworten mit großer Sicherheit zu präsentieren – selbst wenn diese falsch sind.

Diese sogenannte „blinde Selbstsicherheit“ kann Nutzer in die Irre führen, da der Verzicht auf Hinweise wie „das könnte nicht korrekt sein“ oder „ich bin mir nicht sicher“ eine kritische Hinterfragung erschwert und somit das Vertrauen in die Technologie untergräbt. Die Studie dokumentierte beispielsweise, dass ChatGPT in nur 15 von 134 fehlerhaften Antworten unsicher formulierte. Ein positiver Unterschied zeigte jedoch Copilot, der viele Fragen schlicht ablehnte, wenn eine präzise Antwort nicht gewährleistet war.Die Problematik geht jedoch über die rein technische Korrektheit hinaus und betrifft das gesamte Ökosystem der Nachrichtenmedien und ihrer Finanzierung. Es zeigt sich, dass die korrupten oder falschen Quellenangaben auch zu einem massiven Einbruch bei der Weiterleitung von Traffic an die ausgeschriebenen Nachrichtenanbieter führen.

Eine ergänzende Analyse von TollBit ergibt, dass KI-Chatbots im Vergleich zu den traditionellen Google-Suchergebnissen 96 % weniger Empfehlungsverkehr an Nachrichtenseiten erzeugen. Dieser Trend wird durch empirische Comscore-Daten aus einem Bericht der Northwestern University bestätigt, der den Traffic auf Nachrichtenportalen durch ChatGPT und Perplexity im Verlauf des Jahres 2024 analysierte und herausfand, dass lediglich 3,2 % des durch ChatGPT gefilterten und 7,4 % des Perplexity-Verkehrs zu den Nachrichtenquellen gelangen. Ein derart geringer Anteil unterstreicht die Kritik, dass KI-Suchmaschinen aktuell keine ausreichende Rolle als Traffic-Lieferanten oder gar als Konkurrenten für klassische Suchmaschinen spielen.Diese Erkenntnisse stellen eine große Herausforderung für die Zukunft der digitalen Informationslandschaft dar. Immer mehr Menschen verlassen sich auf KI-gesteuerte Suchmaschinen als erste Anlaufstelle, wobei der Wert der gelieferten Quellenangaben entscheidend ist für die eigene Einschätzung der Faktenlage.

Wenn KI-gestützte Systeme fortlaufend falsche oder irreführende Angaben liefern, entsteht nicht nur Vertrauensverlust bei den Nutzern, sondern gleichzeitig eine Gefährdung der journalistischen Integrität und der Sichtbarkeit legitimer Nachrichtenquellen. Das Problem der „Halluzination“ – das heißt der kreierten, aber nicht existierenden Inhalte und URLs – ist dabei nur eine Facette der zahlreichen Mängel.Die journalistische Branche steht daher vor der Aufgabe, verstärkt auf die Qualitätssicherung und auf Lösungen zu setzen, die eine klare und überprüfbare Quellenangabe gewährleisten. Nur so kann KI ihre Rolle als unterstützendes Werkzeug für Recherche, Journalismus und Nutzersuche sinnvoll erfüllen. Es wird von besonderer Bedeutung sein, dass Entwickler von KI-Systemen verstärkt auf technische Verfahren setzen, die die Überprüfung von Fakten und URLs automatisieren und Fehlerquoten signifikant reduzieren.

Darüber hinaus sollen KI-Systeme ihre Antwortkultur dahingehend verändern, dass sie bei Unsicherheit entsprechenden Hinweis geben und Nutzer darin bestärken, Ergebnisse kritisch zu hinterfragen und selbst zu prüfen.Zusammenfassend lässt sich sagen, dass die derzeitige Situation der KI-Suchmaschinen bei der Quellenangabe alarmierende Defizite offenbart. Über 60 % der getesteten Ergebnisse sind fehlerhaft, was die Zuverlässigkeit und Seriosität dieser Technologien infrage stellt. Dennoch steckt großes Potenzial in der Verbindung von KI und digitaler Recherche, sofern die Branche gemeinsam daran arbeitet, transparente und präzise Zitierstandards zu implementieren. Nur so kann sich das KI-gestützte Informationsverhalten zum Vorteil von Nutzern und Medien entwickeln und gleichzeitig den journalistischen Qualitätsansprüchen gerecht werden.

Die Zukunft der Informationswelt hängt somit maßgeblich davon ab, wie schnell und effektiv dieser „Citation Crisis“ durch technologische und inhaltliche Innovationen begegnet wird.