MLOps, die Schnittstelle zwischen maschinellem Lernen und IT-Betrieb, hat sich als essenziell für die erfolgreiche Implementierung und Skalierung von KI-Systemen etabliert. Dennoch sind viele Entwickler und Unternehmen mit Herausforderungen konfrontiert, die aus falschen Annahmen – sogenannten Fallacies – hinsichtlich der MLOps-Methodik resultieren. Diese Missverständnisse können dazu führen, dass hochentwickelte KI-Modelle nie den Weg in die Produktion finden oder dort nur eingeschränkt funktionieren. Es lohnt sich, diese häufigen Fehlerquellen genauer zu betrachten, um langfristig stabile, wartbare und leistungsfähige KI-Systeme zu schaffen. Der folgende Überblick erklärt die zentralen Fallstricke, ihre Ursachen und die sich daraus ergebenden Folgen für den KI-Betrieb.

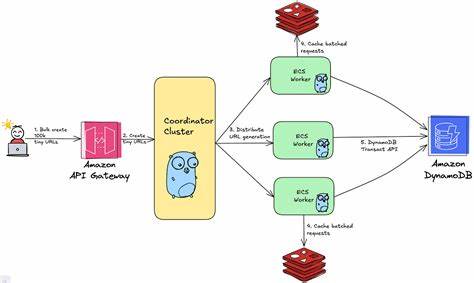

Eine weit verbreitete Fehleinschätzung besteht darin, zu glauben, sämtliche Komponenten eines maschinellen Lernsystems in einer einzigen, monolithischen Pipeline abbilden zu können. Obwohl dies bei den ersten Experimenten mit Batch-Modellen oft funktioniert, stößt man bei komplexeren Szenarien, vor allem bei Echtzeit-Anwendungen, schnell an Grenzen. Erstens unterscheiden sich die Anforderungen grundlegend zwischen Trainingsphasen und Inferenzdienstleistungen, zweitens besitzt jede Stufe unterschiedliche Input- und Output-Parameter. Das Einführen der sogenannten Feature-, Trainings- und Inferenz-Pipelines ermöglicht eine klare Abgrenzung und sorgt für Modularität und Wiederverwendbarkeit. Hierbei konzentrieren sich Feature-Pipelines auf die Verarbeitung und Bereitstellung von Eingabedaten, Trainingspipelines optimieren Modelle anhand dieser Features, und Inferenzpipelines setzen die trainierten Modelle im operativen Betrieb um.

Ein bewusstes Design dieser voneinander getrennten Pipelines unterstützt die Skalierbarkeit und vereinfacht Fehlerbehebung sowie Updates. Weiterhin wird oft unterschätzt, dass Datenumwandlungen für KI-Anwendungen nicht alle gleich sind. Es existieren drei verschiedene Arten von Transformationen, die jeweils ihre eigene Bedeutung und ihren eigenen Ort haben: modellunabhängige Transformationen, modellspezifische Transformationen und on-demand Transformationen. Modellunabhängige Transformationen bereiten Daten allgemein auf, sie erfolgen in der Regel offline und sind jederzeit reproduzierbar. Modellspezifische Transformationen hängen dagegen direkt vom verwendeten Algorithmus ab und müssen konsistent für Training und Inferenz umgesetzt werden, um Fehler durch Diskrepanzen zu vermeiden.

On-demand Transformationen schließlich sind notwendig, wenn Daten erst zum Zeitpunkt der Vorhersage mit zusätzlichen Informationen ergänzt oder berechnet werden. Diese verschiedenen Transformationen klar zu trennen und technisch sauber zu realisieren, ist fundamental, um spätere Fehler durch Datenunanpassungen, sogenannten Data Skew, zu verhindern. Ein weiterer zentraler Ansatz, der häufig vernachlässigt wird, ist die Notwendigkeit eines Feature Stores als spezialisierten Datenlayer für maschinelles Lernen. Während man bei ersten Batch-Modellen möglicherweise ohne einen Feature Store auskommt, ist dieser Baustein für Echtzeit-Systeme unverzichtbar. Er gewährleistet, dass vorbehandelte Features effektiv gespeichert, versioniert und zugänglich gemacht werden – sowohl für Trainings- als auch für Vorhersageprozesse.

Insbesondere die Fähigkeit, korrekte Punkt-in-Zeit Trainingsdaten zu erstellen und die Konsistenz zwischen offline und online Daten sicherzustellen, hält KI-Systeme stabil und nachvollziehbar. Ohne diesen Baustein verliert man schnell die Übersicht über die Datenherkunft und die Versionierung, was zu schwerwiegenden Problemen in Produktion führen kann. Häufig wird experimentelles Tracking von Modellen irrtümlicherweise als integraler Bestandteil von MLOps betrachtet. Zwar ist das Nachvollziehen von Trainingsdurchläufen und Parametervariationen für die Forschung und Entwicklung von Nutzen, jedoch ist es nicht zwingend notwendig, um erste funktionierende KI-Systeme zu erstellen. Ein übertriebener Fokus auf Experiment Tracking kann die Entwicklung verzögern, da die grundlegenden Herausforderungen eines produktiven KI-Betriebs wie Modellregistrierung, Governance, Monitoring und Performance Evaluation zunächst Vorrang haben sollten.

Das Einrichten eines Model Registries mit automatischer Speicherung von Modellen, Metadaten und Metriken bietet in der Praxis einen größeren Mehrwert für den späteren Betrieb. Viel zu oft wird MLOps auch schlicht als eine Erweiterung von DevOps für maschinelles Lernen angesehen, die sich auf automatisiertes Testen und Deployments beschränkt. Dabei verkennt man die spezifischen Eigenheiten von KI-Systemen, die neben Quellcode auch umfangreiche Datenversionierung und Datenvalidierung benötigen. Die Daten sind ein lebendes Wesen, sie verändern sich mit der Zeit durch Drift und neue Quellen. Performanceverschlechterungen durch Veränderungen der Eingabedaten oder Modellveraltung müssen daher kontinuierlich überwacht werden, was im klassischen Software-Lifecycle nicht vorgesehen ist.

MLOps muss daher weit über die übliche Software-Auslieferung hinausgehen und umfassende Mechanismen für Datenqualität, Drift-Detektion und Feedback-Schleifen bereitstellen. Das einfache Versionieren von Modellen alleine reicht nicht, um sichere Upgrades oder Rollbacks durchzuführen. Die Modelle sind stets eng mit den Versionen ihrer verwendeten Features verknüpft. Wenn Feature-Daten nicht synchron mit Modellversionen verwaltet werden, führt dies zu Inkonsistenzen und schwer zu diagnostizierenden Fehlern im Betrieb. Durch die Kombination von Modell- und Feature-Versionskontrolle lässt sich sicherstellen, dass stets die passenden Daten und Modelle zusammenwirken – ein Grundpfeiler für zuverlässige AI-Systeme.

Ebenso ist Data Versioning zur exakten Reproduzierbarkeit von Trainingsdaten unverzichtbar. Besonders bei Compliance-Anforderungen ist es erforderlich, Trainingsdaten exakt so rekonstruieren zu können, wie sie zur Modellbildung verwendet wurden. Ohne ein intelligentes Data Layer mit Zeitreisefunktionen im Daten-Storage können spät eintreffende Daten die Konsistenz gefährden und unerwünschte Nebeneffekte verursachen. Ein oft missverstandenes Konzept ist die Unterscheidung zwischen Model Signature und Deployment API. Die Signatur eines Modells beschreibt, welche Inputs intern vom Modell verarbeitet werden, während das Deployment eine Schnittstelle für externe Nutzer bietet, die mit Parametern arbeiten und Funktionen bereitstellt, die über die reine Modelleinbindung hinausgehen.

Beispielsweise beinhaltet die Deploymentschnittstelle das Abrufen von vorverarbeiteten Features, Ausführen von On-demand Transformationen und Logging von Rohdaten sowie Vorhersagen. Eine klare Trennung und gezielte Kapselung dieser Ebenen erleichtert Entwicklern die Arbeit, ermöglicht unabhängige Updates und erhöht die Systemsicherheit. Prädiktionslatenz wird oft nur auf die reine Modellberechnung bezogen. In der Praxis umfasst die Antwortzeit jedoch sämtliche Vor- und Nachbearbeitungsschritte im Online-Inferenzprozess sowie Netzwerkkommunikation. Hierzu gehören das Sammeln und Transformieren von Features inklusive Anbindung an Feature Stores, Durchführung von on-demand Berechnungen und das Logging der Ergebnisse.

Um glaubwürdige Latenzwerte zu erheben und Performance-Optimierungen vorzunehmen, muss das gesamte Pipeline-System betrachtet werden. Einseitige Fokussierung auf Modellberechnung führt zu Fehleinschätzungen und verpassten Optimierungschancen. Zuletzt wird häufig angenommen, dass LLMOps (Large Language Model Operations) sich grundlegend von klassischen MLOps unterscheidet und ein isoliertes neues Gebiet darstellt. Tatsächlich folgen LLM-Systeme jedoch denselben Architekturprinzipien mit Feature-, Trainings- und Inferenzpipelines. Einzig der Bedarf an GPUs, skalierbarer Infrastruktur und speziellem Storage ist bei LLMs ausgeprägter.

Plattformen, die bereits diese Anforderungen erfüllen, können LLM-Workflows problemlos integrieren, wodurch LLMOps als Erweiterung von MLOps und nicht als eigenständige Disziplin zu verstehen ist. Einheitliche Tools und Prozesse für verschiedene KI-Systeme führen zu höherer Produktivität und besserer Ressourcenauslastung. Die Konsequenzen, wenn diese Fallacies ignoriert werden, zeigen sich vor allem in einem langsamen Fortschritt bei der Entwicklung einsatzreifer KI-Anwendungen. Ohne klare Architektur und standardisierte Prozesse müssen Entwickler Projekte immer wieder neu erfinden, was Zeit und Kosten in die Höhe treibt. Zudem fehlen wichtige Grundlagen für die Beobachtbarkeit der AI-Systeme, was Fehlersuche, Monitoring und Compliance deutlich erschwert.

Probleme wie Data Skew, Drift, inkonsistente API-Schnittstellen oder mangelnde Reproduzierbarkeit sind typische Symptome, die durch grundlegende Architekturmängel ausgelöst werden. Das Vertrauen in KI-Systeme leidet und die Akzeptanz in Unternehmen und bei Kunden bleibt hinter den Erwartungen zurück. Zusammenfassend lässt sich feststellen, dass die Fallacies von MLOps nicht nur theoretische Schwächen beleuchten, sondern praktische Anleitung für den Aufbau nachhaltiger KI-Infrastrukturen bieten. Ein durchdachter modularer Aufbau mit Feature Stores, sorgfältiger Datenversionierung, klar definierten Schnittstellen und umfassendem Monitoring bildet die Basis für den Erfolg. MLOps ist mehr als nur DevOps für KI – es stellt eine ganz eigene Disziplin dar, die auf die Herausforderungen des Datenmanagements, der Modellkomplexität und dem dynamischen Betrieb von AI-Systemen zugeschnitten ist.

Wer diese Prinzipien frühzeitig berücksichtigt, kann die Time-to-Production deutlich verkürzen, die Qualität der Modelle erhöhen und langfristig von einer robusten und skalierbaren KI-Umgebung profitieren.