Nvidia, als führender Akteur im Bereich der künstlichen Intelligenz und Hochleistungsrechner, hat einen strategischen Schritt unternommen, der die Rechenlandschaft im Server- und Datacenter-Segment nachhaltig prägen könnte. Mit der Lizenzierung der NVLink-Memory-Ports an Hersteller von CPUs und Beschleunigern öffnet Nvidia eine wichtige Schnittstelle für eine engere und effizientere Zusammenarbeit zwischen zentralen Prozessoren und spezialisierten Recheneinheiten. Dies könnte maßgeblich zur Effizienzsteigerung und Leistungsoptimierung bei modernen Rechenzentren beitragen. NVLink, erstmals 2016 mit den Pascal P100 GPU-Beschleunigern eingeführt, ist eine Hochgeschwindigkeitsverbindungstechnologie, die eine kohärente Speicherkommunikation zwischen Prozessoren und Grafikeinheiten ermöglicht. Im Unterschied zu klassischen PCIe-Verbindungen unterstützt NVLink eine höhere Bandbreite bei gleichzeitig geringerer Latenz, was enorme Vorteile in AI- und HPC-Workloads mit sich bringt.

Bis dato war diese Technologie eine exklusive Nvidia-Eigentümlichkeit, die ausschließlich für eigene Hardwareprodukte genutzt wurde. Mit der nun bekannt gegebenen Lizenzinitiative, dem sogenannten NVLink Fusion IP-Paket, öffnet Nvidia den Zugang für Dritthersteller und extern entwickelte Siliziumdesigns. Dieser Schritt wird von vielen Experten als Reaktion auf zunehmenden Wettbewerbsdruck und die sich formierende UALink-Alliance gewertet, die auf offene, standardisierte, kohärente Speicherverbindungen für CPUs und Beschleuniger setzt. Die Öffnung von NVLink signalisiert Nvidias Wunsch, trotz der eigenen führenden Position in der AI-Infrastruktur die Technologie als Industriestandard zu etablieren oder zumindest eine dominante Rolle im Ökosystem zu sichern. Dabei ist die Lizenzierung jedoch kein Freifahrtschein für uneingeschränkte Nutzung, sondern an klar definierte Anwendungsfälle gebunden.

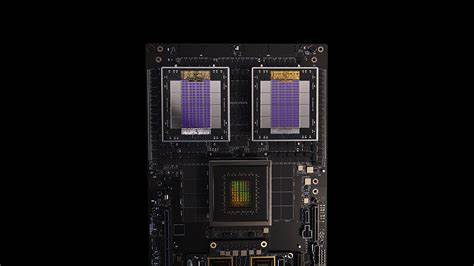

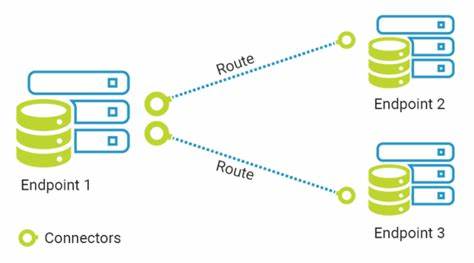

NVLink Fusion erlaubt es Hyperscalern und Cloud-Anbietern, eigene CPUs mit NVLink-Ports auszustatten, um diese direkt mit Nvidia GPU-Beschleunigern zu koppeln. Alternativ können auch kundenspezifische Beschleuniger, die NVLink Fusion unterstützen, an Nvidias Grace CG100 Arm-Prozessoren oder zukünftige Vera CV100 CPUs angeschlossen werden. Auf diese Weise kann eine heterogene Architektur mit kohärentem Speicherzugriff realisiert werden, die sich durch eine besonders effiziente und schnelle Kommunikation auszeichnet. Technisch gesehen basiert NVLink auf einem variablen Lanesystem, das verschiedene Generationen mit unterschiedlichen Bandbreiten pro Lane und Link umfasst. Die erste NVLink-Generation bot 40 GB/s bidirektionale Bandbreite pro Link, während mit NVLink 4.

0 bereits bis zu 900 GB/s pro Port auf einem Hopper- oder Blackwell-GPU-Chiplet erreicht werden. Diese Übertragungsrate ist essentiell für datenintensive Anwendungen, da Engpässe durch Schnittstellenübertragungen erheblich die Gesamtleistung beeinflussen können. UALink, die Konkurrenztechnologie, verspricht zudem noch höhere Raten von bis zu 800 GB/s pro Link, wodurch sich ein spannender Wettlauf um branchenweit effiziente Verbindungsstandards entwickelt. Eine herausragende Besonderheit von NVLink ist die Unterstützung von Speicheratomics – also atomaren Speicheroperationen, die für konsistente Speicherzugriffe über die Komponenten hinweg sorgen. Diese Fähigkeit hebt NVLink von herkömmlichen High-Speed-Verbindungen ab und ermöglicht eine Art Zusammenwachsen von CPU und GPU in einer gemeinsamen Speicherumgebung.

Im Vergleich zu traditionellen Ansätzen, bei denen CPUs und GPUs getrennte Speicherbereiche verwalten und über Datenkopien kommunizieren, ermöglicht NVLink damit eine schnellere und präzisere Zusammenarbeit zwischen den Rechenkomponenten. Der Einsatz von NVLink ist schon langjährige Praxis bei einigen HPC-Spitzenprojekten. IBM zum Beispiel hatte während der Zusammenarbeit mit Nvidia in Systemen wie dem „Summit“-Supercomputer NVLink 2.0 Ports für die Verbindung von Power9 CPUs und Volta-basierenden GPUs genutzt. Auch wenn IBM bei der Weiterentwicklung auf die NVLink 3.

0 Technologie verzichtete und letztendlich AMD mit seinen Lösungen Projekte gewann, hat der frühe Einsatz gezeigt, welches Potenzial eine derart kohärente Speicherverbindung birgt. Nvidias Eigenentwicklungen, wie die Grace-Prozessoren, setzen NVLink intensiv ein, um CPU- und GPU-Leistungen optimal zu koppeln. Mit bis zu 600 GB/s aggregierter Bandbreite zwischen Grace-CPU und Hopper- oder Blackwell-GPUs wird somit ein energiesparendes und extrem schnelles System für AI-Inferenz und Training geschaffen. Die neue Lizenzierung könnte es nun auch anderen Herstellern ermöglichen, eigene Prozessoren oder AI-Beschleuniger mit NVLink-Fähigkeiten zu entwickeln und damit die Kommunikationsbrücke zu Nvidias Hardware zu schlagen. Dabei ist jedoch zu beachten, dass Nvidia nicht den gesamten NVLink-Stack öffnet.

Die beliebten NVSwitch-Schnittstellen, die mehrere GPUs in einer Matrix verschalten und extrem skalierbare Systeme ermöglichen, bleiben weiterhin firmeneigenes Eigentum. Auch werden die Lizenznehmer zur Nutzung weiterer Nvidia-Komponenten wie Mission Control Software und Spectrum-X Switching-Systemen animiert, die für das Management der Verbindungen im Rechenzentrum von großer Bedeutung sind. Dies könnte zu einer gewissen Abhängigkeit führen und die echte offene Nutzung der Technologie bremsen. Dennoch geht Nvidia mit NVLink Fusion einen wichtigen Schritt zur Öffnung seiner Technologie und zeigt dabei ein Verständnis für die Bedürfnisse aller Beteiligten in der Datacenter-Industrie. Unternehmen wie Qualcomm und Fujitsu haben bereits Interesse bekundet, NVLink Fusion in ihren CPU-Designs zu verwenden.

Qualcomm wiederum könnte NVLink auch für eigene AI-Beschleuniger einsetzen, allerdings mit der Einschränkung, auf Nvidia-Prozessoren als Partner angewiesen zu sein. Aus Sicht der Branche stellt dieser Schritt eine interessante Entwicklung dar, die auch auf das lange Spiel um offene Schnittstellen in der Hardwarewelt verweist. Die Geschichte zeigt, dass proprietäre Lösungen zwar kurzfristig Vorteile verschaffen können, langfristig aber offene Standards wie Ethernet und PCIe dominieren, da sie ein breiteres Ökosystem und Kompatibilität ermöglichen. Ob NVLink Fusion den Weg zu einem solchen weit verbreiteten Standard ebnen wird, hängt auch vom Engagement Nvidias und der Bereitschaft der Industrie ab, diese Technologie in unterschiedlichen Kombinationen einzusetzen und weiter zu entwickeln. Kritiker warnen jedoch davor, dass dies eine kontrollierte Öffnung sein könnte, die mehr dazu dient, Nvidias Marktstellung zu sichern, anstatt wirklichen Wettbewerb zu ermöglichen.

Die Lizenzbedingungen sind bislang restriktiv und erlauben nur spezifische Nutzungsszenarien. Es bleibt abzuwarten, inwiefern sich die NVLink-Schnittstelle zu einem offenen Industriestandard mit umfassender Unterstützung entwickeln kann. Abschließend lässt sich festhalten, dass die Lizenzierung von NVLink-Memory-Ports ein bedeutender Schritt in die Zukunft berechneter Systeme ist. Die Technologie ist bestens geeignet, die Speicher- und Datenkommunikationsengpässe zu beseitigen, die in AI-gestützten Anwendungen immer drängender werden. Hyperscaler und Cloud-Anbieter erhalten damit die Möglichkeit, maßgeschneiderte CPU- und Accelerator-Kombinationen zu entwickeln, ohne auf proprietäre Busse und ineffiziente Kopiermechanismen angewiesen zu sein.

Die nächsten Jahre werden zeigen, wie vielseitig sich NVLink Fusion in der Praxis bewährt und ob Nvidia tatsächlich eine führende Rolle bei der Standardisierung dieser Schnittstelle übernimmt. Gleichzeitig bleibt spannend, wie Wettbewerber auf dieses Angebot reagieren und welche Innovationen sich infolge der neu entstehenden Kooperationen und Lizenzprogramme mit NVLink entwickeln. Klar ist: Die Dynamik in der Prozessor- und Accelerator-Architektur bleibt hoch, und mit der Öffnung von NVLink betritt Nvidia ein neues Spielfeld, das die Zukunft der Datacenter-Technologie maßgeblich beeinflussen kann.