Die moderne Entwicklung im Bereich der Künstlichen Intelligenz (KI) erlebt derzeit einen beispiellosen Aufschwung, besonders im Einsatz von großen Sprachmodellen (LLMs) und multimodalen Vision-Language-Modellen (VLMs). Während viele dieser Technologien umfangreiche Cloud-Infrastrukturen benötigen, setzt Swama einen neuen Standard für lokal ausgeführte KI-Anwendungen auf macOS, die speziell auf die Leistungsfähigkeit von Apple Silicon Prozessoren zugeschnitten sind. Als eine MLX-basierte LLM-Inferenz-Engine mit nativer Swift-Implementierung bringt Swama eine einzigartige Kombination aus Performance, Bedienkomfort und Technologieintegration mit sich, die die Nutzung von KI auf Apple-Geräten revolutioniert. Swama wurde als hochperformantes Framework konzipiert, das vollständig in Swift geschrieben ist und somit nahtlos mit dem Ökosystem von Apple zusammenspielt. Die Apple-eigene MLX-Engine bildet die technische Basis, welche tief in die Systemarchitektur von macOS und die Hardware von Apple Silicon (M1, M2, M3 und die kommenden M4-Chips) eingebettet ist.

Dies garantiert eine optimierte Nutzung der Prozessorleistung, der Neural Engine und weiterer spezialisierten Komponenten für Machine Learning. So profitiert Swama nicht nur von Geschwindigkeit und Effizienz, sondern auch von einem sehr energie- und ressourcenschonenden Betrieb, was insbesondere für mobile Apple-Geräte von großer Bedeutung ist. Das Hauptaugenmerk von Swama liegt auf der Bereitstellung einer umfassenden Lösung für die Durchführung von Inferenzprozessen großer Sprachmodelle direkt auf dem lokalen System, ohne dass eine Verbindung zu externen Cloud-Diensten notwendig ist. Diese lokale Ausführung erhöht die Datensicherheit erheblich, da keine sensiblen Eingaben oder Outputs die eigene Hardware verlassen müssen. Große Sprachmodelle wie Qwen3 und Llama 3.

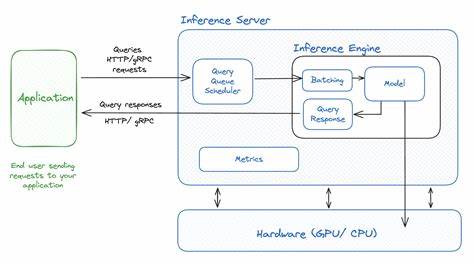

2 werden unterstützt, ebenso wie spezialisierte Modelle für Bild- und Sprachverarbeitung, beispielsweise das Gemma3 VLM oder das Whisper-Modell für lokale Audio-Transkription. Diese Vielfalt macht Swama zu einer vielseitigen Plattform, die sowohl für Entwickler als auch für Endanwender interessant ist. Die Architektur von Swama ist modular gestaltet und gliedert sich in drei Hauptkomponenten. Das Kernmodul SwamaKit beinhaltet die gesamte Business-Logik und die Schnittstellen zur MLX-Engine. Darüber hinaus steht mit Swama CLI ein mächtiges Kommandozeilen-Interface zur Verfügung, das vollständige Funktionen für Modell-Management und Inferenz bietet und sich ideal in Automatisierungs-Workflows integrieren lässt.

Ergänzt wird das System durch eine elegante Menüleiste-App für macOS, die einen einfachen Zugriff mit grafischer Benutzeroberfläche erlaubt und gleichzeitig Hintergrunddienste steuert. Diese Kombination unterstützt vielfältige Nutzungsarten – vom Entwicklerexperiment bis hin zum kommerziellen Einsatz. Ein bemerkenswertes Feature ist die Kompatibilität der Swama-API mit der OpenAI-API. Damit können bestehende Anwendungen und Entwickler-Tools ohne Anpassungen mit Swama betrieben werden. Die Standard-Endpoints wie /v1/chat/completions, /v1/embeddings oder /v1/audio/transcriptions sind vollständig vorhanden und werden über RESTful HTTP-Schnittstellen angeboten.

Dadurch können Nutzer beispielsweise lokale Texterzeugung, semantische Suche oder Sprach-zu-Text-Transkriptionen in gängigen Workflows nutzen, ohne sich mit serverseitigen Anwendungen oder Cloud-Anbietern auseinandersetzen zu müssen. Neben der normalen synchronen Antwort gibt es die Möglichkeit des Streamings, wodurch Ergebnisse in Echtzeit an die Anwendung übermittelt werden – essenziell für interaktive Nutzererlebnisse. Swama erleichtert die Handhabung großer Modelle durch ein intelligentes Modellmanagement. Anwender greifen auf leicht merkbare Aliase statt auf kryptische Modellnamen zu. Die Software lädt Modelle automatisch herunter, falls sie noch nicht lokal vorhanden sind, und verwaltet diese im Cache.

Diese automatisierte Verwaltung reduziert Einstiegshürden und erlaubt es Nutzern, sich auf die Anwendung statt auf technische Details zu konzentrieren. Die Aliase decken unterschiedliche Größen und Kapazitäten ab, von kompakten Modellen bis hin zu trillionenparameterstarken Varianten, die auf Apple-Hardware erstaunliche Leistung bringen. Neben der Sprachverarbeitung unterstützt Swama auch multimodale Eingaben. Die Integration von Vision-Language-Modellen ermöglicht es, Texte mit Bildern zu kombinieren und kontextreiche Ausgaben zu erzeugen. So können beispielsweise Nutzer mit einfachen Anfragen an ein Modell erkunden, was auf einem Bild dargestellt ist oder darauf basierende Beschreibungen generieren lassen.

Zusammen mit der eingebauten Audio-Transkriptionsfunktion auf Basis von OpenAIs Whisper-Modell entsteht ein äußerst vielseitiges Werkzeug für die multimodale KI-Anwendung. Für Entwickler bietet Swama eine umfangreiche Grundlage zur Weiterentwicklung und Integration in eigene Anwendungen. Die quelloffene Natur des Projekts ermöglicht es, den gesamten Code in Swift einzusehen und auf Basis aktueller Swift-Versionen (ab Swift 6.1) und Xcode 15 zu kompilieren. Die Nutzung von SwiftNIO für das Netzwerk-Backend sorgt zudem für hohe Leistungsfähigkeit bei gleichzeitigen Anfragen.

Das Projekt ist gut dokumentiert und stellt Beispiele und Tests bereit, damit Entwickler schnell produktiv werden können. Die Installation von Swama gestaltet sich unkompliziert, dank vorgefertigter, signierter Disk-Image-Dateien, die direkt auf macOS-Geräten laufen. Die optionale CLI-Unterstützung kann ebenfalls mit wenigen Klicks hinzugefügt werden, was eine schnelle Nutzung ermöglicht. Für fortgeschrittene Anwender steht die Möglichkeit des Quellcode-Builds offen, wodurch Anpassungen oder Erweiterungen problemlos realisiert werden können. Die Vorteile einer lokalen LLM-Inferenz liegen auf der Hand: Reduzierte Latenzzeiten durch Wegfall der Netzwerkanbindung, gesteigerte Privatsphäre und vollständige Kontrolle über die eingesetzten Modelle und Daten.

Gerade in Zeiten wachsender Datenschutzanforderungen und steigender Sensibilität für Datenströme im Internet gewinnt das lokale Hosting von KI-Systemen zunehmend an Bedeutung. Swama stellt hier eine state-of-the-art Lösung bereit, die auf macOS-Geräten besonders performant und anwenderfreundlich agiert. Ein weiterer Pluspunkt ist die Integration mit dem macOS-Ökosystem. Die Menüleiste-App bietet eine native Benutzererfahrung, die sich harmonisch in den Arbeitsablauf einfügt. Swama unterstützt zudem den Schnittstellenstandard zu gängigen KI-Diensten, was eine breite Kompatibilität mit bestehenden Chats, Entwicklungstools und Automation-Frameworks ermöglicht.

Dadurch ist das Framework nicht nur für technikaffine Nutzer und Entwickler interessant, sondern ebenso für Unternehmen, die Lösungen mit hohen Anforderungen an Verlässlichkeit und Datenschutz implementieren möchten. Abschließend lässt sich sagen, dass Swama mit seiner MLX-basierten, in Swift geschriebenen Engine einen wichtigen Meilenstein in der KI-Anwendungsentwicklung für Apple-Geräte darstellt. Es kombiniert modernste Technologie mit einfacher Bedienbarkeit und erfüllt die Bedürfnisse sowohl von Softwareentwicklern als auch Endanwendern, die leistungsfähige lokale KI-Funktionalität suchen. Die stetige Weiterentwicklung, die umfassende Unterstützung unterschiedlicher großer Modelle und die enge Anbindung an das Apple-Hardware-Ökosystem machen Swama zu einer spannenden Plattform mit großem Potenzial für die Zukunft der lokalen KI-Computing-Umgebung auf macOS.