In der heutigen technologischen Landschaft sind leistungsstarke und zuverlässige Datenbanksysteme essenziell für den Erfolg von Unternehmen jeder Größe. Die Wahl des passenden Systems hat direkte Auswirkungen auf Performance, Kosten und Skalierbarkeit der Anwendungen. Besonders bei wachsendem Datenvolumen und komplexeren Anforderungen wird die Wahl der Datenbank zu einer strategischen Entscheidung. Während viele anfangs auf verteilte Datenbanken wie CockroachDB setzten, um Skalierbarkeit und Hochverfügbarkeit zu gewährleisten, zeigt die Praxis häufig, dass traditionelle relationale Datenbanken wie PostgreSQL eine bessere Option für viele Use Cases darstellen. Die Migration zu Postgres erweist sich dabei nicht nur als technisch machbar, sondern bringt auch signifikante Vorteile in Bezug auf Kosten, Performance und Entwicklererfahrung mit sich.

CockroachDB galt lange Zeit als vielversprechende Lösung für Multi-Region-Architekturen sowie als extrem ausfallsicher dank seiner verteilten Natur. Doch für Unternehmen, die noch keine streng verteilten Datenanforderungen oder Datenlokalisierungsvorschriften wie GDPR erfüllen müssen, kann eine solche Lösung unnötige Komplexität und vor allem Kosten verursachen. Ein exemplarisches Beispiel liefert das Unternehmen Motion, das seit Anfang 2022 CockroachDB verwendet hatte und über die Zeit steigende Kosten und auftretende technische Probleme feststellte. Trotz der Vorteile wie das automatische horizontale Skalieren und eine SQL-kompatible Oberfläche waren die Ausgaben bis 2024 auf das Fünffache dessen angestiegen, was das Unternehmen als sinnvoll erachtete, ohne dabei die versprochenen Multi-Region-Nutzen voll ausschöpfen zu können. In dieser Situation wurde klar, dass eine Umstellung auf eine traditionellere Datenbankarchitektur Vorteile bringen würde.

Besonders kritisch zeigten sich die Migrationsprozesse mit CockroachDB. Der Einsatz eines ORMs (Object-Relational Mapper) wie Prisma erleichterte zwar den Entwicklungsprozess und vereinfachte den Datenzugriff, doch bei der Ausführung von Datenbankmigrationen traten wiederholt Timeouts auf. Diese führten in Folge zu beträchtlichen Verzögerungen beim Deployment und zwangen das Team zu manuellen Eingriffen, um Migrationen schluckweise einzuspielen. Dieser Umstand beeinträchtigte nicht nur den Entwicklungsfluss, sondern brachte operative Risiken mit sich. Entwickler scheuten im Extremfall sogar, notwendige Datenbankänderungen vorzunehmen, aus Sorge, das System durch langlaufende Sperren zu blockieren.

Der Wechsel zu Postgres brachte hier eine dramatische Verbesserung. Migrationen, die mit CockroachDB unverhältnismäßig lange dauerten oder abbrachen, ließen sich mit Postgres innerhalb von Sekunden umsetzen. Neben der absurden Verkürzung der Downtime gewährleistete Postgres auch eine stabilere Umgebung, in der Migrationen verlässlich durchführbar sind. Dies führte dazu, dass bereits allein durch optimierte Migrationsprozesse signifikante Gewinne in der Entwicklerproduktivität realisiert werden konnten. Ein weiteres Problemfeld bei der Verwendung von CockroachDB war die Integration von ETL-Prozessen (Extract, Transform, Load) in die bestehende Infrastruktur.

ETL-Jobs, die essenziell für Datenanalysen und Dashboards sind, zeigten eine schlechte Performance und neigten zu Abstürzen. Die Anbindung an etablierte ETL-Lösungen wie Airbyte war nur rudimentär möglich und selbst bei Verwendung dessen Alpha-Connectoren traten Speicherlecks auf, die Performance und Stabilität negativ beeinflussten. Die mangelhafte Unterstützung durch das Ökosystem zeigte sich als klarer Engpass und führte dazu, dass individuelle Lösungen entwickelt werden mussten, um die Daten von CockroachDB nach Postgres zu übertragen. Letzteres stellte sich als deutlich verlässlicher und einfacher in der Integration heraus. Neben der operativen Seite spielten auch die Query-Geschwindigkeiten eine zentrale Rolle in der Umstellung.

Interessanterweise ist die Performance von CockroachDB nicht generell schlechter als die von Postgres. Insbesondere manche aggregierende Abfragen liefen aufgrund des optimierten Query Planners bei CockroachDB schneller. Doch bei komplexeren, häufig in der Praxis eingesetzten Abfragen erzeugt der ORM Prisma oft besonders verschachtelte SQL-Abfragen. Dabei entschied die Cockroach-DB häufig für einen Full Table Scan, was die Ausführungszeit dramatisch verlängerte. Postgres schnitt bei vielen dieser realen Abfragen deutlich besser ab, da der Query Planner entsprechende Optimierungen besser umsetzte und beispielsweise Indizes effektiver nutzte.

Insgesamt konnte Motion an dieser Stelle eine Reduktion der durchschnittlichen Abfragezeiten um Faktor drei beobachten, was die Nutzerzufriedenheit direkt positiv beeinflusste. Die Umstellung auf Postgres brachte zudem eine Verbesserung der Entwicklererfahrung mit sich. Die Administration ist durch ausgereifte Tools und Nutzeroberflächen einfacher, Szenarien wie das Abbrechen laufender Queries sind direkter lösbar, ohne aufwändige Aufrufe in der Konsole der verteilten Cluster aufzurufen. Die Fehlersuche und Performance-Analyse profitiert von einem großen Ökosystem bewährter Tools wie PGAnalyze. Zudem gestaltet sich der Support dank konsistenterer und benutzerfreundlicherer Kundenportale einfacher und schneller.

All diese Faktoren reduzierten den Frust der Entwickler und erhöhten die Wartbarkeit der Datenlandschaft deutlich. Nicht zu vernachlässigen sind auch infrastrukturelle Herausforderungen, die sich während der CockroachDB-Nutzung zeigten. Wiederkehrende Verbindungsprobleme, die sich durch Netzwerkausfälle bei der Nutzung von Tailscale VPN-Diensten zeigten, führten zu Ausfällen und instabilen Entwicklungs- und Deploymentphasen. Diese waren nicht nur schwer zu debuggen, sondern traten sporadisch und scheinbar zufällig auf. Mit Postgres in der Infrastruktur konnten diese Fehlerquellen eliminiert werden, da hier keine verteilte Clusterumgebung vorlag und lokale Verbindungsprobleme entfallen und durch bewährte Maßnahmen besser beherrscht werden konnten.

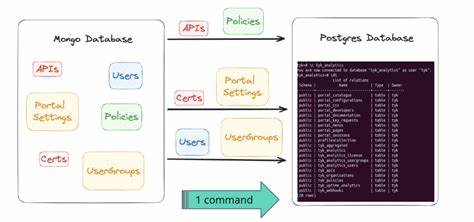

Der tatsächliche Migrationsprozess ist natürlich eine Herausforderung, besonders wenn die Datenbasis sehr groß ist und unterschiedliche Datenformate wie JSON oder Arrays in abweichenden Encoding-Standards gespeichert sind. Die Motion-Erfahrung zeigte, dass individuelle Skripte und Pipelines nötig sind, um die Daten robust und verlustfrei zwischen CockroachDB und Postgres zu übertragen. Dabei bewährte sich ein Ansatz mit eigenständigen Prozessen, die CSV-Streams der Tabellen exportieren und dann gezielt einspielen. Anpassungen bei Datenformaten müssen vorgenommen werden, um Kompatibilität zu gewährleisten. Der Aufwand lohnt sich jedoch aufgrund der anschließenden erhöhten Stabilität und Performance.

Die eigentliche Produktionmigration wurde bei Motion innerhalb von etwa 15 Minuten abgewickelt – eine bemerkenswerte Leistung für eine Datenbank mit zusatzlich etwa 100 Millionen Datensätzen. Während der Migration wurde die Anwendung in den Wartungsmodus versetzt und der Datenbankverkehr kontrolliert gesteuert, um Ausfallzeiten gering zu halten und Datenverlust auszuschließen. Die anschließende Nutzung von Postgres zeigte sofort deutliche Performanceverbesserungen, reduzierte die durchschnittlichen Latenzen um 33 Prozent und ermöglichte eine schnellere Fehlerbehebung durch Analyse der zuvor problematischen Queries. Finanziell gesehen sparte das Unternehmen durch den Wechsel zu Postgres mehr als 110.000 US-Dollar jährlich allein durch geringere Lizenz- und Betriebskosten.

Die Einsparungen würden mit wachsenden Nutzerzahlen und Datenmengen weiter ansteigen. Auch wenn das Postgres-Cluster vorsorglich überdimensioniert wurde, erwies sich die Investition als wirtschaftlich sinnvoll und machte die Migration zu einer lohnenswerten Entscheidung. Für Unternehmen, die vor der Entscheidung stehen, ob sie bei verteilten NoSQL- oder NewSQL-Datenbanken bleiben oder zu traditionellen relationalen Systemen wechseln sollten, bietet die Motion-Erfahrung wertvolle Einsichten. Die Vorteile von Postgres liegen nicht nur in Preis und Performance, sondern auch in kontinuierlicher Weiterentwicklung, einem starken Ecosystem und der breiten Community-Unterstützung. Ältere NoSQL-Systeme können in Szenarien mit Multi-Region-Distributed-Setups punktgenau besser sein – doch für die meisten transaktionalen und analytischen Workloads wie bei vielen SaaS-Anwendungen liefert Postgres eine ausgezeichnete Mischung aus Zuverlässigkeit, Skalierbarkeit und Kosteneffizienz.

Die Learnings aus einer solchen Migration umfassen auch organisatorische Aspekte: Eine sorgfältige Planung der Datenstruktur, Tests mit echten und repräsentativen Datenmengen sowie ein schrittweises Vorgehen minimieren Risiken. Eine automatisierte ETL-Pipeline und Monitoring-Tools zur Performance-Überwachung erleichtern das Umstiegsvorhaben enorm. Zudem sollte ausreichend Zeit für die Erfassung und Anpassung von komplexen Datentypen wie JSON und Arrays eingeplant werden, um spätere Inkonsistenzen zu vermeiden. Zusammenfassend zeigt sich, dass die Migration zu Postgres eine sinnvolle strategische Entscheidung für Unternehmen darstellt, die auf Stabilität, Kosteneffizienz und Performance setzen. Die technischen Herausforderungen sind lösbar, und die langfristigen Vorteile überwiegen deutlich.

Mit dem richtigen Know-how und sorgfältiger Umsetzung lässt sich der Wechsel als Chance nutzen, um die Dateninfrastruktur grundlegend zu verbessern und zukunftssicher aufzustellen. Die PostgreSQL-Community bietet dafür eine solide Basis, die durch zahlreiche innovative Tools und Lösungen ergänzt wird, welche Entwicklern und Administratoren gleichermaßen förderlich sind. Damit ist Postgres nicht nur eine Datenbank, sondern eine starke Plattform für nachhaltiges Wachstum und innovative Anwendungen.

![Scientists warn disease killing Antarctic animals has pandemic potential [video]](/images/BF19030E-06A9-4160-8F10-B90ADEE955E6)

![Why Can't We Make Simple Software? – Peter van Hardenberg [video]](/images/B35E9F40-2F85-48CF-9AF4-01AEC1E9C5C8)