In der heutigen digitalisierten Welt begegnen wir täglich Empfehlungssystemen, die uns neue Filme, Restaurants, Bücher oder Produkte vorschlagen. Doch obwohl diese Systeme oft wie intuitive Entscheidungshelfer erscheinen, verstehen sie unsere Vorlieben nicht wirklich. Stattdessen arbeiten sie mit mathematischen Methoden, die Nutzerverhalten in Zahlen umwandeln und daraus Gemeinsamkeiten erkennen. Diese faszinierende Verbindung zwischen Daten, Mathematik und menschlichem Geschmack lässt sich als „Geometrie des Geschmacks“ beschreiben – eine spannende Reise, bei der Präferenzen in ein geometrisches Modell übersetzt werden und dadurch vergleichbar werden. Empfehlungssysteme basieren häufig auf dem Prinzip, dass hinter jedem Klick, jeder Bewertung oder jeder Interaktion ein Vektor steht – eine Liste von Zahlen, die das Verhalten eines Nutzers widerspiegelt.

Indem diese Vektoren miteinander verglichen werden, erkennen Algorithmen Muster, Ähnlichkeiten und Abweichungen. Es entsteht eine Art mathematischer Abstand zwischen den verschiedenen Nutzerpräferenzen, der Aufschluss darüber gibt, wie ähnlich sich Menschen hinsichtlich ihrer Geschmäcker tatsächlich sind. Ein intuitives Beispiel hierfür sind Restaurantbewertungen. Wenn mehrere Personen zwei unterschiedliche gastronomische Betriebe bewerten, geben sie ihre Meinung oftmals als Wert von null bis fünf ab. Diese Werte können dann als Koordinatenpunkte in einem zweidimensionalen Raum dargestellt werden, wobei jede Achse ein Restaurant repräsentiert.

Wer in diesem Raum nahe beieinander liegt, hat vergleichbare Vorlieben. Durch das Berechnen von Entfernungen zwischen Punkten werden diese Ähnlichkeiten quantitativ erfassbar. Ein bewährter Ansatz ist die sogenannte Manhattan-Distanz, die die Summe der horizontalen und vertikalen Abstände zwischen zwei Punkten misst. Verglichen mit einer geraden Linie zählt hier der Weg, der entlang eines Gitters verläuft – ähnlich wie man sich durch die Straßen einer Stadt bewegt. Diese Methode ist nicht nur anschaulich, sondern auch in der Praxis sehr schnell zu berechnen, was insbesondere bei großen Datenmengen von Vorteil ist.

Alternativ wird oft die euklidische Distanz verwendet, die den direkten, kürzesten Weg zwischen zwei Punkten misst – man stelle sich den Abstand zwischen zwei Orten in gerade Linie vor. Beide Entfernungen gehören zu einer größeren Familie der sogenannten Minkowski-Distanzen. Diese Familie erlaubt durch einen Parameter p eine Anpassung der Sensitivität gegenüber Ausreißern oder starken Unterschieden in einzelnen Dimensionen. Während die Manhattan-Distanz (p=1) eher lineare Summen nutzt, wertet die euklidische Distanz (p=2) größere Abweichungen stärker auf. Bei größeren Werten von p rücken extremste Unterschiede in eine noch stärkere Gewichtung, womit die Metrik letztlich nur noch den größten individuellen Unterschied betrachtet – bekannt als Chebyshev-Distanz.

Diese Flexibilität erlaubt Datenwissenschaftlern, das Maß an Feinfühligkeit an die jeweiligen Anforderungen anzupassen, um ein möglichst treffendes Bild der Ähnlichkeit zwischen Nutzerpräferenzen zu zeichnen. Doch diese Distanz-Messungen stützen sich auf die Annahme, dass alle Nutzer die Bewertungs-Skala gleich verwenden. Das ist in der Realität selten der Fall: Einige bewerten grundsätzlich großzügig, andere eher zurückhaltend. Zudem können geschmackliche Wandlungen oder persönliche Maßstäbe eine bedeutende Rolle spielen. Aus diesem Grund greift man oft zur Pearson-Korrelationskoeffizienten, einem Statistik-Tool, das nicht die absoluten Werte vergleicht, sondern die Muster hinter den Bewertungen.

Statt etwa zu schauen, ob zwei Nutzer beide eine Fünf vergeben, wird untersucht, ob sie bei steigendem Geschmacksempfinden gemeinsam höhere Werte vergeben oder bei schlechtem Geschmack beide tendenziell niedrigere Bewertungen geben. Die Pearson-Korrelation liegt zwischen minus eins und plus eins. Eine Eins bedeutet perfekten Gleichklang: Wenn der eine Nutzer etwas gut bewertet, tut das der andere auch. Minus eins steht für eine perfekte Opposition: Was dem einen gefällt, lehnt der andere ab. Ein Wert nahe null signalisiert, dass keinerlei linearer Zusammenhang zwischen den Bewertungsmustern besteht.

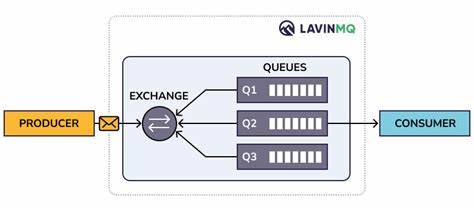

Die Stärke dieses Ansatzes liegt darin, unterschiedlich strenge Bewertungshaltungen neutralisieren zu können und so Deckungsgleichheiten in den Geschmacksrichtungen zu erkennen, die durch reine Abstandsmaße verdeckt blieben. Auf Basis dieser Erkenntnisse lässt sich die Methode der k-nächsten Nachbarn (k-nearest neighbors) beschreiben, die sehr populär im Bereich der personalisierten Empfehlungen ist. Bei diesem Verfahren werden zunächst mithilfe von Distanzmetriken oder der Pearson-Korrelation Nutzer bestimmt, die einem Zielnutzer mit ähnlichen Präferenzen am nächsten sind. Das bedeutet, man sucht nicht nur den Einzelnen mit dem ähnlichsten Geschmack, sondern gleich eine Gruppe Gleichgesinnter. Aus dieser Nachbarschaft ergeben sich Vorhersagen darüber, welche neuen Restaurants oder Filme der Nutzer wahrscheinlich mögen wird – gewichtet nach der Stärke der Übereinstimmung der Geschmäcker.

Das klassische Szenario zeigt, dass selbst wenn zwei Nutzer im Großen und Ganzen gleiche Interessen teilen, einzelne Ausreißer bestehen können. Beispielsweise könnten beide Horrorfilme lieben und Action vermeiden, doch während der eine auch romantische Komödien schätzt, lehnt der andere diese völlig ab. Empfehlungssysteme steuern dagegen, indem sie nicht nur einen Gleichgesinnten berücksichtigen, sondern mehrere, wodurch die Vorhersage stabiler und robuster wird. Allerdings steigt mit der Anzahl der Nachbarn auch der Rechenaufwand, und das Risiko, durch zu viele unterschiedliche Meinungen die Vorhersagen zu verwässern. Somit bleibt der Schlüssel zum Erfolg in der Auswahl passender Ähnlichkeitsmaße: Wollen wir Abstufungen in den Bewertungen berücksichtigen oder stehen Muster im Vordergrund? Wie gehen wir mit Ausreißern um? Und wie wichtig ist es, ob ein Nutzer generell tendenziell höhere oder niedrigere Werte vergibt? Für diese Entscheidungen ist ein profundes Verständnis der eigenen Daten und deren Charakteristik unabdingbar.

In der Praxis werden oft hybride Systeme verwendet, die Distanzmetriken und Korrelationskoeffizienten kombinieren, um die Stärken beider Ansätze zu verbinden. Während die Distanzmetrik hilft, eine eng umgrenzte Nachbarschaft zu definieren, überprüft die Korrelation, wie stark die Übereinstimmung der Geschmäcker tatsächlich ist. So entsteht ein fein abgestimmtes Modell, das nicht nur Ähnlichkeit an sich misst, sondern auch deren Qualität gewichtet. Die Bedeutung der „Geometrie des Geschmacks“ geht weit über einfache Empfehlungsalgorithmen hinaus. Sie zeigt auf, wie durch abstrakte mathematische Konzepte menschliches Verhalten digital interpretierbar wird und wie durch präzise Maße Systeme immer besser darin werden, uns individuell und relevant zu beraten.

Gleichzeitig eröffnet sie eine kritische Perspektive: Wir müssen verstehen, was unsere Daten wirklich aussagen, welche Verzerrungen oder Lücken existieren und wie Algorithmen unsere Erfahrungen formen. Denn letztlich sind Präferenzen zwar subjektiv und komplex, doch durch die Mathematik gewinnen wir Begriffe und Werkzeuge, die Licht ins Dunkel bringen. Die Verschmelzung von Geometrie, Statistik und Verhaltenswissenschaft macht es möglich, Geschmack messbar zu machen – eine innovative Grundlage für personalisierte und smarte Services in einer digitalisierten Gesellschaft. Wer sich dieser Grundlagen bewusst ist, kann nicht nur die Mechanik hinter den Empfehlungen durchschauen, sondern auch aktiv an der Gestaltung fairer und zuverlässiger Lösungen mitwirken.

![Grand Theft Auto VI Trailer 2 [video]](/images/8BD35DA2-B66A-47A2-8B26-4C7521DEFE8C)