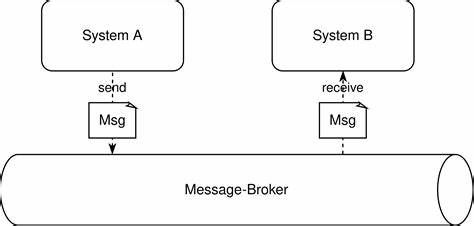

In der heutigen Softwareentwicklung sind asynchrone Schnittstellen ein essenzieller Bestandteil moderner IT-Architekturen, insbesondere im Kontext von Microservices und verteilten Systemen. Die klassische Herangehensweise nutzt oft spezialisierte Nachrichtensysteme wie Apache Kafka oder RabbitMQ, um Nachrichten zwischen Diensten auszutauschen und so Entkopplung sowie Skalierbarkeit zu gewährleisten. Doch diese Middleware-Systeme bringen ihre eigenen Herausforderungen mit sich – angefangen bei der Wartung und Administration über technische Abhängigkeiten bis hin zu komplexen Betriebsabläufen. Die Alternative dazu bietet HTTP-Feeds, eine leichtgewichtige und wartungsarme Methode, um asynchrone Kommunikation ohne den Einsatz schwergewichtiger Broker-Systeme zu gestalten. HTTP-Feeds basieren auf der bewährten Technologie der HTTP-APIs, die Entwickler seit Jahren kennen und einsetzen.

Sie erlauben es, Datenänderungen oder Ereignisse in einem System als eine Art Stream über einen HTTP-Endpunkt bereitzustellen, den andere Systeme periodisch abrufen können. Im Gegensatz zu synchronen APIs, bei denen ein Anfragendes System auf die direkte Antwort wartet, implementieren HTTP-Feeds eine asynchrone Arbeitsweise, indem sie Daten inkrementell und eventgetrieben bereitstellen, ohne dass ein sofortiger Prozessabschluss notwendig ist. Das zentrale Problem synchroner Schnittstellen besteht darin, dass sie die Verfügbarkeit und Latenzzeit aller beteiligten Systeme multiplizieren, was in kritischen Geschäftsanwendungen schnell zu Engpässen oder sogar Ausfällen führen kann. Beispielhaft ist die Abhängigkeit eines Onlineshops von einem Finanzbuchhaltungssystem: Fällt letzteres wegen Wartung oder Last aus, kann der Shop unter Umständen nicht mehr ordnungsgemäß funktionieren. Außerdem entstehen durch synchrone Aufrufe oft lange Wartezeiten, die die Nutzererfahrung und die Performance beeinträchtigen.

HTTP-Feeds umgehen diese Probleme, indem sie Datenänderungen als kontinuierliche „Feeds“ bereitstellen, auf die Clients in ihrem eigenen Tempo zugreifen können. Dabei dienen die HTTP-Feeds als eine einfache Quelle der Wahrheit, zu der sich Konsumenten verbinden und neue Daten asynchron beziehen. Dadurch wird eine Entkopplung der beteiligten Systeme erreicht, ohne die Komplexität und Abhängigkeiten eines Message Brokers. Ein wesentlicher Vorteil von HTTP-Feeds liegt darin, dass keine zusätzliche Infrastruktur für Nachrichtenvermittlung oder Warteschlangen erforderlich ist. Dies reduziert erheblich den Betriebsaufwand, da kein dediziertes Team für Installation, Konfiguration und Betrieb von Kafka, RabbitMQ oder ähnlichen Systemen benötigt wird.

Die Integration in bestehende Systeme ist ebenfalls einfacher, da HTTP ein universeller Standard ist und fast alle modernen Programmiersprachen und Frameworks native Unterstützung bieten. Dadurch lassen sich Schnittstellen schneller realisieren und pflegen. Ein weiterer Aspekt ist die Einhaltung von Datenschutzrichtlinien und die Umsetzung von DSGVO-Anforderungen. Da HTTP-Feeds oft für einen begrenzten Zeitraum vorgehalten und inkrementell übertragen werden, können die Datenflüsse besser kontrolliert und dokumentiert werden. Ein sorgfältiger Umgang mit Metadaten und Zugriffsrechten ist jedoch auch hier unabdingbar, um Missbrauch zu verhindern und Compliance sicherzustellen.

Technisch gesehen basieren HTTP-Feeds in vielen Fällen auf Protokollen wie HTTP Long Polling, Server-Sent Events (SSE) oder Webhooks, die es Systemen ermöglichen, Datenänderungen in Echtzeit oder nahezu echtzeitnah mitzuteilen. Während SSE und Webhooks mehr eine Push-Strategie darstellen, erlauben klassische HTTP-GET-Methoden in Kombination mit inkrementellen ID-Verfahren oder Zeitstempeln die Abfrage nur der Änderungen seit der letzten Anfrage. So kann ein Client effizient immer auf dem neuesten Stand bleiben, ohne kontinuierlich große Datenmengen übertragen zu müssen. Die Verwendung von HTTP-Feeds ist somit nicht nur eine pragmatische Alternative, sondern eröffnet auch architektonische Vorteile. Die Systeme bleiben autonom und robust, denn sie sind weniger anfällig für Fehler, die durch Middleware oder Netzwerkbroker entstehen.

Falls ein Konsument temporär ausfällt, kann er beim nächsten Abruf einfach dort weitermachen, wo er aufgehört hat. Diese Robustheit bei einfachen technischen Mitteln ist gerade in verteilten Umgebungen ein nicht zu unterschätzender Pluspunkt. Während die klassischen Nachrichtensysteme vor allem in hochvolumigen Streaming-Anwendungen oder Event-Streaming-Szenarien mit sehr hohem Durchsatz und strengen Garantien ihre Stärke zeigen, reicht für viele Anwendungsfälle die Lösung über HTTP-Feeds vollkommen aus. Sie sind somit besonders für Startups, kleine bis mittelgroße Unternehmen und Teams interessant, die schnelle und flexible Lösungen suchen, ohne sich in komplexe Middleware-Abhängigkeiten zu verstricken. Nicht zuletzt erfordern HTTP-Feeds nur überschaubare Entwicklungskapazitäten.

Da die Datenformate meist auf JSON basieren und RESTful Konzepte genutzt werden, ist es für Entwickler einfacher, anzufangen und sie zu implementieren, ohne sich mit speziellen Serialisierungsformaten oder Schema-Management-Prozessen wie bei Avro oder Protobuf zu beschäftigen. Ebenso entfallen komplexe Fehlerszenarien, die in Message-Brokern auftreten können, wenn Nachrichten verloren gehen oder nicht richtig zugestellt werden. Bei der Umsetzung von HTTP-Feeds sollte dennoch auf gewisse Aspekte geachtet werden, zum Beispiel auf die Architektur des Feed-Endpunkts, damit eine gute Skalierbarkeit und Performance gewährleistet ist. Die regelmäßige Pflege (Housekeeping) sorgt dafür, dass alte und nicht mehr benötigte Daten aus den Feeds entfernt werden und der Speicherbedarf begrenzt bleibt. Auch das Monitoring der Schnittstellen und entsprechendes Logging spielen eine wichtige Rolle, um im Falle von Fehlern schnell eingreifen zu können.

Zusammenfassend bieten HTTP-Feeds eine elegante, einfache und effektive Möglichkeit, asynchrone Schnittstellen ohne den Einsatz komplexer und wartungsintensiver Middleware-Systeme zu gestalten. Sie ermöglichen Unternehmen, ihre Systemlandschaft resilient und skalierbar zu halten, ohne unnötige Abhängigkeiten und zusätzliche Betriebskosten. Insbesondere bei der zunehmenden Verbreitung von Microservices bieten sie eine praktische Alternative, um Daten zuverlässig, aktuell und entkoppelt auszutauschen. So können Entwicklerteams schneller reagieren, flexibel bleiben und die Komplexität ihrer Infrastruktur reduzieren – ideale Voraussetzungen für agile Softwareentwicklung in einer dynamischen IT-Landschaft.