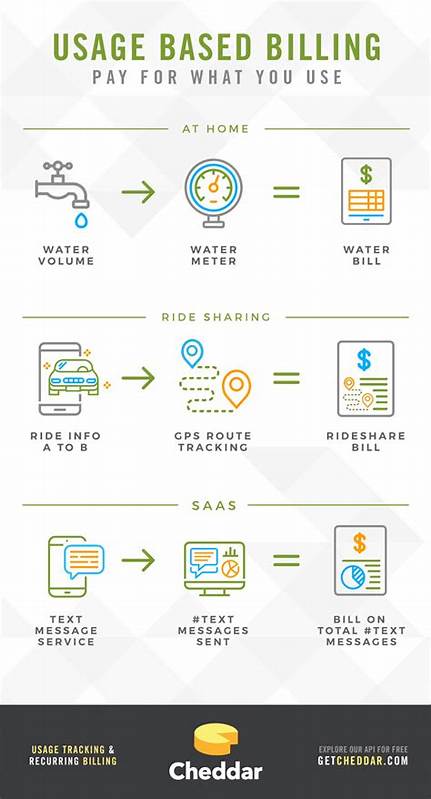

Im Zeitalter der Digitalisierung und Cloud-Dienste gewinnt das Prinzip der nutzungsbasierten Abrechnung zunehmend an Bedeutung. Es ermöglicht Anbietern, ihre Kunden nach tatsächlichem Ressourcenverbrauch zu bezahlen – eine faire und transparente Methode, die den individuellen Bedürfnissen gerecht wird. Hinter dieser Modernisierung der Preisgestaltung verbirgt sich jedoch ein komplexes technisches Problem, das sich als Signalverarbeitungsaufgabe interpretieren lässt. Die Entwicklung eines robusten nutzungsbasierten Abrechnungssystems ist folglich nicht nur eine Frage der Wirtschaftspolitik, sondern vor allem der genauen und effizienten Verarbeitung massiver Datenströme. Dieser Artikel beleuchtet, weshalb nutzungsbasierte Abrechnung auf den Prinzipien der Signalverarbeitung basiert und welche Herausforderungen und Lösungen sich dabei ergeben.

Traditionelle Abrechnungsmodelle, etwa die pauschale Monatsgebühr oder feste Tarifmodelle, legen ihrer Kalkulation starre Parameter zugrunde, die oft wenig mit dem tatsächlichen Verbrauch der Kunden zu tun haben. Mit dem Wachstum der digitalen Transformation und flexibler IT-Architekturen wurde der Bedarf nach näher an der tatsächlichen Nutzung orientierten Preisgestaltung immer dringlicher. Nutzungsbasierte Abrechnung bietet diesen Paradigmenwechsel, indem sie relevante Metriken wie Anzahl der Lese- und Schreibvorgänge oder Speicherverbrauch in Echtzeit erfasst und für die Preisfindung heranzieht. Die technische Herausforderung besteht darin, die riesigen Mengen an nutzungsbezogenen Daten genau und performant zu messen und aggregieren. Dabei entstehen kontinuierliche Datenströme, die eine Art Signal darstellen: etliche Ereignisse, die in hoher Frequenz und großer Vielfalt auf das System einwirken.

Diese Signale müssen aufgezeichnet, gefiltert, aggregiert und interpretiert werden, um einen klaren Überblick über die tatsächliche Ressourcenverwendung zu gewinnen. Die Verarbeitung dieser Signale ähnelt stark klassischen Problemen der Signalverarbeitung, bei denen es um das Erfassen, Verstehen und Verarbeiten von zeitabhängigen Daten geht. Ein Kernaspekt dabei ist die Frage nach der Sampling-Rate, also der Häufigkeit, mit der Daten über Änderungen an Ressourcen erfasst werden. Gemäß dem Nyquist-Shannon-Abtasttheorem braucht ein Signal eine Mindestabtastrate, um ohne Informationsverlust rekonstruiert werden zu können. Dies bedeutet in einem Abrechnungssystem, dass Änderungen am Speicherverbrauch, der Anzahl von Lese- oder Schreibzugriffen ausreichend oft erfasst werden müssen, um eine realitätsnahe Abbildung zu gewährleisten.

Zu seltenes Sampling führt zu Ungenauigkeiten und potenzieller Fehlbewertung, zu häufiges Sampling wiederum belastet Infrastruktur und Performance. Bei Systemen mit Millionen von Kunden und Milliarden von Datenpunkten pro Sekunde wird deutlich, dass naive Sampling-Strategien, wie periodische Vollerhebungen aller Daten, kaum praktikabel sind. Hier ist ein datenstromorientierter Ansatz sinnvoll, bei dem jede Änderung als Event erfasst und in Echtzeit oder nahe Echtzeit verarbeitet wird. Diese Events enthalten dann Informationen wie Zeitpunkt, Kunde, betroffene Ressource und Umfang der Änderung. Auf Basis dieser Daten lässt sich der Ressourcenverbrauch als Signal interpretieren, das über Zeit aggregiert und analysiert wird.

Das Konzept einer kontinuierlichen Event-Stream-Verarbeitung entspricht den Grundprinzipien der Signalverarbeitung: Ein Signal wird als eine Folge von diskreten Messungen über die Zeit verstanden. Man kann diese Messungen mit Filtern glätten, mit Aggregationsmethoden verdichten und Peak-Erkennung oder Trendanalysen durchführen. Für die nutzungsbasierte Abrechnung bedeutet das, dass man vergangene, aktuelle und zukünftige Ressourcenverbräuche anhand dieser Signalverarbeitungstechniken zuverlässig bewerten kann, um dann darauf basierend Preise und Rechnungen zu erstellen. Neben der reinen Erfassung stellt sich die Frage nach der Genauigkeit und Zuverlässigkeit der Messungen. In einem hochdynamischen System, in dem Tausende von Datenpunkten pro Sekunde fließen, können Messfehler oder fehlende Events zu einer fehlerhaften Berechnung des endgültigen Logs führen.

Um dem entgegenzuwirken, setzen moderne Abrechnungssysteme Techniken wie Idempotenzschlüssel ein, die sicherstellen, dass keine Doppelzählungen vorgenommen werden. Außerdem erlauben sie es, die Reihenfolge der Ereignisse genau zu kontrollieren, was vor allem bei parallelen Vorgängen und verteilten Systemen von Bedeutung ist. Damit das Abrechnungssystem trotz der hohen Komplexität performant bleibt, muss eine feine Balance zwischen Granularität der Daten und Systemlast gefunden werden. Komplettes Echtzeit-Monitoring aller Ressourcen auf einzelner Kollektionsebene ist oftmals unnötig und durch die enorme Datenmenge und deren Geschwindigkeit kaum machbar. Deshalb greift man häufig auf Aggregationen auf höherer Ebene zurück, etwa auf der Ebene von Datenbanken oder Tenant-Gruppen.

Dieser Kompromiss ermöglicht genau genug Informationen für eine faire Abrechnung, ohne die Infrastruktur zu überlasten. Ein weiterer wichtiger Aspekt ist das sogenannte Heartbeat-Problem. Dabei geht es darum, dass bei inaktiven Ressourcen keine neuen Events generiert werden, obwohl diese Ressourcen weiterhin Speicherplatz oder Kapazität beanspruchen. Ohne eine passende Lösung würden diese „ruhenden“ Ressourcen unbeachtet bleiben, was die Abrechnung verfälscht. Die Antwort darauf sind periodische Heartbeats – regelmäßige Events, die den Status dieser Ressourcen melden, auch wenn keine Änderung vorliegt.

Die Implementierung dieses Prinzips ist technisch anspruchsvoll und ähnelt dem stetigen Sampling in der Signalverarbeitung, um eine kontinuierliche und präzise Messung zu gewährleisten. Die Nutzung von Change Data Capture (CDC) auf Datenbanken ist eine bewährte Methode in diesem Kontext. Dabei werden Änderungen der Datenbank als Eventströme erfasst, ohne das Leistungssystem direkt zu belasten. Diese Events können dann sequenziell bearbeitet werden, wobei auf eine Reihenfolge geachtet wird – eine essentielle Eigenschaft zur Wahrung der Datenintegrität und zur Vermeidung von Widersprüchen bei der Abrechnung. Metering und Billing lassen sich somit klar voneinander trennen.

Metering beschreibt dabei den Prozess der Erfassung und Aufbereitung von Nutzungsdaten. Die Billing-Phase hingegen wendet darauf geschäftslogische Modelle und Preiskalkulationen an, um am Ende eine Rechnung zu generieren. Diese Trennung ermöglicht Skalierbarkeit, Wartbarkeit und Flexibilität im System sowie eine einfache Anpassung an sich ändernde Geschäftsmodelle. Aufgrund der Vielzahl von monatlich erzeugten Events und der hohen Komplexität ist ein Partner für die Abwicklung der eigentlichen Rechnungslegung sinnvoll. Systeme wie Orb sind in der Lage, die Events zu verarbeiten, diverse Preismodelle zu konfigurieren und das gesamte Finanzmanagement abzudecken.

Dies reduziert die Komplexität für den Anbieter, der sich so auf den Kern seiner Dienstleistung konzentrieren kann. Zusammenfassend lässt sich festhalten, dass nutzungsbasierte Abrechnung im Kern eine anspruchsvolle Signalverarbeitungsaufgabe ist. Die zugrunde liegenden Prinzipien wie Signalabtastung, Event-Streaming, Datenaggregation, Reihenfolgetreue und Fehlervermeidung sind entscheidend, um eine faire, transparente und skalierbare Preisgestaltung zu ermöglichen. Langfristig stellt dieser Ansatz sicher, dass Kosten und Nutzen für Kunden und Anbieter synchronisiert werden – was in einer zunehmend digitalisierten Welt von unschätzbarem Wert ist.