Die Entwicklung großer Sprachmodelle (LLMs) hat in den letzten Jahren beispiellose Fortschritte gemacht und verändert maßgeblich die Art und Weise, wie wir mit Technologie interagieren. Insbesondere im Bereich des Programmierens wird oft diskutiert, inwieweit LLMs ihre Coding-Fähigkeiten aus den zahlreichen verfügbaren Quellen im Internet beziehen. Eine Plattform, die in diesem Kontext immer wieder genannt wird, ist StackOverflow. Aber wie viel des Coding-Know-hows, das LLMs heute präsentieren, stammt tatsächlich von StackOverflow? Dieser Frage gilt es genauer nachzugehen. StackOverflow ist seit mehr als einem Jahrzehnt eine der wichtigsten Ressourcen für Programmierer weltweit.

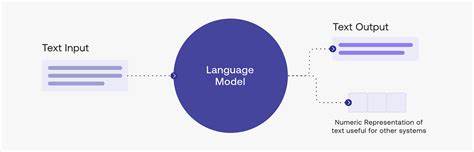

Entwickelt als eine Frage-und-Antwort-Plattform, auf der Entwickler Probleme diskutieren und Lösungen austauschen können, hat sie eine immense Datenmenge an Programmierwissen angesammelt. Die Beiträge reichen von einfachen Code-Snippets bis hin zu komplexen Erklärungen zu Algorithmen und Frameworks. Aufgrund dieser Fülle an strukturierter und leicht zugänglicher Information bietet StackOverflow eine hervorragende Grundlage für das Training von LLMs, die darauf ausgelegt sind, Programmieraufgaben zu verstehen und zu lösen. Große Sprachmodelle werden mithilfe von riesigen Datensätzen trainiert, die aus verschiedenen Quellen im Internet stammen. Dazu gehören unter anderem Open-Source-Repositories, technische Blogs, Dokumentationen sowie eben auch Plattformen wie StackOverflow.

Da StackOverflow Beiträge häufig klar formulierte Fragen und prägnante, gut strukturierte Antworten aufweist, ermöglichen sie es den Modellen, Muster im Umgang mit Programmcode zu erkennen und zu lernen, wie Probleme verständlich dargestellt und gelöst werden können. Viele Experten und Nutzer von LLM-basierten Programmierhilfen berichten, dass Lösungen und Hilfestellungen, die sie durch diese Modelle erhalten, oft Stimmung und Stil der Antworten widerspiegeln, wie sie auf StackOverflow üblich sind. Dies deutet darauf hin, dass die Trainingsdaten von Modellen mit den Inhalten von StackOverflow nahezu durchsetzt sind. Natürlich ist es wichtig zu wissen, dass LLMs nicht einfach einzelne Textstellen aus der Trainingsbasis kopieren – sie erzeugen vielmehr neue Antworten auf Basis erlernter Muster und Zusammenhänge aus den Daten. Dies bedeutet, dass das Codieren durch ein LLM eine Synthese verschiedenster Informationen aus vielfältigen Quellen darstellt, die über das bloße Zusammenfügen von StackOverflow-Antworten hinausgeht.

Dennoch repräsentiert StackOverflow eine zentrale und qualitativ hochwertige Informationsquelle, die zur Robustheit der Programmierfähigkeiten eines Modells maßgeblich beiträgt. Neben StackOverflow sind auch andere Plattformen und Quellen von Bedeutung. GitHub beispielsweise liefert enorm viel Rohcode, der in unterschiedlichen Kontexten geschrieben und dokumentiert ist. Kombiniert mit Foren, Blogposts und offiziellen Dokumentationen entsteht ein umfassendes Bild, das den Lernprozess für LLMs erst ermöglicht. Doch trotz dieser Vielfalt fällt StackOverflow durch seine Community-basierte Struktur und die klare Problem-Lösungs-Architektur aus dem Rahmen, weshalb große Sprachmodelle hier besonders viel lernen können.

Damit verbunden sind jedoch auch Herausforderungen bei der Nutzung von Daten aus StackOverflow im Trainingsprozess. Da Inhalte auf dieser Plattform unter bestimmten Lizenzen stehen, müssen Entwickler von LLMs sicherstellen, dass die Datenquelle korrekt genutzt und respektiert wird, um rechtliche Konsequenzen zu vermeiden. Zudem besteht die Schwierigkeit, die Qualität und Korrektheit der dargebotenen Lösungen zu beurteilen, da nicht alle Beiträge auf StackOverflow zwangsläufig optimal oder fehlerfrei sind. Für Anwender bedeutet dies, dass auch wenn LLMs beeindruckende und schnelle Lösungen bieten, eine kritische Prüfung des generierten Codes weiterhin essentielle Praxis bleibt. Eine Überraschung beim Training von LLMs durch StackOverflow-Inhalte ist die Fähigkeit der Modelle, verschiedene Programmierparadigmen, Syntaxsysteme und Problemstellungen zu erfassen – von einfachen Script-Aufgaben bis hin zu komplexen Algorithmen und Systemdesigns.

Dies zeigt, dass die durch die Modelle gezogenen Kenntnisse über das Portfolio der auf StackOverflow vorhandenen Vielfalt an Programmierdisziplinen hinausgehen. Darüber hinaus hat der Einfluss von StackOverflow weitreichende Auswirkungen auf die Art und Weise, wie Entwickler mit diesen KI-Werkzeugen arbeiten. Durch die Nähe zu den typischen Diskursen und Lösungsansätzen der Entwicklercommunity ermöglichen LLMs eine intuitive Interaktion. Nutzer fühlen sich häufig an ihre vertrauten Werkzeuge und Problemlösungsstrategien erinnert, was die Akzeptanz und den produktiven Einsatz solcher Modelle fördert. Zusammenfassend lässt sich also festhalten, dass ein erheblicher Teil der Programmierkompetenz von großen Sprachmodellen aus der Nutzung und Verarbeitung von Inhalten von StackOverflow stammt.

Diese Plattform stellt eine detailreiche und strukturierte Quelle für Programmierwissen dar, die LLMs dabei unterstützt, ihre Fähigkeiten effizient zu entwickeln und anzuwenden. Dennoch ist StackOverflow nur eine von vielen Quellen im gesamten Universum an Trainingsdaten, die für die Entwicklung solcher Modelle entscheidend sind. Für Entwickler und Nutzer bleibt es wichtig zu verstehen, dass LLMs die aus StackOverflow gewonnenen Informationen nicht eins zu eins übermitteln, sondern diese kreativ und kontextabhängig anwenden, um individuelle Lösungen zu generieren. Die Zukunft wird zeigen, wie sich diese Beziehung zwischen Plattformen wie StackOverflow und künstlicher Intelligenz weiterentwickelt und wie sich die Trainingspraktiken und datentechnischen Grundlagen weiter verbessern lassen, um noch zuverlässigere und leistungsfähigere Programmierassistenten zu erschaffen.