Die Transformer-Architektur hat die Welt der künstlichen Intelligenz revolutioniert, insbesondere im Bereich der Verarbeitung natürlicher Sprache. Ein herausragendes Modell, das breite Aufmerksamkeit erlangt hat, ist GPT-2 von OpenAI. Doch was macht dieses Modell so leistungsfähig? Ein entscheidender Bestandteil sind die sogenannten Aufmerksamkeitsgewichte, die nun zunehmend visuell aufbereitet und besser verständlich gemacht werden. Die Visualisierung dieser Aufmerksamkeitsgewichte bietet nicht nur Forschern und Entwicklern, sondern auch Interessierten aus der breiten Öffentlichkeit einen faszinierenden Einblick in die inneren Abläufe moderner Sprachmodelle. Um die Bedeutung der Visualisierung der Aufmerksamkeitsgewichte im GPT-2 Modell zu verstehen, ist ein kurzer Blick auf die Funktionsweise der Transformer-Architektur hilfreich.

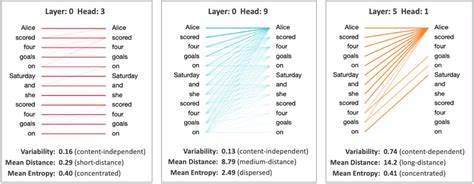

Die Aufmerksamkeit – oder Attention – ermöglicht es dem Modell, relevante Teile eines Eingabetextes zu fokussieren und dadurch Zusammenhänge besser zu erkennen. Statt Eingabesequenzen linear zu verarbeiten, betrachtet das Modell jedes Token, also einzelne Wörter oder Bestandteile von Wörtern, im Kontext aller anderen Tokens. Dabei werden sogenannte Aufmerksamkeitsscores berechnet, die anzeigen, wie stark ein Token bei der Verarbeitung eines anderen berücksichtigt wird. Diese Scores sind essenziell für das Verständnis der Modellentscheidungen und stellen die Grundlage für die Fähigkeiten von GPT-2 dar. Die Visualisierung der Aufmerksamkeitsgewichte erfolgt durch die Darstellung der Verbindungen zwischen Abfrage- und Schlüssel-Tokens innerhalb der einzelnen Transformerschichten, auch als Blöcke bezeichnet.

Im Fall von GPT-2 (kleine Version) verfügt das Modell über zwölf solcher Aufmerksamkeitsschichten. In einer innovativen Visualisierungsmethode werden die Aufmerksamkeitsscores als gewichtete Verbindungen entlang verschiedener Achsen dargestellt: Die einzelnen Aufmerksamkeitshäupter befinden sich übereinander gestapelt auf der y-Achse, während die x- und z-Achsen die Beziehung zwischen den Token-Ketten abbilden. Diese dreidimensionale Darstellung ermöglicht es, detailliert zu beobachten, wie sich die Aufmerksamkeit von einem Wort zum nächsten verteilt. Besonders interessant ist die Möglichkeit, mit der Visualisierung flexibel zu agieren. Der Nutzer kann durch das Modell ziehen, hineinzoomen und so verschiedene Bereiche der Aufmerksamkeitsmatrix genauer unter die Lupe nehmen.

Hinzu kommt eine interaktive Funktion, die es erlaubt, über spezifische Punkte zu fahren, um die exakten Aufmerksamkeitswerte sowie die zugehörigen Abfrage-Schlüssel-Paare anzuzeigen. Dadurch wird das abstrakte Konzept der Attention in greifbare, nachvollziehbare Daten verwandelt. Die Visualisierung setzt auch auf eine logarithmische Skalierung der Punktgrößen, um sogenannte "Attention Sinks" besser erfassen zu können. Diese sind Stellen mit besonders hohen Aufmerksamkeitswerten, die wichtige Schlüsselwörter oder Phrasen im Text hervorheben. Durch den logarithmischen Maßstab lassen sich sowohl hohe als auch niedrige Aufmerksamkeitswerte gut unterscheiden, was die Analyse und das Verständnis deutlich verbessert.

Ein weiterer bedeutender Aspekt ist die Möglichkeit, verschiedene Eingabeparameter wie die Eingabe eines neuen Anfangstokens - in diesem Fall das sogenannte <bos>-Token – zu verändern und dessen Einfluss auf die Aufmerksamkeit zu beobachten. Zusätzlich können Parameter wie Temperatur und Top-k, die das Sampling-Verfahren bei der Textgenerierung steuern, eingestellt werden, um unterschiedliche Verhaltensweisen des Modells in Echtzeit sichtbar zu machen. Diese Visualisierungen sind nicht nur ein leistungsstarkes Werkzeug für Entwickler und Forschende, sondern auch eine Brücke zur breiteren Öffentlichkeit. Indem sie den Prozess der Textaufbereitung und -generierung transparenter machen, fördern sie das Verständnis für künstliche Intelligenz und mindern Ängste, die oft durch die schwarze-Box-Natur vieler neuronaler Netze entstehen. Zudem tragen sie zu einer verbesserten Diagnostik bei, indem mögliche Schwachstellen oder Fehlerquellen in den Transformerschichten präzise sichtbar gemacht werden.

Die Entstehung solcher visuellen Tools ist auf eine rege Gemeinschaft von Forschern und Entwicklern zurückzuführen. Ein bemerkenswertes Projekt, das als Inspiration diente, ist die "Transformer Explainer"-Plattform von Cho et al., die bereits vor einiger Zeit erste interaktive Erklärungen zu Transformern lieferte. Weiterhin brachte Brendan Bycroft mit seinem „3D LLM“ einen innovativen Ansatz für dreidimensionale Visualisierungen großer Sprachmodelle ein. Solche Pionierleistungen haben die Basis für zahlreiche nachfolgende Projekte geschaffen, die das Verständnis von Sprachmodellen auf ein neues Niveau heben.

Die Relevanz der Visualisierung von Aufmerksamkeitsgewichten im Zusammenhang mit GPT-2 geht weit über rein akademisches Interesse hinaus. Unternehmen, die NLP-basierte Anwendungen entwickeln, können durch diese Einblicke ihre Modelle besser optimieren und validieren. Insbesondere beim Erkennen von Bias oder dem Nachvollziehen von Fehlentscheidungen bietet die visuelle Darstellung eine effiziente Unterstützung. Auch im Bereich der Ausbildung und Weiterbildung spielt sie eine Rolle als didaktisches Mittel, um komplexe Konzepte verständlich zu vermitteln. Darüber hinaus eröffnet die Visualisierung neue Perspektiven für die Weiterentwicklung von Architekturen.

Forscher können analysieren, wie sich die Aufmerksamkeit im Verlauf der Verarbeitung verschiebt, und so Anhaltspunkte für Verbesserungen wie effizientere Aufmerksamkeitsschemata oder spezialisierte Kopfkonfigurationen gewinnen. Die Möglichkeit, solche Zusammenhänge visuell und interaktiv zu erforschen, beschleunigt den Innovationsprozess und fördert das Entwickeln neuer, leistungsfähigerer Modelle. Schließlich ist die Gratulation und Widmung des Entwicklers eines solchen Projekts an wichtige Personen seines Lebens ein berührendes Detail, das auch zeigt, wie menschlich die Arbeit hinter hochkomplexen Technologien sein kann. Persönliche Motivationen und Wertschätzung sind oft treibende Kräfte hinter bahnbrechenden Innovationen und reflektieren den menschlichen Aspekt im Bereich der Technologieentwicklung. Zusammenfassend lässt sich festhalten, dass die Visualisierung der Aufmerksamkeitsgewichte des GPT-2-Modells eine Schlüsselrolle dabei spielt, die Mechanismen moderner Sprachmodelle zu entschlüsseln und zugänglich zu machen.

Sie bietet vielfältige Vorteile von Forschung bis Praxis, bringt Komplexität auf eine verständliche Ebene und fördert die Akzeptanz und Weiterentwicklung künstlicher Intelligenz. Wer sich tiefer mit der Transformer-Technologie und deren Anwendungen im Bereich der Sprachverarbeitung beschäftigen möchte, findet in der Visualisierung der Aufmerksamkeitsgewichte ein unverzichtbares Werkzeug, das Transparenz und Verständnis gleichermaßen steigert.