Die rasante Entwicklung von Künstlicher Intelligenz hat in den letzten Jahren insbesondere im Bereich der Bild- und Videogenerierung für erhebliches Aufsehen gesorgt. Unter den vielen Innovationen, die den Sektor der kreativen Medienproduktion revolutionieren, sticht das Projekt Wan als ein wegweisendes Beispiel hervor. Wan stellt eine offene und fortschrittliche Familie groß angelegter Video-Generierungsmodelle dar, die auf modernster Technologie basiert und sich durch ihre Vielseitigkeit sowie Leistungsstärke auszeichnet. Die Wan-Modelle repräsentieren eine neue Ära im Bereich der KI-Videoproduktion und sorgen für reichhaltige, hochwertige und komplexe Videoinhalte, die sowohl für professionelle Anwendungen als auch für individuelle Nutzer zugänglich sind. Die Grundidee von Wan beruht auf der Integration innovativer Verfahren zur Verarbeitung und Generierung von Videoinhalten auf Basis von Text- und Bildvorlagen.

Im Zentrum steht die Version Wan2.1, die als umfassende Suite von Video-Grundlagenmodellen konzipiert ist. Diese Suite vereint verschiedene Modelle, die leistungsfähige Funktionen wie Text-zu-Video, Bild-zu-Video, Video-Bearbeitung sowie Text-zu-Bild und Video-zu-Audio bieten. Durch die Verknüpfung dieser Funktionen entsteht ein beeindruckendes Ökosystem, das weit über herkömmliche Ansätze hinausgeht und Anwendern neue kreative Freiräume eröffnet. Ein hervorstechendes Merkmal von Wan2.

1 ist die hohe technische Leistung, die in Tests und Vergleichen mit bestehenden offenen sowie kommerziellen geschlossenen Systemen klar dominierend ist. Besonders bemerkenswert ist die Fähigkeit des Modells, auf modernen Consumer-Grafikkarten mit vergleichsweise geringem VRAM auszuführen. So benötigt das kleinere T2V-1.3B-Modell zum Beispiel nur 8,19 GB Grafikspeicher und kann auf einer RTX 4090 in wenigen Minuten einen fünf Sekunden langen Kurzclip in 480P erzeugen. Dieser Aspekt macht Wan für viele Anwender zugänglich, die nicht über extrem teure Hardware verfügen, und fördert damit die Demokratisierung hochqualitativer KI-gestützter Videoproduktion.

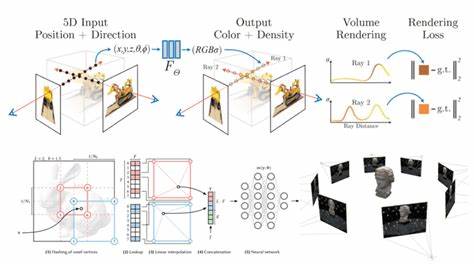

Die Architektur von Wan2.1 basiert auf einem bahnbrechenden dreidimensionalen Variational Autoencoder (3D VAE), der speziell für die Verarbeitung bewegter Bilder entworfen wurde. Wan-VAE ermöglicht eine effektive Kompression und Rekonstruktion von Videoinhalten, ohne dabei die zeitliche Kausalität und Details zu vernachlässigen. Die Methode ermöglicht es, Videos in einer Auflösung bis zu 1080P mit unbegrenzter Länge zu verarbeiten, was besonders für professionelle Videoproduktionen einen echten Mehrwert bietet. Diese Innovation sorgt zudem für eine verbesserte Effizienz bei der Codierung und Decodierung und erlaubt eine nahtlose Integration in verschiedene Arbeitsabläufe der Videobearbeitung.

Ein weiteres Kernstück von Wan2.1 ist das eingesetzte Diffusionsmodell, das auf einer Transformer-basierten Architektur aufbaut. Hierbei werden Techniken wie Flow Matching und ein spezielles MLP-Modul verwendet, um eine präzise und vielseitige Umsetzung von komplexen Videosequenzen zu ermöglichen. Durch die Einbindung mehrsprachiger Textverarbeitung, darunter sowohl Chinesisch als auch Englisch, ist Wan weltweit einsetzbar und kann Inhalte mit robustem Text in den Videos generieren, was sonst nur wenige Systeme zuverlässig leisten. Wan2.

1 unterstützt mehrere Aufgabenbereiche, die weit über die reine Videogenerierung hinausgehen. Neben Text-zu-Video und Bild-zu-Video zählen auch First-Last-Frame-zu-Video und Video-Editing-Modelle dazu. Darüber hinaus gehört auch die Generierung von Audioinhalten aus Videos zu den angebotenen Modulen. Dies verschafft Creators zusätzliche Möglichkeiten, vielfältige audiovisuelle Projekte effizient und mit hoher Qualität umzusetzen. Besonders in Kombination mit der Unterstützung modularer User Interfaces wie ComfyUI oder den Diffusers-Frameworks lässt sich das Potenzial voll ausschöpfen.

Besonders wichtig für die Qualität der erzeugten Videos ist die Fähigkeit von Wan, komplexe Eingaben zu verarbeiten und zielführend zu nutzen. So können Anwender etwa bei der Referenz-Video-Generierung (Reference-to-Video) oder Video-zu-Video-Editing nicht nur Texte, sondern auch Masken und Bildmaterial als Input nutzen, um präzise kontrollierte und kreative Resultate zu erzielen. Diese Flexibilität macht das System für zahlreiche Anwendungsfelder interessant, von Animation und Filmproduktion über Werbung bis hin zu interaktiven Anwendungen und Bildung. Die Benutzerfreundlichkeit des Systems wurde ebenfalls nicht vernachlässigt. Für Entwickler und Anwender stellt Wan eine Vielzahl an Tools bereit, angefangen von vortrainierten Modellen mit verschiedenen Parametern bis hin zu klar dokumentierten Codebasen und Installationsanleitungen.

So ist ein schneller Start möglich, beispielsweise durch einfache „pip install“-Befehle oder direkte Integration in bekannte Frameworks. Auch Optionen zur Nutzung von Multi-GPU-Inferenzstrategien sorgen dafür, dass Modelle in professionellen Umgebungen effektiv skaliert werden können. Ein interessanter Aspekt ist die sogenannte Prompt-Erweiterung, die sich als ein wesentliches Feature für die Verbesserung der Videos herausgestellt hat. Hierbei werden Eingabeaufforderungen (Prompts) durch zusätzliche semantische Kontextualisierung erweitert, um detailliertere und ästhetisch anspruchsvollere Videos zu generieren. Wan bietet mehrere Wege, diese Erweiterung zu realisieren: durch externe APIs wie Dashscope oder durch lokale Modelle wie Qwen.

Diese Erweiterungen bereichern den Textinput um Nuancen, die sich im Ergebnis bemerkbar machen und die kreative Vielfalt erhöhen. Die vielfältigen Möglichkeiten von Wan zeigen sich auch in der aktiven Community und den darauf aufbauenden Projekten. Beispielsweise gibt es Weiterentwicklungen, die einzigartige Funktionen ermöglichen, wie die Animation von menschlichen Bildern oder die Verdopplung der Geschwindigkeit durch Softwareoptimierungen. Solche Community-Integrationen verdeutlichen den offenen Charakter von Wan und bieten Interessierten die Chance, eigene Ideen einzubringen und das Modell weiterzuentwickeln. Des Weiteren überzeugt Wan durch einen gründlichen Prozess der Datenaufbereitung und -bereinigung.

Die Entwickler haben große Bild- und Videodatenmengen gesammelt, dedupliziert und mit einem vierstufigen Qualitätsfilter versehen. Diese sorgfältige Datenbasis trägt erheblich zu der herausragenden Leistung und Stabilität der Modelle bei und bildet das Fundament für eine wirkungsvolle Generalisierung bei der Generierung unterschiedlicher Videoinhalte. Zahlreiche Tests und manuelle Bewertungen demonstrieren die überlegene Qualität von Wan im Vergleich zu sowohl offenen als auch geschlossenen kommerziellen Modellen. Hierbei wurden hunderte Prompts auf unterschiedliche Dimensionen wie visuelle Qualität, Bewegungsfluss, Details und Kohärenz geprüft. Wan erzielt in der Mehrzahl der Kategorien Spitzenwerte und setzt damit einen neuen Standard in der Branche.

Die Öffnung von Wan unter der Apache 2.0 Lizenz stellt einen weiteren wichtigen Schritt dar, um Innovation und Verbreitung zu fördern. Nutzer können die Modelle frei verwenden und anpassen, wobei lediglich rechtliche Einschränkungen hinsichtlich schädlicher Nutzung und illegaler Inhalte berücksichtigt werden. Diese Offenheit sichert die Nachhaltigkeit des Projekts und ermöglicht es Forschern, Unternehmen und Kreativen weltweit, von den Vorteilen der Technologie zu profitieren. Insgesamt zeigt Wan eindrucksvoll, wie moderne KI-Technologie die Videoproduktion grundlegend transformieren kann.

Die Kombination aus state-of-the-art Modellarchitektur, hochqualitativer Datenbasis, mehrsprachiger Textintegration und flexiblen Anwendungsszenarien macht das Projekt zu einer der fortschrittlichsten Plattformen für kreative Medieninhalte. Mit kontinuierlichen Updates, einer aktiven Community und umfassendem Support ist Wan bestens positioniert, um die Zukunft der digitalen Videokunst nachhaltig mitzugestalten und neue kreative Horizonte zu eröffnen.