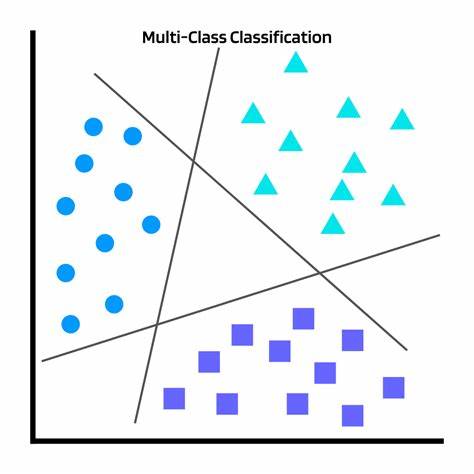

Im Bereich des maschinellen Lernens spielt die Klassifikation eine zentrale Rolle, wenn es darum geht, Daten in vordefinierte Kategorien einzuordnen. Ob im Kundenservice, der medizinischen Diagnostik oder der automatisierten Prozesssteuerung – die korrekte Zuordnung von Eingaben zu Kategorien ist essenziell. Doch die Überprüfung der Leistung solcher Klassifikationsmodelle stellt eine der größten Herausforderungen dar. Die manuelle Bewertung von Modellvorhersagen ist zeitintensiv, ermüdend und fehleranfällig. Diese Prozesse sind oft kostspielig und schwer skalierbar, besonders wenn Modelle im produktiven Einsatz regelmäßig überprüft werden müssen.

Hier kommt der innovative Ansatz eines KI-Schiedsrichters ins Spiel, der darauf abzielt, den Bewertungsprozess zu automatisieren und zuverlässige Entscheidungshilfe zu bieten. Ein KI-Schiedsrichter nutzt große Sprachmodelle (Large Language Models, LLMs), um die Vorhersagen eines Klassifikationsmodells zu beurteilen, indem er prüft, ob die vorhergesagte Kategorie korrekt zur gegebenen Eingabe passt. Die Idee dahinter ist, dem KI-Schiedsrichter den Kontext, die Eingabedaten sowie die vorhergesagte Kategorie zu übermitteln, damit er eigenständig eine Bewertung abgeben kann. Die Automatisierung dieser Bewertung bietet immense Vorteile: reduzierte Kosten, schnellere Rückmeldungen und die Möglichkeit, Modelle kontinuierlich und in Echtzeit zu überwachen. Doch die Entwicklung eines solchen KI-Schiedsrichters, der zuverlässig funktioniert und Vertrauen schafft, erfordert eine strategische Vorgehensweise und systematische Qualitätskontrollen.

Vertrauen und Zuverlässigkeit sind die Schlüsselwerte für eine erfolgreiche Implementierung. Die Leistung des KI-Schiedsrichters muss daher sorgfältig evaluiert werden, um sicherzustellen, dass er die menschlichen Bewertungen in akzeptabler Weise approximiert. Ein bewährter Ansatz ist es, zunächst ein sorgfältig manuell gelabeltes Datenset zu erstellen, das idealerweise reale Nutzungsdaten umfasst. Dieses Datenset sollte von Experten annotiert werden, besonders in Fällen, in denen der Intent der Eingaben unklar ist. Die Diversität der Beispiele spielt eine wichtige Rolle, um unterschiedliche Typen von Absichten abzudecken und sicherzustellen, dass der KI-Schiedsrichter auch bei vielfältigen Szenarien valide Ergebnisse liefert.

Die zu bewertenden Fälle müssen repräsentativ für die anzunehmenden Produktionsszenarien sein, so dass die spätere Nutzung im Echtbetrieb valide abgesichert ist. Der nächste Schritt ist die eigentliche Evaluation, bei der der KI-Schiedsrichter die Kategorien überprüft und seine Entscheidung mit der menschlichen Annotation abgeglichen wird. Eine akzeptable Übereinstimmungsrate liegt idealerweise über 80 Prozent, während Werte darunter auf Verbesserungsbedarf hinweisen. Die Analyse der Fälle, in denen der KI-Schiedsrichter und die menschlichen Gutachter unterschiedlicher Meinung sind, offenbart wertvolle Hinweise. Diese Abweichungen können auf Fehler in der menschlichen Annotation zurückzuführen sein, die zu korrigieren sind.

Ebenso sind mehrdeutige Absichten keine Seltenheit, was entweder eine Entfernung solcher Beispiele oder deren explizite Dokumentation mit ausführlichen Begründungen erfordert. Letzteres ermöglicht eine transparentere und fundiertere Entscheidungsfindung durch den KI-Schiedsrichter, der diese Kontextinformationen in seinen Prompt einarbeiten kann. Es empfiehlt sich, den zu verwendenden Prompt im Laufe der Zeit weiter zu optimieren, um die Genauigkeit zu erhöhen. Die Einbindung zusätzlicher Beispiele für unterschiedliche Intents, die Verfeinerung der Beschreibung von Kategorien und die Auswahl eines geeigneten LLM-Modells sind wesentliche Hebel dafür. Dabei müssen auch technische Rahmenbedingungen wie Kosten, maximal verfügbare Token-Anzahl pro Anfrage und Reaktionsgeschwindigkeit berücksichtigt werden.

Nach mehreren Iterationen lässt sich meist eine hohe Übereinstimmung von mindestens 90 Prozent erreichen, was die Einsatzbereitschaft des KI-Schiedsrichters für den produktiven Betrieb signalisiert. Sobald diese Zuverlässigkeit etabliert ist, kann der KI-Schiedsrichter auf eine Probegruppe echter Produktionsdaten angewandt werden. Dieser Schritt dient dazu, die Einschätzungsfähigkeit bei bisher unbekannten Eingaben zu validieren und die Performance im Live-Umfeld zu prüfen. Auch hier wird eine manuelle Gegenkontrolle angewandt, um die Urteile des KI-Schiedsrichters mit den realen Treffsicherheiten abzugleichen. Aus dieser Phase lassen sich Erkenntnisse gewinnen, die sowohl die Stimuli für den KI-Schiedsrichter als auch das ursprüngliche Klassifikationsmodell verbessern können.

Die Rückkopplungsschleife stellt sicher, dass beide Modelle gemeinsam verbessert werden und somit die Gesamtsystemqualität wächst. Ist die Pilotphase erfolgreich, kann der KI-Schiedsrichter schließlich in Echtzeit auf alle Produktionsdaten angewandt werden, ohne dass noch kontinuierliche manuelle Korrekturen erforderlich sind. Die regelmäßige Anwendung hilft, Schwachstellen im Klassifikationsmodell frühzeitig zu identifizieren sowie Probleme mit bestimmten Kategorien oder bestimmten Ausdrücken aufzudecken. Die Analyse der Bewertung auf Grundlage der Klassifikationsgenauigkeit, Fehlerraten pro Kategorie sowie der Verteilung möglicher Fehler im Kontext der Vorhersage-Sicherheit des Modells liefert wichtige Einblicke. Solche Erkenntnisse sind nicht nur für die Optimierung des Klassifikationsmodells wertvoll, sondern eröffnen auch Möglichkeiten für die Fehlerbehandlung und gezielte User-Experience-Verbesserungen.

Ein systematisches Monitoring und eine halbautomatisierte oder vollautomatisierte Berichterstattung ermöglichen es, den Status der KI-basierten Klassifikation kontinuierlich zu verfolgen und fundierte Entscheidungen hinsichtlich Nachtrainierungen oder Änderungen zu treffen. Darüber hinaus bietet der KI-Schiedsrichter bei der Identifizierung von systematischen oder wiederkehrenden Problemen eine wertvolle Entscheidungsunterstützung. Ein interessantes Zukunftsfeature besteht darin, den KI-Schiedsrichter zu beauftragen, bei einer als falsch bewerteten Vorhersage nicht nur ein Urteil abzugeben, sondern auch eine alternative Kategorie inklusive Begründung vorzuschlagen. Diese zusätzlichen Informationen könnten helfen, das Klassifikationsmodell gezielter anzupassen und Unklarheiten in den Intent-Definitionen zu beseitigen. Die kontinuierliche Verbesserung von Prompts, der Aufbau einer gut gepflegten Datenbasis und eine sorgfältige Beobachtung der Modellleistung bleiben dabei dauerhaft notwendig, um den KI-Schiedsrichter an sich verändernde Anforderungen anzupassen.

Die Implementierung eines solchen KI-Schiedsrichters eröffnet für Unternehmen die Möglichkeit, den zeitaufwendigen und fehleranfälligen Prozess der manuellen Klassifikationsbewertung signifikant zu vereinfachen. So können Ressourcen effizienter eingesetzt und die Qualität der KI-Anwendungen nachhaltig gesichert werden. Gleichzeitig profitieren Teams von schnelleren Feedbackzyklen, mit denen sich Innovationsgeschwindigkeit und Kundenzufriedenheit erhöhen lassen. Das Ziel ist es, eine stabile und zuverlässige Lösung zu schaffen, die flexibel auf unterschiedliche Datenlandschaften und Klassifikationsaufgaben angepasst werden kann. Die Kombination aus menschlicher Expertise und automatisierten KI-Urteilen samt intelligenter Feedbackmechanismen sorgt für einen robusten Mechanismus zur Qualitätssicherung.

Ein derartiger KI-Schiedsrichter kann somit entscheidend dazu beitragen, maschinelle Klassifikationssysteme praxistauglicher und skalierbarer zu gestalten, ohne dass Abstriche bei der Genauigkeit oder dem Vertrauen gemacht werden müssen. Die Technologie steht erst am Anfang ihrer Entwicklung, bietet jedoch heute schon konkrete Mehrwerte, die viele Anwendungsfelder nachhaltig verändern können. Es bleibt spannend zu beobachten, wie sich dieser Ansatz weiterentwickelt und welche weiteren Innovationen entstehen, wenn automatisierte Qualitätssicherung in der Künstlichen Intelligenz zur Standardpraxis wird.