Die Entwicklung von automatischer Spracherkennung (ASR) hat in den letzten Jahren enorme Fortschritte gemacht, angetrieben durch die rapide Zunahme der Rechenleistung und die Verfügbarkeit großer Datenmengen. Traditionell wurde ASR auf leistungsstarken Cloud-Servern ausgeführt, doch der Trend wandelt sich zunehmend in Richtung On-Device-Verarbeitung. Dies ist besonders bedeutsam, wenn es um den Schutz der Privatsphäre der Nutzer, Latenzreduzierung und Betrieb ohne ständige Internetverbindung geht. Apple hat mit seiner Conformer-basierten Spracherkennung ein System vorgestellt, das speziell für den Einsatz auf sogenannten extremen Edge-Computing-Geräten optimiert wurde. Edge-Devices haben naturgemäß nur begrenzte Ressourcen bezüglich Rechenleistung, Speicher und Energieversorgung, was eine besondere Herausforderung für rechenintensive Modelle wie Speech-to-Text-Systeme darstellt.

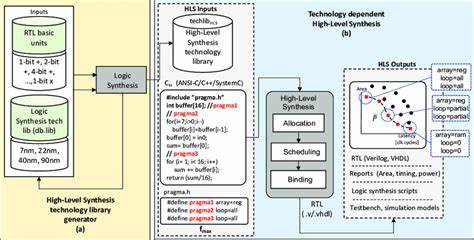

Die Conformer-Architektur vereint die Vorteile von Convolutional Neural Networks (CNNs) und Transformer-Netzen, um sowohl lokale als auch globale Kontextinformationen effizient zu erfassen. Während Transformer-Modelle in den letzten Jahren in verschiedenen Bereichen der Künstlichen Intelligenz große Aufmerksamkeit erlangt haben, galt ihre Komplexität oft als zu hoch für den Einsatz auf massiv ressourcenbeschränkten Geräten. Apples Ansatz war es, die Modellarchitektur so anzupassen, dass sie mit weniger Rechenleistung realisiert werden kann, ohne dabei Einbußen in der Erkennungsgenauigkeit hinzunehmen. Dies ist besonders wichtig bei Anwendungen auf Smartphones, Smartwatches und anderen smarten Heimgeräten, die über geringe Akku-Kapazität verfügen und dennoch stets bereit sein müssen, Spracheingaben verlässlich zu erkennen. Ein zentrales Element der apple-internen Optimierung besteht in der tiefgreifenden Transformation der neuronalen Netzwerkgraphen.

Durch präzises Pruning, Quantisierung und weitere numerische Optimierungen wurde es möglich, die Modelle energieeffizienter zu gestalten. Damit funktioniert die Spracherkennung nicht nur schneller, sondern verbraucht auch deutlich weniger Strom – ein entscheidender Vorteil für tragbare Geräte. In Tests erreichte die Technologie eine beeindruckende Leistung, die über dem 5,26-fachen der Echtzeitgeschwindigkeit (Realtime Factor von 0,19) auf Smartwatches liegt. Dieses Tempo bei gleichzeitig hoher Genauigkeit der Spracherkennung hebt das Anwendungspotenzial enorm. Nicht zuletzt spielt die numerische Stabilität des Systems eine wichtige Rolle.

Apple entwickelte eine umfassende Theorie zu optimalen Prä-Normalisierern, die eine stabile Layer-Normalisierung sicherstellen, unabhängig von der verwendeten Lp-Norm oder der Fließkommazahlpräzision. Diese Innovation verhindert unerwartete Genauigkeitsverluste und steigert die Zuverlässigkeit der automatischen Spracherkennung auch unter anspruchsvollen Rechenbedingungen. Die Vorteile einer On-Device-Spracherkennung auf Edge-Geräten sind vielfältig. Neben einer schnelleren Reaktionszeit auf Eingaben profitieren Nutzer vor allem vom verbesserten Datenschutz, da keine sensiblen Sprachdaten mehr über das Internet zu Servern übertragen werden müssen. Gerade in Zeiten zunehmend strengerer Datenschutzrichtlinien und wachsender Nutzersensibilität kommt diese Eigenschaft besonders gut an.

Zudem reduziert sich die Abhängigkeit von stabilen und schnellen Internetverbindungen, was die Funktionalität der Geräte in abgelegenen Regionen oder während Verbindungsausfällen sicherstellt. Apple demonstriert mit seiner Conformer-basierten Lösung eindrucksvoll, wie anspruchsvolle KI-Anwendungen auch mit begrenzten Ressourcen auf kleinen Geräten realisiert werden können. Die praktische Übertragbarkeit der eingesetzten Optimierungstechniken lässt zudem vermuten, dass ähnliche Konzepte zukünftig vermehrt bei anderen Transformator-basierten serverfreien Anwendungen Einzug halten werden. Der technologischen Entwicklung steht damit ein weiterer Meilenstein bevor, der intelligente und datenschutzfreundliche AI-Anwendungen auf kleinstem Raum ermöglicht. Die Kombination aus verbesserter Modellarchitektur, cleveren neuronalen Netzwerkmodifikationen und hochentwickelten numerischen Optimierungen setzt neue Maßstäbe für die Zukunft der Spracherkennung.