Die rasante Entwicklung der Künstlichen Intelligenz (KI) revolutioniert viele Bereiche unseres Lebens – von der Medizin über das Finanzwesen bis hin zu alltäglichen Anwendungen. Trotz der enormen Fortschritte bleibt ein entscheidender Aspekt oft im Verborgenen: Die Komplexität und Intransparenz moderner KI-Modelle erzeugen den sogenannten Blackbox-Effekt. Das bedeutet, dass es für Menschen oft nicht nachvollziehbar ist, wie und warum KI-Systeme bestimmte Entscheidungen treffen. Diese fehlende Transparenz birgt Risiken und erschwert den verantwortungsvollen Umgang mit der Technologie. Aus diesem Grund gewinnt das Thema der KI-Nachvollziehbarkeit beziehungsweise Interpretierbarkeit zunehmend an Bedeutung und muss als zentrale Priorität in Forschung, Entwicklung und Regulierung etabliert werden.

Der Begriff Blackbox beschreibt Systeme, deren innere Funktionsweise unbekannt bleibt, obwohl man ihre Eingaben und Ausgaben beobachten kann. Bei herkömmlicher Software ist das Verhalten meist durch klar abgegrenzte, menschlich verständliche Anweisungen definiert. Im Gegensatz dazu beruhen moderne KI-Systeme, insbesondere neuronale Netzwerke und tiefe Lernmodelle, auf komplexen mathematischen Strukturen mit Millionen oder sogar Milliarden von Parametern. Diese Parameter interagieren auf nicht-lineare Weise, wodurch das genaue Innenleben schwer zu durchschauen ist. Insbesondere bei großen Sprachmodellen (Large Language Models, LLM) etwa, die in der Lage sind, menschliche Sprache zu verstehen und zu generieren, ist nicht klar ersichtlich, wie bestimmte Antworten oder Vorhersagen zustande kommen.

Diese fehlende Transparenz führt zu mehreren Herausforderungen. Zum einen bestehen Risiken unerwarteter oder unerwünschter Verhaltensweisen der KI, da Menschen nicht eindeutig nachvollziehen können, auf welcher Grundlage die Maschine entschieden hat. Selbst Entwickler haben oft keine detaillierten Erklärungen für das Verhalten ihres Systems parat. Zum anderen erschwert der Blackbox-Effekt die Validierung, also die Überprüfung der Zuverlässigkeit und Fairness der Modelle. Gerade in sensiblen Bereichen wie Gesundheitswesen, Justiz oder Finanzen ist es essenziell, nachvollziehen zu können, welche Faktoren eine Entscheidung beeinflussen, um mögliche Fehler oder Diskriminierungen auszuschließen.

Unklarheiten und Misstrauen gegenüber KI-Systemen könnten damit die Akzeptanz und Verbreitung wichtiger Anwendungen verzögern. Darüber hinaus eröffnet die mangelnde Nachvollziehbarkeit Angriffsflächen für Missbrauch und Manipulation. Es lässt sich beispielsweise schwer erkennen, ob eine KI absichtlich irreführende Informationen generiert hat oder ob das zugrundeliegende Trainingsmaterial problematische Verzerrungen enthält. Diese Gefahren machen es dringend notwendig, die Interpretierbarkeit von KI zu verbessern. Die Forschung an erklärbarer KI (Explainable AI, XAI) versucht genau diese Transparenzprobleme zu adressieren.

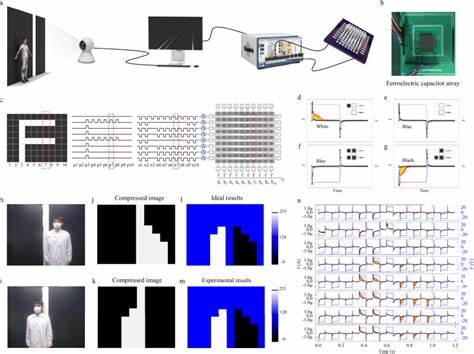

Ziel ist es, die komplexen Modelle so zu gestalten oder mit Hilfsmitteln zu versehen, dass ihre Entscheidungen für Menschen verständlich werden. Dies erfolgt durch verschiedene Ansätze, etwa das Visualisieren von wichtigen Einflussfaktoren, das Erzeugen von nachvollziehbaren Entscheidungsregeln oder das Erklären von Schritt-für-Schritt-Prozessen, die zur jeweiligen Entscheidung geführt haben. Besonders bemerkenswert sind jüngste Fortschritte bei der Analyse neuronaler Netzwerke, die etwa die Identifikation und Kartierung einzelner aktivierter Neuronen und deren Bedeutung für spezifische Funktionen ermöglichen. So konnten Forschende zum Beispiel bei der Firma Anthropic über 30 Millionen interpretierbare Merkmale im sogenannten Claude 3 Sonnet Modell identifizieren. Diese Merkmale entsprechen menschlich verständlichen Konzepten, die in einem neuronalen Netzwerk codiert sind.

Mit Techniken wie sparsamen Autoencodern und KI-gestützter automatische Interpretation wird sichtbar, wie und warum ein Modell seine Ausgabe generiert. Solche Erkenntnisse erlauben es Entwicklern, Fehler gezielt zu isolieren und zu beheben, indem sie neuronale Strukturen analysieren, die für problematische Verhaltensweisen verantwortlich sein könnten. Diese Fortschritte sind aber aktuell vor allem bei mittelgroßen KI-Systemen einsetzbar. Die Skalierung auf extrem große Modelle bleibt eine der großen technischen Herausforderungen. Dass ein besseres Verständnis von KI-Systemen unverzichtbar ist, zeigt sich an praktischen Anwendungen.

Im Bereich der Sicherheit etwa können interpretierbare Modelle schadhafte Programmteile entdecken, die gezielt als Hintertüren oder Schwachstellen eingebaut wurden. Bei Red-Blue-Teams-Übungen – in denen ein Team versucht, Modelle anzugreifen, und ein anderes diese Angriffe abwehren soll – sind interpretierbare Algorithmen wesentlich erfolgreicher darin, Schwächen aufzudecken und entsprechende Abwehrmaßnahmen zu initiieren. Aus Sicht der Gesellschaft bedeutet mehr KI-Nachvollziehbarkeit auch mehr Verantwortung und Kontrolle. Nur wenn es gelingt, die Entscheidungsprozesse von KI transparent zu machen, kann Vertrauen entstehen – eine Grundvoraussetzung für die breite Anwendung. Regulierungen und gesetzliche Rahmenbedingungen spielen in diesem Kontext ebenfalls eine wichtige Rolle: Behörden könnten Interpretierbarkeitsanforderungen als Sicherheitsstandards definieren, die Hersteller erfüllen müssen, bevor ihre Systeme auf den Markt kommen.

Dies würde nicht nur die Sicherheit erhöhen, sondern auch die ethische Nutzung von KI stärken und Missbrauch erschweren. Die Verantwortung liegt nicht allein bei der Wissenschaft und Industrie. Regierungen, Institutionen und Gesellschaft müssen gemeinsam sicherstellen, dass die Entwicklung und Nutzung von KI im Einklang mit den Grundwerten der Transparenz, Fairness und Sicherheit steht. Das bedeutet auch, Wissen zu teilen, Standards zu etablieren und Offenheit für diese komplexen, aber essenziellen Fragestellungen zu fördern. Nur so lässt sich verhindern, dass KI-Technologien zu einer undurchschaubaren Macht werden, deren Entscheidungen wir nicht kontrollieren können.