In einer Zeit, in der globale Vernetzung und interkultureller Austausch immer stärker an Bedeutung gewinnen, stoßen traditionelle Sprachbarrieren zunehmend an ihre Grenzen. Während zahlreiche Übersetzungs-Apps und Geräte für Einzelgespräche entwickelt wurden, bleiben komplexe Situationen mit mehreren Gesprächspartnern eine Herausforderung. Genau hier setzt die neuartige Entwicklung der KI-basierten Übersetzungskopfhörer der University of Washington an, die in der Lage sind, mehrere Sprecher gleichzeitig zu erkennen, ihre Stimmen originalgetreu in 3D-Sound zu klonen und die Übersetzung in Echtzeit bereitzustellen. Diese Innovation transformiert die Art und Weise, wie Menschen weltweit miteinander kommunizieren und schafft neue Potenziale für Bildung, Tourismus und den beruflichen Alltag. Das Problem zahlreicher bisheriger Übersetzungstechnologien liegt darin, dass sie oft nur einen Sprecher isoliert erfassen und danach dessen Äußerungen in einer automatisierten Stimme wiedergeben.

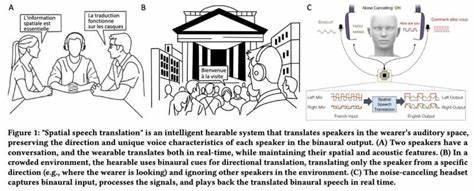

Wenn jedoch mehrere Menschen in einem Raum sprechen, zum Beispiel bei Gruppendiskussionen, Museumsführungen oder Geschäftsbesprechungen, verliert die Übersetzung an Präzision und Verständlichkeit. Der Nutzer erhält lediglich eine monotone Synthese, die nicht die natürliche Klangfarbe und Richtung der Stimmen abbildet. Zudem entsteht häufig das Problem, dass Umgebungsgeräusche oder Überschneidungen der Sprecher die Qualität der Übersetzung erheblich beeinträchtigen. Das von Forschern der University of Washington entwickelte System namens Spatial Speech Translation bietet hier eine bahnbrechende Lösung. Es nutzt handelsübliche, geräuschunterdrückende Kopfhörer, die mit speziellen Mikrofonen ausgestattet sind.

Diese werden mit einem intelligenten Algorithmus kombiniert, der die menschlichen Stimmen in einer Umgebung wie ein Radar in 360 Grad erfasst und fortlaufend die Anzahl der aktiven Sprecher bestimmt. Auf diese Weise kann das System selbst dann mehrere Gesprächspartner erkennen und deren Sprache in Echtzeit übersetzen, wenn sie sich bewegen oder sich die Lautstärke und Stimmeigenschaften verändern. Ein einzigartiger Aspekt der Technologie ist die Fähigkeit, die individuellen Stimmen nicht nur zu übersetzen, sondern auch deren charakteristische Klangfarbe und räumliche Position im 3D-Sound nachzubilden. Dies bedeutet, dass Zuhörer nicht nur verstehen, was gesagt wird, sondern auch intuitiv erfassen, von wem die jeweiligen Worte stammen und wo sich die jeweiligen Sprecher befinden. Dadurch entsteht ein natürliches Hörerlebnis, das herkömmliche Übersetzertechnologien bei Weitem übertrifft.

Die Technik setzt auf eine lokale Datenverarbeitung auf Geräten mit leistungsfähigen Chips wie dem Apple M2, um Datenschutzprobleme zu vermeiden. Cloudbasierte Systeme sind hier problematisch, da sie mit der Übertragung von sensiblen Sprachdaten in externe Server verbunden sind. Das UW-System verarbeitet die Stimmen und Übersetzungen direkt vor Ort, womit das Risiko von Datenmissbrauch minimiert wird. Die Entwickler testeten die Technologie unter realen Bedingungen in unterschiedlichen Innen- und Außenbereichen. In Evaluierungen mit Teilnehmern zeigte sich, dass Nutzer die räumliche Verfolgung von Stimmen und die 3- bis 4-Sekunden-Verzögerung, die für eine höhere Genauigkeit sorgt, als angenehmer und hilfreicher empfanden als frühere Modelle mit kürzerer Verzögerung und schlechterer Genauigkeit.

Dies ist ein wichtiger Schritt, denn Übersetzungen müssen nicht nur richtig sein, sondern sich auch organisch in den Sprachfluss einfügen, damit Gespräche lebendig bleiben. Ein weiterer Vorteil ist die Anpassungsfähigkeit an verschiedene Sprachen. Während im jetzigen Stadium vor allem gängige Sprachen wie Spanisch, Deutsch und Französisch berücksichtigt werden, legt die Systemarchitektur den Grundstein für eine Erweiterung auf etwa hundert Sprachen, wozu bestehende Trainingsmodelle bereits über umfangreiches Know-how verfügen. So könnten Reisende oder interkulturelle Teams künftig ohne Sprachbarrieren effektiv kommunizieren, unabhängig von der Vielzahl der anwesenden Personen. Auch der Einsatz in spezialisierten Kontexten ist denkbar, wobei das System aktuell eher für den allgemeinen Sprachgebrauch optimiert ist.

Zukünftige Weiterentwicklungen könnten auf Fachbegriffe und branchenspezifische Jargons ausgeweitet werden, was in Bereichen wie Medizin, Technik oder Recht besonders hilfreich wäre. Die klanggetreue Nachbildung der Stimmen in 3D bietet zudem Anwendungsgebiete über die Sprachübersetzung hinaus. Beispielsweise könnten Hörprogramme für Menschen mit Hörbeeinträchtigung optimiert werden, indem relevante Stimmen hervorgehoben und in der räumlichen Wahrnehmung unterstützt werden. Auch im Bereich der virtuellen und erweiterten Realität eröffnen sich vielfältige Einsatzmöglichkeiten, um immersive Kommunikationserlebnisse realistischer zu gestalten. Das im Jahre 2025 vorgestellte Projekt ist Resultat der gemeinsamen Arbeit von Doktoranden, Professoren und Forschern der Paul G.

Allen School of Computer Science & Engineering der University of Washington und wird durch Förderungen wie den Moore Inventor Fellow Award ermöglicht. Die Veröffentlichung auf der renommierten ACM CHI Conference im japanischen Yokohama zeigt das hohe Interesse und die Relevanz für die Forschungsgemeinschaft. Für Reisende bedeutet diese Technologie einen Quantensprung. Stellen Sie sich vor, Sie befinden sich auf einer Straßentour durch eine fremde Stadt und hören die Gespräche der Einheimischen in einer Sprache, die Sie nicht sprechen. Die KI-Kopfhörer erkennen automatisch mehrere Sprecher, übersetzen deren Worte und ordnen sie präzise im Raum zu.

So fällt es leichter, kulturelle Nuancen zu verstehen und der Orientierung in komplexen sozialen Situationen zu folgen. Auch im Unternehmensumfeld eröffnen sich neue Möglichkeiten. Internationale Meetings mit mehreren Teilnehmern könnten ohne Dolmetscher nahezu in Echtzeit erfolgen, wobei jeder Teilnehmer seine natürliche Stimme beibehält und die räumliche Dynamik erhalten bleibt. Das erhöht nicht nur das Engagement, sondern auch das Verständnis und die Effizienz von Besprechungen. Trotz aller Fortschritte gibt es weiterhin Herausforderungen, die in den kommenden Versionen adressiert werden sollen.