Wissenschaft gilt oft als Inbegriff von objektivem Wissen. In vielen gesellschaftlichen Bereichen, von Medizin über Umweltpolitik bis hin zu Technologie, vertrauen Menschen auf wissenschaftliche Studien, deren Ergebnisse vermeintlich klar, überprüfbar und zuverlässig sind. Doch wie zuverlässig sind tatsächlich die sogenannten standardwissenschaftlichen Beweise, auf die sich täglich in Medien, Politik und Öffentlichkeit berufen wird? Ein genaueres Hinschauen offenbart eine Reihe von Schwachstellen, die den übermäßigen Glauben an diese Evidenz in Frage stellen. Es lohnt sich, kritisch zu reflektieren, weshalb man standardmäßigen wissenschaftlichen Beweisen nicht uneingeschränkt vertrauen darf und welche Argumente dafür sprechen, lieber mit Vorsicht und gesundem Skeptizismus an solche Daten heranzugehen. Zunächst einmal muss man verstehen, dass wissenschaftliche Methode zwar per Definition ein systematisches Vorgehen zur Erkenntnisgewinnung meint, in der Praxis aber mit menschlichen Schwächen verflochten ist.

Forscher sind keine unfehlbaren Maschinen, sondern Menschen mit individuellen Interessen, Erwartungen und manchmal auch wirtschaftlichen oder politischen Zwängen. Das führt immer wieder zu problematischen Verzerrungen und Fehlschlüssen. Ein zentrales Beispiel ist das sogenannte p-Hacking – die bewusste oder unbewusste Manipulation von Datenauswertungen, um Ergebnisse statistisch signifikant erscheinen zu lassen. Wissenschaftliche Journale verlangen häufig, dass Studien ein bestimmtes Signifikanzniveau erreichen, damit sie veröffentlicht werden. Dies erzeugt einen starken Druck auf Forschende, ihre Daten so zu präsentieren, dass ein positives Ergebnis erzielt wird.

Dabei wird oft hypothesengeleitet nach Ergebnissen gesucht, die bereits bekannt oder gewünscht sind (HARKing - hypothesizing after the results are known). Diese Praktiken führen nicht selten zu einer Überschätzung von Effekten oder sogar zu komplett falschen Behauptungen. Ein weiteres Problem ist die Replizierbarkeitskrise, die derzeit in diversen wissenschaftlichen Disziplinen breiter diskutiert wird. Viele Studien können nicht erfolgreich reproduziert werden, was ihre Validität infrage stellt. Dies führt zu der Erkenntnis, dass eine einmalige Studie oder ein einzelnes Experiment keine verlässliche Wahrheit abbildet.

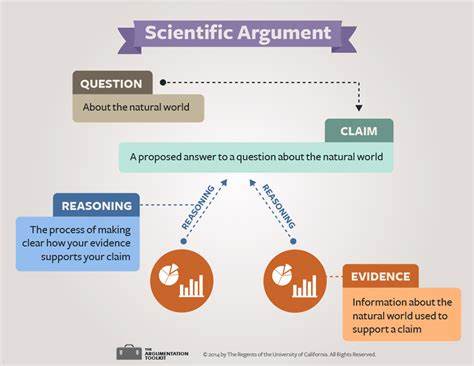

Das Vertrauen in Peer-Review als Qualitätskontrolle nimmt ab, denn Peer-Reviewer können nicht alle Fehler entdecken, und die sozialen Mechanismen des Wissenschaftsbetriebs fördern manchmal das Festhalten an etablierten Paradigmen. Ein sehr grundlegendes Problem liegt in der statistischen Grundlage vieler wissenschaftlicher Beweise. Häufig werden klassische frequentistische Methoden angewandt, bei denen die Fragestellung auf die Wahrscheinlichkeit von beobachteten Daten unter einer angenommenen Nullhypothese abgezielt wird. Dabei wird die Wahrscheinlichkeit, dass das beobachtete Ergebnis oder ein extremeres Ergebnis unter der Annahme der Gültigkeit der Nullhypothese eintritt, berechnet. Was jedoch kaum verstanden wird, ist, dass daraus nicht direkt die Wahrscheinlichkeit folgt, dass die Nullhypothese tatsächlich falsch oder richtig ist.

Auch ist die Bedeutung eines p-Werts in der Praxis oft missinterpretiert und führt zu falschen Schlussfolgerungen. Alternativ und aus Sicht vieler moderner Statistikexperten sinnvoller ist der Bayessche Ansatz, der versucht, eine Ausgangswahrscheinlichkeit (Prior) für eine Hypothese mit den erhobenen Daten zu einer aktualisierten Wahrscheinlichkeit (Posterior) zu verknüpfen. Trotz seiner theoretischen Vorteile wird der Bayessche Ansatz in den meisten wissenschaftlichen Studien kaum angewandt, zum Teil weil die Wahl der Prioren subjektiv ist und für viele Forscher eine zu große Umstellung darstellt. Doch gerade hier zeigen sich die Möglichkeiten, eine evidenzbasierte Einschätzung mit mehr Transparenz und logischer Stringenz zu versehen. Die gesellschaftliche Verquickung von Wissenschaft mit wirtschaftlichen und politischen Interessen verstärkt die Problematik zusätzlich.

Wissenschaftliche Ergebnisse werden oft in Medien und Politik überhöht oder vereinfacht dargestellt, um bestimmte Narrative zu stützen, sei es zur Rechtfertigung von Investitionen, Regulierung oder gesellschaftlichem Wandel. Die Gefahr hierbei ist, dass komplexe, unsichere oder noch nicht ausreichend validierte wissenschaftliche Erkenntnisse als unumstößliche Fakten präsentiert werden. Das führt zu einer Entwertung der Wissenschaft als Suchprozess und kann das Vertrauen der Bevölkerung untergraben. Darüber hinaus wird der Umstand gerne übersehen, dass Wissenschaft per Definition ein Prozess des ständigen Zweifelns und Hinterfragens ist. Neue Erkenntnisse ersetzen alte Theorien, und „Wahrheiten“ sind stets vorläufig.

Dies ist einerseits eine Stärke, doch in der öffentlichen Wahrnehmung entsteht oft der Eindruck einer festen Wahrheit, an die man sich letztendlich klammern kann. Wenn später diese vermeintlichen Wahrheiten korrigiert oder verworfen werden, wächst die Skepsis gegenüber der Wissenschaft insgesamt – trotz ihrer eigentlichen methodischen Offenheit. Eine wichtige Erkenntnis für Laien und auch für Experten ist daher, dass wissenschaftliche Beweise immer im Kontext betrachtet werden müssen. Einzelne Studien, insbesondere solche mit kleinen Stichproben oder fragwürdiger Methodik, sollten nicht als absoluter Maßstab für echte Erkenntnis gelten. Stattdessen ist die Betrachtung des Gesamtbildes entscheidend, die Überprüfung durch verschiedene Methoden und unabhängige Forschungsgruppen sowie eine transparente Darstellung der Unsicherheiten und Limitationen.

Ein weiterer kritischer Punkt ist die Art des Beweises, der in der Wissenschaft verlangt wird. Insbesondere in den Sozial- und Lebenswissenschaften ist der direkte Nachweis kausaler Zusammenhänge schwierig. Oftmals werden Korrelationsstudien fälschlich als Ursache-Wirkung-Beweise interpretiert. Dazu gesellen sich Effekte wie Selektionsbias oder Publikationsbias, die das Gesamtbild verzerren können. Das führt dazu, dass Ergebnisse, die in der ersten Studie spektakulär erscheinen, später durch weiterführende Forschung nicht bestätigt werden.

Es gibt deshalb eine wachsende Bewegung innerhalb der Wissenschaft, die fordert, mehr Gewicht auf Transparenz, Datenoffenlegung, präregistrierte Studien und die Förderung von Replikationsstudien zu legen. Erst durch solche Mechanismen kann das Vertrauen in wissenschaftliche Evidenz wieder gestärkt werden, und manipulative Praktiken wie p-Hacking werden erschwert. Ein kritisches Bewusstsein in der Öffentlichkeit und bei Entscheidungsträgern ist jedoch weiterhin unabdingbar. Gerade in Zeiten, in denen wissenschaftliche Erkenntnisse maßgeblich politische Entscheidungen und gesellschaftliche Entwicklungen bestimmen, ist es essenziell, den Unterschied zwischen vorläufigen Erkenntnissen, Hypothesen und gesicherten Fakten zu verstehen. Wissenschaft ist kein Orakel, sondern ein dynamischer Prozess, der Fehler macht, korrigiert und sich weiterentwickelt.

![A man living at an international airport [video]](/images/3DCC0EDE-7AC3-4755-BDCD-1AC949A2AC9B)