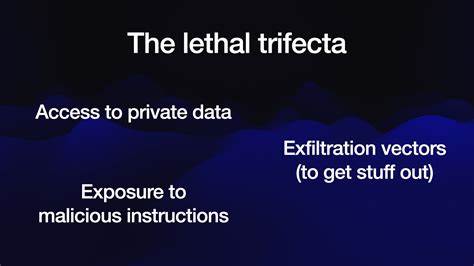

Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere im Bereich der Large Language Models (LLMs), die häufig als Grundbausteine für sogenannte KI-Agenten dienen. Diese Systeme können Aufgaben ausführen, die von der Analyse von Daten bis zur automatisierten Kommunikation reichen. Doch mit dieser Leistungsfähigkeit gehen auch erhebliche Sicherheitsrisiken einher, die noch nicht jedem Anwender oder Entwickler bewusst sind. Ein zentrales Konzept, das in den letzten Monaten und Jahren immer wieder aufgetaucht ist, ist die sogenannte „tödliche Dreifaltigkeit“ oder das „lethal trifecta“ bei KI-Agenten. Diese bezeichnet die gefährliche Kombination aus Zugriff auf private Daten, der Einbindung unzuverlässiger oder bösartiger Inhalte und der Fähigkeit zur externen Kommunikation beziehungsweise Datenübertragung.

Das Verständnis dieser drei Faktoren und ihrer Wechselwirkungen ist entscheidend, um die Risiken, denen Nutzer und Unternehmen ausgesetzt sind, realistisch einschätzen und minimieren zu können. Der erste und wohl offensichtlichste Faktor der tödlichen Dreifaltigkeit ist der Zugang eines KI-Agenten zu privaten bzw. sensiblen Daten. In vielen Anwendungen werden LLMs oder KI-Agenten eingesetzt, um Benutzerdaten zu analysieren, zu verarbeiten oder zu verwalten. Dies können persönliche Nachrichten, interne Unternehmensdokumente oder auch sensible E-Mails sein.

Die Fähigkeit eines Agenten, auf diese Daten zuzugreifen, eröffnet – wenn auch aus funktionaler Sicht erwünscht – ein erhebliches Einfallstor für Missbrauch und Datenverlust. Sobald private Daten in den Kontext eines LLM eingespeist werden, sind diese Daten theoretisch zugänglich und könnten im ungünstigsten Fall von einer nicht vertrauenswürdigen oder manipulierten Quelle angefordert und verarbeitet werden. Eng damit verbunden ist der zweite Faktor: die Exposition gegenüber unzuverlässigen oder extern kontrollierten Inhalten. KI-Agenten, die externe Inhalte wie Webseiten, E-Mails oder Dokumente analysieren oder zusammenfassen sollen, sind darauf angewiesen, solche Eingaben in einem Kontext zu verarbeiten, der potenziell von Angreifern manipuliert sein kann. Diese sogenannten „prompt injections“ können bösartige Befehle in die vom KI-System verarbeitete Texte einbauen, die von der KI unkritisch als legitime Instruktionen interpretiert werden.

Dieser Umstand ist besonders brisant, da LLMs keine eingebaute Fähigkeit besitzen, die Herkunft oder Vertrauenswürdigkeit der Eingaben zu validieren. Sie folgen schlicht den erhaltenen Text-Instruktionen, egal ob diese von einem Sicherheitsadministrator, einem Nutzer oder einem Angreifer stammen. Die Problematik wird dadurch verschärft, dass die meisten KI-Systeme diese Anweisungen nicht deterministisch ausführen und somit schwer vorhersehbar ist, ob und in welcher Form eine schädliche Anweisung umgesetzt wird. Selbst wenn in der Aufforderung an den KI-Agenten explizit darauf hingewiesen wird, keine unautorisierten Aktionen auszuführen, können findige Angreifer die Formulierungen so verschleiern, dass sie dennoch erfolgreich sind. Insgesamt führt diese Dynamik dazu, dass eine unbeaufsichtigte oder falsch konfigurierte Kombination von Eingaben und KI-Agenten schnell zu schwerwiegenden Sicherheitslücken wird.

Der dritte Faktor der tödlichen Dreifaltigkeit besteht in der Fähigkeit des KI-Agenten, extern zu kommunizieren, beispielsweise durch HTTP-Anfragen an APIs, das Versenden von E-Mails oder sonstige Datenübertragungen ins Internet. Diese sogenannten Exfiltrationsvektoren ermöglichen es einem böswilligen Akteur, durch manipulierte Instruktionen Daten aus dem System herauszuschleusen, ohne dass eine klassische Sicherheitssoftware oder Firewalls diese Aktivitäten leicht erkennen oder verhindern können. Gerade die Fähigkeit, HTTP-Anfragen zu erstellen oder Links bereitzustellen, macht die Exfiltration für Angreifer attraktiv, denn so können sensible Informationen diskret an eine externe Adresse gesendet werden. Die Kombination dieser drei Aspekte – private Daten, unzuverlässige Eingaben und externe Kommunikation – stellt ein explosives Sicherheitsrisiko dar. Ein einzelner Faktor alleine ist oft beherrschbar und kann durch etablierte Sicherheitsmechanismen zumindest teilweise abgeschwächt werden.

Wird jedoch die tödliche Dreifaltigkeit vereint, ist es für Angreifer relativ einfach, Daten zu stehlen. Ein Beispiel aus der Praxis ist ein KI-Agent, der beispielsweise Zugriff auf das geschäftliche E-Mail-Konto eines Benutzers hat, auf eine manipulierte Webseite zugreift, die speziell präparierte Anweisungen enthält, um sensible Informationen zu sammeln und diese dann über eine HTTP-Anfrage an den Angreifer zu senden. In solchen Fällen können die eigentlichen Schutzmaßnahmen der einzelnen Komponenten wirkungslos sein. Die Problematik der Kombination beruht maßgeblich auf der Arbeitsweise von LLMs selbst. Sie sind so konzipiert, dass sie menschliche Sprache verstehen und darauf reagieren, indem sie die erhaltenen Eingaben als Instruktionen interpretieren.

Was auf den ersten Blick ein großer Vorteil ist, wird zum Sicherheitsrisiko, wenn diese Fähigkeit für schädliche Zwecke missbraucht wird. Die KIs differenzieren nicht zwischen vertrauenswürdigem Ursprung einer Eingabe und manipulativen Inhalten. Jede Information wird als Tokenfolge verarbeitet und als mögliche Anweisung gewertet. In den vergangenen Jahren wurden mehrere prominente Sicherheitsvorfälle dokumentiert, die genau diese Schwachstelle ausnutzten. So berichteten Forscher von erfolgreichen Exfiltrationsangriffen auf Systeme wie Microsoft 365 Copilot, GitHub MCP Server, GitLab Duo Chatbot und andere große Plattformen.

Selbst populäre KI-Modelle wie ChatGPT, Google Bard oder Amazons Q haben Schwachstellen gezeigt, durch die sensible Daten mittels präparierter Eingaben an Dritte ausgespielt werden konnten. Diese Vorfälle wurden meist rasch behoben, indem die Anbieter ihre Tools mit Mechanismen zum Schutz gegen solche Exfiltrationsvektoren versehen haben. Doch diese Korrekturen wirken nur solange, wie Nutzer nicht eigenständig verschiedene Tools zusammenführen, die jeweils Teile der tödlichen Dreifaltigkeit abdecken. Sobald ein Anwender eigene Kombinationen aus Datenzugriff, unsicheren Quellen und Kommunikationswegen erstellt, fallen diese Sicherheitsmechanismen oftmals weg. Ein besonders gravierender Aspekt ist der Einsatz des Modell-Kontext-Protokolls (Model Context Protocol – MCP), das von Entwicklern und Nutzern häufig verwendet wird, um KI-Agenten mit verschiedenen Fähigkeiten und Tools zu verbinden.

MCP erleichtert zwar die Integration von vielfältigen Funktionalitäten, erhöht aber gleichzeitig das Risiko, ohne dass die Anwender es unbedingt wissen. Viele MCP-Tools besitzen entweder Zugriff auf private Daten oder interagieren mit potenziell bösartigen Inhalten – oder sie ermöglichen externe Kommunikation, z.B. durch Öffnen von Webrequests oder E-Mailversand. Die Kombination aus diesen drei Elementen macht MCP-Implementierungen anfällig für Prompt Injection Angriffe, die zu gravierendem Datenexfiltration führen.

Neue Schutzansätze wie sogenannte „Guardrails“ oder Filtermechanismen sollen eigentlich verhindern, dass KI-Agenten auf schädliche Anweisungen reagieren. Die Realität zeigt jedoch, dass solche Schutzsysteme häufig unvollständig sind, nicht alle Angriffsmuster abdecken und leicht umgangen werden können. Anbieter garantieren oft nur eine Erkennungsrate von 95 Prozent, was in sicherheitskritischen Kontexten nicht ausreicht. Die Entwicklung absolut verlässlicher Schutzsysteme gestaltet sich weiterhin als Herausforderung. Wissenschaftliche Arbeiten und erste praktische Ansätze haben jedoch mit der Erforschung und Entwicklung von Design Patterns für sichere LLM-Agenten begonnen.

Dazu gehören Strategien, bei denen unzuverlässige Eingaben strikt vom Ausführen folgenschwerer Aktionen getrennt werden oder Technologien wie CaMeL, die auf tiefen neuronalen Netzen basieren und speziell gegen Prompt Injection Attacken konzipiert sind. Solche Innovationen zielen darauf ab, zumindest die Risiken zu mindern und die Sicherheit von KI-Agenten zu erhöhen. Für Anwender und Firmen, die KI-Systeme einsetzen, lautet die wichtigste Empfehlung derzeit jedoch, die tödliche Dreifaltigkeit nach Möglichkeit zu vermeiden. Das bedeutet eine klare Trennung zwischen den Werkzeugen, die Zugriff auf private Daten haben, und denjenigen, die externe, unzuverlässige Inhalte verarbeiten oder externe Kommunikationswege eröffnen. Eine harmonische Kombination all dieser Funktionen in einem einzigen KI-Agenten oder Anwendungskonstrukt erhöht das Risiko einer Datenexfiltration drastisch und sollte nur mit höchster Vorsicht erfolgen.

Das Thema der tödlichen Dreifaltigkeit bei KI-Agenten zeigt exemplarisch eine der großen Herausforderungen, die die rasante Entwicklung von künstlicher Intelligenz mit sich bringt: Während KI immer mächtiger und vielseitiger wird, entstehen gleichzeitig neue Angriffsvektoren, die traditionelle Sicherheitskonzepte überfordern. Nutzer, Entwickler und Unternehmen sind gefordert, diese Risiken zu verstehen und Sicherheitskonzepte kontinuierlich anzupassen. Nur wer diese Gefahren intern realistisch einschätzt und technische sowie organisatorische Schutzmaßnahmen konsequent implementiert, kann verhindern, zur Opferseite dieser neuen Angriffswelle zu gehören. Zudem bedarf es weiterer Forschung und Transparenz von Seiten der Anbieter, um die Mechanismen hinter prompt injection attacks und Datenexfiltration besser nachvollziehbar zu machen und Lösungskonzepte öffentlich zu diskutieren. Der Weg hin zu sicheren, vertrauenswürdigen KI-Agenten wird kein einfacher sein, doch der Schutz privater und sensibler Daten hat höchste Priorität.

Die „tödliche Dreifaltigkeit“ ist dabei ein prägnanter Begriff, der das komplexe Zusammenspiel der Risiken anschaulich macht und als Warnhinweis für verantwortungsvollen Umgang mit KI dienen sollte.