Die Frage, ob ein Jahr ein Schaltjahr ist, mag trivial erscheinen, doch hinter der Schaltjahrberechnung verbirgt sich eine faszinierende Komplexität, die seit Jahrzehnten Entwickler und Algorithmiker beschäftigt. Traditionell beruht die Prüfung auf einer Folge von Modulo-Operationen und Bedingungen, die genau definieren, unter welchen Umständen ein Jahr als Schaltjahr zu gelten hat. Insbesondere im proleptischen Gregorianischen Kalender – der Gregorianischen Zeitrechnung rückwirkend bis zum Jahr 0 angewandt – hängt die Schaltjahresregel von Teilbarkeiten durch 4, 100 und 400 ab. Die klassische Sequenz von Vergleichen und Restbildungen ist klar verständlich, kann aber besonders bei großen Datenmengen oder performancekritischen Anwendungen zu engültigen CPU-Zyklen führen. In einem bemerkenswerten Ansatz stellte Falk Hüffner am 15.

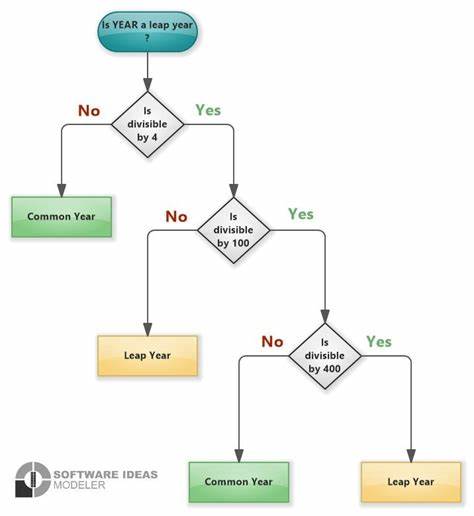

Mai 2025 im Rahmen einer Diskussion auf Hacker News eine radikal optimierte Methode vor, mit der sich Schaltjahre für den Bereich von 0 bis 102499 Jahren in etwa drei CPU-Instruktionen zuverlässig bestimmen lassen. Dieses Verfahren sprengt das klassische Muster, indem es Multiplikation mit einer sogenannten magischen Konstanten, bitweises Maskieren und Vergleich kombiniert. Die resultierende Aussage „ist Schaltjahr?“ wird in einer einzigen Zeile Code berechnet und liegt damit fernab von expliziten if-Abfragen oder teuren Modulo-Operatoren.Das übliche Vorgehen bei der Schaltjahrbestimmung ist bekannt: Ein Jahr ist ein Schaltjahr, wenn es durch 4 teilbar ist, außer es ist durch 100 teilbar, aber wiederum falls es durch 400 teilbar ist, gilt es dennoch als Schaltjahr. Diese Regel lässt sich sauber in einer if-Anweisung umsetzen, die nacheinander prüft, ob y modulo 4 null ergibt, dann y modulo 100 nicht null ist oder schließlich y modulo 400 null ist.

Diese Schritte umfassen mehrere Rechenoperationen mit Übergängen, die je nach Prozessorarchitektur kostspielig in der Laufzeit sein können, insbesondere bei hohem Datenaufkommen. Der insgesamt benötigte Energieaufwand und CPU-Zyklen summieren sich, was vor allem bei eingebetteten Systemen oder zeitkritischen Anwendungen unangenehm ist.Falk Hüffners Trick basiert auf der genetischen Rekombination der klassisch verwendeten Bedingungen und der Suche nach einer universellen, mathematisch kompilierten Bitmuster-Erkennung. Durch heuristische und algorithmische Verfahren (unter anderem der Einsatz des SMT-Solvers Z3 zur bitweisen Constraint-Lösung) wurden drei spezielle Konstanten ermittelt: eine Multiplikationskonstante f, eine Maskenkonstante m sowie ein Schwellwert t. Die Funktionsweise lässt sich vereinfacht so beschreiben, dass das Jahr mit f multipliziert, dann bitweise mit m verundet und mit t verglichen wird.

Das Ergebnis zeigt an, ob es sich um ein Schaltjahr handelt.Dieser Ansatz besitzt eine Reihe von Vorteilen: Er benötigt keine aufwändigen Modulo-Berechnungen, verzichtet auf Sprünge im Kontrollfluss und lässt sich branchless implementieren. Dies reduziert vor allem auf modernen Prozessoren Kosten durch Pipeline-Stalls oder Sprung-Vorhersage-Fehler drastisch. Gleichzeitig fällt die Gesamtzahl der Befehle so gering aus, dass performance-sensible Systeme – von Hochfrequenzhandel bis hin zu Echtzeitanwendungen – profitieren können.Aber wie funktioniert die Methode präzise? Die Erklärung ist komplex und reicht in die Tiefen der Bitarithmetik und modularen Mathematik hinein.

Zuerst werden in der Multiplikationskonstante einzelne Bits so gesetzt, dass relevante Resteigenschaften der Jahreszahl in spezifische, vorher definierte Bitblöcke des Ergebnisses „eingebettet“ werden. Die Maske m filtert anschließend jene Bits, die für die Schaltjahreslogik bedeutsam sind, während der Schwellenwert t eine Art Grenze definiert, bei deren Unterschreitung das Ergebnis als wahr (Schaltjahr) gewertet wird.Im Detail zerlegt sich die Multiplikation in mehrere Blöcke, wobei unterschiedliche Bitfelder unterschiedliche Resteigenschaften widerspiegeln. Einige Bitabschnitte signalisieren, ob die Jahreszahl durch 4 teilbar ist, andere erfassen Aspekte der Teilbarkeit durch 100 oder 400 in reduzierter Form. Aufgrund der sorgfältigen Konstruktion entsprechen diese manchmal etwa modifizierten Multiplikationen, die durch die bitselektiven Vergleiche final in nur einem einzigen Vergleich zusammengefasst werden.

Diese Methode eröffnet so eine fast magisch anmutende Kompression der Schaltjahresregel in eine minimale Instruktionsanzahl.Die Arbeit von Hüffner entdeckte auch, dass dieser „fast magische“ Algorithmus für sehr viele Jahre – bis hin zu über 100.000 – korrekte Ergebnisse liefert, was für sämtliche praxisrelevanten Anwendungen weit mehr als ausreichend ist. Für Zeiten jenseits dieses Bereichs verliert die Methode an Präzision, doch hierfür existieren weiterhin die klassischen Berechnungsmöglichkeiten. Interessant ist auch der erwähnte Übergang auf 64-Bit-Werte, die Jahrhunderte in Milliardenhöhe abdecken können, wodurch das Prinzip für zukünftige Systeme und größere Datumsbereiche erweitert wird.

Darüber hinaus ergibt sich aus der Vermeidung von Verzweigungen eine Verbesserung bei der Code-Pipeline und der CPU-Auslastung. CPU-Zyklen, die sonst durch Sprungvorhersagefehler verloren gingen, bleiben erhalten. Zudem verringert sich die Komplexität der Assembly-Ausgabe, was eingebettete Systeme mit begrenztem Speicher besonders begünstigt. Die Verminderung von Latency-Problemen und Cache-Misses ist ein positiver Nebeneffekt.Eine interessante Beobachtung zeigt sich in praktischen Benchmarks: Während das klassische Schaltjahrverfahren auf CPUs mit branch prediction bei festen Jahren (etwa 2025) sehr schnell arbeitet, verlangsamt es sich bei zufälligen oder unvorhersehbaren Daten, da Branch Mispredictions zusätzliche Taktzyklen kosten.

Die magische Drei-Anweisungen-Lösung hingegen arbeitet flacher, konstanter und erreicht bei echten Zufallsdaten eine bis zu vierfache Beschleunigung gegenüber dem traditionellen Ansatz. Die eingesparte Zeit ist auf maschinennahe Optimierungen zurückzuführen und verdeutlicht, wie wichtig bitweise Rechnung für performante Anwendungen ist.Trotz aller Vorteile ist der universelle Einsatz solcher superoptimierter Funktionen nicht immer sinnvoll. In der Regel arbeiten Datumsbibliotheken in Programmiersprachen wie Python oder C# mit vordefinierten Jahresgrenzen oder abstrahieren das Problem, sodass der Unterschied kaum spürbar wird. In Anwendungen mit vielen Berechnungen wie Kalender-Rendering, astronomischen Simulationen oder wissenschaftlicher Jahresdatenanalyse kann der Gewinn jedoch beträchtlich sein.

Ebenso können Compiler oder virtuelle Maschinen die Technik nutzen, um Schaltjahrprüfungen in niedrigster Latenz auszuführen.Neben der Performance spielt auch die Wartbarkeit eine Rolle. Die ursprüngliche Klarheit der Schaltjahrregel lässt sich im neuen Algorithmus nicht direkt ablesen, weshalb eine Dokumentation unumgänglich ist. Dies relativiert den Vorteil etwas, doch für maßgeschneiderte, performante Kernfunktionen in Systemen, die selten geändert werden, ist dies ein vernachlässigbarer Nachteil.Im weiteren Verlauf der Forschung wurde auch erkannt, dass es durch ähnliche Verfahren möglich ist, verwandte Kalenderfunktionen und andere modulare Entscheidungsprozesse zu optimieren.

Die Algorithmen von Daniel Lemire, Cassio Neri und weiteren Pionieren in der Modulararithmetik erweitern die Methoden und ermöglichen vielschichtige Anwendungsszenarien, die jenseits von einfachem Jahreszyklus liegen.Zusammenfassend lässt sich sagen, dass die Schaltjahrprüfung mit nur drei Anweisungen ein brillantes Beispiel moderner algorithmischer Konstruktion und Bit-fokussierter Optimierung ist. Es zeigt, wie sich komplexe mathematische Regeln in kompakte Maschinenbefehle fassen lassen, unter Ausnutzung der Eigenschaften von Binärarithmetik und modularem Verhalten. Diese Ingenieursleistung steht sinnbildlich für Fortschritte in effizienter Softwareentwicklung und zeigt Wege, selbst scheinbar triviale Abläufe auf ein neues Level zu heben.Für Entwickler bietet sich hier eine spannende Möglichkeit, ihre Programme in puncto Geschwindigkeit und Ressourcennutzung entscheidend zu verbessern.

Gleichzeitig dient das Konzept als Lehrstück für angehende Programmierer und Forschungsinteressierte, welche die Macht der bitweisen Optimierungen und die Kunst, mathematische Gesetze als Computerinstruktionen zu formulieren, kennenlernen möchten. Die Überraschung darüber, wie wenige Instruktionen tatsächlich nötig sind, führt zu einem erweiterten Blick auf Programmierparadigmen und optimierende Compilertechniken.In einer Welt, die immer mehr auf Effizienz und stromsparende Berechnung setzt, gehören solche Entwicklungen nicht nur ins Reich der akademischen Neugierde, sondern finden echte Verwendung in Alltagssoftware, mobilen Geräten und High-End-Computern gleichermaßen. Die Verschmelzung von abstrakter Mathematik mit bitgenauer Implementierung eröffnet faszinierende Möglichkeiten und lautet als zentrale Erkenntnis: Auch altehrwürdige Probleme können durch cleveren Einsatz moderner Werkzeuge neu gedacht und dramatisch beschleunigt werden.