Die Wahl der richtigen Datenbanktechnologie ist eine entscheidende strategische Entscheidung für Unternehmen jeder Größe und Branche. In den letzten Jahren hat sich PostgreSQL als eine der beliebtesten und zuverlässigsten relationalen Datenbanken etabliert, insbesondere wenn Unternehmen ihre Anwendungen skalieren und zugleich Kosten sowie Komplexität im Griff behalten wollen. Doch der Umstieg von einer anderen Datenbank, wie etwa CockroachDB, auf PostgreSQL kann eine anspruchsvolle Herausforderung darstellen, die sorgfältige Planung, technische Expertise und ein Verständnis der jeweiligen Stärken und Schwächen erfordert. Motion, ein Unternehmen, das seit 2022 CockroachDB nutzte, schildert eindrucksvoll die Beweggründe und Erfahrungen beim Wechsel zu PostgreSQL. Anfangs versprach CockroachDB enorme Vorteile, darunter die mühelose horizontale Skalierung, besonders in Multi-Region-Konfigurationen, hohe Verfügbarkeit und eine SQL-kompatible Schnittstelle.

Diese Merkmale waren damals essenziell, um den Anforderungen einer wachsenden Infrastruktur gerecht zu werden, insbesondere unter Berücksichtigung von Datenschutzanforderungen wie der DSGVO. Mit dem Wachstum des Unternehmens stiegen jedoch auch die Kosten und technische Komplexität. Bis 2024 hatte sich die CockroachDB-Rechnung verfünffacht und erreichte mittlere sechsstellige Beträge. Überraschenderweise benötigte das Unternehmen noch keine Multi-Region-Datenlokalisierung und führte vorwiegend einfache transaktionale Abfragen in einer einzelnen Region aus. Somit war die Nutzung einer so komplexen und kostspieligen verteilten Datenbank fragwürdig.

Die Migration zu PostgreSQL wurde durch den Einsatz eines ORMs wie Prisma erleichtert, der eine vergleichende Testung der Migrationsprozesse ermöglichte. In der Praxis zeigten sich bei CockroachDB jedoch immer häufiger Timeouts beim Anwenden von Datenbankschemamigrationen. Entwickler mussten dann manuell und mühsam Migrationen direkt auf der Datenbank ausführen, was den Deployment-Prozess erheblich verzögerte. Insbesondere wurde der Prozess teilweise mehrere Stunden blockiert – ein Zustand, der eine effiziente Weiterentwicklung und Wartung erschwerte. Ein Vergleichstest zeigte eine deutliche Verbesserung bei PostgreSQL: Migrationen, die bei CockroachDB minuten- bis stundenlang dauerten oder sogar fehlschlugen, wurden bei PostgreSQL innerhalb von Sekunden ausgeführt.

Insbesondere der Zusatz eines neuen Datenbankfeldes, der mit Prisma implementiert wurde, dauerte in einer kontrollierten Testumgebung nur zehn Sekunden. Diese Zuverlässigkeit führte nicht nur zu einer Vereinfachung des Entwicklungsprozesses, sondern vermied auch riskante Workarounds, die unter CockroachDB durch die Angst vor Systemsperrungen eingeführt wurden. Nicht nur die Migrationsprozesse selbst, sondern auch angrenzende Abläufe wie ETL-Jobs (Extract, Transform, Load) litten unter den Beschränkungen der verteilten Infrastruktur. Airbyte, der verfügbare Connector für CockroachDB, befand sich Anfang 2024 noch in einer Alpha-Phase und war von Problemen wie Speicherlecks geprägt. Dies führte zu häufigen Timeouts und ineffizienter Leistung, was die Verlässlichkeit und Skalierbarkeit von Datenintegrationsprozessen infrage stellte.

Ein weiteres zentrales Thema war die Performance bei der Abfragebearbeitung. Während CockroachDB bei manchen spezialisierten Queries dank seines intelligenten Query-Planners für bessere Geschwindigkeit sorgte, gab es viele alltägliche Abfragen, bei denen PostgreSQL deutlich die Nase vorn hatte. Komplexe SQL-Statements, insbesondere jene, die über ORM generiert wurden, erzeugten bei CockroachDB oft Full Table Scans und sehr hohe Latenzen. Diese konnte PostgreSQL durch optimierte Ausführungspläne und Indizes vermeiden, was in der Praxis zu einer im Schnitt dreifachen Geschwindigkeit führte. Neben technischen Problemen traten auch UI- und Supportprobleme auf.

Die Benutzeroberfläche von CockroachDB zeigte beispielsweise häufig falsche Empfehlungen zu nicht genutzten Indizes, was die Entwickler verunsicherte. Das Abbrechen von langen Queries war technisch anspruchsvoll und musste manuell über die Cockroach-Konsole erfolgen, was im Gegensatz zu gängigen SQL-Clients wie TablePlus eine erhebliche Erschwernis darstellte. Außerdem war der Kundensupport getrennt vom Hauptportal, was in dringenden Situationen wie etwa bei Bugs zu Wartezeiten von bis zu einer Woche führte. Zusätzlich stellte sich die Vernetzung des CockroachDB-Clusters über virtuelle private Netzwerke als problematisch heraus. Tailscale-Verbindungsabbrüche traten wiederholt und unvorhersehbar auf, beeinträchtigten den Zugriff aus CI-Systemen und lokalen Tools und konnten auch durch umfangreiche Fehlersuche nicht beseitigt werden.

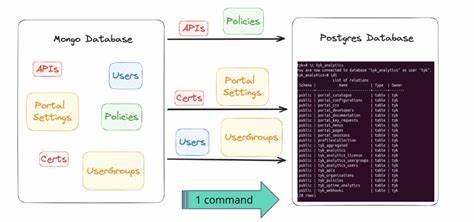

Solche Verbindungsprobleme waren mit PostgreSQL nie aufgetreten. Die eigentliche Migration stellte eine enorme technische Herausforderung dar, auch wegen der Datenmenge: Die größte Tabelle enthielt zu dieser Zeit etwa 100 Millionen Datensätze. Die vorhandenen ETL-Werkzeuge waren für diese Migration unzureichend, sodass eine eigene Lösung entwickelt wurde. Mit modernsten Tools wie Bun wurde ein maßgeschneiderter Streaming-ETL-Prozess implementiert, der alle Tabellen aus CockroachDB dumpte und per Prozess-Streaming nach PostgreSQL importierte. Dabei zeigte sich, dass die Datentypen und die Kodierung – besonders bei JSON und Arrays – zwischen beiden Datenbanken nicht komplett kompatibel waren.

Eine Anpassung der CSV-Parsing-Pipelines wurde notwendig, um diesen Unterschieden Rechnung zu tragen und gleichzeitig Datenintegrität sicherzustellen. Die zweiwöchige Vorbereitungsphase mündete in die produktive Migration, die innerhalb von rund 15 Minuten auf einer hoch performanten GCP-VM durchgeführt wurde. Der Betrieb wurde währenddessen für etwa eine Stunde in den Wartungsmodus versetzt, um einen reibungslosen Ablauf ohne Datenverlust zu gewährleisten. Nach der erfolgreichen Migration zeigte sich ein unmittelbarer Effekt auf die Systemperformance: Die aggregierten Abfragezeiten fielen um etwa ein Drittel. Durch Tools wie PGAnalyze konnte das Team innerhalb weniger Stunden mehrere ineffiziente Queries identifizieren und optimieren, was zu weiteren Performancegewinnen führte.

Auch finanziell zeigte sich der Wechsel als äußerst lohnend: Trotz vorerst konservativer Ressourcenbereitstellung konnten jährlich über 110.000 US-Dollar eingespart werden, und dieser Betrag wird mit wachsendem System vermutlich noch steigen. Die Entscheidung für PostgreSQL basierte somit nicht nur auf technischen Vorteilen, sondern auch auf Kostenoptimierung und der besseren Handhabbarkeit der Datenbank im Alltag. Die breite Unterstützung durch ein ausgereiftes Ökosystem, leistungsfähige Werkzeuge und eine lebendige Community machen PostgreSQL besonders attraktiv für Unternehmen, die Skalierbarkeit und Stabilität suchen, ohne unnötigen Overhead zu bezahlen. Der Umstieg von CockroachDB auf PostgreSQL verdeutlicht, dass selbst vermeintlich disruptive Technologien wie verteilte SQL-Datenbanken nicht immer die beste Lösung für jedes Szenario sind.

Unternehmen sollten Risiken und Kosten sorgfältig abwägen und ihre Wahl auf die tatsächlichen Anforderungen anpassen. Migrationen sind komplex, bergen Risiken, bieten aber vor allem Chancen, Systeme nachhaltig zu verbessern und technische Schulden abzubauen. Diese Erfahrungen liefern wertvolle Einblicke für Unternehmen, die vor der Entscheidung stehen, ihre Datenbanktechnologie zu wechseln oder ihre bestehende Infrastruktur zu optimieren. Ein sauber geplanter und technisch fundierter Migrationsprozess kann Performance steigern, Kosten senken und die Entwicklerzufriedenheit erhöhen – ein Gewinn für alle Beteiligten und ein wichtiger Schritt auf dem Weg zu einer modernen IT-Architektur.