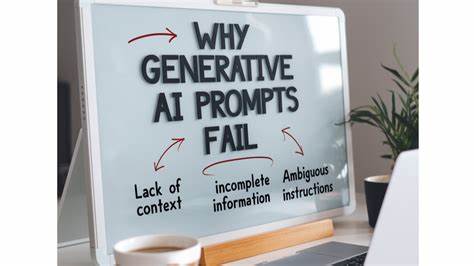

In der Welt der Künstlichen Intelligenz spielen Prompts eine zentrale Rolle. Sie sind die Brücke zwischen Mensch und Maschine, die den Output eines Modells maßgeblich beeinflussen. Doch trotz aller Fortschritte, die in den letzten Jahren gemacht wurden, kommt es häufig vor, dass Prompts nicht die gewünschten Ergebnisse liefern. Warum das so ist und warum dieses Problem auch in Zukunft bestehen bleiben wird, ist ein komplexes Thema, das sich vor allem auf drei Schlüsselkomponenten zurückführen lässt: Kognition, Kontext und Alignment. Darüber hinaus gibt es mit dem Begriff Scope eine weitere wichtige Dimension, die das Verständnis von Prompts und deren Erfolgen oder Misserfolgen erheblich erweitert.

Eine fundierte Analyse dieser Faktoren hilft dabei, die Natur von Prompt-Fehlern besser zu verstehen und die zukünftigen Grenzen der KI-Anwendungen realistischer einzuschätzen. Scope: Die innere Größe eines Prompts Zunächst lohnt sich ein genauerer Blick auf den Begriff Scope, der häufig als unterschätzter Faktor bei der Betrachtung von Prompts gilt. Konkret bezeichnet Scope die inhaltliche Größe oder den Umfang der Aufgabe, die ein Prompt adressiert. Hierbei kann ein Prompt entweder eine sehr kleine Aufgabe beschreiben oder eine umfangreiche Anforderung formulieren. Ein einfaches Beispiel wäre ein Prompt wie „Schreibe eine Funktion, die zwei Zahlen addiert“.

Dieser Befehl hat einen kleinen Scope, da er eine klar abgrenzbare, einfache Aufgabe benennt. Im Gegensatz dazu steht ein komplexerer Prompt wie „Schreibe eine Chat-Applikation“. Hier ist die inhaltliche Bandbreite ungleich größer, da viele verschiedene Komponenten, Regeln und Eventualitäten berücksichtigt werden müssen. Interessanterweise gibt es eine direkte Beziehung zwischen dem Scope eines Prompts und seiner Länge beziehungsweise Komplexität. Dabei kann man sich Scope als die Menge an Information vorstellen, die in einem Prompt zusammengefasst wird, während die Länge oder der Umfang des Prompts angibt, wie viel Platz diese Information einnimmt.

Man kann diese Beziehung durch den Begriff Kompression ausdrücken: Wie viel Bedeutung wird in einem bestimmten Textumfang „verdichtet“? Je größer der Scope bei konstanter oder kurzer Länge, desto höher die Kompression. Diese Kompression zieht jedoch eine Schwäche mit sich: Mit zunehmendem Scope und gleichbleibend knapper Ausdrucksform steigt die Wahrscheinlichkeit, dass nicht alle relevanten Informationen klar und explizit kommuniziert werden. Implizite Annahmen, unausgesprochene Details und vage Erwartungen schleichen sich ein. Es entsteht eine Art Informationsverlust, der vom Modell ausgeglichen oder interpretiert werden muss. In der Praxis führt dies dazu, dass bei großem Scope und kurzer Prompt-Länge das Risiko steigt, dass die KI falsch versteht oder wichtige Details missachtet.

Dies ist eine der Hauptursachen, warum Prompts nicht die erhofften Ergebnisse liefern. Kognition: Die Intelligenz der Modelle Ein weiterer entscheidender Faktor ist die Kognition des KI-Modells. Kognition beschreibt hier die Fähigkeit der Maschine, Informationen zu verarbeiten, Zusammenhänge zu erkennen und intelligent auf Eingaben zu reagieren. Mit jeder neuen Modellgeneration wachsen die kognitiven Fähigkeiten der KI enorm. Moderne Modelle wie das OpenAI O1-Modell stellen einen bedeutenden Schritt in Richtung kognitiver Exzellenz dar.

Sie sind in der Lage, komplexe und präzise Aufgaben zuverlässig zu bearbeiten, sofern der Prompt klar und eindeutig formuliert ist. Allerdings ist Kognition nicht allmächtig. Auch die intelligentesten Modelle erreichen asymptotisch eine Grenze bei der fehlerfreien Interpretation und Ausführung von Prompts. Besonders bei Aufgaben, die stark von Kontext und impliziten Erwartungen geprägt sind, kommt es trotz fortgeschrittener Kognition zu Schwierigkeiten. Während die kognitive Leistung von Modellen kontinuierlich verbessert wird und in Zukunft womöglich eine sehr hohe Genauigkeit erreicht, kann sie allein die Probleme bei der Promptausführung nicht komplett beheben.

Kontext: Mehr als nur das unmittelbare Eingabefenster In vielen Fällen hängt der Erfolg eines Prompts maßgeblich von dem Kontext ab, in dem die KI agiert. Kontext ist dabei weit mehr als nur der unmittelbar vorliegende Text des Prompts. In der Softwareentwicklung umfasst Kontext zum Beispiel das gesamte Projekt, bestehende Codestrukturen, die Beweggründe hinter bestimmten Entscheidungen, vergangene Erfahrungen der Nutzer und sogar Informationen aus externen Quellen wie Meetings oder Dokumentationen. Je größer und komplexer der Kontext, desto schwieriger wird es für ein Modell, alle maßgeblichen Informationen angemessen zu verarbeiten. Moderne Systeme machen Fortschritte, indem sie Werkzeuge einbinden, die Kontext besser erfassen und verwalten können.

Technologien wie Augment Code zielen darauf ab, die ganze Umgebung eines Projekts zu verstehen und dadurch intelligentere Reaktionen zu ermöglichen. Dennoch steht der Kontext noch vor einer Art „O1-Moment“ – einem Zeitpunkt, an dem das Erfassen und Verstehen von Kontexten so präzise und effizient wird wie bei der Kognition bereits möglich ist. Darüber hinaus fehlt vielen Systemen die Fähigkeit, historisch gewachsene und teils fragmentarische Informationen fließend zu integrieren. Ohne eine umfassende Kontextualisierung können auch die besten Modelle die Anforderungen großer und komplexer Prompts nur bedingt erfüllen. Alignment: Die Kunst der Übereinstimmung Das dritte und vielleicht kritischste Element ist Alignment, also die Übereinstimmung zwischen den Erwartungen des Anwenders und der Interpretation des Modells.

Alignment stellt sicher, dass die Antworten und Ergebnisse eines KI-Systems genau das widerspiegeln, was der Nutzer beabsichtigt hat, selbst wenn nicht alle Details explizit formuliert wurden. Im Gegensatz zu Kognition und Kontext ist Alignment ein subtileres, kommunikationsbasiertes Problem. Während Intelligenz und Kontextualisierung durch technische Innovationen und Datenwachstum zunehmend verbessert werden können, hängt Alignment maßgeblich von der Art ab, wie Menschen mit Maschinen kommunizieren. Aktuell erfolgt die Eingabe meist über Text – ein Kommunikationsmedium, das begrenzte Bandbreite für Nuancen und unterschwellige Absichten bietet. Die Herausforderung besteht darin, dass das Modell ohne klare, explizite Anweisungen nicht wissen kann, welche Protokolle anzuwenden sind oder welche Farbnuancen ein Button haben soll.

Die Folge ist, dass trotz des besseren Verständnisses des Modells Missverständnisse und Fehlinterpretationen auftreten. Verbesserungen in der User-Experience, neue Schnittstellen und neue Kommunikationsmethoden könnten helfen, diese Lücke zu schließen. Doch ohne fundamentale technologische Durchbrüche wie direktes Gedankenlesen bleibt Alignment die größte Hürde und wird vermutlich zur primären Einschränkung bei der Produktivität mit KI-Systemen. Das Zusammenspiel der Faktoren und die Zukunft der Prompts Verständnis über Scope, Kognition, Kontext und Alignment zeigt, dass Prompt-Fehler unterschiedlichsten Ursprungs sein können und jeweils ein eigenes Lösungspotenzial erfordern. Kognition wird sich mit fortschreitender Forschung und Entwicklung immer weiter verbessern, und auch der Kontextbezug wird durch neue Technologien deutlich besser verarbeitet werden können.

Trotzdem wird das Zusammenspiel beider Komponenten ohne eine verbesserte Alignment-Methode nur bedingt zu einer fehlerfreien Kommunikation führen. Der Alignment-Faktor bleibt also der limitierende Engpass, der neue Herausforderungen an Nutzer und Entwickler stellt. Während technische Lösungen den Weg ebnen und Werkzeuge intelligenter machen, müssen wir zugleich die Art und Weise verbessern, wie Menschen ihre Absichten an Maschinen übermitteln, um wirklich präzise Ergebnisse zu erzielen. Es ist zu erwarten, dass sich diese Probleme künftig nicht einfach in Luft auflösen, sondern durch die zunehmende Komplexität der Aufgaben und die steigenden Erwartungen eher noch verstärkt werden. Die Arbeit an neuen Kommunikationswegen und besseren Modellen ist essenziell, aber wir sollten uns auch auf eine Welt vorbereiten, in der Prompts weiterhin fehlschlagen können – trotz steigender Modellintelligenz und wachsendem Datenverständnis.

Das Wissen um die Grenzen und Herausforderungen von Prompt-Interaktionen ist entscheidend, um die Möglichkeiten von KI realistisch einschätzen und zielgerichtet nutzen zu können. Nur wer versteht, warum Prompts scheitern, kann effektive Strategien entwickeln, um mit dieser Realität produktiv umzugehen und langfristig erfolgreich zu sein.