Llama.cpp hat sich in der Welt der leichten und effizienten KI-Modelle als bedeutende Open-Source-Innovation etabliert. Als portables Projekt, das verschiedene LLMs (Large Language Models) auf nahezu jeder Hardware zum Laufen bringt, wächst es ständig weiter – und vor kurzem wurde mit der Einführung von Multimodalität ein großer Schritt nach vorne gemacht. Die Möglichkeit, nicht nur Text, sondern auch Bilder und Audio als Eingabe zu verarbeiten, erweitert die Einsatzgebiete von Llama.cpp erheblich.

Diese Entwicklung katapultiert das Projekt in eine neue Ära von KI-Anwendungen, in der Vision und Sprache in enger Verzahnung genutzt werden können. In diesem Artikel betrachten wir die Grundlagen und die Bedeutung der neuen visuellen Funktionen in Llama.cpp und analysieren, wie diese Innovation die Landschaft der KI-Modelle verändern wird. Multimodalität in der Künstlichen Intelligenz ist ein zentraler Trend der letzten Jahre. Während klassische Sprachmodelle zum Verstehen und Generieren von Text optimiert sind, besteht die drängende Herausforderung darin, Kontext aus mehreren Informationsquellen zu erfassen.

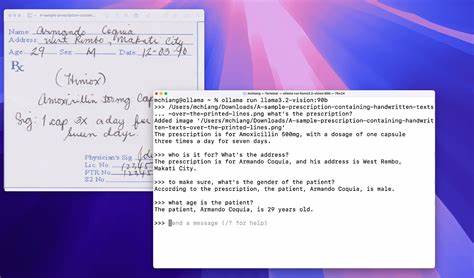

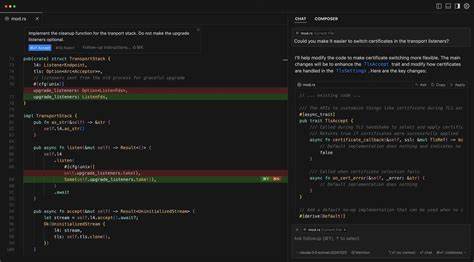

Die Kombination von Bild, Ton und Text erlaubt es KI-Systemen, komplexere Aufgaben mit höherer Präzision zu lösen – beispielsweise das Erkennen von Objekten in Bildern, das Verstehen von Videos oder das Analysieren von Audioinhalten zusammen mit verbalen Informationen. Llama.cpp hat diese Anforderungen erkannt und mit der Integration von Vision-Features über die libmtmd-Bibliothek einen bedeutenden Schritt gemacht. Die praktische Umsetzung erfolgt über zwei Hauptwerkzeuge: den llama-mtmd-cli, ein Kommandozeilen-Tool, sowie den llama-server, der über eine OpenAI-kompatible API angesprochen werden kann. Beide unterstützen die neue Multimodalität, insbesondere die Verarbeitung von Bildern und – wenn auch noch experimentell – Audioeingaben.

Diese Tools ermöglichen es Nutzern, multimodale Modelle mit verschiedensten Quantisierungen und Konfigurationen zu verwenden, was maximale Flexibilität hinsichtlich Leistung und Genauigkeit bietet. Besonders hervorzuheben sind die vorquantisierten Modelle, die bequem über die Hugging Face-Plattform bezogen werden können. Hier finden sich diverse Modelle, die speziell für visuelle Aufgaben vorbereitet sind, darunter bekannte Namen wie Gemma 3, SmolVLM, Pixtral 12B und Qwen 2 VL. Diese Modelle sind in GGUF-Dateien verpackt, einem modernen Format, das effizientes Laden und Handling auf unterschiedlichster Hardware garantiert. Ein großer Erfolg der Integration ist, dass multimodale Projektionen standardmäßig auf die GPU ausgelagert werden.

Dadurch werden Berechnungen beschleunigt, und das Gesamtmodell zeigt bessere Performance. Dennoch lässt sich das Offloading bei Bedarf auch deaktivieren, etwa um Kompatibilitätsprobleme zu vermeiden oder wenn nur CPU-Ressourcen zur Verfügung stehen. Für viele Anwender macht das Zusammenspiel von leichter Handhabung und hoher Leistung den großen Reiz von Llama.cpp aus. Die Vielfalt der Vision-Modelle und die direkte Verfügbarkeit per Kommandozeile oder Server führen dazu, dass Entwickler beispielsweise in Forschung oder Prototyping sehr schnell eigene Projekte realisieren können, die über reine Textverarbeitung hinausgehen.

Dies öffnet Tür und Tor für zahlreiche Anwendungsfälle, die bisher nur mit deutlich kostspieligeren und ressourcenintensiveren Lösungen möglich waren. Einige besonders interessante Vision-Modelle sind dabei das Gemma 3 in verschiedenen Größen, welches bewährte Qualität für visuelle Aufgaben liefert, sowie die SmolVLM-Reihe, die insbesondere in der Instruktions-Verarbeitung von Bild-Unt erstützung zu überzeugen weiß. Große Modelle wie Pixtral 12B bieten hingegen noch komplexere Fähigkeiten und erlauben anspruchsvollste Anwendungen. Neben der Vision spielt auch die Audioverarbeitung eine Rolle, wenngleich dieser Bereich noch experimenteller ist. Modelle wie Ultravox 0.

5 bieten erste Einblicke in Sprach- und Audiointegration, jedoch weist das Entwicklerteam darauf hin, dass die Qualität hier oft noch hinter den Erwartungen zurückbleibt. Zukünftige Updates dürften die Audio-Komponenten weiter ausreifen lassen, sodass auch diese Modalität an Bedeutung gewinnt. Die Integration von Vision und Audio erweitert die Nutzungsmöglichkeiten von Llama.cpp deutlich. Anwendungen aus Bereichen wie automatisierte Bildanalyse, assistive Technologien, multimodale Dialogsysteme und Videoverarbeitung lassen sich ebenso einfacher umsetzen wie kreative Use-Cases, etwa in der Kunst oder interaktiven Medien.

Besonders spannend ist die Möglichkeit, multimodale Eingaben zu verknüpfen und im Rahmen eines einheitlichen Modells zu analysieren. Für Entwickler und Forscher eröffnet sich somit ein leistungsfähiges Instrumentarium, um die Grenzen von KI noch weiter zu verschieben. Die Einfachheit der Integration – vor allem durch das Aufrufen dieser Funktion via Kommandozeile oder OpenAI-kompatible APIs – sorgt außerdem dafür, dass das Angebot auch für weniger erfahrene Anwender zugänglich bleibt. Dies trägt erheblich zur Verbreitung und Akzeptanz öffentlicher KI-Tools bei, da die Einstiegshürden niedrig bleiben. Betrachtet man den aktuellen Stand der Technik, so steht Llama.

cpp mit der Vision-Integration auf einer Höhe mit einigen der bekanntesten kommerziellen Multimodal-Modelle. Die Kombination aus Open-Source-Natur, Effizienz auf verschiedenster Hardware und multimodaler Unterstützung macht das Projekt für viele Laien genauso wie Profis attraktiv. Zudem etabliert sich der GGUF-Modellstandard als zuverlässiges und schnelles Format im gesamten Ökosystem. Der wachsende Pool an Multimodalmodellen auf Plattformen wie Hugging Face unterstreicht, wie stark die Community auf das Thema setzt und wie das Projekt dynamisch weiter wächst. Zukunftsausblick: Die Erweiterung von Llama.

cpp ist nur der Anfang einer großen Bewegung hin zu KI-Systemen, die nahtlos mit der realen, komplexen Welt interagieren können. Weitere Verbesserungen in Modellarchitektur, Quantisierung und Hardware-Unterstützung werden folgen. Zudem stehen die Türen offen für neue Modalitäten wie Video oder Sensor-Daten. Damit rückt die Vision einer allumfassenden künstlichen Intelligenz näher, die Bilder, Ton, Sprache und sogar weitere Signale gleichzeitig verstehen und verarbeiten kann. Für Anwender bedeutet dies, dass zukünftig deutlich vielseitigere, robustere und kreativere Applikationen möglich werden – direkt nutzbar auf eigenen Geräten ohne notwendige Cloud-Verarbeitung.

Heraus kommt ein Paradigmenwechsel im Umgang mit KI, der nicht nur Forschung und Entwicklung beflügelt, sondern auch in der Praxis neue Anwendungshorizonte schafft. Zusammenfassend lässt sich sagen, dass die Verfügbarkeit von Vision in Llama.cpp ein wichtiger Meilenstein für das Projekt und die gesamte Open-Source-KI-Welt ist. Die Möglichkeit, multimodale Inputs ganz einfach zu integrieren, eröffnet eine breite Palette neuer Einsatzgebiete und macht leistungsfähige KI-Technologie für ein größeres Publikum zugänglich. Dabei profitieren Nutzer von einer aktiven Community, beständigen Verbesserungen und vielseitigen Modellen, die ständig erweitert und verfeinert werden.

Wer sich mit modernen KI-Anwendungen beschäftigen möchte, findet mit Llama.cpp jetzt ein leistungsstarkes Toolkit, das den Trend zur Multimodalität auf innovative Weise fördert. Es bleibt spannend zu beobachten, wie sich die Vision-Funktionalität weiterentwickelt und welche neuen Anwendungen in den nächsten Jahren daraus entstehen – die Zukunft der KI ist lebendiger und vielfältiger denn je.