Machine Learning hat sich in den letzten Jahren als eine der revolutionärsten Technologien in der Informatik etabliert. Es ermöglicht Unternehmen, anspruchsvolle Aufgaben schneller und effizienter zu lösen als je zuvor. Doch trotz der unbestreitbaren Vorteile lauert im Hintergrund eine oft übersehene Gefahr: die technische Verschuldung, die durch Machine Learning entsteht. Dieser Begriff, der ursprünglich aus der Softwareentwicklung stammt, beschreibt die kumulierten Mehrkosten, die durch schnelle und kurzfristige Lösungen verursacht werden – und bei Machine Learning können diese Kosten besonders hoch und schwer kalkulierbar sein. Technische Schulden entstehen, wenn Entwickler bewusst oder unbewusst Kompromisse eingehen, um neue Features schnell zu implementieren oder Systeme rasch in Produktion zu bringen.

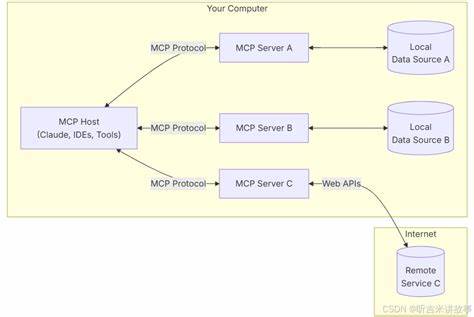

Im klassischen Softwareengineering kann dies durch mangelnde Dokumentation, unzureichende Tests oder schlechte Architektur geschehen. Machine Learning bringt jedoch eine neue Ebene der Komplexität mit sich, da die Modelle nicht wie traditioneller Code funktionieren, sondern sich durch Trainingsdaten und Algorithmen definieren, die sich im Laufe der Zeit verändern können. Ein zentrales Problem bei Machine Learning ist die sogenannte "Grenzflächen-Erosion". Normalerweise sollten unterschiedliche Systemkomponenten klar voneinander abgegrenzt sein, sodass Änderungen an einem Teil nicht unkontrollierte Auswirkungen auf andere Bereiche haben. Bei ML-Systemen verschwimmen diese Grenzen oft, weil Eingabesignale, sogenannte Features, mehrfach verwendet oder miteinander verflochten werden.

Dies führt dazu, dass Änderungen an einer Komponente schwer abgeschätzt werden können und das gesamte System instabiler wird. Die Folge ist ein engeres, oft unbeabsichtigtes Kopplungsverhalten, das die Wartung erheblich erschwert. Ein weiterer komplexer Aspekt sind versteckte Feedback-Schleifen. Modelle in produktiven Systemen reagieren auf Daten, welche durch das System selbst generiert wurden. Dadurch kann es zu Rückkopplungseffekten kommen, bei denen das System seine eigene Eingabe beeinflusst und sich dadurch selbst verstärkt oder verändert.

Diese Dynamik lässt sich ohne fundiertes Monitoring und tiefgehende Analysen nur schwer diagnostizieren und kann langfristig dazu führen, dass der Algorithmus von seiner ursprünglichen Funktionalität abweicht. Die Abhängigkeiten von Daten sind oft schwerer zu handhaben als klassische Codeabhängigkeiten. Die Qualität, Verfügbarkeit und Aktualität der Trainings- und Eingangsdaten haben direkten Einfluss auf die Performance und Verlässlichkeit des Modells. Änderungen in externen Datenquellen oder im Nutzerverhalten können Modelle plötzlich ineffektiv machen oder sogar falsche Entscheidungen provozieren. Die daraus resultierenden Wartungsaufwände sind schwer vorhersehbar und potenziell sehr kostspielig.

Durch die oftmals als Blackbox behandelten Machine Learning Modelle entsteht zudem eine Vielzahl von sogenannter "Klebeschichten" oder "Glue Code". Das sind spezielle Codeabschnitte, die entwickelt werden, um Modelle an die bestehenden Systemarchitekturen anzubinden und diese zu kalibrieren. Häufig enthalten diese Schichten versteckte Annahmen und Hardcodierungen, die es schwierig machen, flexible Anpassungen vorzunehmen oder neue Modelle einzuführen, ohne das gesamte System zu destabilisieren. Das Problem wird zusätzlich verschärft durch die sich schnell verändernde Umwelt, in der ML-Systeme eingesetzt werden. Märkte, Nutzerverhalten, gesetzliche Rahmenbedingungen oder technische Rahmenbedingungen verändern sich kontinuierlich.

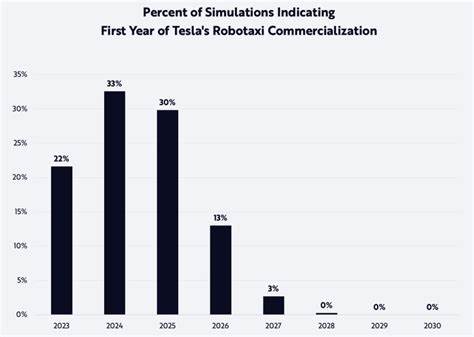

Ohne konsequentes Monitoring und adaptive Strategien verwalten viele Unternehmen Modelle, die mit veralteten Annahmen arbeiten. Dies führt nicht nur zu Leistungsabfall, sondern auch zu unsichtbaren Fehlerquellen, die sich erst dann bemerkbar machen, wenn sie schon hohen Schaden angerichtet haben. Insgesamt steigen die Betriebskosten von Machine Learning Systemen durch diese Faktoren exponentiell an, wenn technische Schulden nicht aktiv angegangen werden. Das bedeutet, dass Unternehmen langfristig deutlich mehr Ressourcen in Wartung, Anpassung und Fehlerbehebung investieren müssen, als ursprünglich geplant. Der Vergleich von Machine Learning mit einer Hochzins-Kreditkarte ist hierbei treffend: schnelle Vorteile am Anfang, aber hohe Kosten bei langfristigem Einsatz.

Um dieser Entwicklung entgegenzuwirken, ist eine bewusste und strategische Herangehensweise notwendig. Das beginnt mit einem klaren Architektur-Design, das die Grenzen zwischen ML-Komponenten und klassischem Systemcode strikt definiert und dokumentiert. Ebenso wichtig ist es, umfangreiche Tests zu implementieren, die nicht nur den Code, sondern auch die Modellqualität und deren Verhalten in verschiedenen Szenarien prüfen. Ferner sollten Unternehmen ein kontinuierliches Monitoring aufsetzen, das sowohl die Datenqualität als auch die Modellperformance laufend überwacht. Frühzeitige Warnsysteme helfen, potenzielle Probleme zu erkennen, bevor sie zu gravierenden Störungen führen.

Dabei darf auch nicht vergessen werden, dass das Testen von Machine Learning Modellen weiterreichender sein muss als bei herkömmlichen Softwareprodukten, da es neben Funktionalität auch die statistische und datenabhängige Komponente abdeckt. Auch die Unternehmenskultur spielt eine wichtige Rolle im Umgang mit technischer Verschuldung bei Machine Learning. Ein Bewusstsein dafür zu schaffen, dass schnelles Liefern nicht auf Kosten der langfristigen Wartbarkeit gehen darf, ist essenziell. Führungskräfte und Entwickler müssen gleichermaßen verstehen, welche Risiken in nicht nachhaltigen Implementierungen stecken. Zusammenfassend lässt sich sagen, dass Machine Learning zweifellos eine mächtige Technologie darstellt, die innovative Anwendungen und Geschäftserfolge ermöglicht.

Doch der vermeintlich einfache Einsatz trägt das Risiko verborgen, immense technische Schulden zu verursachen, die langfristig die Wartbarkeit, Skalierbarkeit und Zuverlässigkeit der Systeme gefährden. Eine sorgfältige Planung, konsequente Architekturdisziplin und proaktives Monitoring sind unerlässlich, um die versteckte Kostenfalle zu vermeiden und nachhaltige, robuste ML-Systeme zu schaffen. Nur so können Unternehmen den hohen „Zins“ dieser Technologie zahlen und von ihrem Potenzial profitieren, ohne in der technischen Verschuldung zu versinken.

![Machine Learning: The High-Interest Credit Card of Technical Debt (2014) [pdf]](/images/BDEE251E-089D-43C1-AB16-62B34165247F)

![How reliable is fingerprint evidence? [video]](/images/B28F1379-8C0C-4884-B3DD-BDC21BF2345B)