Im Bereich des maschinellen Lernens sieht man sich oft mit unausgeglichenen Datensätzen konfrontiert, bei denen eine Klasse deutlich seltener vertreten ist als die andere. Diese Probleme, auch als Imbalanced Learning bekannt, stellen eine besondere Herausforderung dar, vor allem bei Klassifikationsaufgaben. Wenn zum Beispiel ein Bildklassifikator viel mehr negative als positive Beispiele bearbeitet, verliert das Modell häufig an Genauigkeit bei der Erkennung der selteneren Klasse. Eine weit verbreitete Antwort auf dieses Phänomen ist die Verwendung von Klassengewichten – vor allem Gewichtungen, die proportional zum Kehrwert der Klassenhäufigkeit gesetzt werden. Doch wie sinnvoll ist diese Praxis wirklich? Und wie beeinflusst die Wahl der Klassengewichte tatsächlich die Leistung eines Klassifikators? Um diese Fragen zu beantworten, lohnt sich ein Blick hinter die Kulissen der Klassengewichte und wie sie sich auf den Lernprozess auswirken.

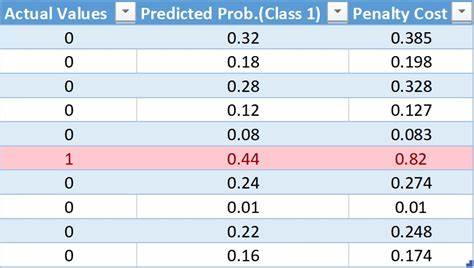

Klassisch betrachtet wird das Training eines binären Klassifikationsmodells oft durch Minimierung des binären Kreuzentropie-Verlusts gesteuert. Hierbei ist der Kniff, die positiven Instanzen mit einem höheren Gewicht zu versehen, um dem Modell zu signalieren, dass Fehler hier besonders teuer sind. Überraschenderweise zeigen sich in neueren Untersuchungen durchaus Szenarien, in denen das Anwenden des klassischen, invers-proportionalen Gewichtungsschemas keinen relevanten Vorteil bringt – und mitunter sogar kontraproduktiv sein kann. Die Problematik einer unausgeglichenen Klassifikation liegt im fundamentalen Tradeoff zwischen den zwei Arten von Fehlern: falsch-positive und falsch-negative Vorhersagen. Während man alle Beispiele einfach als negativ klassifizieren könnte, um falsch-positive Fehler zu vermeiden, würden alle positiven Fälle übersehen werden.

In der Praxis muss also eine Balance gefunden werden, die den jeweiligen Anwendungsfall und die Kosten der Fehlklassifikationen respektiert. Anstelle nur naiv Gewichtungen auf Basis der Klassenhäufigkeiten vorzunehmen, ist ein tiefer gehendes Verständnis des Tradeoff-Kurvenverlaufs essenziell. Dabei beschreibt diese Kurve, wie sich die Fehlerarten zueinander verhalten, wenn man unterschiedliche Schwellenwerte für die Klassifikation ansetzt. Mathematisch lässt sich dieser Tradeoff mithilfe zweier Größen charakterisieren: Die Wahrscheinlichkeit, eine positive Instanz korrekt als solche zu erkennen (Recall) und die Wahrscheinlichkeit, eine negative Instanz richtig zu klassifizieren (True Negative Rate). In einer idealen Welt mit perfekten Modellen könnte man beide Größen gleichzeitig maximieren.

Tatsächlich besteht hier aber ein Kompromiss, der üblicherweise durch Parameter in der Modelloptimierung und die Wahl der Verlustfunktion beeinflusst wird. Bei der Analyse der Klassengewichte zeigt sich, dass der Einfluss von Gewichtungsfaktoren auf den optimalen Punkt auf der Tradeoff-Kurve oft subtiler und komplexer ist als erwartet. Die F1-Maßzahl ist für viele Projekte ein beliebtes Leistungsmaß, da sie sowohl Präzision als auch Recall miteinander verbindet und so eine ausgewogene Sicht auf beide Fehlerarten ermöglicht. Insbesondere bei solchen Problemen, in denen positive und negative Fehler gleich schädlich sind, gibt die F1-Score eine gute Entscheidungsgrundlage. Wenn man die Verwendung von Klassengewichten betrachtet, zeigt sich, dass eine einfache Blatt-vor-dem-Mund-Regel wie die inverse Klassenhäufigkeit nicht zwangsläufig den F1-Wert optimiert.

Stattdessen resultiert aus der theoretischen Modellierung meist ein leicht erhöhtes Gewicht, das aber weit unter dem inversen Wert liegt und häufig nur marginale Verbesserungen bringt. Diese Erkenntnis kann für viele Praktiker überraschend sein, da das inverse Gewichtungsschema weithin als goldener Standard gehandhabt wird. Die Erklärung liegt unter anderem in der Annahme einer symmetrischen Tradeoff-Kurve und weiteren idealisierten Bedingungen. Realwelt-Daten und Modelle zeigen oft ein anders geartetes Verhalten, welches in Simulationen mit synthetischen Datensätzen bestätigt wurde. Dort wurde unter anderem die Klassentrennbarkeit als Stellgröße für die Tradeoff-Eigenschaften verwendet, was zu einer ähnlichen, wenn auch nicht identischen, Kurvenform führte.

Die praktische Bedeutung dieser theoretischen Resultate liegt darin, dass das manuelle Tüfteln mit Klassengewichten, ohne Berücksichtigung des spezifischen Kontextes, meist wenig einbringt. Ein weiterer spannender Aspekt ist der Einfluss der Auswahl des zu optimierenden Metrikums. So hat sich gezeigt, dass während der F1-Score bezüglich der Gewichtung kaum signifikante Steigerungen zulässt, andere Maße wie die balanced accuracy ganz andere Ergebnisse liefern können. Letztere misst den Durchschnitt der Sensitivität der positiven und negativen Klasse und ist damit besonders geeignet, wenn beide Klassen eine ähnliche Bedeutung im Kontext besitzen. Für die balanced accuracy bestätigt sich, dass das inverse Klassenhäufigkeitsgewicht oft tatsächlich der optimale Punkt ist.

Der Unterschied zwischen diesen Metriken verdeutlicht, wie wichtig es ist, das Ziel der Modelloptimierung klar zu definieren und an die spezifischen Anforderungen des Produkts oder der Anwendung anzupassen. Die Wahl zwischen F1-Score und balanced accuracy hängt also stark vom Anwendungsfall ab. In Szenarien mit stark unausgeglichenen Klassen und sehr unterschiedlichen Kosten für falsch-positive und falsch-negative Fehler ist eine sorgfältige Abwägung unabdingbar. Für medizinische Anwendungen zum Beispiel, bei denen Fehlalarme viele unnötige Untersuchungen auslösen können, während das Übersehen eines echten Krankheitsfalls kritisch ist, ist eine genaue Kalibrierung der Gewichtungen und der Tradeoffs elementar. Im weiteren Sinne unterstreicht diese Analyse die Bedeutung von Kenntnis sowohl der Daten als auch der Geschäftsanforderungen bei der Auswahl von Modellparametern.

Eine standardisierte Herangehensweise wie das pauschale Anlegen von inversen Klassenhäufigkeiten ist zwar schnell umgesetzt, aber selten das optimale Rezept. Stattdessen lohnt es sich, zunächst den Tradeoff, das Verhältnis zwischen den Fehlerarten und die gewünschte Metrik zu definieren und daran die Gewichtungen und Thresholds im Modell auszurichten. Auch sollte nicht außer Acht gelassen werden, dass unbalancierte Daten nicht nur durch Gewichtung gelöst werden müssen. Methoden wie Datenaugmentation, gezielte Datensammlung, Oversampling, Undersampling oder komplexere Ansätze wie adversarielles Training und Ensemble-Methoden bieten vielfältige Wege, die Datenverteilung und die Modellrobustheit zu verbessern. Zusätzlich ist die Modellkalibrierung ein nicht zu unterschätzender Faktor, der die endgültige Leistung entscheidend beeinflussen kann.

Zusammenfassend lässt sich sagen, dass das Problem der unausgeglichenen Klassen im maschinellen Lernen weitreichend, komplex und multidimensional ist. Klassengewichte sind dabei ein hilfreiches, aber mit Vorsicht zu genießendes Werkzeug. Der Schlüssel zum Erfolg liegt in der fundierten Analyse der Anwendungsanforderungen, der zugrunde liegenden Tradeoff-Dynamik und der sorgfältigen Auswahl von Leistungsmetriken. Nur so lassen sich Modelle entwickeln, die nicht nur auf dem Papier gut abschneiden, sondern auch in der Praxis den tatsächlichen Bedürfnissen gerecht werden und valide Entscheidungen treffen. Zukünftige Forschungen und Praxisberichte werden sicher weitere Einblicke in die Mechanismen von Gewichten, Tradeoffs und Loss-Funktionen liefern.

Bis dahin ist es ratsam, bei der Arbeit mit unausgeglichenen Datensätzen nicht blind auf gängige Faustregeln zu vertrauen, sondern sich intensiv mit den Besonderheiten und Herausforderungen des jeweiligen Szenarios auseinanderzusetzen. Die Balance zwischen mathematischer Eleganz und praxisorientierter Anwendung bildet das Fundament für erfolgreiche Modelle im Umgang mit Ungleichgewichten.