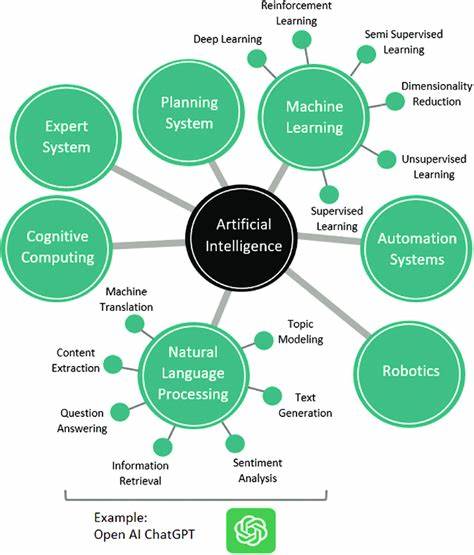

Im Zeitalter der Künstlichen Intelligenz (KI) erleben wir eine beispiellose Entwicklung im Bereich der Sprachmodelle und generativen Systeme. Moderne KI-Systeme, insbesondere große Sprachmodelle, werden häufig mit beeindruckenden Fähigkeiten vorgestellt, die an menschenähnliches Denken und Verstehen erinnern. Doch parallel dazu gibt es eine Flut an Publikationen und Diskussionen, die lautstark „fundamentale Grenzen“ oder gar „Illusionen“ dieser Denkfähigkeiten anprangern. Hier ist jedoch Vorsicht geboten, vor allem wenn verallgemeinernde Aussagen getroffen werden, die den komplexen Sachverhalt stark vereinfachen oder missverstehen. Es gilt, die Debatte mit kritischem Blick, fundiertem Wissen und dem Verständnis der praktischen Anwendbarkeit dieser Erkenntnisse zu führen.

Die Erforschung allgemeiner Denkfähigkeiten von KI-Systemen ist kompliziert und eben nicht schwarz-weiß. Es handelt sich dabei um ein Forschungsfeld, das seit Jahrzehnten immer wieder vor Herausforderungen steht, die tief in der künstlichen Intelligenz, der Lernfähigkeit von neuronalen Netzwerken und der theoretischen Komplexität von Aufgaben verwurzelt sind. In jüngster Zeit sorgte eine Veröffentlichung von Forschern bei Apple für Aufsehen, die moderne Sprachmodelle in sogenannten „Reasoning Tasks“ (Denkaufgaben) auf die Probe stellten und dabei behaupteten, dass aktuelle Ansätze an fundamentale Barrieren stoßen, was das generalisierbare Denken betrifft. Diese Studie, tituliert „The Illusion of Thinking“, hat viele kontroverse Reaktionen ausgelöst und wirft zugleich die Frage auf, wie solche Behauptungen richtig einzuordnen sind. Zunächst ist es wichtig zu verstehen, dass diese Art von Kritik nicht neu ist.

Bereits in den späten 60er Jahren zeigten Forscher wie Minsky und Papert, dass einfachere neuronale Netze, sogenannte Perzeptrons, gewisse Muster wie XOR nicht lernen können, was damals zur ersten sogenannten KI-Winterphase beitrug. Auch Gary Marcus zählt zu den langjährigen Kritikern, der argumentiert, dass herkömmliche neuronale Netze wichtige Eigenschaften der natürlichen Sprache nicht erfassen können. Darüber hinaus gibt es wissenschaftliche Arbeiten, die Sprachmodelle als „stochastische Papageien“ bezeichnen – also als Systeme, die lediglich statistisch Muster nachahmen, ohne ein echtes Verständnis zu besitzen. Theoretische Untersuchungen zeigen zudem, dass Transformer-Modelle, eine zentrale Architektur aktueller KI, eine begrenzte Ausdruckskraft bezüglich bestimmter Komplexitätsklassen besitzen. Diese historischen und aktuellen Argumentationslinien haben gemeinsam, dass sie die Leistungsfähigkeit von KI in theoretisch sauber definierten, oft stark vereinfachten Problemstellungen testen.

Die Forscher stellen Aufgaben, die von Menschen leicht verstanden und gelöst werden können, Modelle aber trotz großem Trainingsaufwand nicht fehlerfrei bearbeiten können. Daraus wird häufig die Schlussfolgerung gezogen, dass die beeindruckenden praktischen Ergebnisse von KI-Systemen nur auf bloßem Auswendiglernen basieren, aber keine echte Verallgemeinerungsfähigkeit oder generalisierbare Denkfähigkeit vorliegt. Diese Perspektive greift jedoch zu kurz und übersieht wichtige Aspekte. Moderne KI-Modelle, wie die neuesten Versionen großer Sprachmodelle, sind kein rudimentäres Perzeptron mehr, sondern komplexe Systeme mit mehreren Schichten, differenzierten Verbindungen und Mechanismen wie der Selbstaufmerksamkeit. Zudem kombinieren viele Anwendungen Sprachmodelle mit weiteren Tools, wie Code-Interpretern und externem Wissen, und agieren so als vielschichtige Agenten, die über bloßes Textgenerieren hinausgehen.

Die „Illusion des Denkens“ ergibt sich oft daraus, dass Sprachmodelle in der Praxis beeindruckende Leistungen zeigen, etwa in der Kommunikation, im Code-Schreiben oder beim Lösen realweltlicher Fragen. Doch bei der manuellen Ausführung langer und komplexer Algorithmen, etwa beim Tower of Hanoi mit vielen Scheiben oder anderen Aufgaben mit exponentiell wachsendem Aufwandsaufwand, versagen sie oft – zumindest wenn diese Aufgaben in reiner Textform ohne Hilfsmittel erschöpfend gelöst werden sollen. Allerdings ist diese Anforderung, einen tausend Schritte langen Prozess fehlerfrei händisch zu generieren, weder ein realistisch erwartbares menschliches Verhalten, noch ein geeigneter Maßstab für generalisierbare Intelligenz. Menschen zeigen häufig ebenfalls Mustererkennung, setzen auf Heuristiken und erledigen komplexe Herausforderungen, indem sie kreativ Werkzeuge einsetzen oder Aufgaben abstrahieren. Einen langen Algorithmus dürfen sie an einen Computer übergeben, anstatt ihn manuell auszuführen – und genau so agieren auch moderne KI-Systeme.

Sie verstehen Aufgaben zumindest so gut, dass sie passende Programme schreiben können, die diese Aufgaben effizient lösen. Das ist eine Form von generalisierbarem Denken, die sich nicht auf schlichte Schrittausführung beschränkt. Ein weiterer Punkt betrifft die problematische Natur der Testaufgaben selbst. In einigen Fällen sind sie mathematisch unmöglich zu lösen oder die Untersuchungen ignorieren elementare Limitierungen wie beschränkte Kontextlänge von Sprachmodellen. Modelle weigern sich etwa bei extrem langen Aufgaben, Fehleranfälligkeit zu vermeiden, indem sie stattdessen alternative Lösungsansätze vorschlagen.

Dies wird fälschlich als Versagen der Denkfähigkeit interpretiert, statt als pragmatisches Erkennen von Grenzen. Deshalb ist es wichtig, dass wir die Kritik an den Denkfähigkeiten von KI differenzierter betrachten. Ein echtes Verständnis der Leistungsgrenzen erfordert sorgfältige Datenanalyse, Berücksichtigung der praktischen Bedeutung, Verständnis hinter den Architekturentscheidungen der Modelle und das Einbeziehen vielfältiger Evaluierungen über mehrere Aufgaben und Modalitäten hinweg. Es reicht nicht, mit vereinfachten, isolierten Experimenten vermeintliche „fundamentale“ Grenzen aufzuzeigen und daraus breit gefächerte negative Folgerungen zu ziehen. Die Forschungsgemeinschaft ist sich darüber bewusst, dass Grenzen bestehen, aber auch darüber, dass diese sich mit dem Fortschritt der Technologien, der Erweiterung von Kontextfenstern, der Integration von Tools und der Skalierung der Modelle verschieben.

Aktuelle Sprachmodelle können mittlerweile Aufgaben lösen, die noch vor wenigen Jahren undenkbar waren. Die Entwicklung ist kontinuierlich und nicht in Stein gemeißelt. Zudem ist die Diskussion um „generalizable reasoning“ und damit verbundene Begriffe wie Intelligenz oder kognitive Fähigkeiten häufig durch fehlende Präzision geprägt. In der Praxis ist Denken kein binärer Zustand, sondern ein Kontinuum mit vielen Facetten. Menschen sind keineswegs perfekt beim Ausführen komplexer, rein algorithmischer Aufgaben.

Vielmehr schöpfen sie aus einem reichen Fundus an Erfahrungen, Heuristiken und Fähigkeiten zur Abstraktion. KI könnte in Zukunft in ähnlicher Weise funktionieren, indem sie Aufgaben angeht, für deren direkte algorithmische Umsetzung sie nicht geeignet ist, sie aber durch Kombination verschiedener Hilfsmittel dennoch bewältigen kann. Auch ethische, soziale und kommunikative Fähigkeiten der KI gewinnen zunehmend an Bedeutung. Intelligenz wird immer öfter als Fähigkeit definiert, Probleme in der realen Welt sinnvoll und verantwortungsbewusst zu lösen, statt nur auf der Ebene computergestützter Theorien. In diesem Kontext ist das Beharren auf extrem exakten, formalisierten Problemlösungen in isolierten Szenarien wenig aussagekräftig.